深度学习的最新发展涵盖了广泛的任务,如图像分类、文本翻译、围棋对弈和蛋白质折叠。所有这些成功的方法都依赖于一种基于梯度的学习算法,通过大量数据和显著的计算能力来训练模型。尽管这种优化算法是共享的,但深度学习依赖于不同的模型架构来处理训练数据,具体取决于数据的模式:多层感知器用于向量,卷积神经网络用于图像,循环神经网络用于文本和序列,图神经网络用于图。最近加入这一模型家族的是Vaswani等人(2017)为文本翻译开发的Transformer架构。这种架构的碎片化景观迫使从业者根据数据模式选择模型并学习其特性。当问题涉及多种数据模式(如图像字幕)时,这种情况尤其不利。一种更系统的方法是采用一种单一的架构来处理所有模式,并从训练数据中直接学习输入的结构。

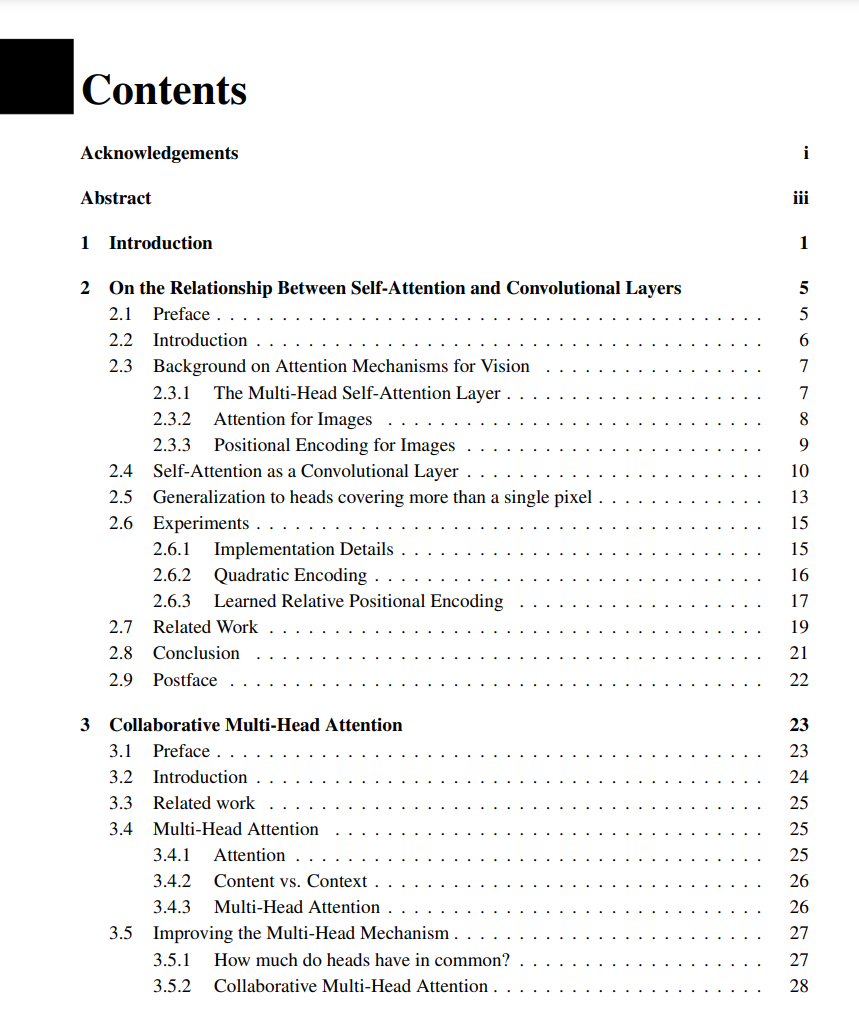

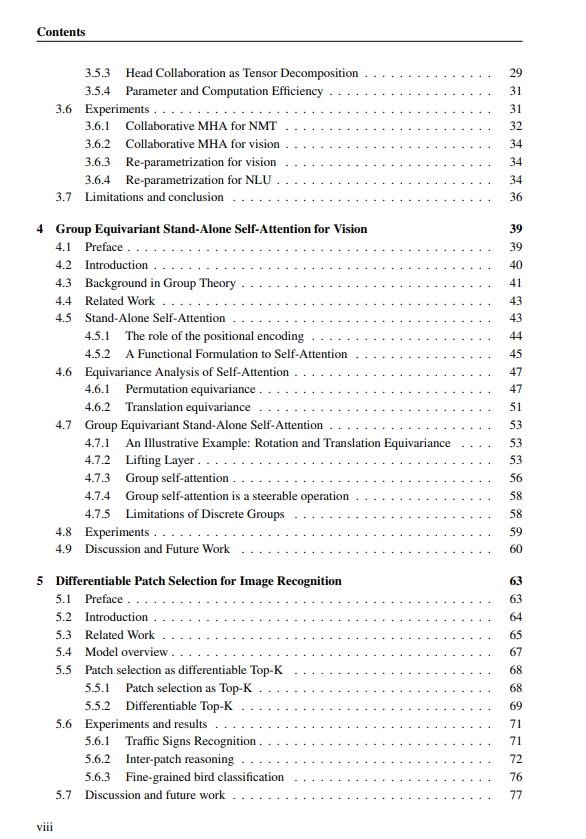

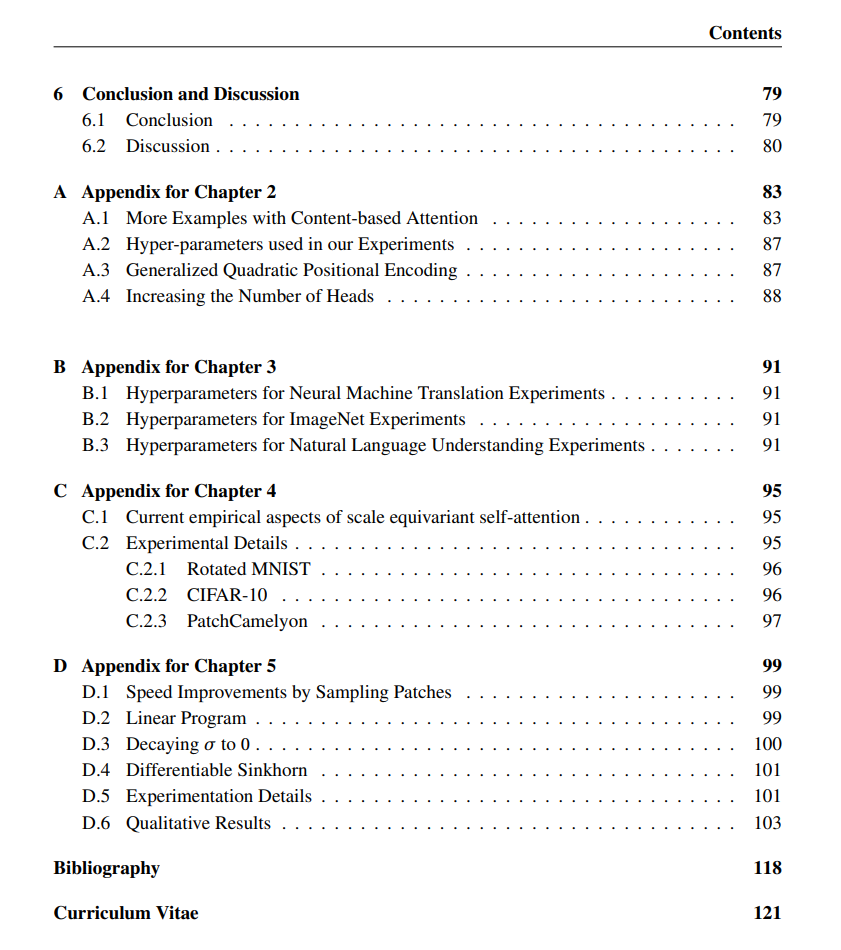

本工作采用自然语言处理和视觉之间的横向方法,展示了最初设计用于处理文本的Transformers也能处理图像。首先,我们展示了一种自注意力层——Transformer的构建块——能够证明地表达卷积,并通过实验证明浅层的Transformers确实学习了类似于卷积神经网络的局部平移滤波器。我们的证明依赖于注意力头模仿卷积核的感受野。我们研究了这些注意力头的交互方式,并提出了一种新的多头机制,利用跨头提取的共享表示。本论文提出了两种适应于特定图像类型的Transformer模型。我们介绍了一种旋转等变注意力层,适合处理那些方向信息无关的图像,如卫星图像或生物组织的显微图像。最后,我们通过提取图像的显著补丁并以较小的内存占用处理它们来调整Transformers处理大分辨率图像。我们的工作及后续发展使Transformers成为处理图像的标准架构。

深度学习最近在许多具有挑战性的任务上取得了巨大进展,例如翻译(Vaswani et al., 2017)、文本理解(Devlin et al., 2019)、文本生成(Brown et al., 2020)、图像分类(Dosovitskiy et al., 2021)、蛋白质折叠(Jumper et al., 2021),以及最近的图像生成(Ramesh et al., 2022)。这些问题涉及不同的数据模式:文本、图像、图或点云。解决机器学习问题的关键决策之一是选择适合输入数据模式的模型架构。从业者会实现卷积神经网络(LeCun et al., 1989)来处理图像,使用循环神经网络(Rumelhart et al., 1986)来处理文本和序列,用图神经网络(Defferrard et al., 2016;Kipf 和 Welling,2017)来处理图。

Vaswani等人(2017)引入了一种新的架构——Transformer,并将其应用于神经机器翻译。Transformer由编码器和解码器组成,这两部分都是由堆叠的注意力层构成的。注意力机制的核心最初由Bahdanau等人(2015)提出,用于跨语言对齐句子。注意力层计算输入不同部分之间的交互系数,并输出重新加权的表示。注意力分数的计算使用内容(单词的意义)、输入的位置(单词的顺序)或两者的结合。起初,注意力机制与卷积层结合使用,以获得两种架构的好处:卷积提取局部模式,而全局注意力重新加权允许找到发生在更远距离的模式,例如建模德语中模态短语末尾主语和动词之间的交互。然而,Vaswani等人(2017)展示了可以消除卷积层,只依赖于注意力。

通过在翻译中超越循环神经网络(RNNs),Transformers成为处理文本的事实标准架构:从翻译(Vaswani et al., 2017)到文本理解(Devlin et al., 2019),甚至文本生成(Brown et al., 2020)。但由于这种架构的多功能性,它的成功也扩展到了其他数据模式。Transformer的一个关键特性是内容和输入的位置/结构是解耦的。这对于超越文本处理并允许Transformers处理其他结构的数据(如图像、视频、图和蛋白质)至关重要。输入不仅可以是单词表示的序列,还可以是像素的二维图(图像)或三维分子中的原子。因此,一些Transformers专门用于处理图(Dwivedi和Bresson,2020)、蛋白质(Jumper et al., 2021)或视频(Sun et al., 2019)。

本论文聚焦于应用于图像视觉任务的Transformers。我们在第二章中证明,除了应用于文本,Transformer架构也可以类似于卷积神经网络处理图像。确实,我们展示了一种自注意力层——Transformer架构的主要构建块——在严格意义上比卷积层更具表达力。每个注意力头(注意力机制的并行重复)可以映射到卷积滤波器感受野的一个像素上,以将任何卷积核重新参数化为自注意力层。然而,表达力并不能提供完整的解释,因为即使一个层能够表达一个函数,这样的权重也可能无法通过如随机梯度下降这样的学习算法找到。因此,我们通过实验验证,一堆自注意力层确实能从展现平移等变性的噪声数据中学习计算卷积。

我们在图像上应用的Transformer(Cordonnier等人,2020b)在Dosovitskiy等人(2021)对更大图像的实验中表现非常好,他们为这种架构命名为Vision Transformer(ViT)。我们在CIFAR-10数据集(Krizhevsky等人,2009b)上对尺寸为32×32的图像进行的实验工作被Dosovitskiy等人(2021)扩展到224×224的图像,这些图像来自JFT-300M(一个私有数据集)或ImageNet(Russakovsky等人,2015)。ViT架构还处理16×16的补丁,并通过使用绝对位置编码而非相对位置编码进一步向纯Transformers迈进。高数据量训练允许纯Transformers大致学习平移等变滤波器,并证实Transformers类似于卷积处理图像。我们在第二章的伴随网站上可视化了ViT早期层的注意力分数的平移局部化滤波器。

如上所述,多重注意力头在自注意力中编码卷积的感受野方面起着关键作用。在第三章中,我们研究了在文本和图像上训练的Transformers中注意力头的交互方式。我们的实验表明,不同的头依赖于相似的模式(位置或内容)来计算注意力分数。我们提出了一种不同于串联的机制来复制注意力头。协作注意力通过共享中间表示来利用头之间共享的信息。这种重新参数化可以应用于已经训练好的Transformers,或在训练时使用。 在最后两章中,我们将Transformers适应于图像中存在的某些特定结构:生物图像中的旋转等变性和高分辨率图像中的局部化信息。

在第四章中,我们考虑那些角度方向不包含任何信息的图像。例如,卫星图像或细胞显微图像的处理应该与拍摄图像的角度无关。这一特性称为旋转等变性(或不变性)。我们约束Transformer对某些对称性(例如旋转或镜像)等变,这样滤波器可以在所有方向上学习一次。我们的工作建立在Cohen和Welling(2016)的开创性论文基础上,他们将对称性强加于卷积神经网络。我们提供了一种纯注意力提升层和一种对旋转等变的群注意力层。

最后,第五章讨论包含局部化信息的高分辨率图像,例如自动驾驶汽车的图像,其中交通标志的信息应是可读的。局部化信息需要以高分辨率处理,这阻止了将图像重新缩放到224×224像素的标准技术。另一方面,通过Vision Transformer以高分辨率处理整个图像需要过多的内存和计算资源,这超出了我们当前硬件的能力。相反,我们改编了Katharopoulos和Fleuret(2019)的工作,让Transformer处理图像的稀疏版本,其中只有“感兴趣”的补丁以高分辨率处理。由于一种新颖的层能够以可微分的方式提取最显著的补丁,我们的模型可以端到端地进行训练(Berthet等,2020)。

组织结构。上述贡献将在接下来的四章中详细描述。每章对应于作者撰写的一篇论文。各章节以工作总结和使用CRediT框架(Brand等,2015)列出的作者贡献开始。所有章节的附录集中在最后。