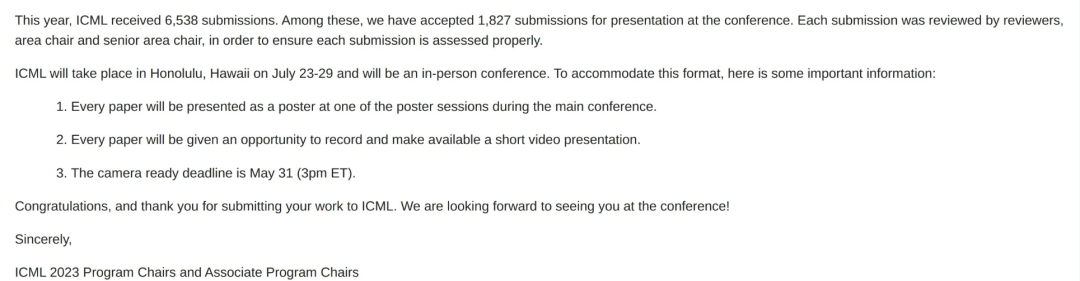

ICML 2023已经公布了会议通知,这是一场备受关注的机器学习盛会。2023年,共有6538份论文提交,通过筛选和评审,有1827篇论文被接收。

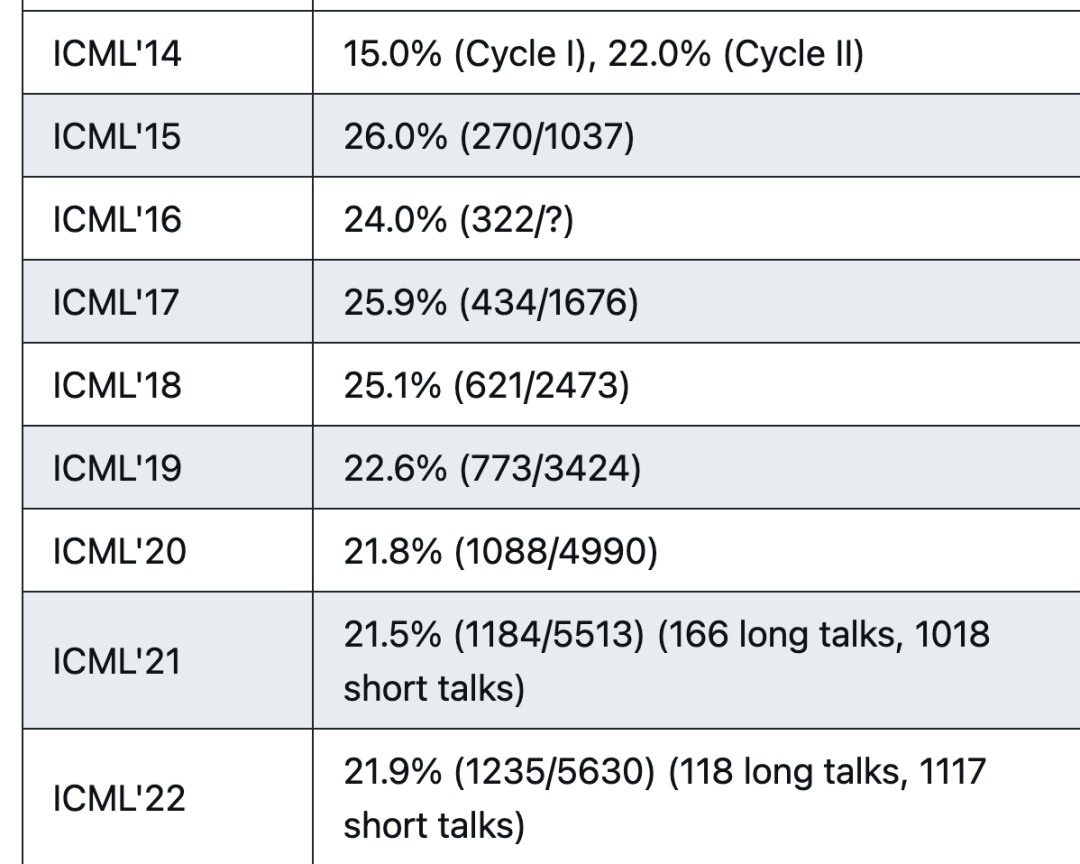

下面是网友统计的历史录取率,相比来看,2023年的接收率为历史最高,接收数量也是历史最高!

国际机器学习大会(International Conference on Machine Learning,简称ICML ) 是由国际机器学习学会(IMLS)主办的机器学习国际顶级会议。

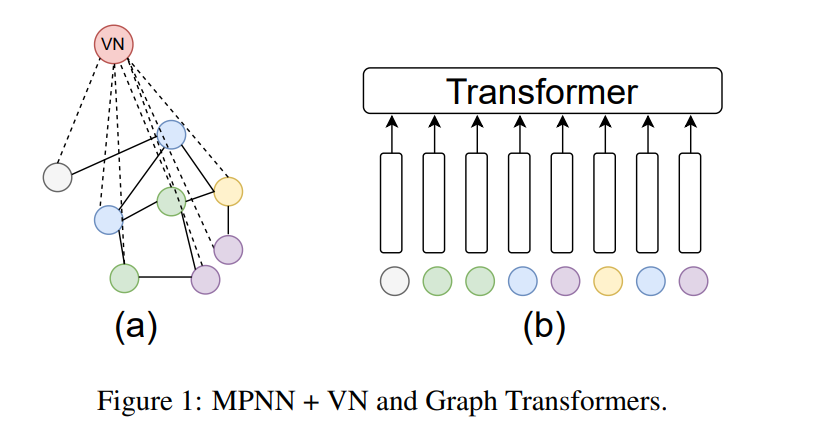

1. On the Connection Between MPNN and Graph Transformer

图Transformer (GT)最近作为一种新的图学习算法范式出现,在多个基准上超过了之前流行的消息传递神经网络(MPNN)。之前的工作(Kim et al., 2022)表明,通过适当的位置嵌入,GT可以任意地近似MPNN,这意味着GT至少与MPNN一样强大。本文研究了反向连接,并表明具有虚拟节点(VN)的MPNN,一种常用的启发式方法,但几乎没有理论理解,足够强大,可以任意近似GT的自注意力层。

https://arxiv.org/abs/2301.11956

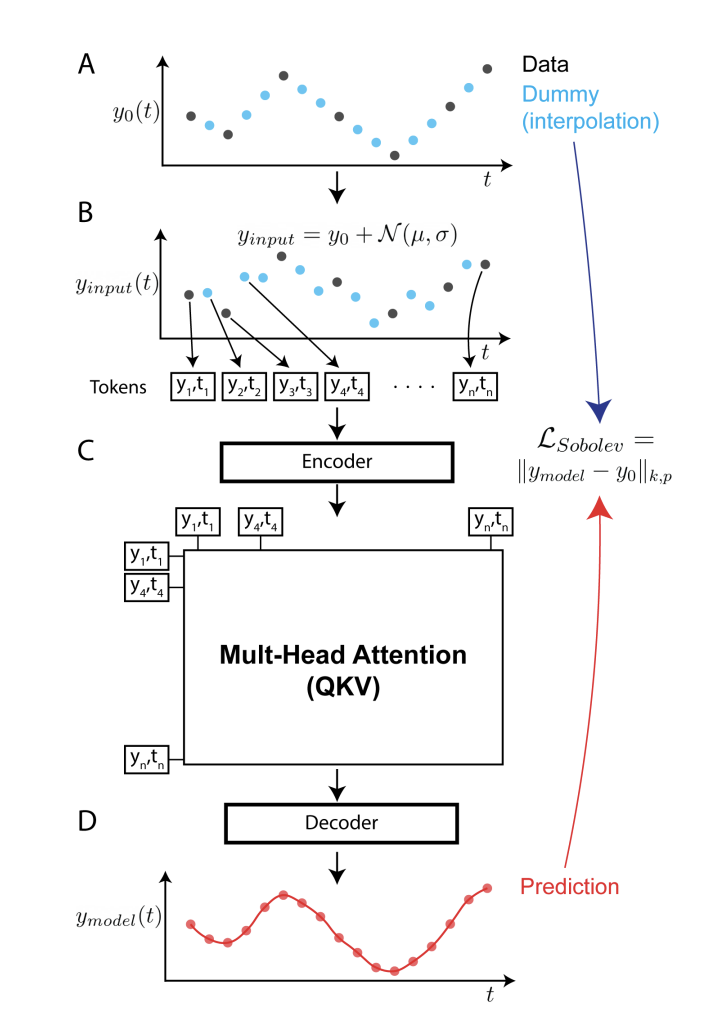

2. Continuous Spatiotemporal Transformers

https://arxiv.org/abs/2301.13338

Transformer模型在自然语言处理和计算机视觉中非常成功, 然而,Transformer本质是一个离散的时空模型,在连续系统方面有一个限制, 也就是无法保证采样的连续性。 为解决此挑战,本文提出了一种连续时空 Transformer (CST), 可用于连续系统的建模。这种新的框架通过在 Sobolev 空间优化来保证连续和流畅的输出。作者将 CST 与传统 Transformer 以及其他空间时间动态建模方法进行了基准测试,包括从 calcium 成像数据学习大脑动态。

CST 可以生成更连续、更流畅的表示形式,并在多个合成和真实系统上的任务中实现更好的表现,包括从 calcium 图像数据学习大脑动态。