近年来, 基于环境交互的强化学习方法在机器人相关应用领域取得巨大成功, 为机器人行为控制策略优化提供一个现实可行的解决方案. 但在真实世界中收集交互样本存在高成本以及低效率等问题, 因此仿真环境被广 泛应用于机器人强化学习训练过程中. 通过在虚拟仿真环境中以较低成本获取大量训练样本进行策略训练, 并将 学习策略迁移至真实环境, 能有效缓解真实机器人训练中存在的安全性、可靠性以及实时性等问题. 然而, 由于仿真环境与真实环境存在差异, 仿真环境中训练得到的策略直接迁移到真实机器人往往难以获得理想的性能表现. 针对这一问题, 虚实迁移强化学习方法被提出用以缩小环境差异, 进而实现有效的策略迁移. 按照迁移强化学习过 程中信息的流动方向和智能化方法作用的不同对象, 提出一个虚实迁移强化学习系统的流程框架, 并基于此框架 将现有相关工作分为 3 大类: 基于真实环境的模型优化方法、基于仿真环境的知识迁移方法、基于虚实环境的策略迭代提升方法, 并对每一分类中的代表技术与关联工作进行阐述. 最后, 讨论虚实迁移强化学习研究领域面临的 机遇和挑战. 当前, 强化学习 (reinforcement learning, RL)[1]方法在一系列复杂决策问题上取得了巨大成功, 如棋牌[2−4]和实 时战略类游戏[5,6]、推荐系统[7−9]、自动驾驶[10,11]等. 在诸如机器人运动控制[12,13]、机器人操控[14−17]、运动导航[18−21] 和机器人足球[22,23]等任务上, 强化学习也取得了令人瞩目的进展. 为了得到有效机器人控制策略, 强化学习依赖大 量交互样本进行训练, 而在真实环境中获取样本具有较高的成本代价与安全风险; 此外, 由于机器人结构复杂且真 实世界动态变化, 在机器人控制中运用强化学习依然面临有效性、安全性以及实时性等问题. 为减轻真实样本的 需求, 仿真环境被广泛用于机器人策略学习当中. 基于仿真的机器人策略学习有如下优点: (1**) 廉价性**: 仿真环境的 物理引擎能够以比实时更快的速度对真实环境进行计算模拟, 以较低成本生成训练样本用于机器人策略学习, 从 而提高机器人策略的训练效率. (2) 真实性: 仿真环境不但能模拟机器人的完整运动特性, 如关节及关节之间的运 动关联等, 还能模拟机器人和环境作用之间的物理属性, 如重力、压力、摩擦力等, 从而为真实世界建立逼真的物 理模型. (3) 多维性: 在特定的机器人任务中可以利用多个仿真环境对真实世界进行不同粒度建模, 从不同层次反 映真实场景的环境属性, 提供与真实世界相关的数据与信息以满足不同的应用需求. (4) 安全性: 在仿真环境中的 试错行为没有实际风险, 可以重复不断地执行现实世界中耗时且危险的任务.

综上可知, 基于仿真的强化学习在机器人控制中具有一定优势. 为使机器人成功地完成现实世界中的一系列 操作, 需要将仿真环境中学习的策略迁移至真实世界中. 然而, 由于仿真环境和真实世界之间存在现实差距 (reality gap)[24] , 包括在不同平台中机器人动力模型的差异以及环境物理属性的差异 (如动作感知延迟、地面状况与大气 状况等[25−27] ), 即使最高逼真度的仿真环境也难以对真实世界进行完全一致的建模. 因此, 将仿真环境中学到的策 略直接迁移到真实机器人上, 效果通常难以达到预期. 为了弥合仿真环境和现实之间的差异, 基于虚实迁移 (sim-toreal transfer)[24,28−30]的机器人强化学习方法通过解决仿真环境和真实环境之间的差异性问题, 从而实现学习策略的 有效迁移. 近年来, 一系列虚实混合迁移强化学习方法被提出, 包括系统识别[31−33]、域随机化[34−37]、域自适应[38−40]、 多保真度学习[41−43]等, 广泛地应用于运动控制、运动操控以及运动导航等机器人任务上, 取得了巨大的成功, 为机 器人行为控制策略优化提供了一个现实可行的解决方案. 已有一些工作对现有的机器人虚实迁移学习方法进行了总结. Zhao 等人[30]对虚实迁移中基本概念与具体技 术进行了简要的介绍. Dimitropoulos 等人[29]按照是否需要真实数据将现有虚实迁移方法分类为模拟器方法以及 自适应方法, 前者不依赖真实数据, 后者则需要真实数据用于策略迁移. Salvato 等人[24]将虚实迁移方法分为 3 类: 域随机化、对抗强化学习以及迁移学习方法. Zhu 等人[28]按照不同的应用目标, 将仿生机器人研究中使用的虚实 迁移方法分为 4 类: 基于精准的模拟器、基于运动学和动力学模型、基于分层与分布式控制器、基于演示的方 法. 尽管这些工作对现有的虚实迁移学习研究工作进行了总结, 但缺乏一个通用的框架对现有工作进行全面梳理 和分类. 因此, 本文对当前研究进行全面梳理, 从方法执行过程中信息流动和智能化方法作用对象的角度建立一个 通用的虚实迁移学习框架, 并基于此框架将当前主要的虚实迁移强化学习方法划分为 3 类: 基于真实环境的模型优化方法、基于仿真环境的知识迁移方法和基于虚实环境的策略迭代提升方法, 并对相关具体理论和应用进行讨论. 本文第 2 节介绍强化学习与迁移学习中重要的概念. 第 3 节深入探讨为了缩小仿真与现实之间的差异所采取 的不同方法, 并提出一个通用的虚实迁移学习框架, 对迁移步骤中的数据信息流动和智能化方法作用的对象进行 阐述与分析, 并在此基础上对现有方法进行分类, 分析它们的基本差异与优缺点. 第 4 节对该领域的目前的挑战进 行分析, 并对于未来研究进行展望. 最后, 第 5 节对本文工作进行总结.

虚实迁移强化学习

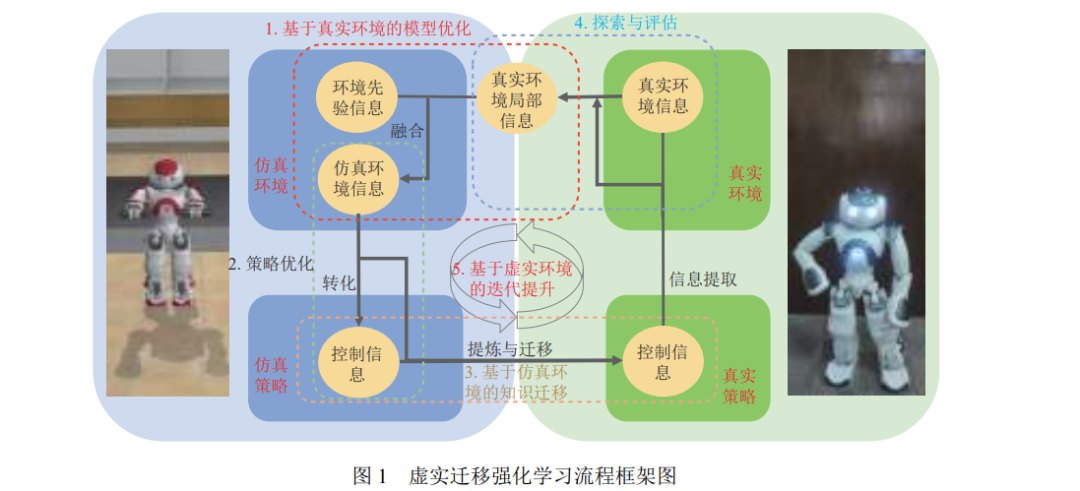

虚实迁移[24,30,100]指机器人在仿真环境中进行训练, 获得的策略被迁移部署至真实机器人控制系统中, 其中仿 真环境作为源域, 真实环境作为目标域, 机器人的控制策略作为迁移对象, 核心内容是实现环境信息与控制信息在 真实环境与仿真环境之间的迁移. 虚实迁移对迁移效果提出了 4 个重要的目标: 有效性、效率性、安全性、泛化 性. 有效性[101,102]是指在仿真环境中学到的策略能在真实世界中发挥预期作用, 即在仿真环境中获得高回报的策略 在真实环境中也能获得较高回报, 针对有效性的研究大多从缩小环境差异角度着手. 效率性[103,104]从采样的时间与 经济成本出发, 强调在真实世界中进行尽可能少的探索采样, 针对效率性的研究关注对真实样本中环境信息的充 分挖掘与利用. 安全性[105,106]强调现实中的探索与直接的策略部署具有潜在的安全风险及较高的成本代价, 需要指 导真实机器人进行安全的探索与样本收集. 泛化性[107,108]针对多任务迁移场景, 强调获得的策略能在尽可能少的微 调下快速适应不同环境的任务. 本文主要关注围绕虚实迁移的有效性以及效率性开展的相关研究工作, 在此基础 上对现有方法进行梳理总结. 本文从迁移学习过程中的信息流动和智能化方法作用对象的角度提出了一个通用的虚实迁移强化学习系统 流程框架, 如图 1 所示. 首先将策略学习与迁移过程分为以下 5 个主要步骤: 基于真实环境的仿真模型优化、仿真 策略优化、基于仿真环境的知识迁移、真实环境探索与评估, 以及基于虚实环境的策略迭代提升.

:上述 4 个步骤的循环迭代实现策略的不断提升. 真实环境信息包含了真实任务场景中的动力学模型以及奖励模型, 前者受复杂的环境参数, 如温度、湿度、 摩擦力系数等影响, 后者则由最终的任务目标及奖励结构决定. 复杂的真实环境难以被精准且完整地表征, 但蕴含 于样本数据、评估指标以及人类对任务的先验认知中的真实环境信息能够被有效利用, 这些信息蕴藏于人类在建 立仿真环境时所用的物理方程、环境参数的估计以及对参数范围的约束中. 基于真实环境的仿真模型优化通过真 实世界的样本数据修正或调整仿真环境, 其本质是将仿真模型中的先验但不精确信息与真实样本中的真实但局部 信息相融合以还原真实环境. 在仿真环境策略优化中, 机器人与仿真环境进行高效交互生成大量廉价样本并利用 当前已有的深度强化学习算法如 DDPG[49]、PPO[50]等实现策略优化, 在此过程中融合真实环境信息后的仿真环境 信息被转化成仿真控制策略中的控制信息. 在基于仿真环境的知识迁移中, 仿真环境中优化得到的策略控制信息 通过分解、组合或者直接迁移等手段从仿真策略中被提炼并迁移到真实策略. 最后, 迁移得到的真实策略又用于 真实环境探索与评估, 通过样本采集以及策略评估从真实环境中提取局部信息, 通过真实策略的控制信息引导机器人探索真实环境的未知部分以建立更加精准的环境模型. 虚实迁移中的仿真环境策略优化、真实环境探索与评估是传统强化学习领域中独立的研究方向. 现有的虚实 迁移强化学习方法通常针对基于真实环境的仿真模型优化、基于仿真环境的知识迁移以及基于虚实环境的策略 迭代提升这 3 个部分开展, 所以本文着重从上述 3 个角度出发对虚实迁移方法及代表工作进行分类与总结, 并阐 述每类方法内在动机与关联.****

本文总结了有关于机器人虚实迁移学习的主要工作, 从迁移学习过程中数据信息流动和智能化方法作用对象 的角度提出一个虚实迁移的流程框架, 并在此基础上提出了当前虚实迁移学习技术的 3 个主要方向: 基于真实环 境的仿真模型优化、基于仿真环境的知识迁移、基于虚实环境的策略迭代提升. 接着, 对每个方向中的主要方法 以及相关工作进行阐述, 并对比了一些代表性工作的实验内容. 最后, 介绍虚实迁移学习领域未来面临的挑战, 给 出了相应的解决思路与发展方向. 值得说明的是, 除了机器人领域, 虚实迁移强化学习相关思想与技术也可广泛应 用于其他领域, 以避免高风险的真实环境交互并提高训练效率. 如在金融交易中, 虚实迁移强化学习可应用于虚拟 金融市场环境中的交易策略开发和优化, 以提高交易策略的性能和鲁棒性, 并将其应用于实际市场中进行交易. 另 外, 在医疗决策场景中, 虚实迁移强化学习可用于在虚拟环境中训练智能代理来模拟医疗治疗决策, 并将其迁移到 实际临床实践中, 以提高医疗决策的准确性和效果. 我们希望通过对当前相关工作的分类与总结, 为相关研究人员 提供一种新的视角解读虚实迁移强化学习领域的研究现状与方向.