5月24日,由阿里研究院牵头,阿里巴巴集团、数字中国研究院(福建)、阿里云智能集团联合编写的《大模型训练数据白皮书》在第七届数字中国峰会期间发布。

自《中共中央国务院关于构建数据基础制度更好发挥数据要素作用的意见》发布以来,我国数据要素建设不断深入,在国家数据局等17部门联合印发的《“数据要素×”三年行动计划(2024—2026年)》进一步明确“建设高质量语料库和基础科学数据集,支持开展人工智能大模型开发和训练”。通过数据要素建设推动人工智能大模型发展,可以有效解决我国人工智能,特别是大模型研发所面临的数据瓶颈,进一步发挥大模型对于世界知识数据的汇集和处理能力,创造更大的生产力,助力我国从数据经济走向智能经济新发展模式。

大模型是数据要素价值释放的最短路径,通过理解其训练所使用的数据类型,可以更好理解大模型发挥价值的内在机制。而促进高质量训练数据的建设,需要综合利用政府、企业、社会等各方资源推动数据的开放共享和开发利用;需要构建共享、共创、共赢的合作生态和更开放的环境,不囿于版权等制度所存在的争议;需要给技术的发展预留空间,并相信随着技术的日益成熟,相应的商业模式和制度设计也都会逐步完善。作为支撑大模型发展的三大基石之一,我们希望中国的大模型发展,可以在数据方向上有所突破,助力我国在国际竞争中取得优势地位。

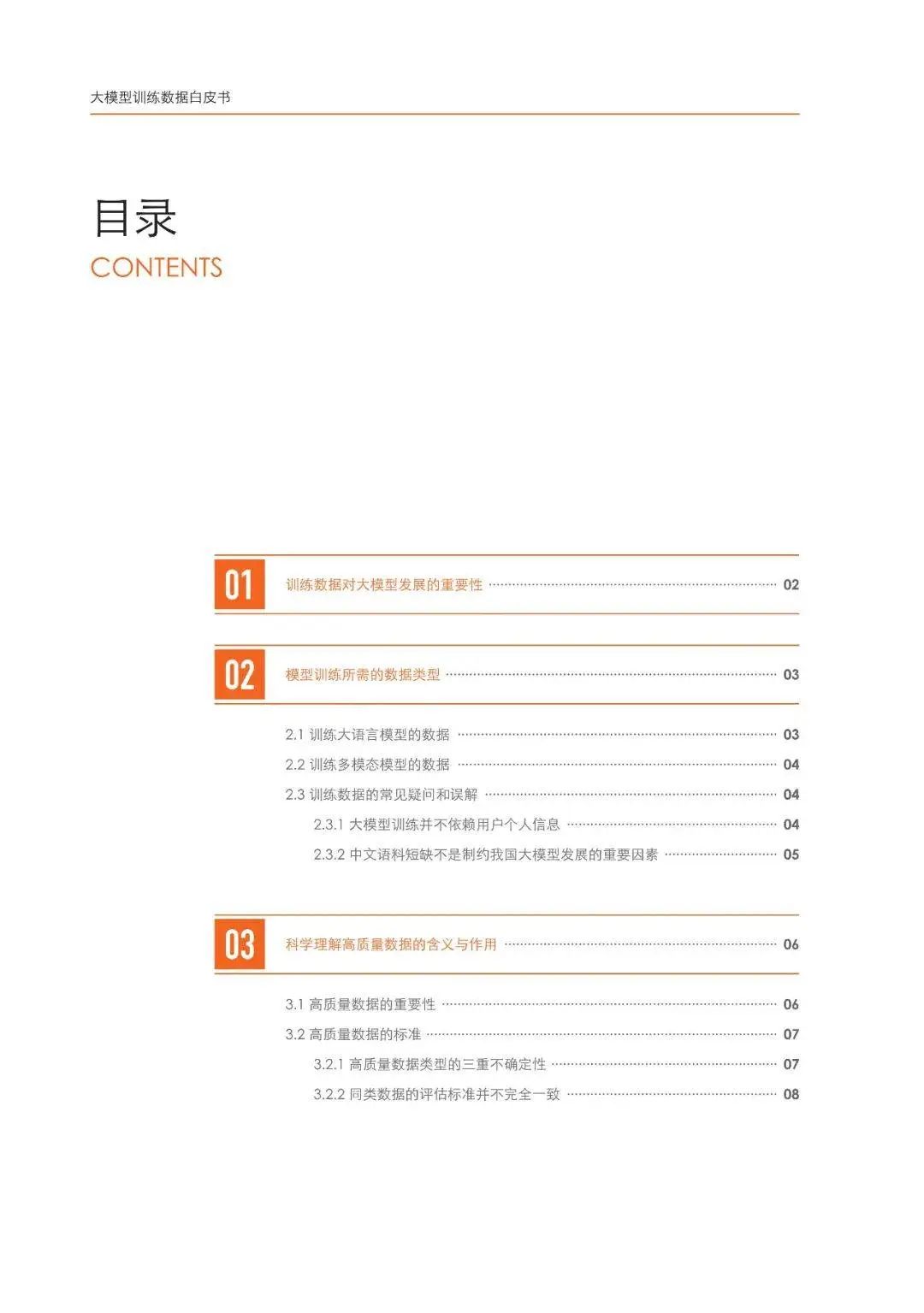

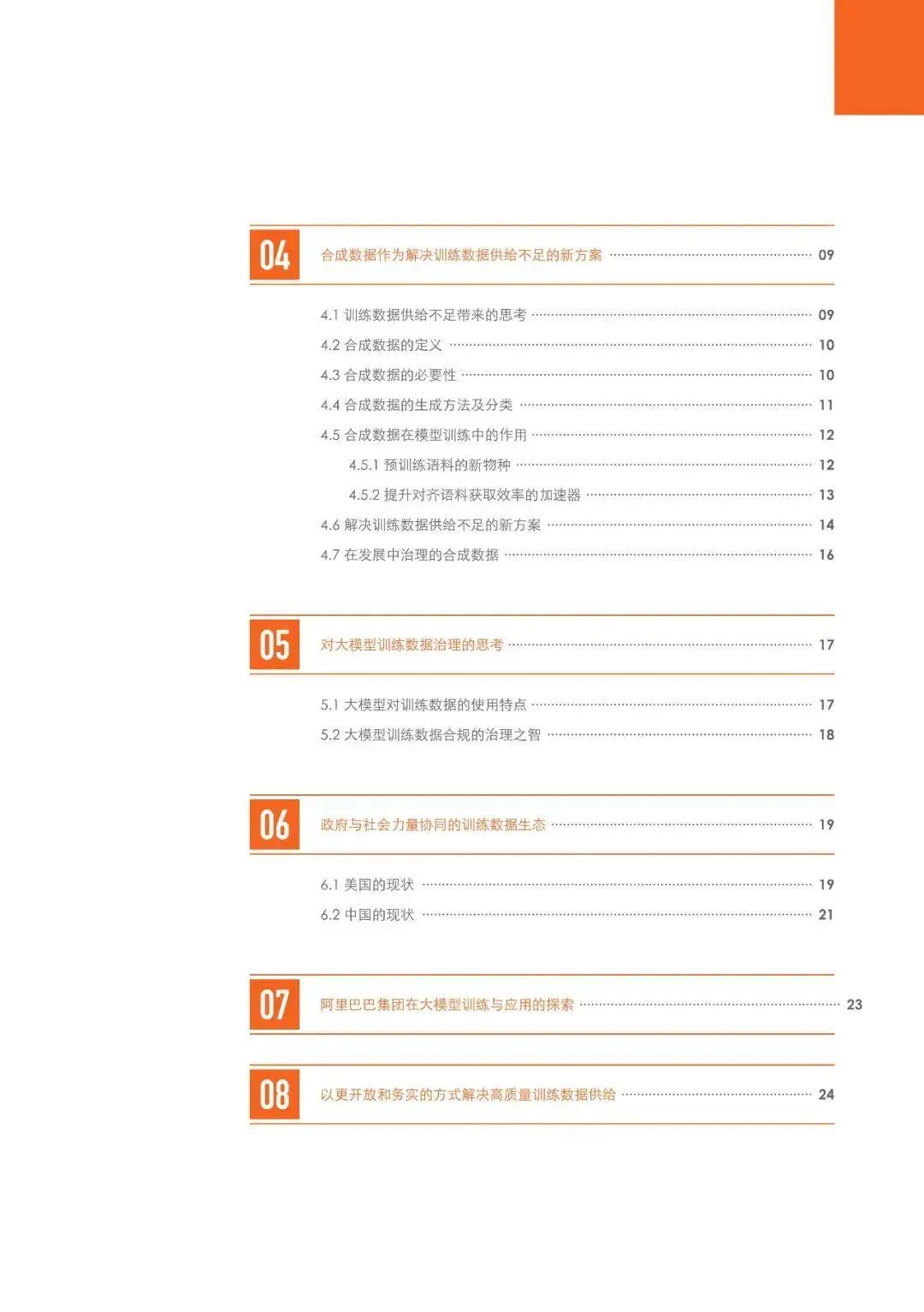

本白皮书首先分析了大模型训练所需的数据类型,并从产业实践出发破解了对训练数据的常见迷思和误解。在上述基础上,本书进而对训练数据的质量和规模进行讨论,发现高质量数据应在实践中检验效果,而难以用前置的客观标准衡量。同时,本书探讨了合成数据作为解决高质量训练数据供给不足的新方案,及其在大模型训练中的潜力。在训练数据合规方面,针对模型训练的特点,本书提出顺应模型发展的数据治理思路。最后,本书论述构建政府和社会力量协同的数据生态对满足大模型训练数据需求的重要性,并以阿里巴巴的实践为案例做说明和阐述。

以下为白皮书内容目录与精彩节选:

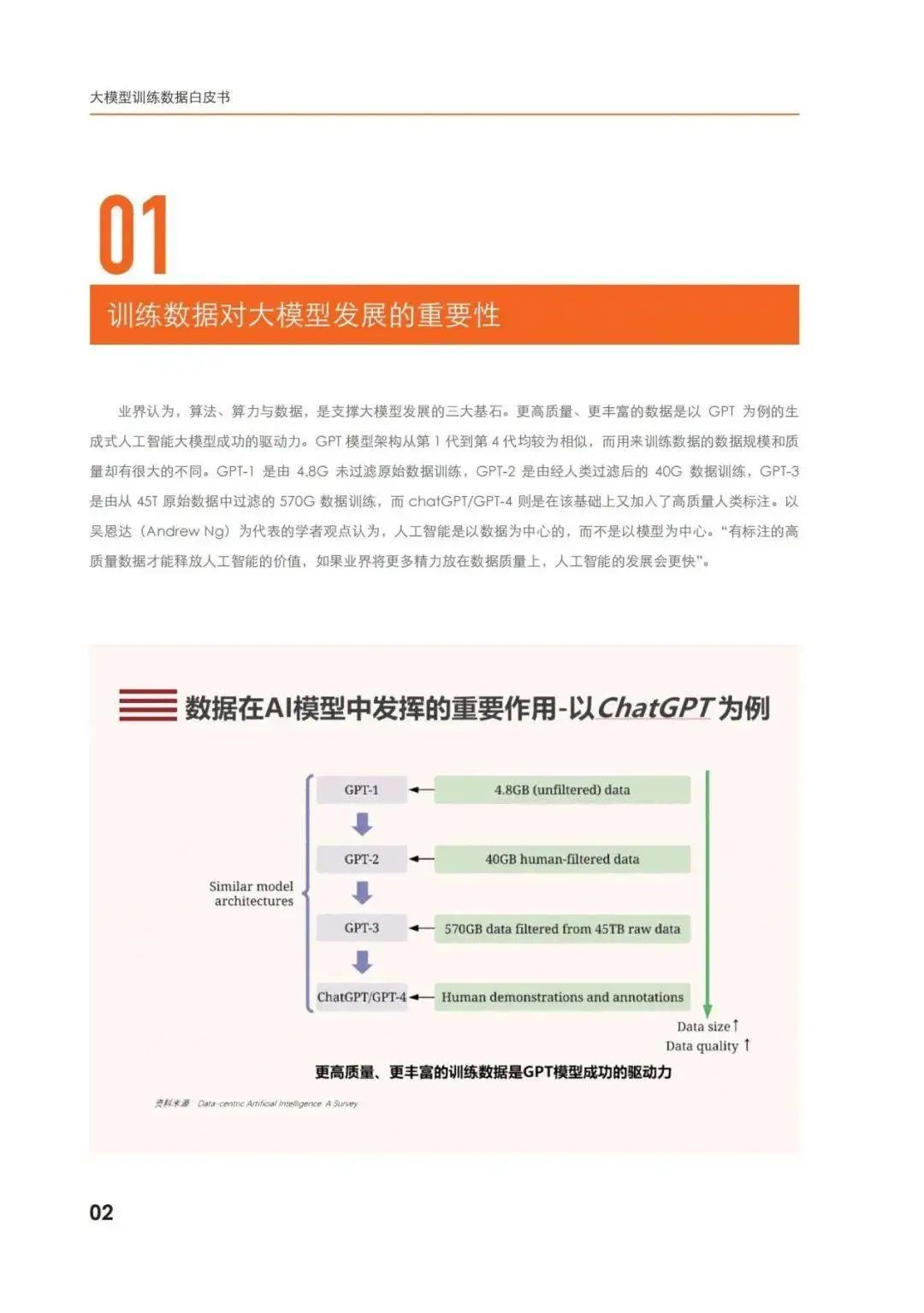

01 训练数据对大模型发展的重要性 算法、算力与数据,是支撑大模型发展的三大基石。更高质量、更丰富的数据是以GPT为例的生成式人工智能大模型成功的驱动力。