本手稿提供了一个全面、最新的强化学习(深度强化学习)与序列决策制定领域的概述,涵盖了基于值的方法、策略梯度方法、基于模型的方法以及其他多个主题(包括对强化学习与大语言模型(RL+LLMs)的简要讨论)。

强化学习概述

**序言

文章旨在提供一个强化学习领域的全面概览,包含了来自Murphy先前教科书章节的内容,并添加了大量新资料。

**1. 引言

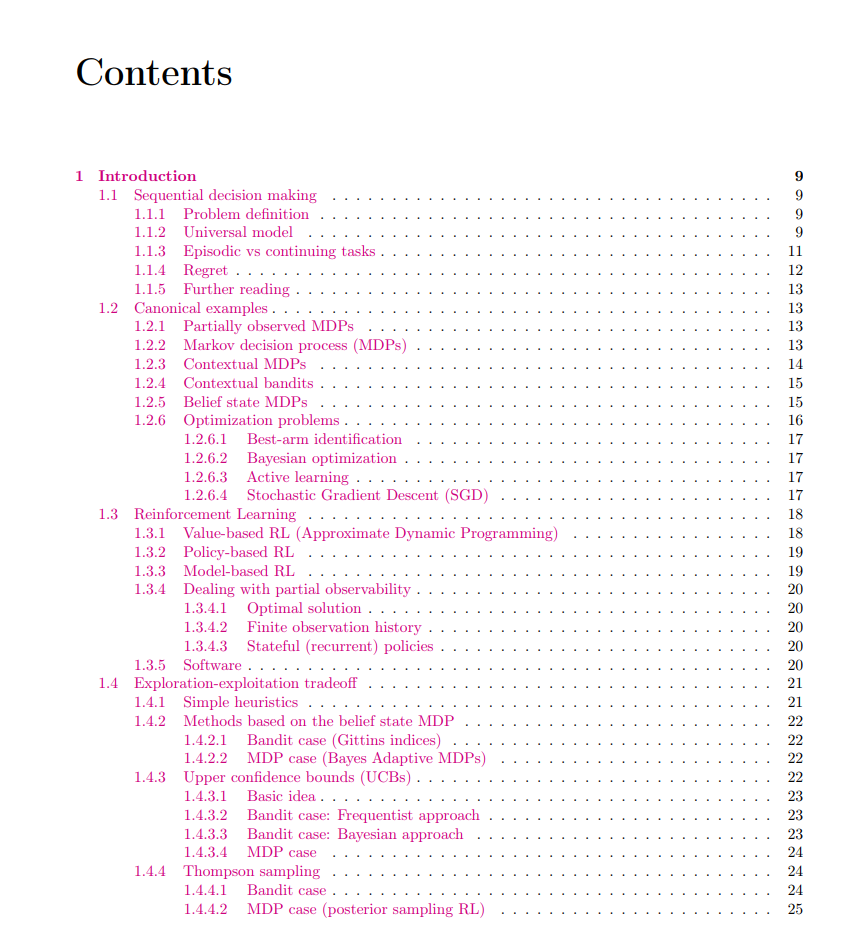

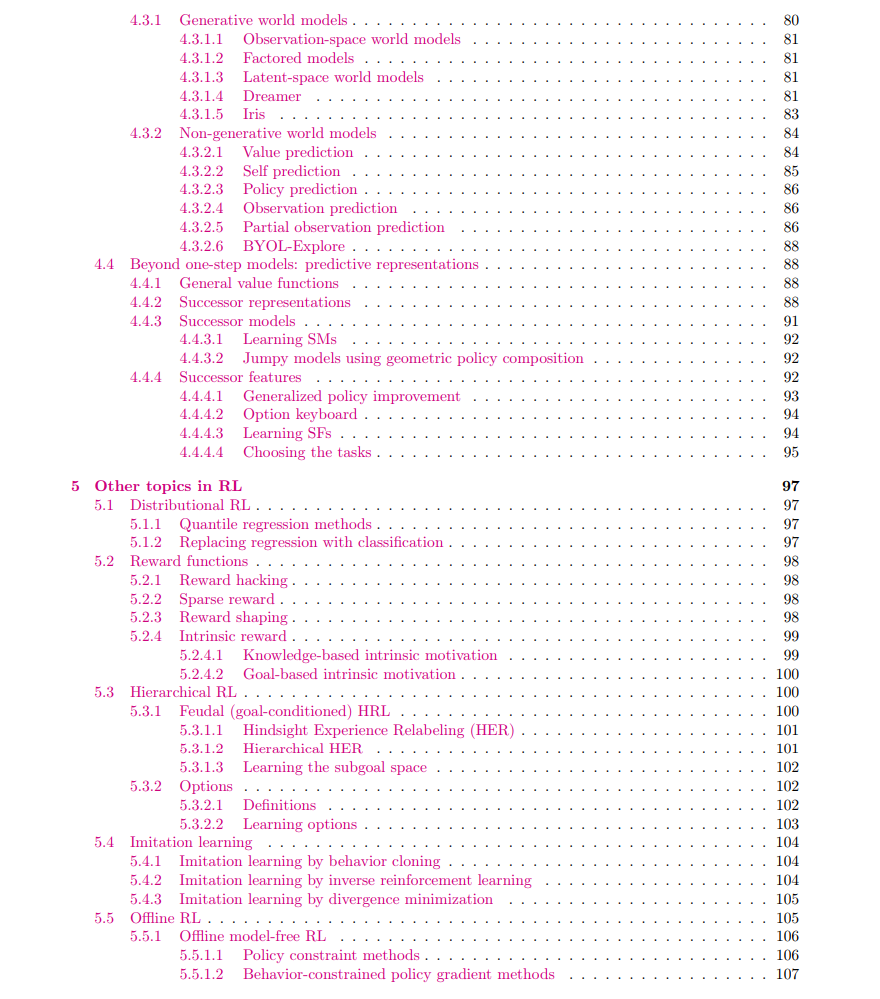

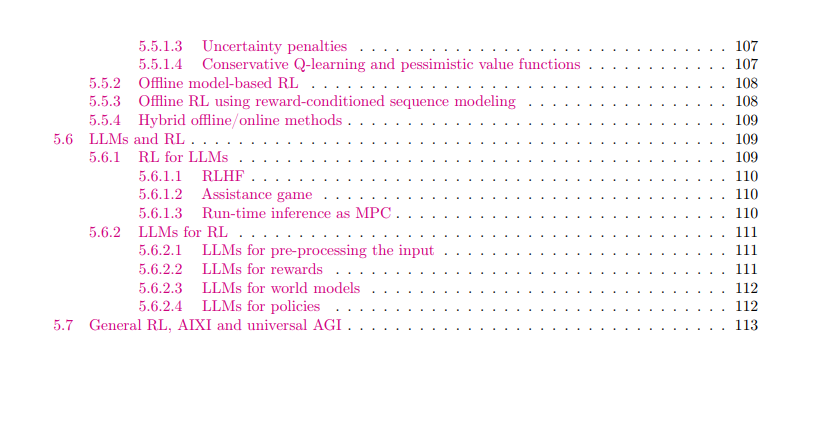

1.1 顺序决策制定:定义了问题,介绍了通用模型,区分了情节任务与连续任务,并讨论了遗憾的概念。 * 1.2 典型示例:包括部分观测MDPs、上下文MDPs、上下文Bandits、信念状态MDPs和优化问题等实例。 * 1.3 强化学习:分为基于价值的RL(近似动态规划)、基于策略的RL、基于模型的RL,并探讨了如何处理部分可观察性的问题。

**内容框架

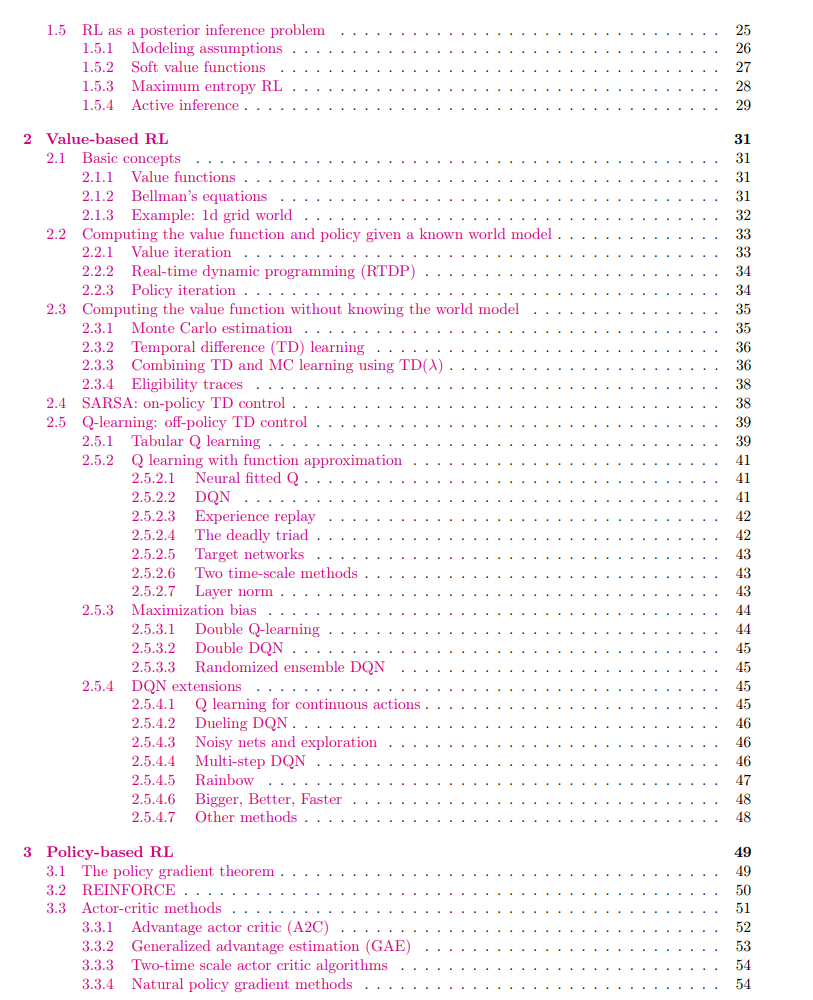

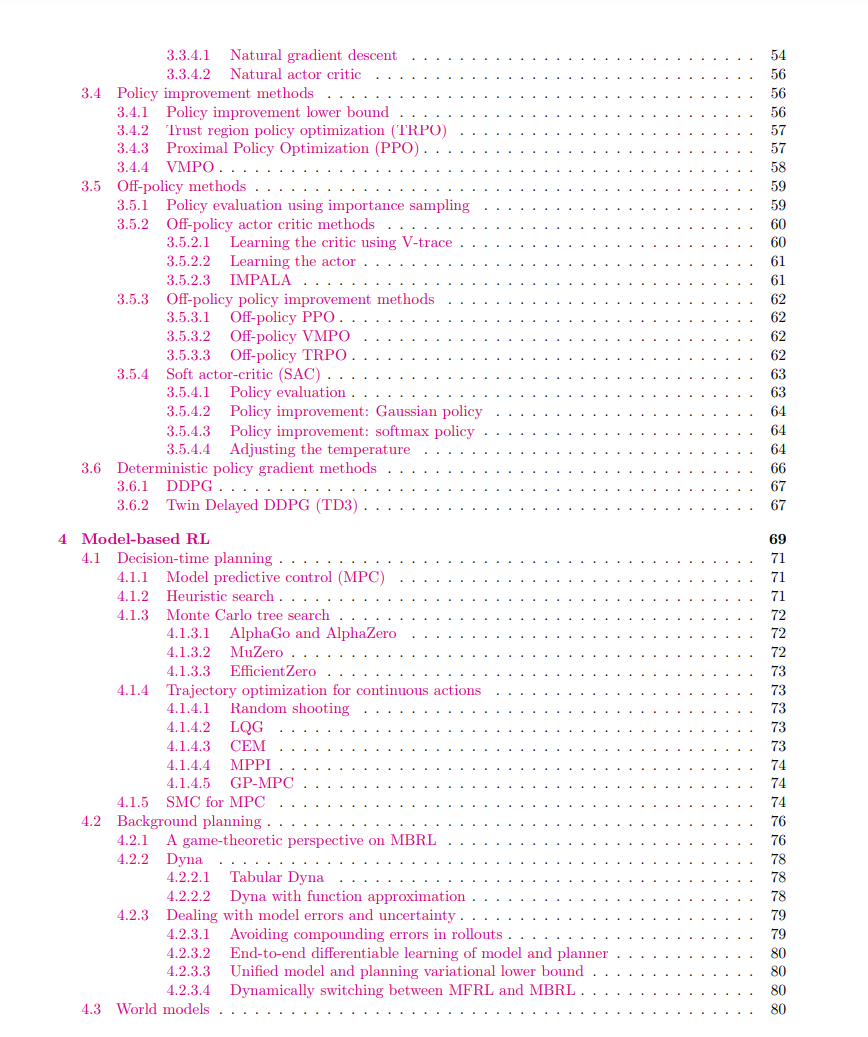

文章涵盖了强化学习的基础概念、经典示例以及不同的学习方法,如: * 基于价值的方法(Value-based RL) * 基于策略的方法(Policy-based RL) * 基于模型的方法(Model-based RL)

此外,还深入讨论了各种应用领域和技术进步,例如深度强化学习中的树结构模型(TreeQN)、用于离线强化学习的极简方法、信任区域策略优化(TRPO)、优先经验回放(Prioritized Experience Replay)、通用优势估计(Generalized Advantage Estimation)、近端策略优化算法(PPO),以及其他最新的研究成果和技术进展。

强化学习的应用和技术

文中引用了许多研究工作来展示强化学习在不同场景下的应用,比如使用深度神经网络进行连续控制、通过内在动机加速学习过程、结合语言模型实现世界建模等。同时,也提到了一些重要的技术发展,如DQN、DDPG、TD3、SAC等算法的发展及其对解决复杂环境问题的影响。 总之,这篇文章为读者提供了一个理解强化学习基本原理及其最新发展的全面视角,适合希望深入了解这一领域的研究人员和从业者阅读。