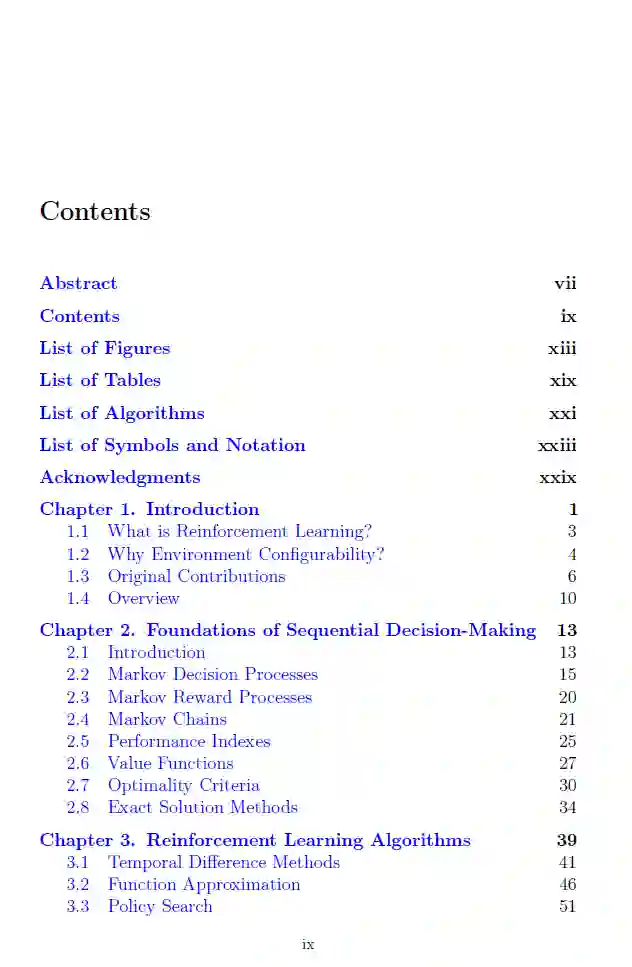

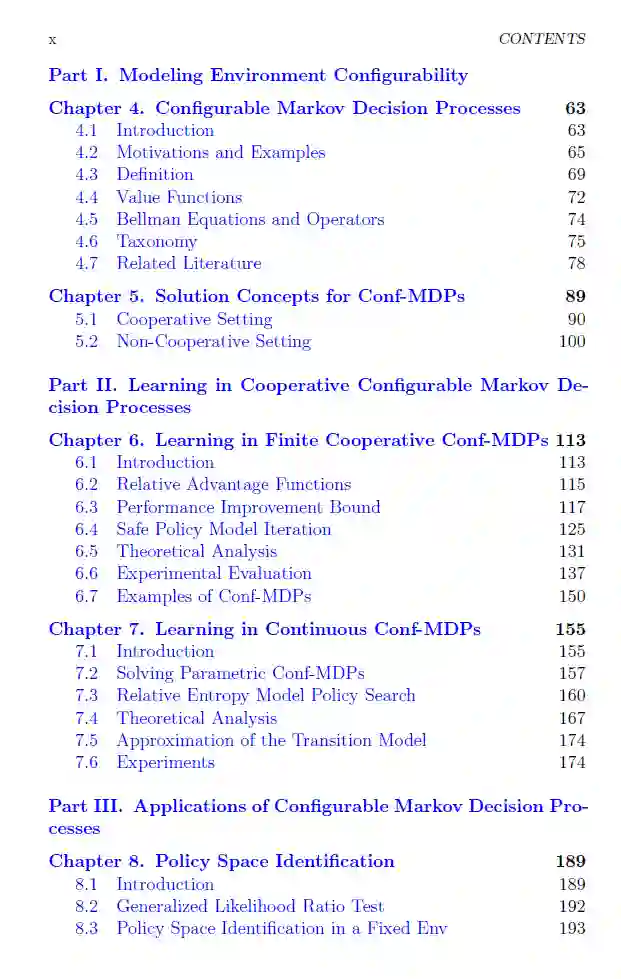

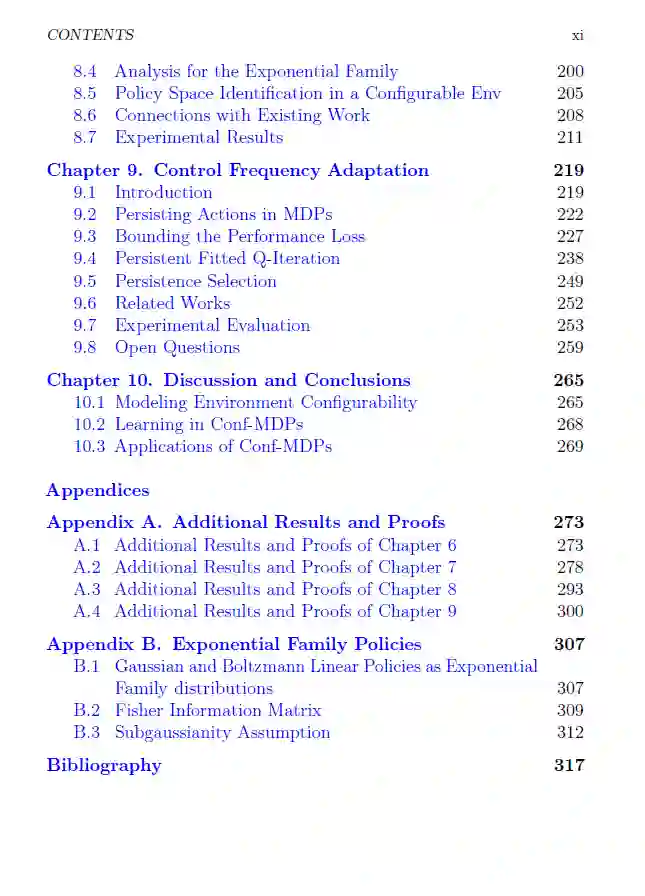

在近几十年中,强化学习(RL)已经成为解决复杂控制任务的有效方法。在通常使用的马尔可夫决策过程(MDP)框架中,环境被假定为一个固定的实体,无法从外部进行修改。然而,在许多实际场景中,环境可以在一定范围内被修改。这本书《在强化学习中利用环境可配置性》旨在形式化和研究环境配置的多样化方面。在传统的MDP中,智能体感知环境的状态并执行动作。作为结果,环境转换到新的状态并生成奖励信号。智能体的目标包括学习一个策略,即最大化长期奖励的动作处方。尽管环境配置在实际应用中经常出现,但该主题在文献中的探讨非常少。书中的贡献是理论的、算法的和实验的,可以大致分为三个部分。第一部分介绍了可配置马尔可夫决策过程(Conf-MDPs)的新颖形式化,以模拟环境提供的配置机会。书的第二部分专注于合作的Conf-MDP设置,并研究了寻找一个同时优化长期奖励的智能体策略和环境配置的问题。第三部分解决了Conf-MDP框架的两个特定应用:策略空间识别和控制频率适应。这本书将对所有将RL作为工作部分的人感兴趣。

成为VIP会员查看完整内容

相关内容

Arxiv

225+阅读 · 2023年4月7日