AAAI 2025|基于信息瓶颈准则的联邦图数据压缩

题目:Federated Graph Condensation with Information Bottleneck Principles 会议:The 39th Annual AAAI Conference on Artificial Intelligence (AAAI 2025) 论文链接:https://arxiv.org/pdf/2405.03911

一. 摘要

图压缩(GC)通过合成小规模的压缩图来减小大规模图的尺寸,并且保持大规模图的效用,大大减少了存储和计算代价。然而,现有的 GC 方法依赖于集中式数据存储,这对于现实世界的分散式数据存储来说是不可行的,并且忽视了数据持有者的隐私保护要求。为了弥补这一研究空白,我们提出并研究了联邦图压缩(FGC)问题。具体而言,我们首先提出了一个 FGC 的通用框架,其中我们将 GC 的典型梯度匹配过程解耦为客户端梯度计算和服务器端梯度匹配,将来自多个客户端子图的知识融合到一个较小的压缩图中。然而,我们的实验研究表明,在联邦设置下,压缩图将持续泄露数据成员隐私,即在成员推理攻击(MIA)下,联邦训练期间的压缩图可用于窃取本地训练数据。为了解决这个问题,我们将信息瓶颈原理融入 FGC,它只需要在联邦训练前通过一个本地的预训练步骤提取部分节点特征,并在联邦训练期间利用这些特征,即可抵御MIA并且保持数据效用。理论和实验分析表明,我们的框架在训练期间能始终保护成员隐私。同时,它可以达到与现有的集中式 GC 和联邦图学习 (FGL) 方法相当甚至更好的性能。

二. 简介

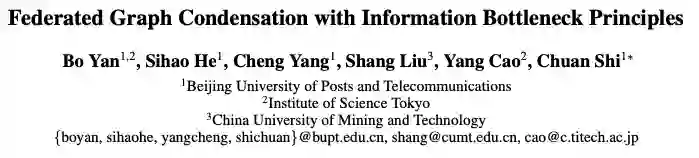

由于内存和计算开销,图模型在处理现实世界的大规模图时会带来巨大的存储和计算开销,尤其当模型需要多次训练时,例如神经架构搜索 (NAS)和持续学习。一个从数据入手的解决方案是图压缩(GC),如图1(a)所示,它将大规模图压缩为小图,且保留了原始图的效用,方便图数据的存储和下游任务的计算。然而,现有GC的研究都持有一个基本假设,即图数据是集中存储的。而在现实世界中,整个图被分成由不同方持有的多个子图。例如,在医疗保健系统中,医院仅拥有患者(节点)、其信息(属性)和交互(链接)的子集。出于隐私方面的考虑,数据持有者不愿意共享他们的数据,许多严格的法规(如 GDPR)也禁止任意收集数据,这使得集中式 GC 不可行。近年来,联邦图学习 (FGL) 的出现使得可以在不暴露本地数据的情况下协作训练一个全局模型,如图 1(b) 所示。然而,它们仍然在大规模图训练中带来大量存储、计算和通信开销。因此,一个重要但尚未探索的领域是在联邦环境中考虑 GC。为了填补这一空白,我们研究了联邦图压缩(FGC)这一新问题,如图1(b)所示,旨在协作学习一个包含来自不同方数据知识的小图。之后,所有数据持有者都可以访问这个压缩图以用于下游应用。它存在以下两点挑战:(1)如何保持压缩图的效用?与集中式 GC 不同,在 FGC 中,整个图被分割成很多子图分布在数据持有者之中。因此,一些关键的跨客户端信息缺失,并且这些子图也存在严重的异质性,不可避免会降低压缩图的效用。(2)如何防止压缩图可能泄露本地图的成员隐私?与传统FGL 中图数据本地存储不同,FGC 中发布的压缩图可用于MIA 推断本地数据的成员隐私。此外,压缩图的可访问性使攻击者能够训练任意模型,使得传统的基于模型的 MIA 防御失效。 为了应对这些挑战,在本文中,我们研究了在联邦环境下的图压缩问题,并提出联邦图压缩框架 (FedGC)。主要贡献如下:(1)我们首次提出并研究了联邦图压缩问题,这是现实场景中重要且实际的一个问题。(2)我们为 FGC 设计了一个 FedGC 框架。它通过匹配来自客户端的加权梯度聚合来学习压缩图。我们进一步发现压缩图会持续泄露成员隐私,并基于信息瓶颈原理提出一种新颖的本地图变换方法来保护原始图。理论分析证明, FedGC 可以同时保持原始图的效用和成员隐私。(3)我们在五个真实数据集进行了广泛的实验,结果表明 FedGC 可以达到和集中式 GC 和 FGL 方法相当的表现,在大规模数据集中甚至比这些方法性能更好。同时,FedGC 在整个联邦训练过程中可以持续保护成员隐私。

三. 方法

在我们的setting下,对于个客户端,整张图 被分割成个子图保存在相应的客户端中。FGC的目标是将这些子图压缩成一个小图保存在server端,同时保持原图的效用和隐私。本节首先介绍保持效用的FGC通用框架,然后介绍保持隐私的本地图数据转换。

保持效用的FGC通用框架

根据经典的梯度匹配的图压缩方法,我们提出了一种分布式梯度匹配的算法。联邦训练每一轮客户端利用本地数据训练一个本地GNN模型,并将梯度上传到服务器。服务器拿到各个客户端的梯度进行聚合得到。同时,在服务器端维护一个压缩图,服务器利用训练一个GNN模型并得到梯度,然后最小化和的差异来更新压缩图。如以下公式所示, 这里,由于联邦下图数据异质性问题,我们根据各个客户端的各个类别数量做了加权的梯度聚合。由于联合优化很难,所以我们固定使得分布和原始数据分布一致,并且假设可由导出。联邦图的另一挑战是信息缺失,因为一些节点和边是不可见的。为了缓解这一问题给压缩图效用带来的影响,我们根据之前的工作,利用同态加密在客户端之间安全地传输缺失的邻居聚合。此步骤只执行一次,并且只需最多两跳邻居的聚合信息就足够保护效用,所以并不会带来很大的计算和通信开销。同时,由于压缩图捕捉到了各个子图的通用知识,具有良好的泛化能力,但可能并不能捕捉到特定的图信息。所以不同于传统图压缩框架将压缩图直接训练一个图模型用于测试,我们提出将压缩图训练出的图模型分发到各个客户端,利用本地图数据对模型进行微调以捕捉本地图数据的特定信息,从而实现针对不同客户端数据的个性化。

保持隐私的本地图数据变换

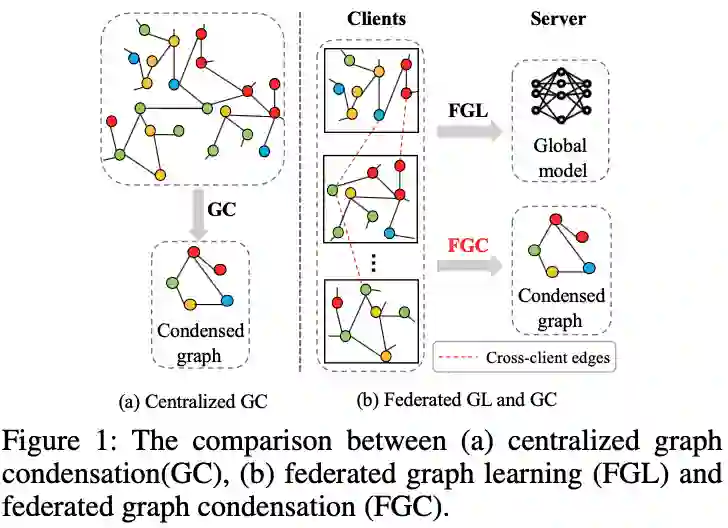

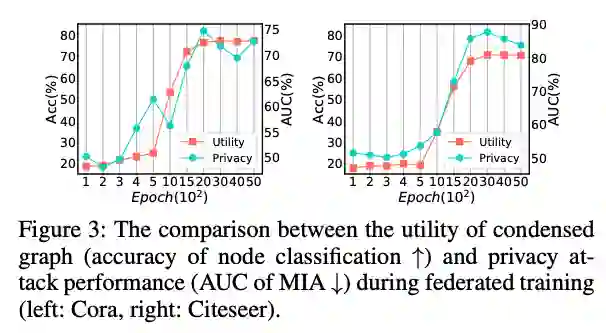

基于上述框架,我们可以将多个大子图压缩为一个小图,而保持图数据的效用。然而,我们的实验研究表明,压缩后的图会暴露原始子图的成员隐私。我们记录了在训练过程中压缩后的图的效用和MIA攻击表现,如图3所示。可以发现,MIA 的表现随着压缩图效用的增加而提高,即压缩后的图会逐渐泄露原始子图的成员隐私。为了保护成员隐私,一个直观的想法是将原始子图变换成另外的图,然后用新生成的图来执行联邦图压缩。转换后的图应具备两个属性:(1)保持原始图的效用;(2)包含较少的原始图成员隐私。因此,受到信息瓶颈 (IB) 理论从原始数据中提取最小充分特征的启发,我们利用 IB 将原始图进行转换。整体流程如图 4 所示。

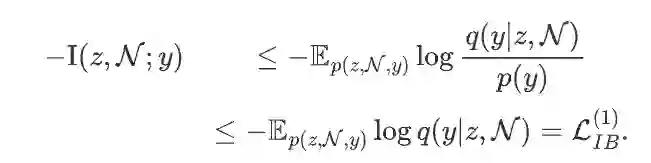

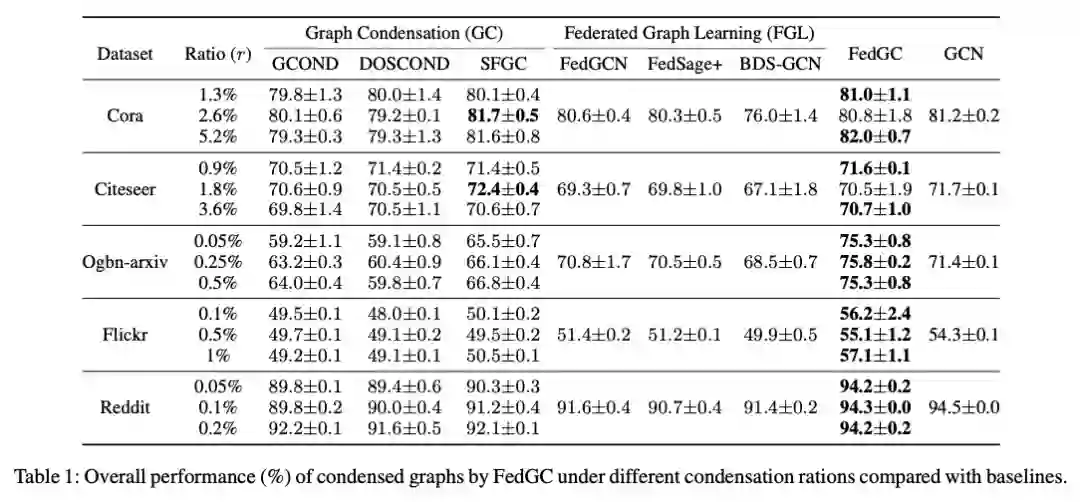

具体的,每个客户端旨在利用本地数据学习一个 IB 编码器来提取最小充分特征: 。根据信息瓶颈准则,目标函数为:,即最大化与标签之间的互信息,旨在保持转化后的图的效用,同时最小化和原始节点特征之间的互信息,使得转化后的图包含尽量少的原始图隐私信息。值得一提的是,每个客户端需在本地独自训练一个编码器来进行图转换,此过程不涉及客户端参数共享,因为如果攻击者知道了客户端的模型参数,就可以根据它掌握的相同分布的图数据来推断转化后的图,导致图转换失效。为了便于优化IB的目标函数,我们首先应该导出目标函数的上界,第一项的上界为:

第二项的上界为:

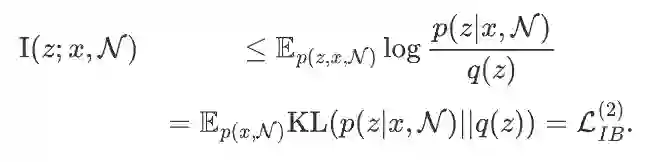

因此,本地图变换的目标函数为:。和传统IB不同的是,我们这里考虑到计算和通信代价,不对图结构进行变换,而只变换图特征。理论分析也会证明,此操作可以很好的保护数据隐私。接下来,我们将IB准则实例化为不同的神经网络结构:对于, 我们首先假设服从正态分布,利用一个两层的MLP和一次邻居聚合来实现,并且通过采样来得到:

按照此方式,可以实例化为和正态分布的差异(如KL散度);得到之后,我们利用传统的GNN节点分类损失来实例化: 。 对于每个客户端,经过本地图变换后,我们可以得到一个新的子图,然后,各个客户端基于转换后的图利用FGC通用框架来进行图压缩。然而,此方法还存在两个主要缺陷:(1)缺乏足够的标记样本来获得高质量的。由于现实场景中客户端中的标记节点可能稀缺,这使得难以应用 IB 原则。(2)不同客户端得得的不在同一个特征空间中。由于为了更好地保护隐私,图变换是在本地进行的,即客户端之间没有参数共享,导致特征空间异构,使得FGC效果变差甚至难以收敛。为了解决第一个缺陷,我们提出了一种联邦自训练策略来扩展标签。在本地图变换之前,所有客户端首先协作训练一个GNN模型用于标记本地图数据。为了解决第二个缺陷,我们用自训练得到的GNN参数来统一初始化各个客户端的,并且在联邦训练过程中保持不变。这样各个客户端只需本地训练 和,既将各个客户端的统一到了同一空间,又保护了客户端隐私。 * 隐私和效用分析: 利用推理成本增益对成员推断的定量分析定义,我们将压缩图的效用,对原始图的隐私泄漏,用信息瓶颈理论进行了统一建模分析。理论分析证明,利用信息瓶颈理论进行的本地图变换过程,可以看作是隐私和效用的折中,折中效果被参数所控制。

四. 实验

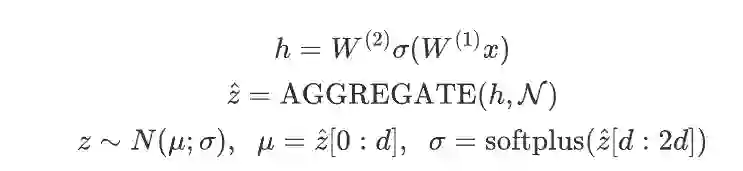

主实验

我们在5个数据集Cora、Citeseer、Ogbn-arxiv、Flickr 和 Reddit上进行了实验。压缩图数据效用实验结果如下所示:

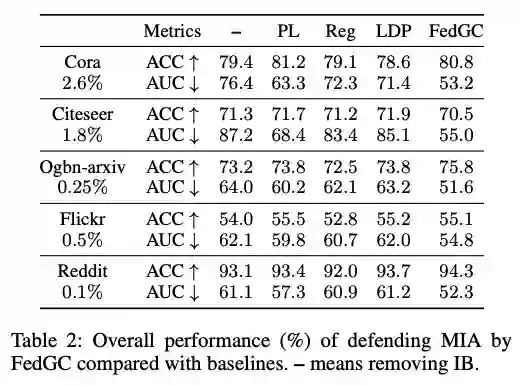

有以下观察结果:(1)FedGC 取得了优异的表现,证明了我们框架的有效性,这也为执行 GC 和 FGL 任务提供了新的方法和思路(2) FedGC 在数据强异质性的表现甚至比 FGL 方法更好(子图之间的异质性是 FGL 中的一个关键挑战),我们将其归因于压缩图能够捕获不同子图之间的共同知识,从而减轻异质性。并且,FedGC通过本地数据对训练后的模型进行微调,实现了更好的个性化。(3)FedGC 与集中式 GCN 和 GC 方法取得了相当的结果,并在大规模数据集中取得了更好的效果。与集中式 GCN 相比,其优势可能在于压缩图可以捕捉不受局部噪声结构影响的一般图模式。至于 GC 方法,这种优势主要归功于我们设计的自训练和微调方法,这将在消融研究中阐述。 MIA的效果如下表所示:

我们用其他防御模型替换 IB,以评估防御 MIA 的效果。从表 2 中,我们观察到,虽然基线模型在压缩图的效用上可以取得与 FedGC 相当的结果,但它们在防御 MIA 方面性能急剧下降。相比之下,FedGC 可以同时实现高效用并保护成员隐私。具体的,由于压缩图是公开的,因此基于模型的防御(Reg 和 LDP)只能影响模型梯度匹配阶段,对压缩图对原始图性质的继承影响甚微,导致了比较高的攻击准确率。而PL则直接修改原始数据(添加伪标签),防御性更强,但伪标签继承了训练标签的知识,MIA依然有效。FedGC利用IB原则,将原始节点特征变换到新的空间,防止了强攻击者来获取成员隐私。 压缩图的泛化效果如下表所示:

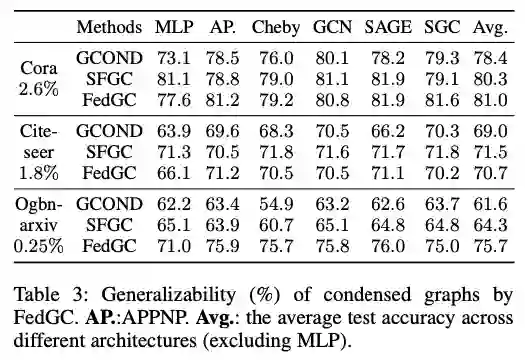

我们可以发现 FedGC 在不同下游模型中表现出良好的泛化能力。根本原因是这些 GNN 模型具有相似的过滤行为,这在之前的研究中已经得到说明。浓缩图的通用性使客户能够根据自身情况训练个性化模型,从而为开展下游任务提供了一种灵活的方式。

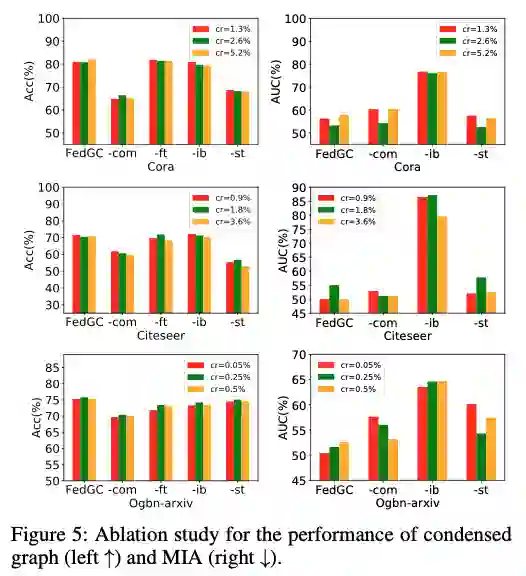

消融实验

上表的消融实验可以发现:(1) 一次性通信对相对较小的图 (Cora 和 Citeseer) 的贡献大于对较大的图 (Ogbn-arxiv) 的贡献。原因是较小的图遭受更多的信息损失(缺少重要的跨客户端邻居),从而对压缩图产生级联效应。同样,自训练在较小的图中也起着关键作用,因为它们需要更多标记节点来补偿破坏的结构。这些证明了整体局部结构对 FGC 效用的重要性。2)IB 可以提高压缩图的泛化能力,可以观察到删除 IB 几乎在所有数据集上都会导致性能略有下降。(3)使用局部数据进行微调可以实现更好的个性化。对于MIA,我们可以看到,使用 IB 的本地图变换对 MIA 具有显着的防御能力。如之前分析,IB 目标的优化将最小化推理成本增益,从而降低 MIA 的有效性。还可以看出,一次性通信和自训练在一定程度上防御了 MIA。实际上,一次性通信可以看作是一种特征增强,自训练可以看作标签增强,这些增强使压缩图匹配增强数据而不是原始数据,从而减轻了过拟合,导致 MIA 的性能下降。

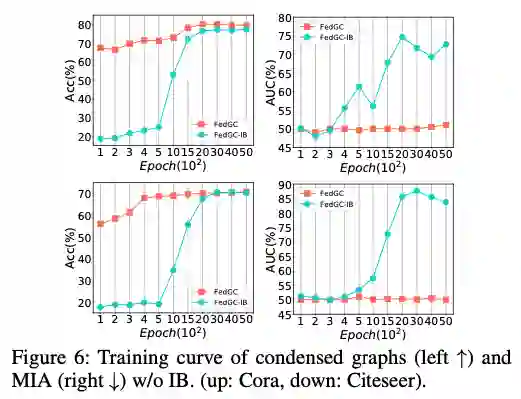

上图展示了有和没有 IB 的压缩图效用和 MIA 的联邦训练曲线,可以看到没有IB,模型收敛速度慢,性能也低于带有 IB的模型。快速收敛的原因在于在转换图之前使用自训练来标记节点,这会引入更多监督信号来训练 IB,从而将更准确的图信息纳入。MIA 的防御也受益于 IB, FedGC 在整个训练过程中始终保持较低的 AUC 分数。

参数实验

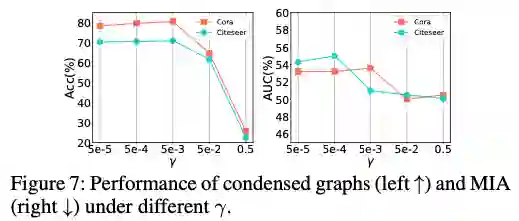

上图展示了不同的下 压缩图与MIA的表现。适当的可以提高泛化能力,但过大会迫使遵循特定的分布,在下游任务上表现不佳。MIA也有类似的趋势。较小的导致模型过拟合训练数据,从而增强MIA。相反, 过大会使与原始特征的相似度降低,从而消弱MIA。总体而言,控制了效用和隐私之间的平衡,现实中可以灵活调整。

五. 结论

在本文中,我们首次提出并研究了联邦图压缩任务。我们提出了一种通过加权梯度匹配的通用框架来保持压缩图的效用。我们还揭示了压缩图会泄露本地数据的成员隐私,并提出了一种基于信息瓶颈原理的本地图转换来保护隐私。实验和理论分析证明了我们方法的有效性。