摘要——视觉-语言模型(VLM)在开放词汇(OV)物体检测和分割任务中得到了广泛应用。尽管在与开放词汇相关的任务中展现了潜力,但它们在传统视觉任务中的有效性尚未得到评估。本研究对基于VLM的检测与分割进行了系统综述,将VLM视为基础模型,并首次对多个下游任务进行了全面评估: 1)评估涵盖了八个检测场景(闭集检测、领域适应、拥挤物体等)和八个分割场景(少样本、开放世界、小物体等),揭示了各种VLM架构在不同任务中的性能优势与局限性。 2)在检测任务中,我们在三种微调粒度下评估了VLM:零预测、视觉微调和文本提示,并进一步分析了不同微调策略如何在不同任务下影响性能。 3)基于实证研究结果,我们深入分析了任务特征、模型架构和训练方法之间的关联,为未来VLM设计提供了洞见。 4)我们相信,本工作将对从事计算机视觉、多模态学习和视觉基础模型研究的模式识别专家具有价值,帮助他们了解该问题并熟悉当前进展,同时为未来的研究提供有前景的方向。与本综述和评估相关的项目已创建于https://github.com/better-chao/perceptual-abilities-evaluation。

关键词——视觉-语言模型,物体检测,物体分割,视觉感知评估。

I. 引言

随着人工智能技术的快速发展,视觉-语言模型(VLM)已经成为多模态学习中的一个重要成果,成为计算机视觉和自然语言处理领域研究的焦点。这一演变的推动因素有几个:首先,模型架构的迭代发展,从传统的卷积神经网络(CNN)[1]–[4]到基于变换器的架构[5]–[8],再到大规模预训练模型[9]、[10],为提高VLM性能奠定了坚实的基础。其次,计算能力的显著进步,特别是GPU和TPU的快速发展,使得大规模数据和复杂模型的处理成为可能。此外,数据可用性的指数增长为VLM的发展提供了支持,数据集从有限规模扩展到大规模的视觉-语言数据集,为模型训练提供了大量的图像-文本对。此外,对复杂现实任务的需求日益增加,尤其是从传统的闭集检测到开放集场景的转变,这些任务需要多样化的能力,进一步推动了学术研究向多模态模型的方向发展。在这种背景下,VLM从单一模态方法发展到先进的多模态融合框架,展现出了显著的优势。通过对视觉和文本特征的对齐,VLM能够有效利用不同的数据形式,增强新类别的泛化能力,并在物体检测和分割任务中取得出色的表现。

视觉作为理解环境信息的核心感知通道,迫切需要系统地评估VLM在通过多模态理解提升传统视觉任务中的效果。物体检测[11]和分割[12]是计算机视觉中的基础任务,是感知和场景理解的重要组成部分。这些技术构成了多个领域中各种实际应用的基础,包括自动驾驶[13]、医学影像[14][15][16]、智能机器人[14]等。

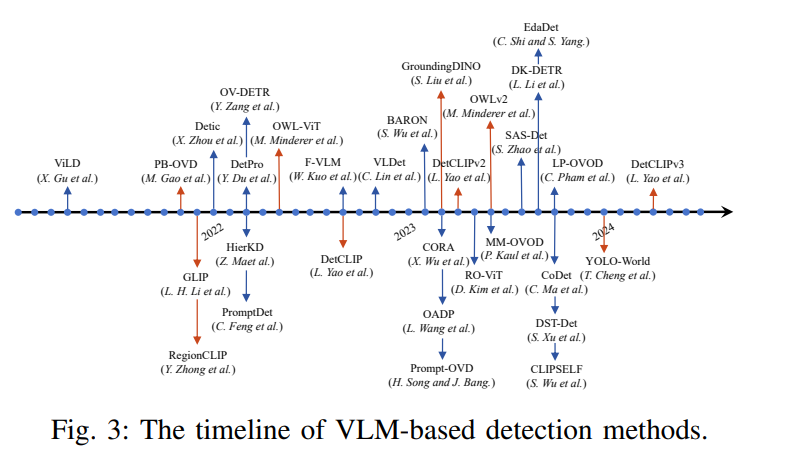

当前的VLM基本上通过对齐视觉和文本特征来实现其广泛且强大的能力。在物体检测任务中,基于VLM的检测通过对比学习方法将视觉特征与文本描述对齐,典型例子包括GLIP[17]和GroundingDINO[18],通过在大规模数据集(如CC12M(Conceptual 12M [19])、YFCC1M(YFCC100M的子集[20]))上的预训练,实现了对未见类别的泛化。在分割任务方面,近期的研究集中于将VLM的全局多模态对齐能力转移到细粒度的对齐任务,特别是区域-文本[21]和像素-文本对齐[22]。这些进展利用了多种监督策略,促进了像素级分割任务中的密集预测。

这些模型的核心延伸了如CLIP[10]等预训练方法的概念;然而,尽管CLIP作为分类模型工作,但不同VLM的对齐机制和原理有所不同。例如,一些模型利用对比学习进行特征对齐,而另一些则采用跨注意力机制进行特征融合。值得注意的是,当前的VLM主要在开放词汇(OV)任务上表现出色,但它们在向其他具体任务泛化的能力上仍然是一个需要进一步探索的领域。

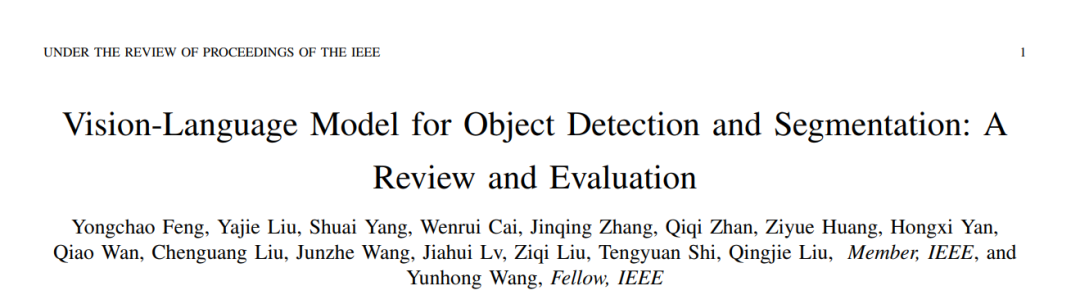

鉴于VLM的潜力和强大能力,许多研究已开始探索如何将VLM应用于下游任务,包括物体检测、语义分割等。例如,DA-Pro[23]基于RegionCLIP[24],通过为每个目标类别动态生成与领域相关和领域无关的提示前缀,从而显著提高跨领域检测性能。COUNTGD[25]通过在GroundingDINO[18]中增加目标类别的视觉示例来增强文本提示,形成增强的文本描述,以检测输入图像中的目标物体,成为第一个开放世界计数模型。然而,现有的研究和相关综述主要集中在开放词汇设置中的检测和分割任务,往往忽视了现实世界场景的复杂性和挑战。因此,在广泛的视觉下游任务中的全面评估尚未开展。如图1所示,为了全面评估VLM模型在不同场景中的表现,我们设计了8种不同的检测任务设置,涵盖了传统的闭集检测任务、开放词汇相关任务、领域适应场景以及更为现实的密集物体场景。对于分割任务,我们设置了8种不同的设置,包括零样本评估、开放世界语义分割任务、以及小物体和密集分割任务。

在本研究中,我们呈现了对视觉-语言模型(VLM)在密集预测视觉任务中的全面调研,并总结了我们的三大主要贡献如下:

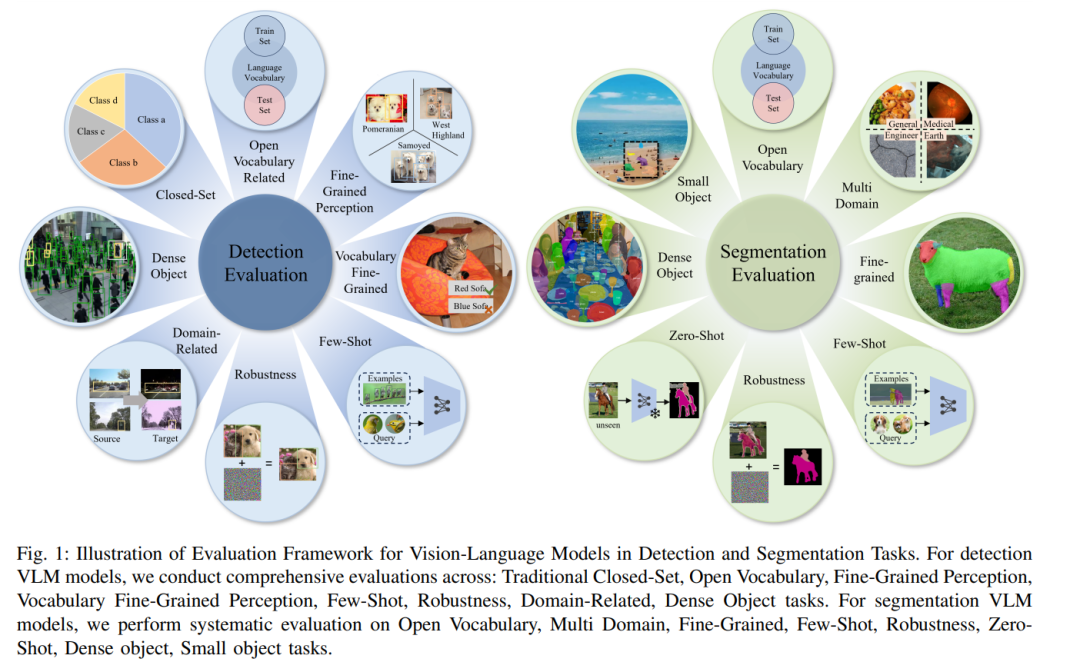

• 开创性的评估:本文首次将VLM作为“基础模型”进行全面评估,涵盖了广泛的下游视觉任务。通过这一独特的视角,我们系统地展示了VLM在不同视觉任务中的表现,为理解其潜力和局限性提供了宝贵的基准。 • 微调策略的细粒度分析:我们系统地研究了三种微调方法——零预测、视觉微调和文本提示——在下游任务中的影响,特别关注分割任务。通过深入分析,揭示了各种微调策略在实际应用中的优缺点,为模型优化提供了关键见解。

• 机制深入分析:从训练方法和模型架构的角度出发,我们探讨了这些因素如何影响模型在下游任务中的表现。本研究不仅关注表面应用,还深入探讨了VLM的内在机制,为未来模型设计和改进提供了支持。

总之,我们的研究不仅提供了对VLM的全面评估和深入分析,还为推动该领域的进展奠定了坚实的基础,促进了物体检测和分割任务的进一步突破和进展。本文的剩余部分结构如下:第二节回顾了基于VLM的检测和分割相关工作;第三节和第四节展示了检测和分割评估结果及相应的任务分析;第五节概述了VLM发展的潜在未来方向;最后,第六节总结了本文并概括了工作的重要贡献。