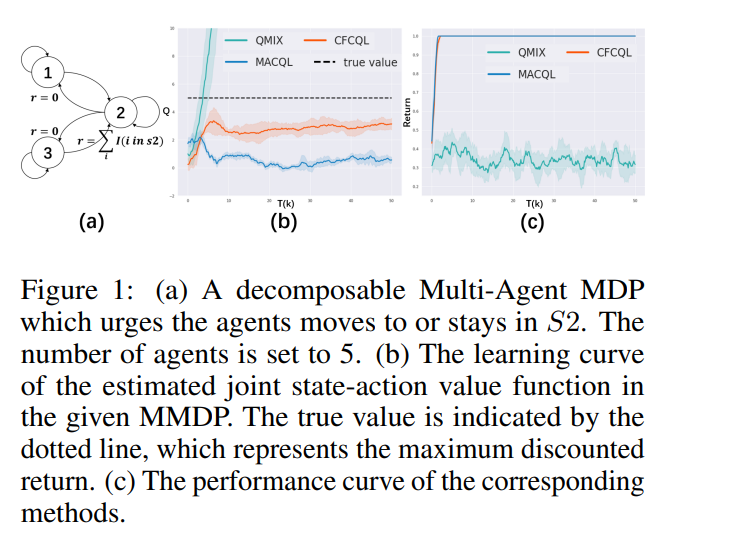

由于离线多智能体强化学习面临着分布偏移问题和多智能体环境中常见的高维度问题的耦合效应,所以非常具有挑战性,导致动作超出分布(OOD)和价值过高估计现象极为严重。为了减轻这个问题,我们提出了一种新的多智能体离线RL算法,名为CounterFactual Conservative Q-Learning(CFCQL),用于进行保守的价值估计。CFCQL不是将所有智能体视为高维单一实体并直接对其应用单一智能体方法,而是以反事实的方式为每个智能体分别计算保守正则化,然后线性组合它们,以实现整体保守价值估计。我们证明,尽管它仍然具有低估特性和单一智能体保守方法的性能保证,但引入的正则化和安全政策改进边界独立于智能体数量,因此理论上优于上述直接处理方法,特别是当智能体数量较大时。我们还在包括离散和连续动作设置在内的四个环境中进行了实验,这些环境包括现有的和我们制作的数据集,实验表明CFCQL在大多数数据集上胜过现有方法,甚至在其中一些数据集上以显著优势胜出。

https://www.zhuanzhi.ai/paper/87817b0ed2fee90a1f0cb765e25d5a38

成为VIP会员查看完整内容

相关内容

Arxiv

42+阅读 · 2023年4月19日

Arxiv

224+阅读 · 2023年4月7日

Arxiv

152+阅读 · 2023年3月29日