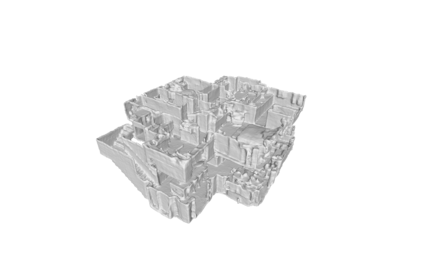

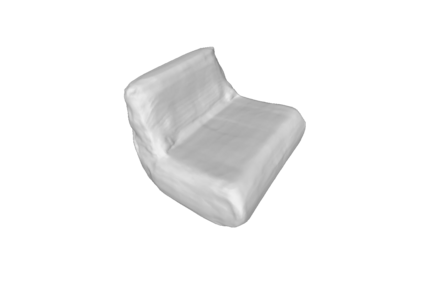

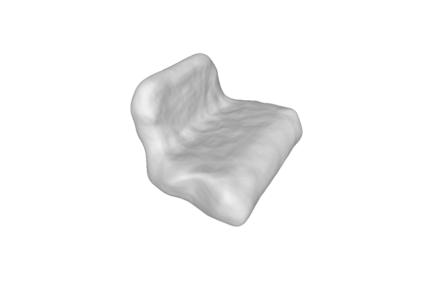

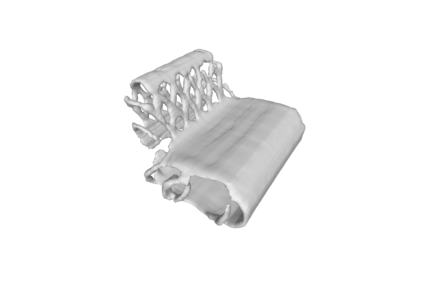

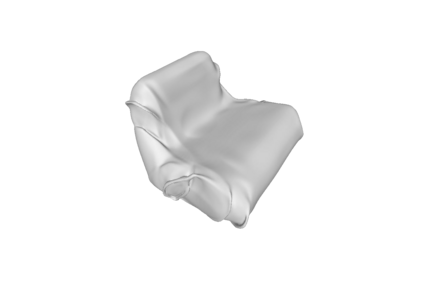

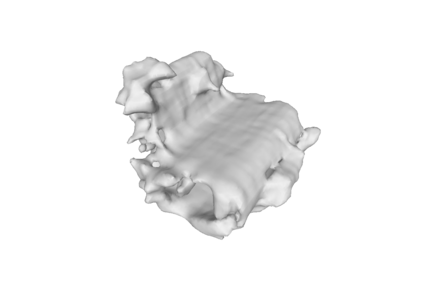

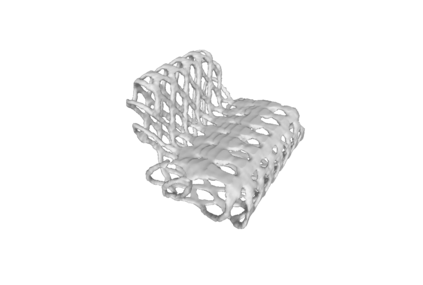

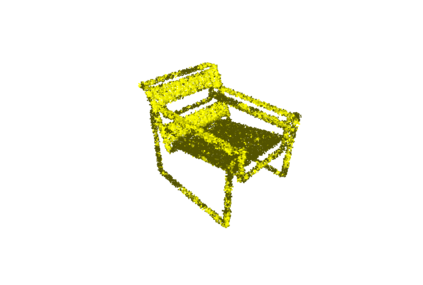

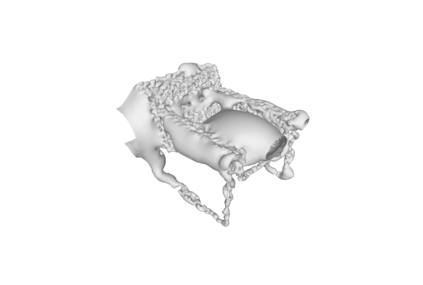

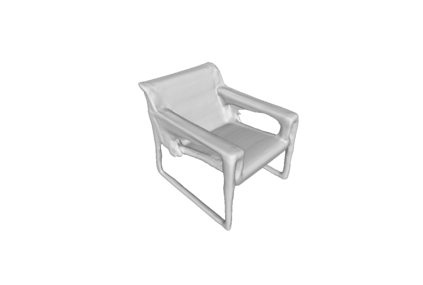

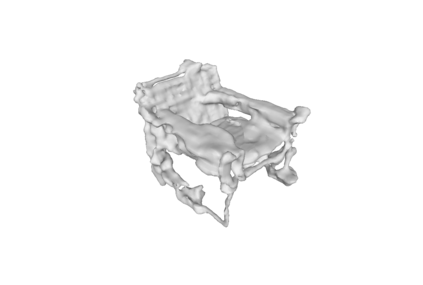

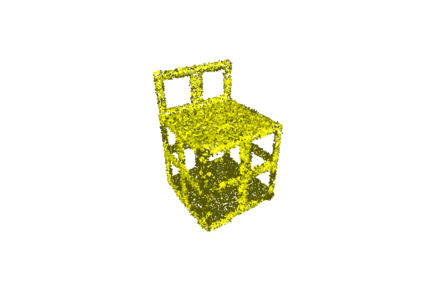

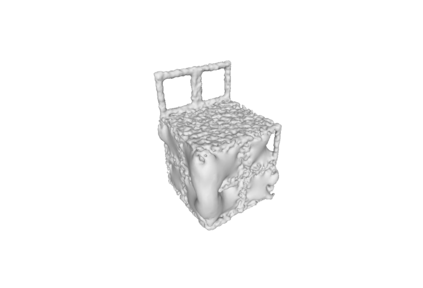

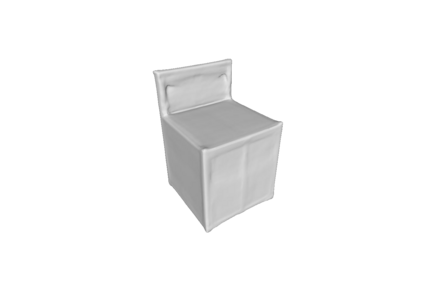

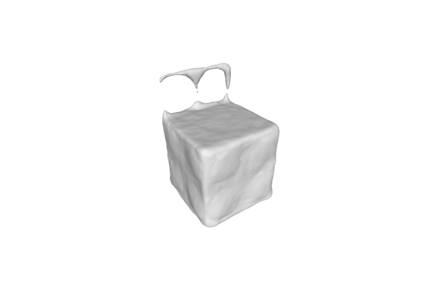

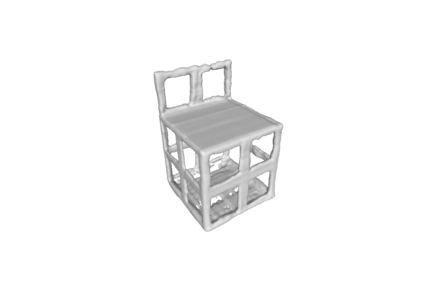

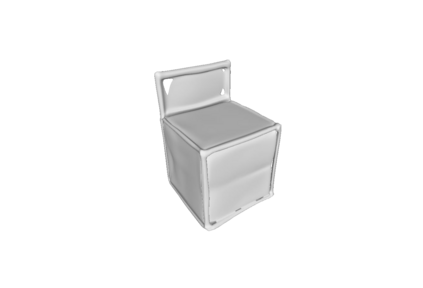

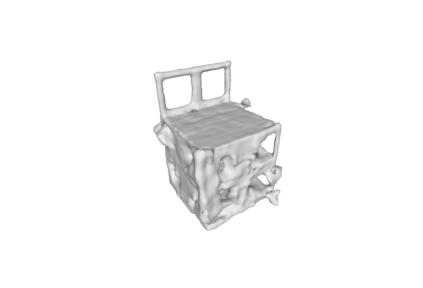

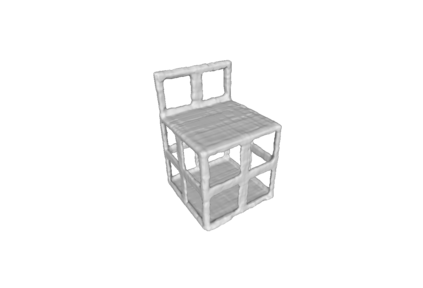

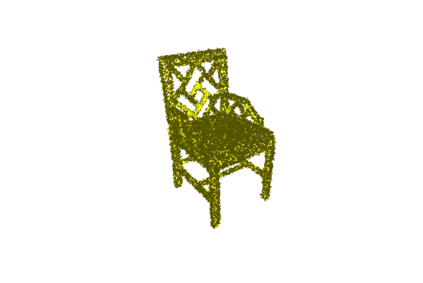

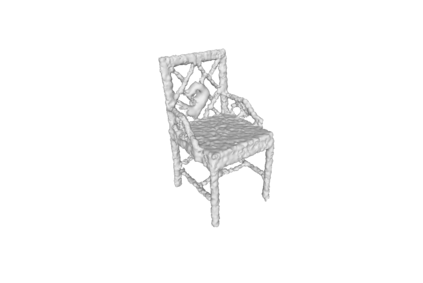

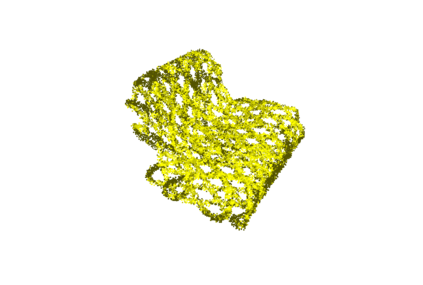

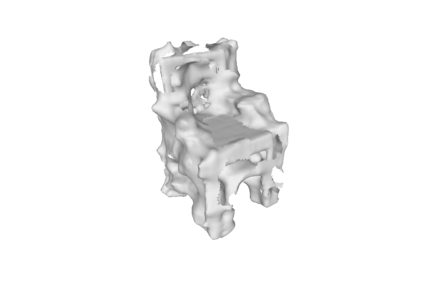

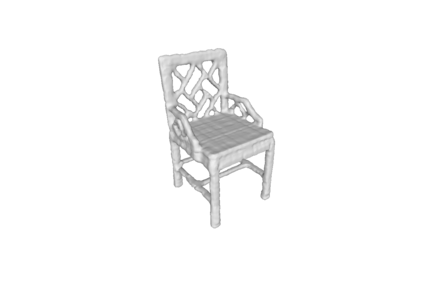

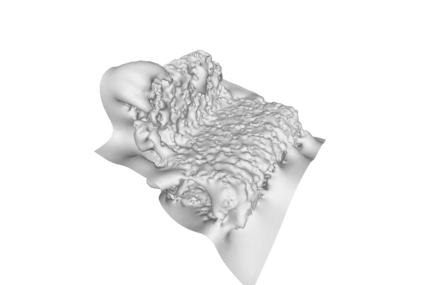

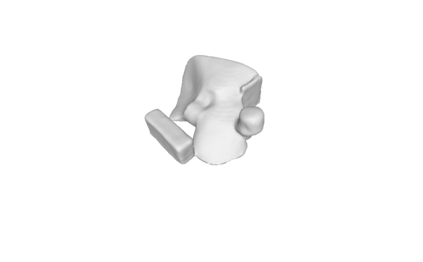

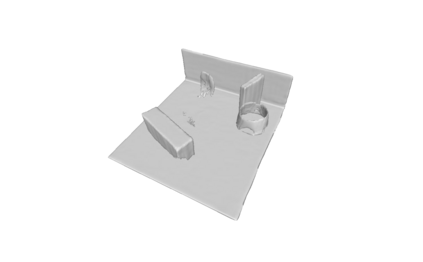

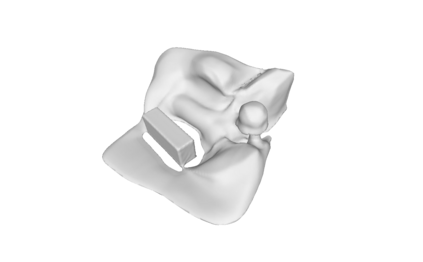

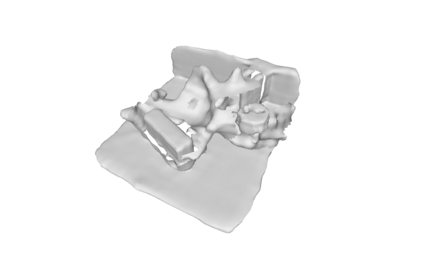

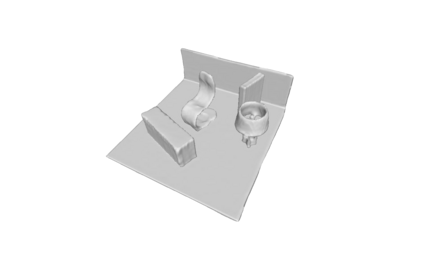

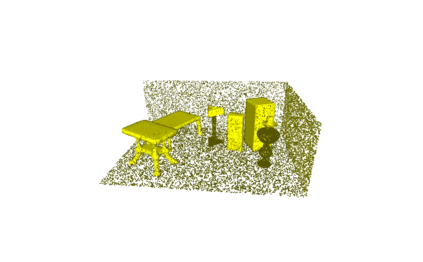

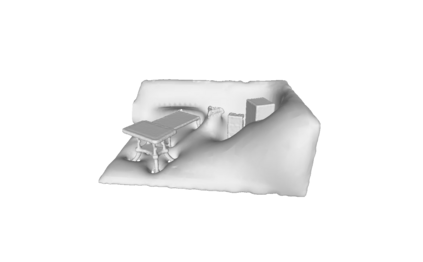

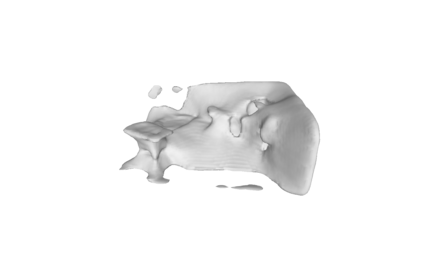

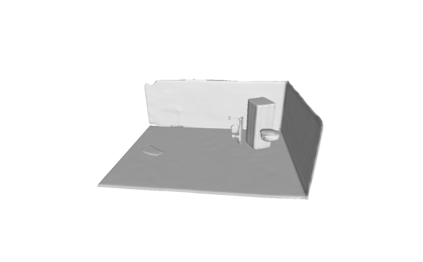

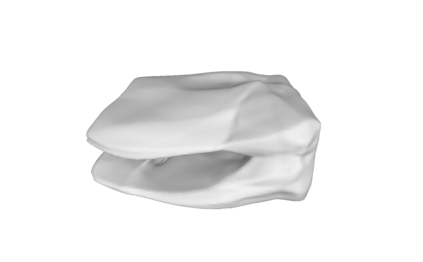

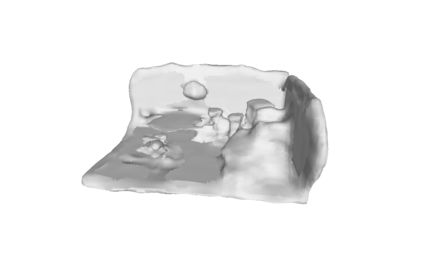

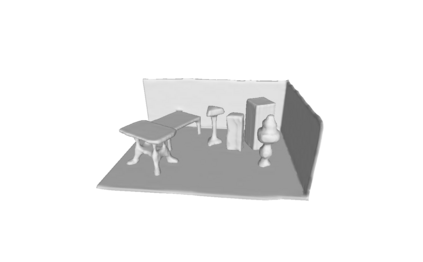

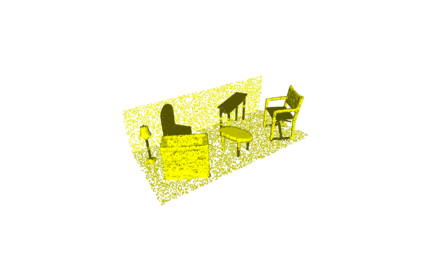

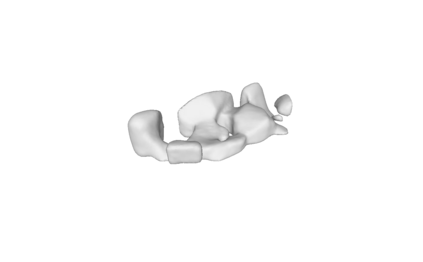

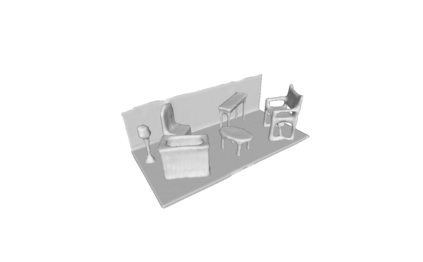

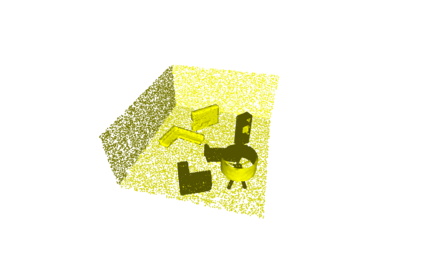

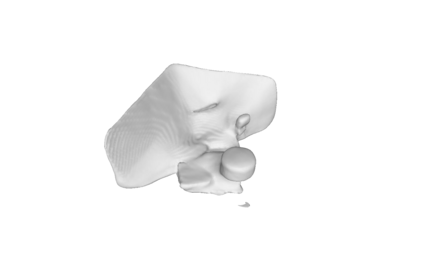

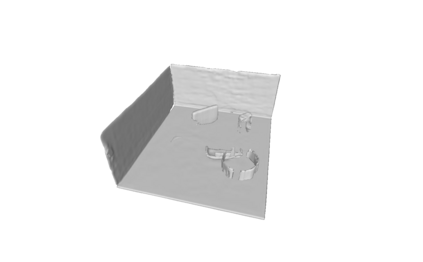

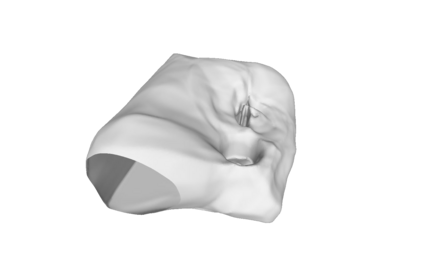

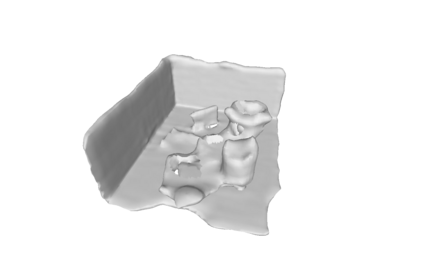

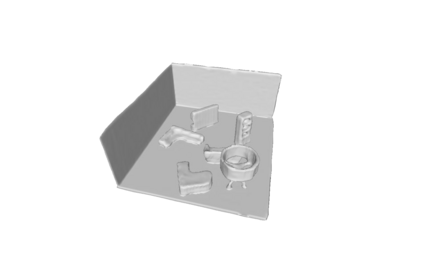

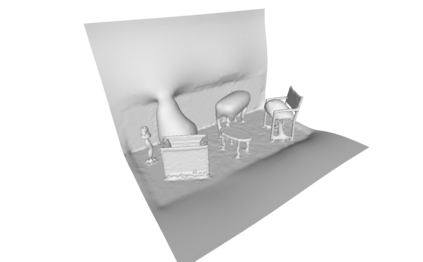

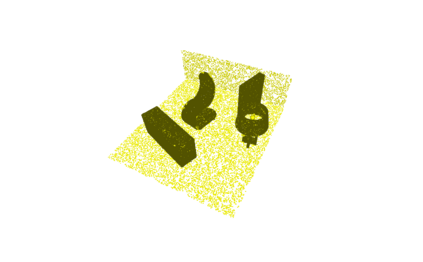

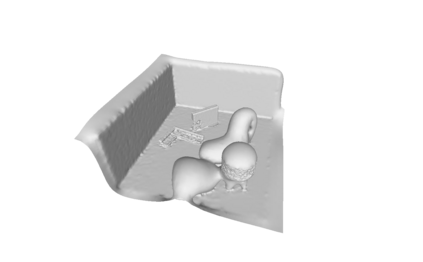

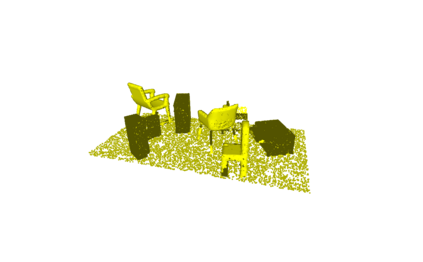

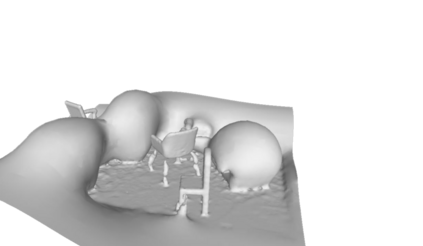

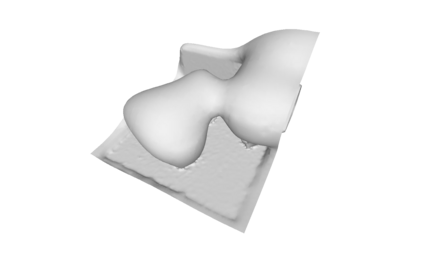

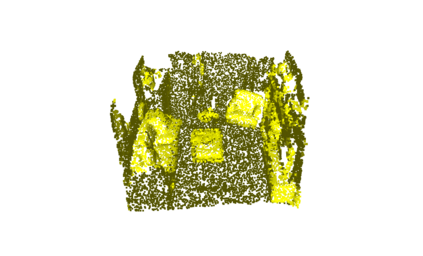

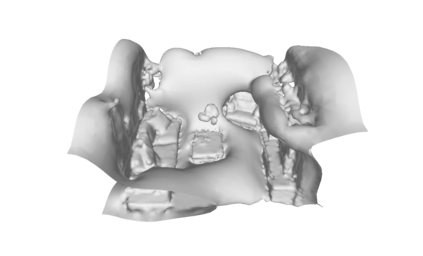

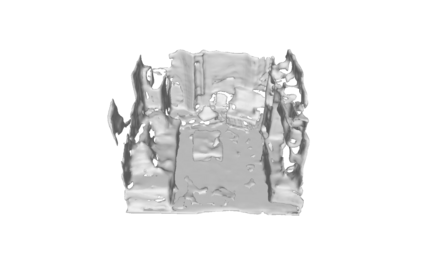

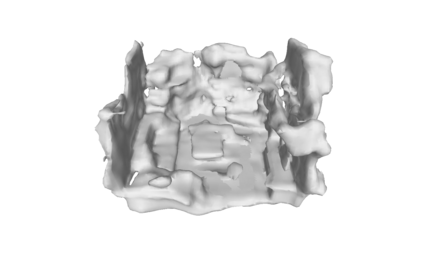

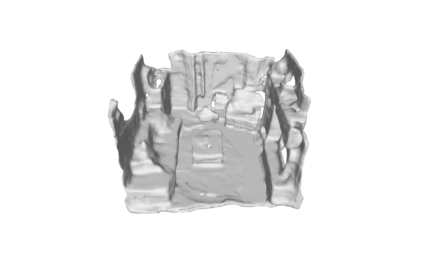

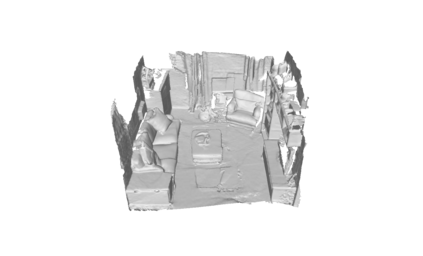

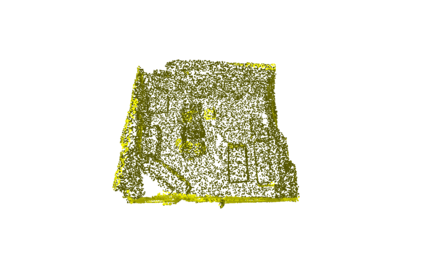

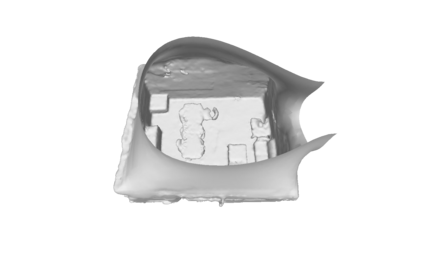

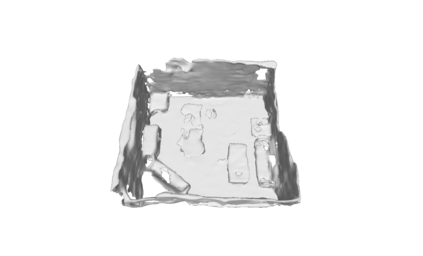

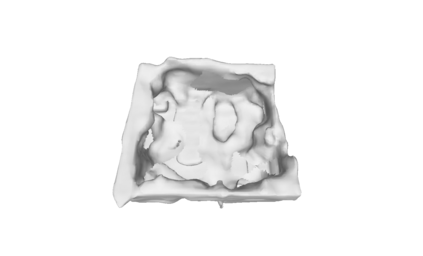

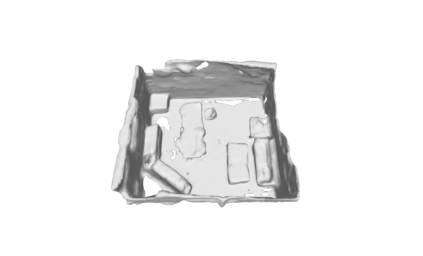

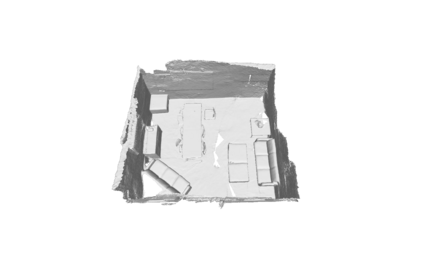

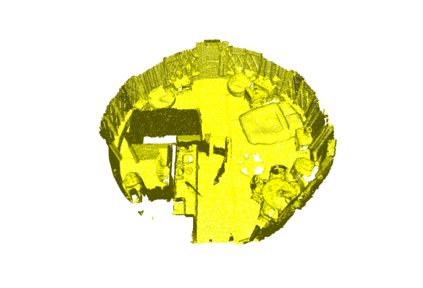

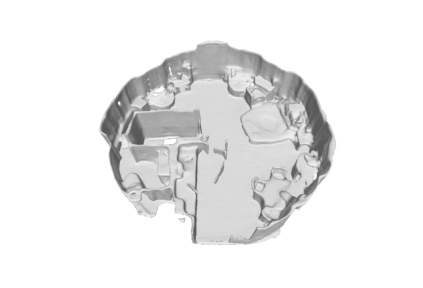

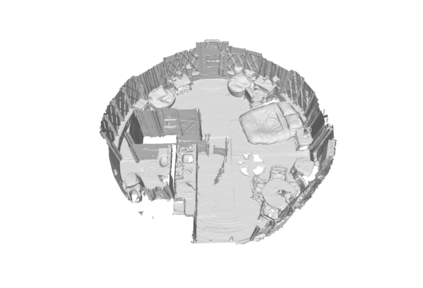

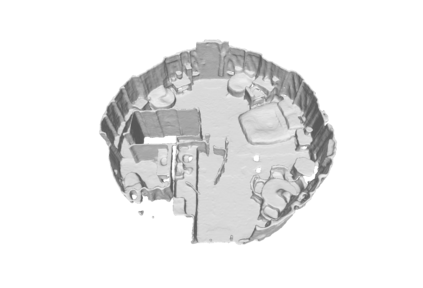

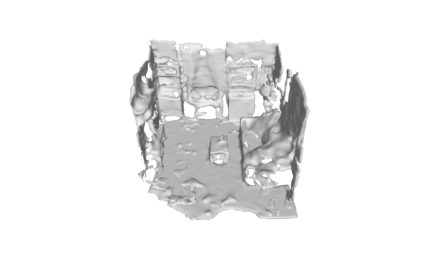

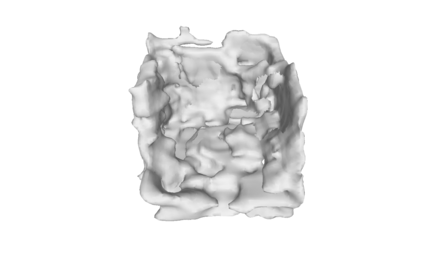

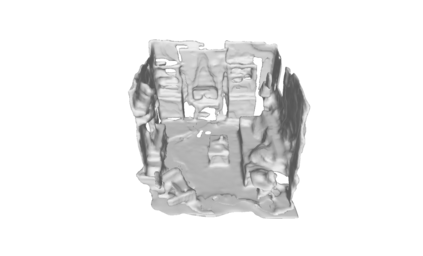

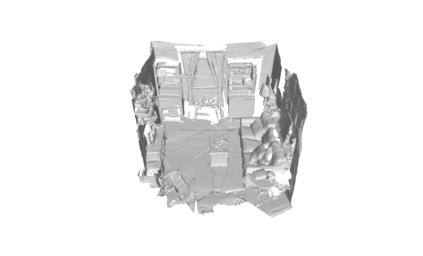

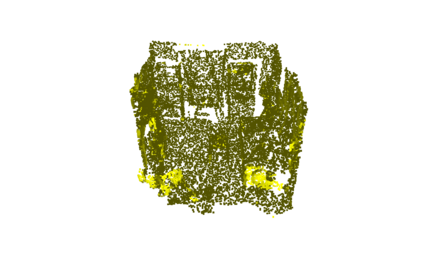

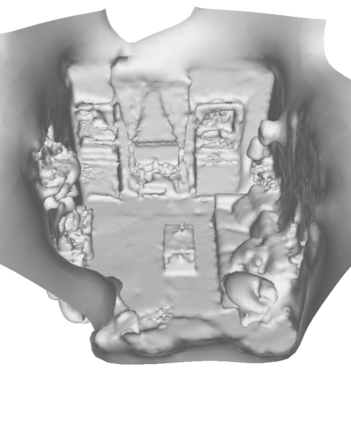

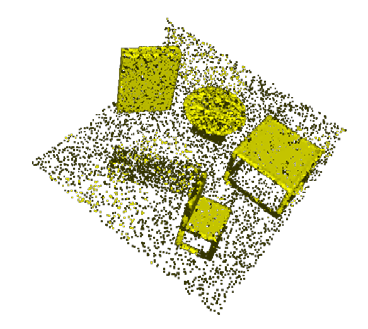

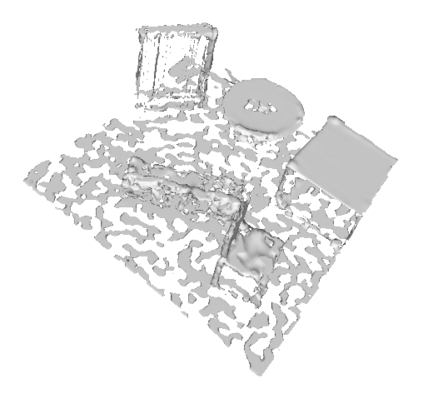

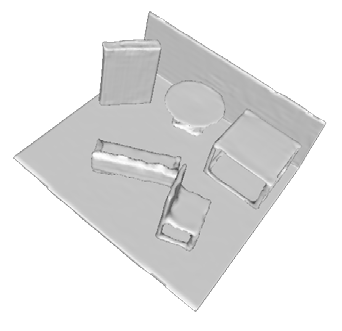

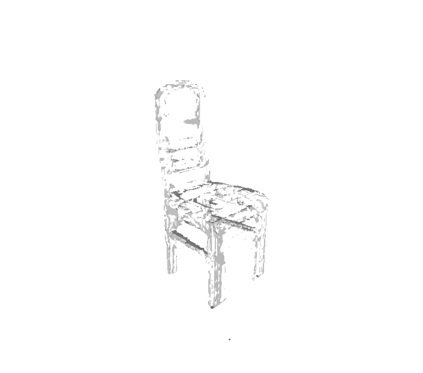

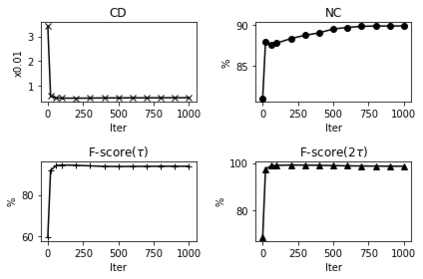

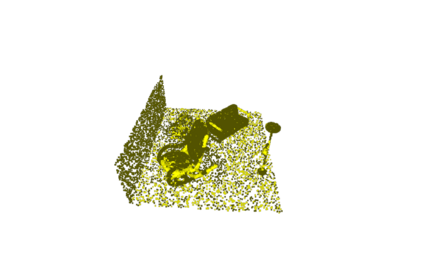

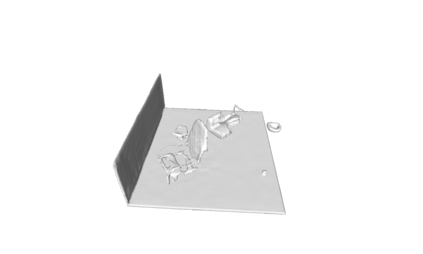

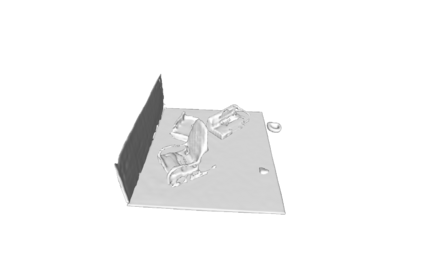

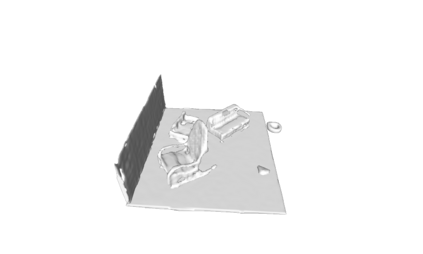

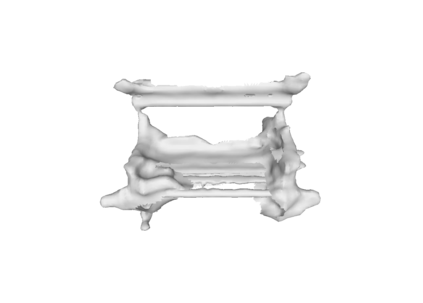

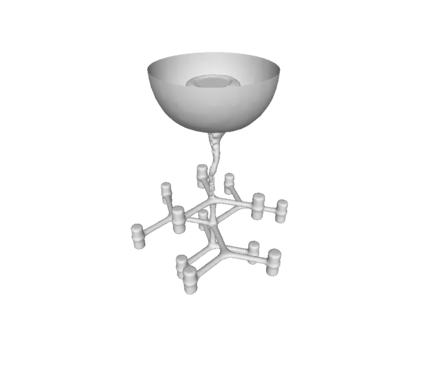

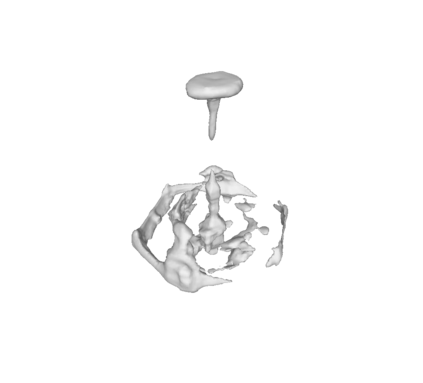

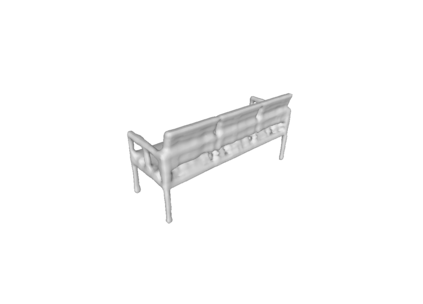

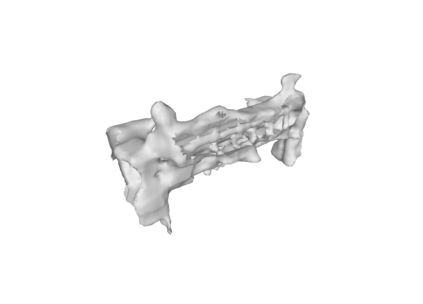

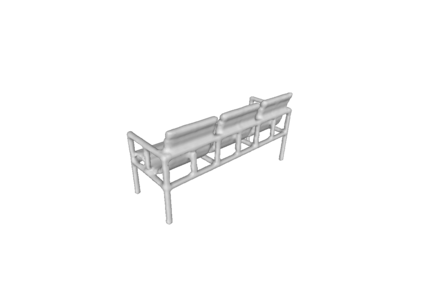

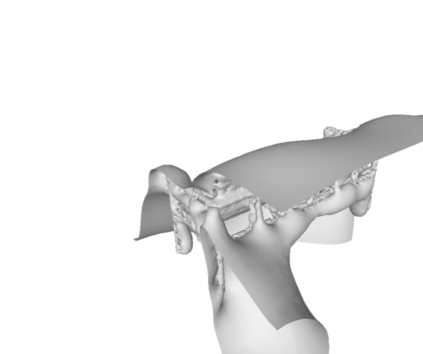

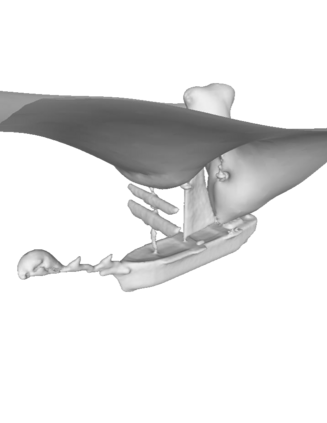

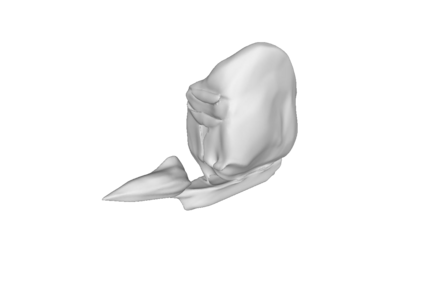

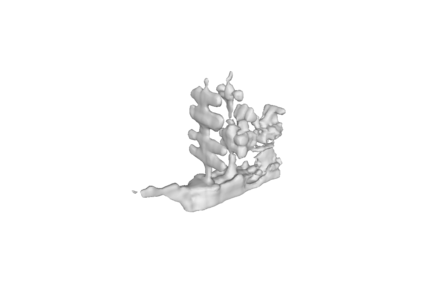

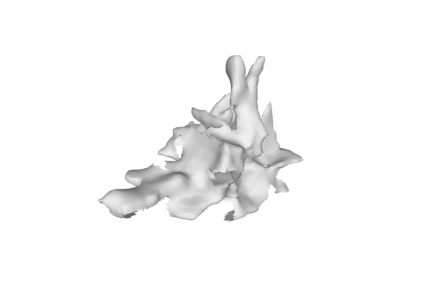

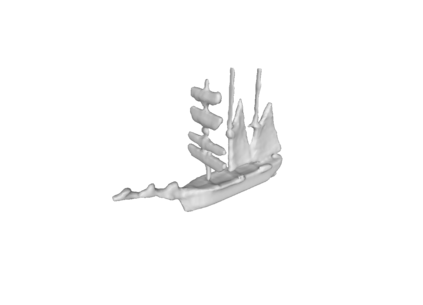

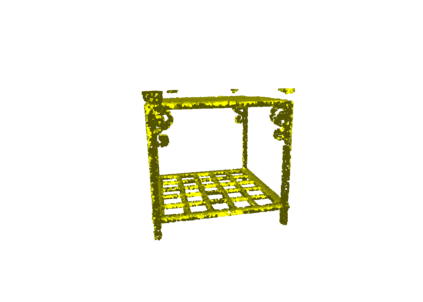

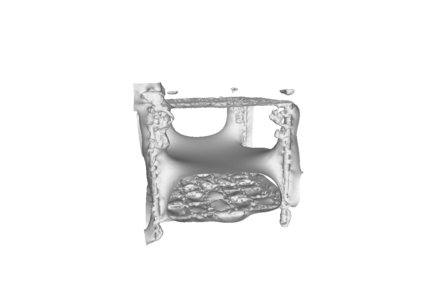

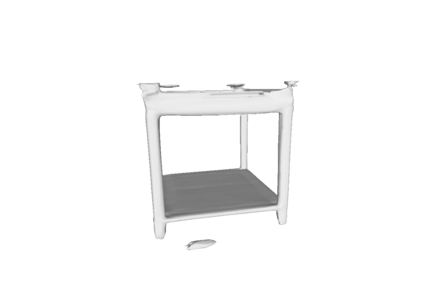

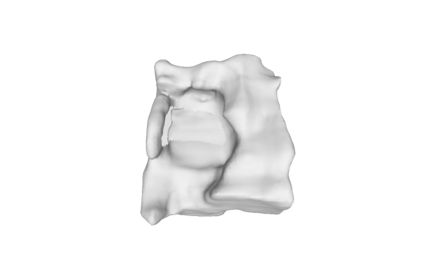

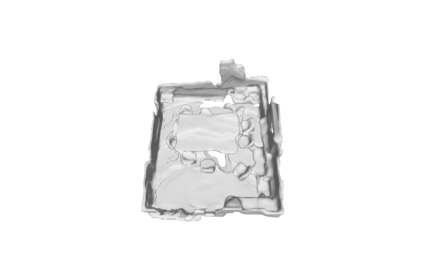

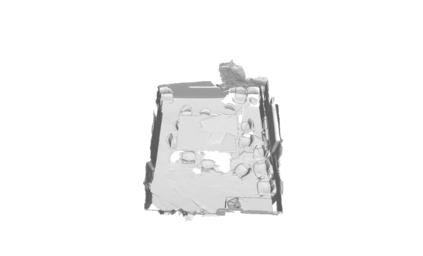

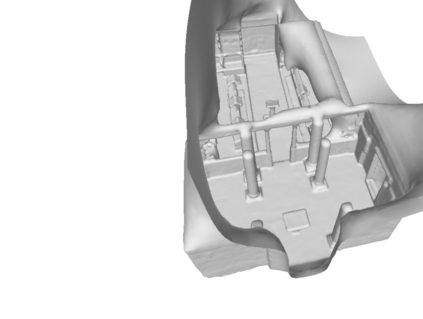

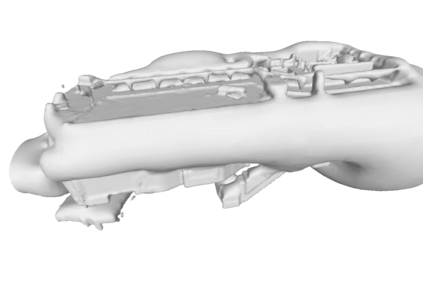

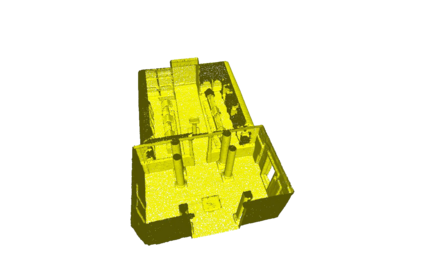

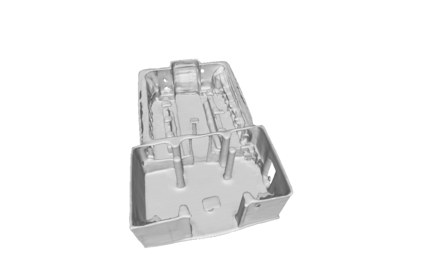

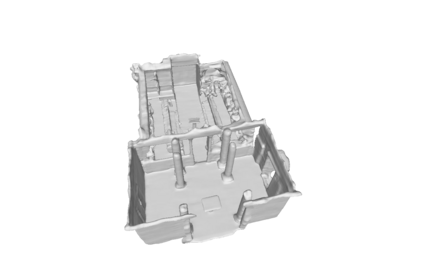

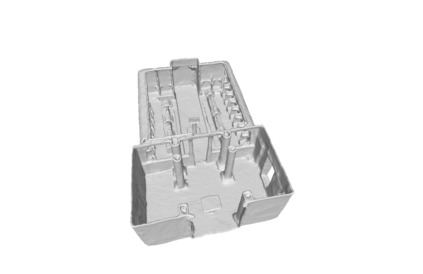

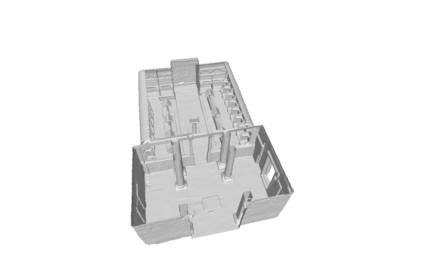

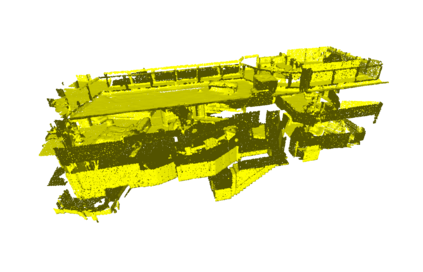

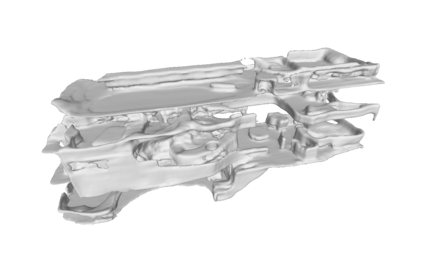

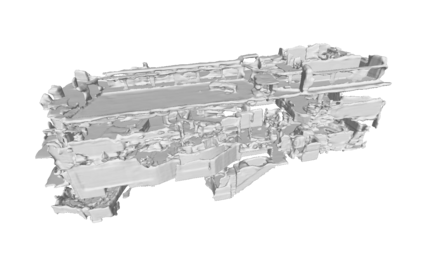

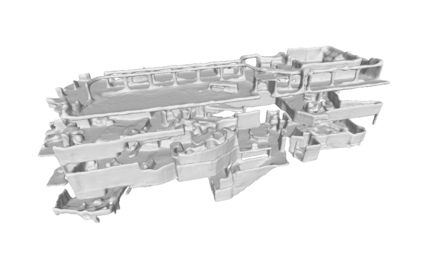

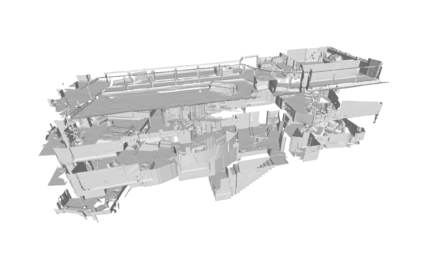

Surface reconstruction from point clouds is a fundamental problem in the computer vision and graphics community. Recent state-of-the-arts solve this problem by individually optimizing each local implicit field during inference. Without considering the geometric relationships between local fields, they typically require accurate normals to avoid the sign conflict problem in overlapped regions of local fields, which severely limits their applicability to raw scans where surface normals could be unavailable. Although SAL breaks this limitation via sign-agnostic learning, further works still need to explore how to extend this technique for local shape modeling. To this end, we propose to learn implicit surface reconstruction by sign-agnostic optimization of convolutional occupancy networks, to simultaneously achieve advanced scalability to large-scale scenes, generality to novel shapes, and applicability to raw scans in a unified framework. Concretely, we achieve this goal by a simple yet effective design, which further optimizes the pre-trained occupancy prediction networks with an unsigned cross-entropy loss during inference. The learning of occupancy fields is conditioned on convolutional features from an hourglass network architecture. Extensive experimental comparisons with previous state-of-the-arts on both object-level and scene-level datasets demonstrate the superior accuracy of our approach for surface reconstruction from un-orientated point clouds. The code is available at https://github.com/tangjiapeng/SA-ConvONet.

翻译:从点云层进行表面重建是计算机视觉和图形界的一个根本问题。 最近的先进艺术通过在推论期间个别优化每个地方隐隐领域来解决这个问题。 在不考虑地方字段之间的几何关系的情况下,它们通常需要精确的正常度以避免地方字段重叠区域中的标志性冲突问题,这严重限制了它们对原始扫描的可应用性,在原始扫描中可能无法获得表面常态。 虽然SAL通过标志- 不可知性学习打破了这一限制, 但是进一步的工作还需要探索如何推广这种技术, 用于本地形状建模。 为此, 我们提议通过对革命占用网络进行标志- 不可知性优化来学习隐含的表面重建。 以便同时实现对大型场景的高级可缩缩放性、 对新形状的一般性以及对于在统一框架内进行原始扫描的可适用性。 具体地说,我们通过简单而有效的设计来达到这一目标, 进一步优化预先训练的占用预测网络, 并在推断期间将未完成的跨热带损失进一步优化。 占用域域域域系的学习以来自时镜端网络结构结构的变特征为条件。 与前期的轨道级目标级水平的轨道/, 与以前的精确度对比对比对比对比, 在前的重建中, 在前的轨道上, 在前的轨道上进行对比, 正在展示, 在前的轨道上展示, 在前的轨道上展示, 在前地基面线面线面图面线上展示, 在前的精确度分析。