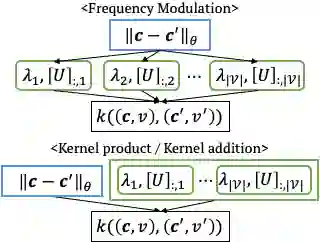

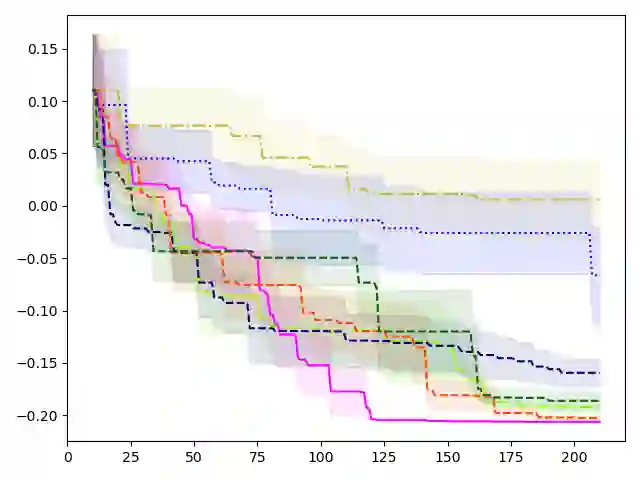

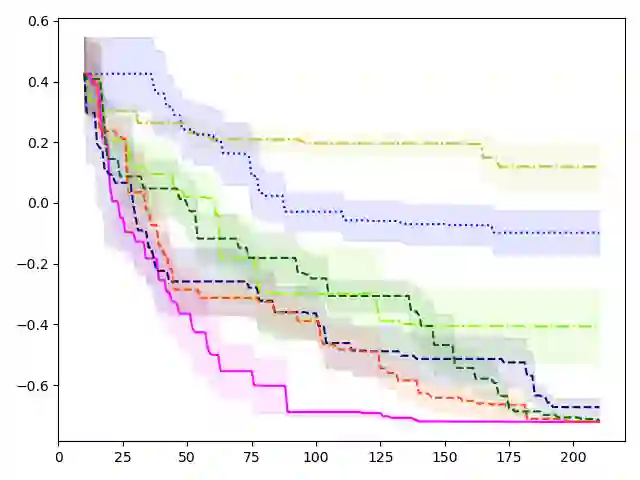

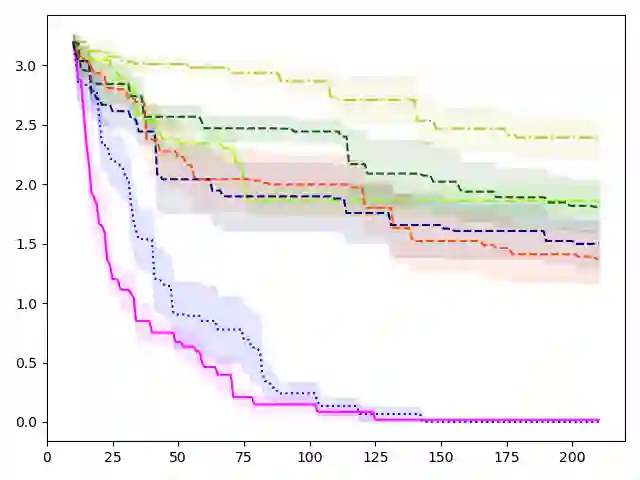

The sample efficiency of Bayesian optimization(BO) is often boosted by Gaussian Process(GP) surrogate models. However, on mixed variable spaces, surrogate models other than GPs are prevalent, mainly due to the lack of kernels which can model complex dependencies across different types of variables. In this paper, we propose the frequency modulated (FM) kernel flexibly modeling dependencies among different types of variables, so that BO can enjoy the further improved sample efficiency. The FM kernel uses distances on continuous variables to modulate the graph Fourier spectrum derived from discrete variables. However, the frequency modulation does not always define a kernel with the similarity measure behavior which returns higher values for pairs of more similar points. Therefore, we specify and prove conditions for FM kernels to be positive definite and to exhibit the similarity measure behavior. In experiments, we demonstrate the improved sample efficiency of GP BO using FM kernels (BO-FM).On synthetic problems and hyperparameter optimization problems, BO-FM outperforms competitors consistently. Also, the importance of the frequency modulation principle is empirically demonstrated on the same problems. On joint optimization of neural architectures and SGD hyperparameters, BO-FM outperforms competitors including Regularized evolution(RE) and BOHB. Remarkably, BO-FM performs better even than RE and BOHB using three times as many evaluations.

翻译:Bayesian优化(BO)的样本效率往往因Gaussian Process(GP)替代模型而提高。然而,在混杂的变异空间上,替代GP以外的替代模型很普遍,主要原因是缺乏内核,这些内核可以模拟不同类型变量的复杂依赖性。在本论文中,我们提议调频调制(FM)内核灵活建模不同类型变量之间的依赖性模型,这样BBB可以享受进一步提高的样本效率。调频内核对连续变量的距离用于调制来自离散变量的Fourier光谱图的调控。然而,频率调频调制并不总能定义一个内核,具有类似测量性的行为,这种内核反应为不同类型变量的对等。因此,我们提出并证明调频内核的调(FM)调(FM)内核(B-FM)的样本效率得到提高。关于合成问题和超光度优化问题,B-REFM(B-R)竞争者以一致的方式,以及B-RMFM(B-R-B-R-B-B-B-B-B-B-B-B-B-B-B-B-B-B-B-B-B-B-B-B-B-B-B-B-B-B-B-B-B-B-B-B-B-B-B-B-B-B-B-B-B-B-B-B-B-B-B-B-B-B-B-B-B-B-B-B-B-B-B-B-B-B-B-B-B-B-B-B-B-B-B-B-B-B-B-B-B-B-B-B-B-B-B-B-B-B-B-B-B-B-B-B-B-B-B-B-B-B-B-B-B-B-B-B-B-B-B-B-B-B-B-B-B-B-B-B-B-B-B-B-B-B-B-B-B-B-B-B-B-B-B-A)-