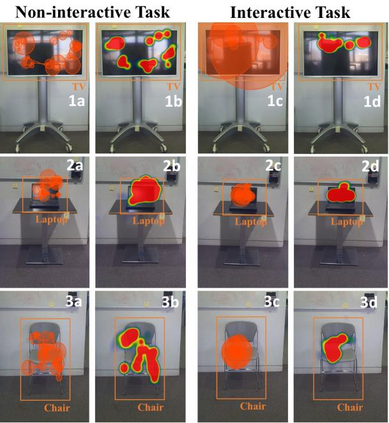

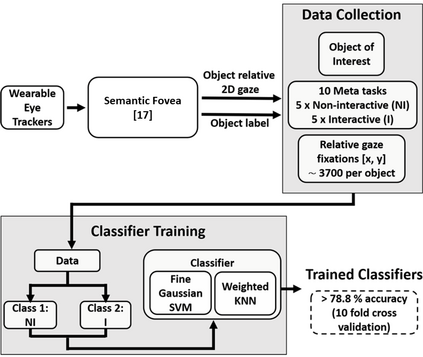

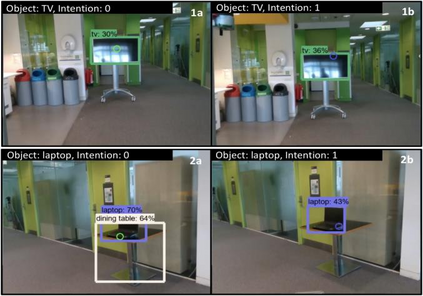

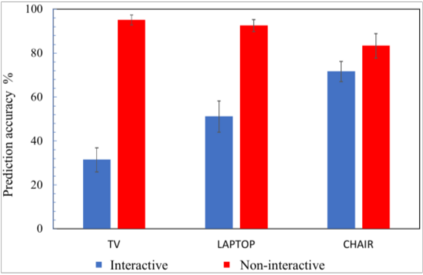

We have pioneered the Where-You-Look-Is Where-You-Go approach to controlling mobility platforms by decoding how the user looks at the environment to understand where they want to navigate their mobility device. However, many natural eye-movements are not relevant for action intention decoding, only some are, which places a challenge on decoding, the so-called Midas Touch Problem. Here, we present a new solution, consisting of 1. deep computer vision to understand what object a user is looking at in their field of view, with 2. an analysis of where on the object's bounding box the user is looking, to 3. use a simple machine learning classifier to determine whether the overt visual attention on the object is predictive of a navigation intention to that object. Our decoding system ultimately determines whether the user wants to drive to e.g., a door or just looks at it. Crucially, we find that when users look at an object and imagine they were moving towards it, the resulting eye-movements from this motor imagery (akin to neural interfaces) remain decodable. Once a driving intention and thus also the location is detected our system instructs our autonomous wheelchair platform, the A.Eye-Drive, to navigate to the desired object while avoiding static and moving obstacles. Thus, for navigation purposes, we have realised a cognitive-level human interface, as it requires the user only to cognitively interact with the desired goal, not to continuously steer their wheelchair to the target (low-level human interfacing).

翻译:我们开创了控制移动平台的“何地看,何地看,你到何地看 ” 方法, 解码用户如何看待环境以了解他们想要浏览移动装置。 然而, 许多自然眼运动与行动意图解码无关, 只有一些自然眼睛运动与行动意图解码无关, 给解码带来挑战, 即所谓的“ 门或只是看一看 ” 问题。 在这里, 我们提出了一个新解决方案, 包括1. 深深层的计算机视野, 以了解用户在其视野中看到的对象, 以及2. 分析用户在物体的捆绑框中寻找的物体的位置, 到3. 使用简单的机器学习分类器, 以确定该物体的表面视觉关注是否预示着该物体的导航意图。 我们的解码系统最终决定了用户是否想要去解码, 比如, 门或只是看一个物体, 想象它们正在朝向它的方向移动, 由此产生的视觉运动图象( 与神经界面相对) 仍然可以弯曲。 当驱动一个目标, 一旦驱动目标,, 我们的视觉目标, 方向, 也测量到 方向定位 方向 方向, 我们的定位, 我们的定位定位定位定位, 我们的定位, 方向 测量到一个方向, 我们的定位, 我们的定位, 我们的定位定位, 需要 方向 向一个方向, 向一个方向, 向一个方向, 我们的定位, 我们的定位, 我们的定位, 向, 测测测测测到一个方向, 方向, 我们的轨道, 我们测测测到一个方向, 我们测测到一个方向, 测到一个方向, 我们的轨道, 我们的轨道, 测到一个方向, 测到一个方向, 测到一个方向, 测到一个方向, 测到一个方向, 测到一个方向, 测到一个方向, 测到一个方向, 我们的轨道, 测到一个方向, 我们的轨道, 方向, 测到一个方向到它。到它。 测到它。 测到一个方向到它。