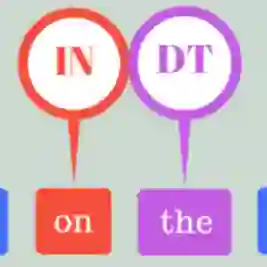

While there has been significant progress towards developing NLU resources for Indic languages, syntactic evaluation has been relatively less explored. Unlike English, Indic languages have rich morphosyntax, grammatical genders, free linear word-order, and highly inflectional morphology. In this paper, we introduce Vy\=akarana: a benchmark of gender-balanced Colorless Green sentences in Indic languages for syntactic evaluation of multilingual language models. The benchmark comprises four syntax-related tasks: PoS Tagging, Syntax Tree-depth Prediction, Grammatical Case Marking, and Subject-Verb Agreement. We use the datasets from the evaluation tasks to probe five multilingual language models of varying architectures for syntax in Indic languages. Due to its prevalence, we also include a code-switching setting in our experiments. Our results show that the token-level and sentence-level representations from the Indic language models (IndicBERT and MuRIL) do not capture the syntax in Indic languages as efficiently as the other highly multilingual language models. Further, our layer-wise probing experiments reveal that while mBERT, DistilmBERT, and XLM-R localize the syntax in middle layers, the Indic language models do not show such syntactic localization.

翻译:虽然在开发印度语的NLU资源方面取得了显著进展,但合成评价的探索却相对较少。与英语不同,印度语与英语不同,印度语具有丰富的形态学、语法性别、自由线性文字顺序和高度纵向形态学。在本文中,我们引入了Vyakarana:性别平衡的印度语无色绿色句的基准,用于多语模式的综合评估。基准包括四项与语法有关的任务:Pos taxing、语系深入预测、格莱玛特案例标记和主题-Verb协议。我们使用评估任务中的数据集来探测五种不同语系结构的多种语言模式,用于印度语的合成。由于其普遍性,我们还在我们的实验中包括了一个代码转换设置。我们的结果显示,印度语模式(IndicBERT和MuriLL)的象征性级别和判决级表达方式并没有将印化语言的语系合成语言作为其他高度多语种语言模式有效体现。此外,我们使用评价任务的数据集测试中层B 展示了其他高语言模式。