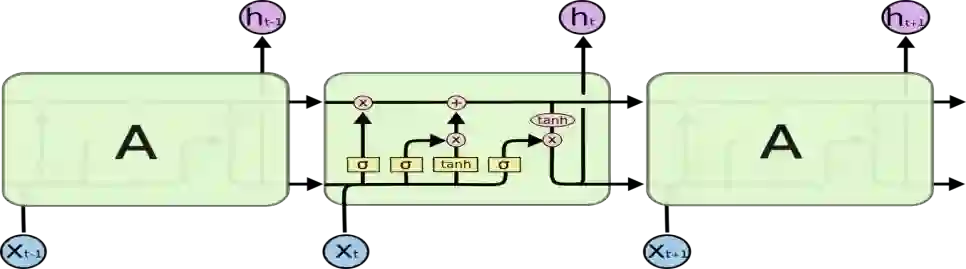

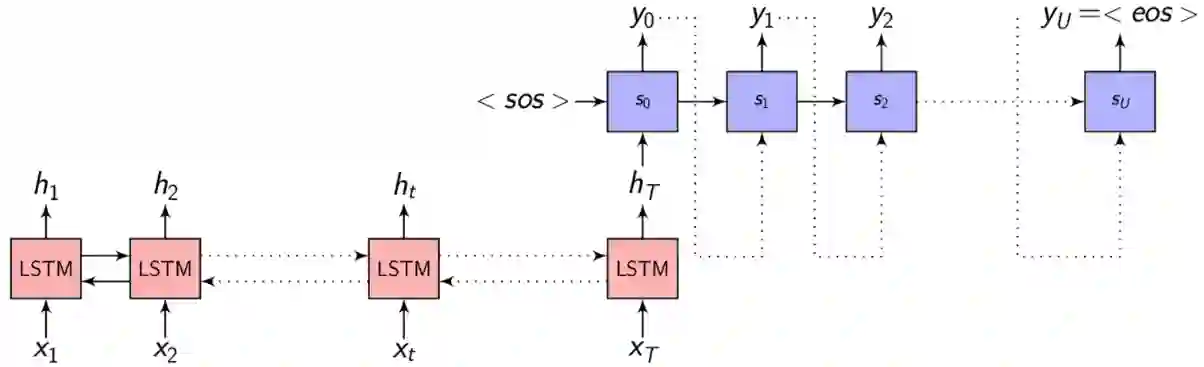

Abstractive Text Summarization is the process of constructing semantically relevant shorter sentences which captures the essence of the overall meaning of the source text. It is actually difficult and very time consuming for humans to summarize manually large documents of text. Much of work in abstractive text summarization is being done in English and almost no significant work has been reported in Telugu abstractive text summarization. So, we would like to propose an abstractive text summarization approach for Telugu language using Deep learning. In this paper we are proposing an abstractive text summarization Deep learning model for Telugu language. The proposed architecture is based on encoder-decoder sequential models with attention mechanism. We have applied this model on manually created dataset to generate a one sentence summary of the source text and have got good results measured qualitatively.

翻译:抽象文本摘要是一个过程,它反映了源文本总体含义的精髓。实际上,对于人类来说,手工归纳大量文本文件是困难和耗时的。许多抽象文本摘要工作正在用英文完成,而在Telugu抽象文本摘要中几乎没有报告任何重要工作。因此,我们想提出一种抽象的文本摘要方法,用于使用深层学习的Telugu语。在本文中,我们建议了一种抽象文本摘要模型,用于Telugu语的深层学习模式。提议的建筑基于带有注意机制的编码-解码器顺序模型。我们应用了这一模型,在人工创建的数据集上生成了源文本的一句话摘要,并取得了质量方面的良好效果。