@即将开学的你,请收好这份必读论文清单

在碎片化阅读充斥眼球的时代,越来越少的人会去关注每篇论文背后的探索和思考。

在这个栏目里,你会快速 get 每篇精选论文的亮点和痛点,时刻紧跟 AI 前沿成果。

点击本文底部的「阅读原文」即刻加入社区,查看更多最新论文推荐。

@FindMyPaper 推荐

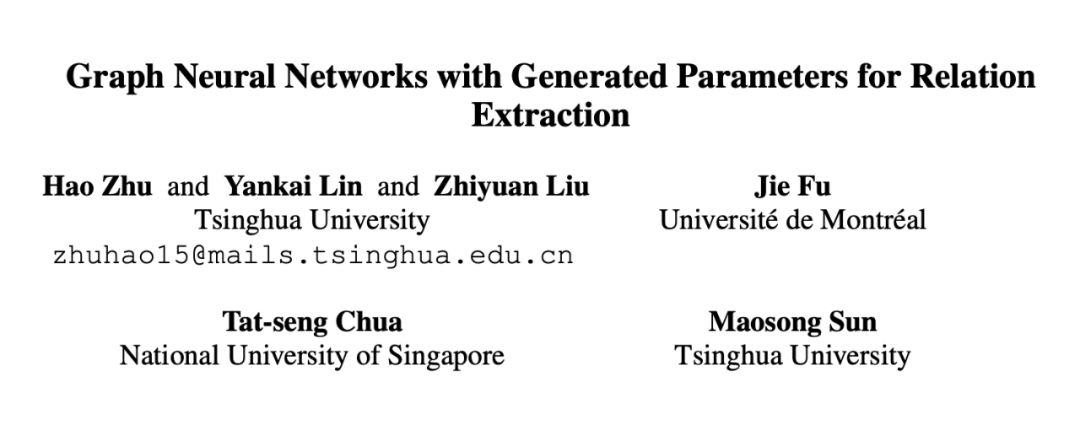

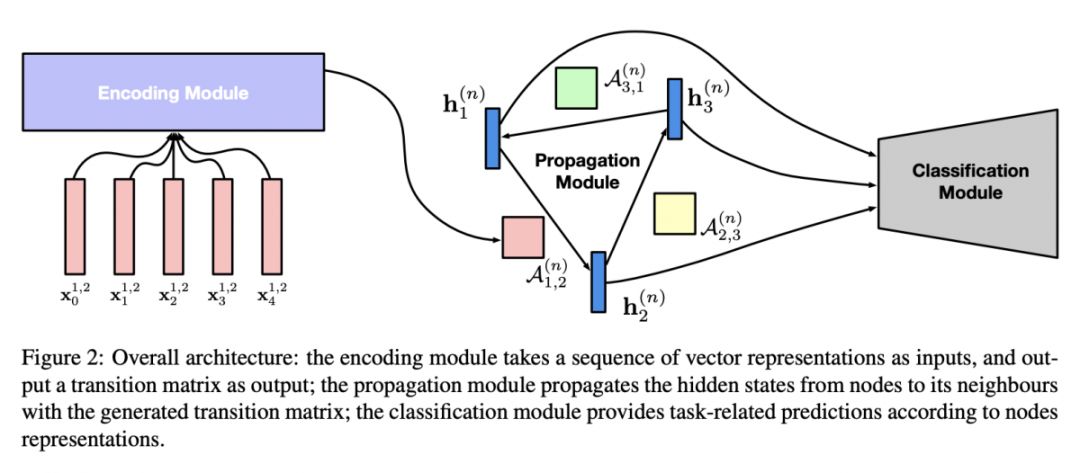

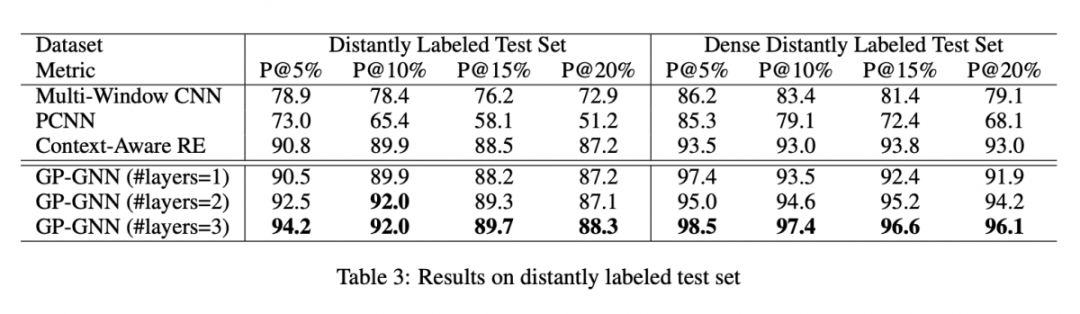

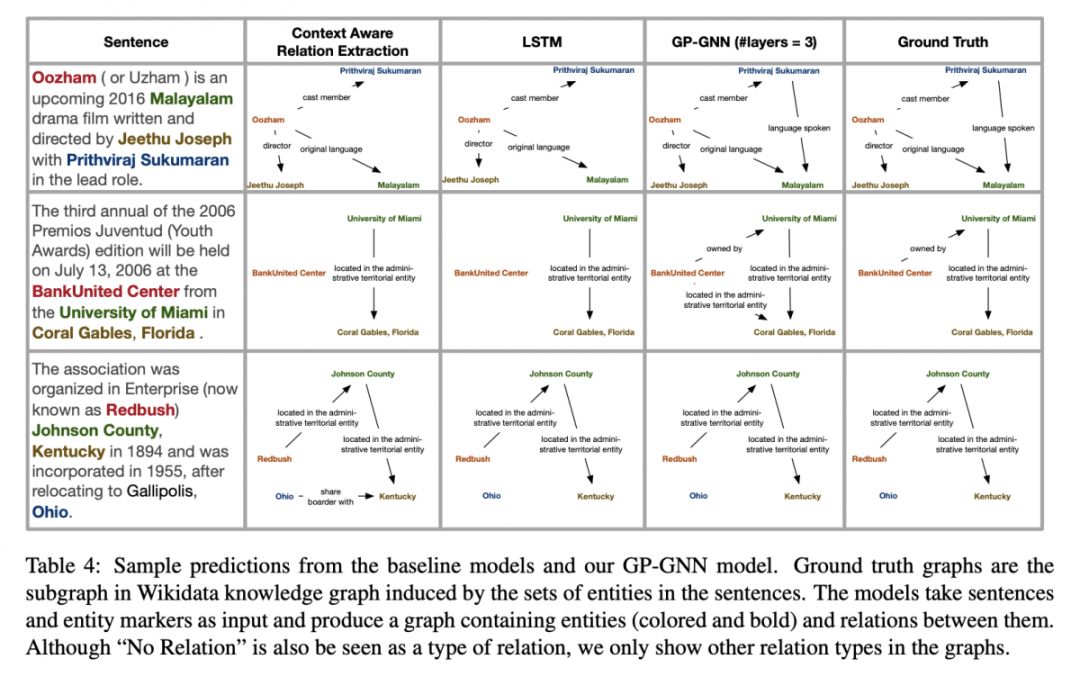

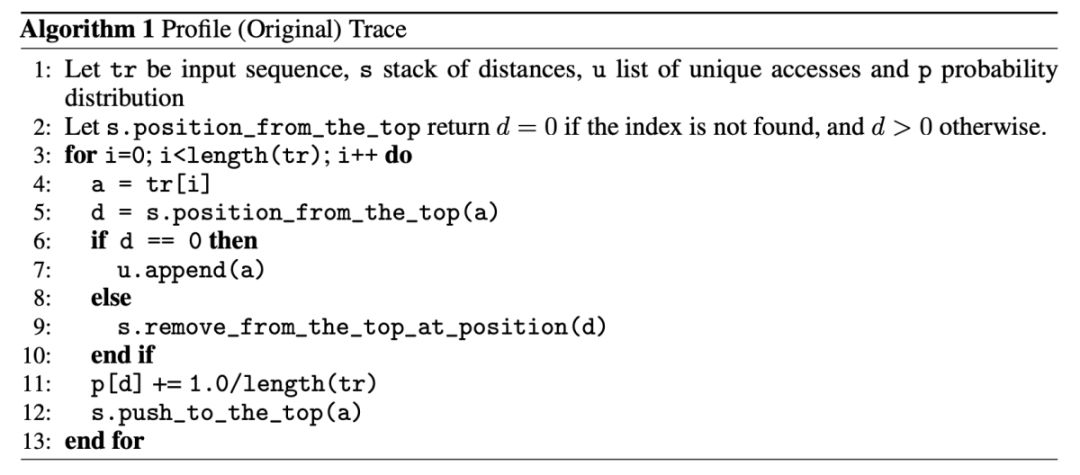

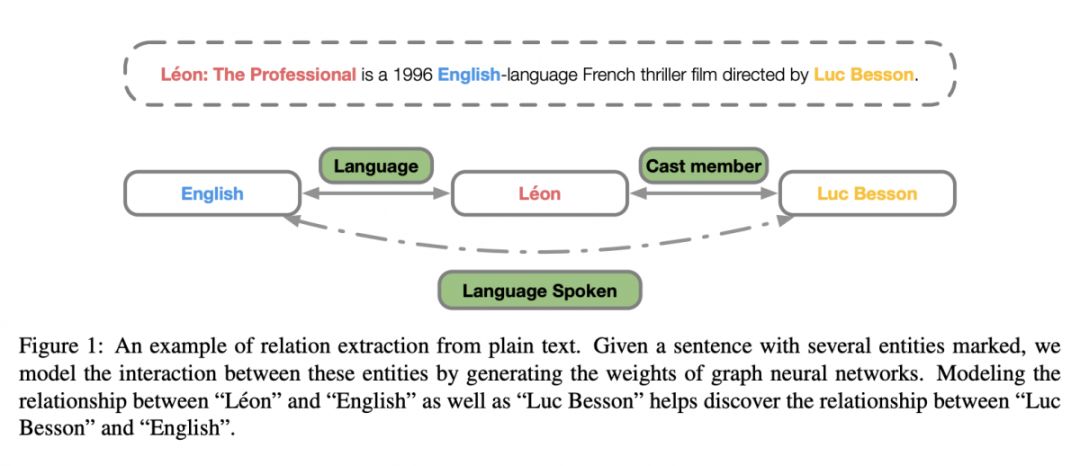

#Relation Extraction

本文是清华大学刘知远老师组发表于 ACL 2019 的工作,论文描述了当今少有的抽取关系间关系的模型,有助于关系预测、关系分类等任务的发展。具体来说,作者提出根据自然语言句子生成图神经网络(GP-GNNs)的参数,使得 GNN 能够处理非结构化文本输入的关系推理。

▲ 论文模型:点击查看大图

@xlf 推荐

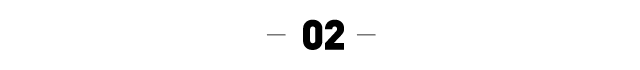

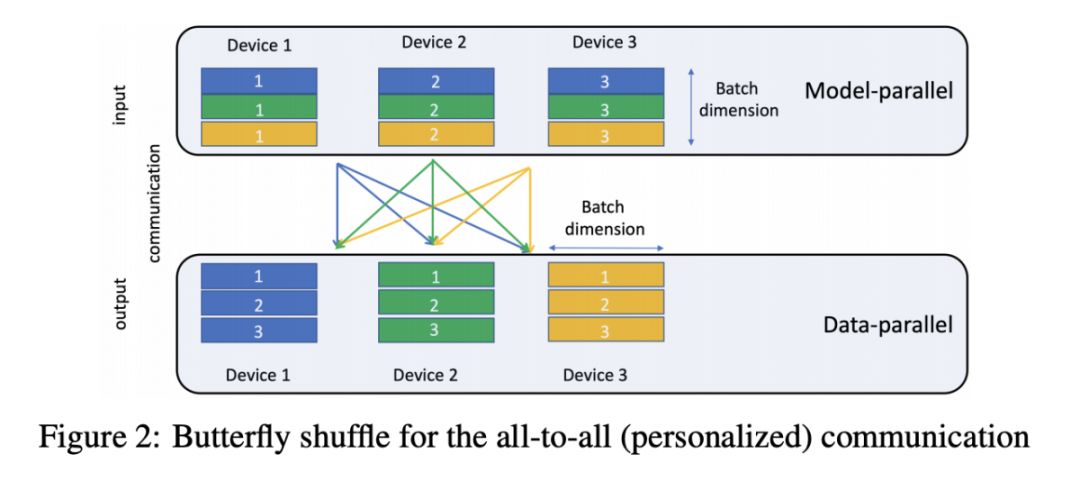

#Recommendation Systems

本文来自 Facebook,论文提出了一个深度学习推荐模型 DLRM,该模型基于 PyTorch 和 Caffe2 实现。DLRM 结合了协同过滤和基于预测分析方法的原理,相较于其他模型有所提升,从而使其能够有效地处理生产规模的数据,并得到当前最佳结果。

▲ 论文模型:点击查看大图

@figo 推荐

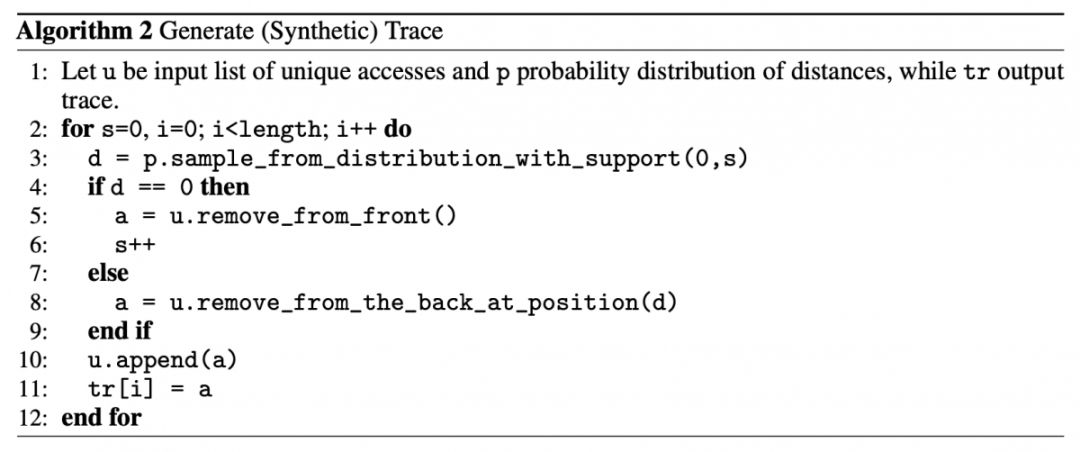

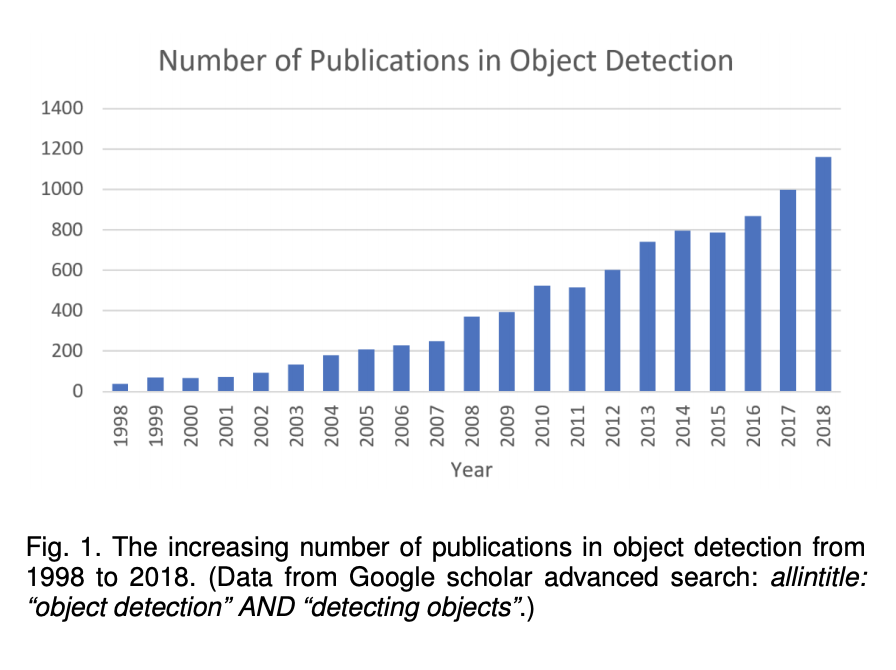

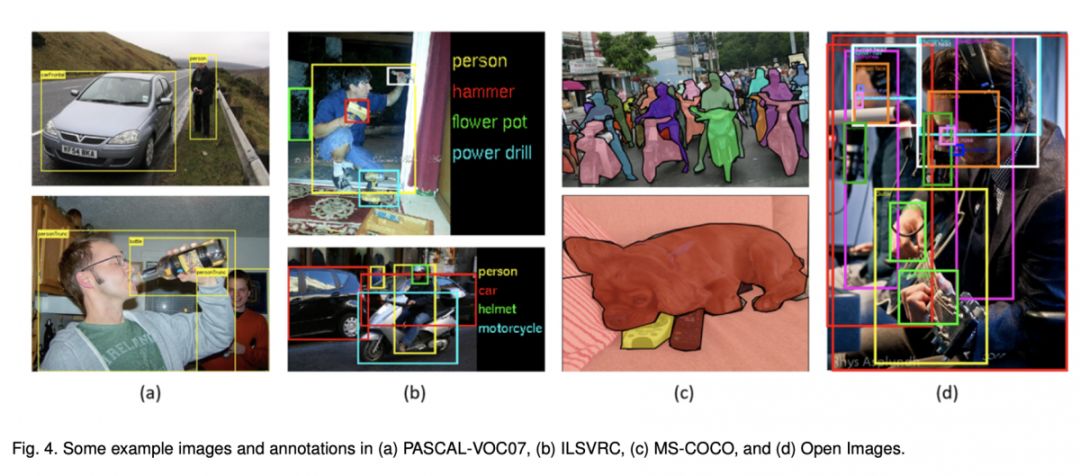

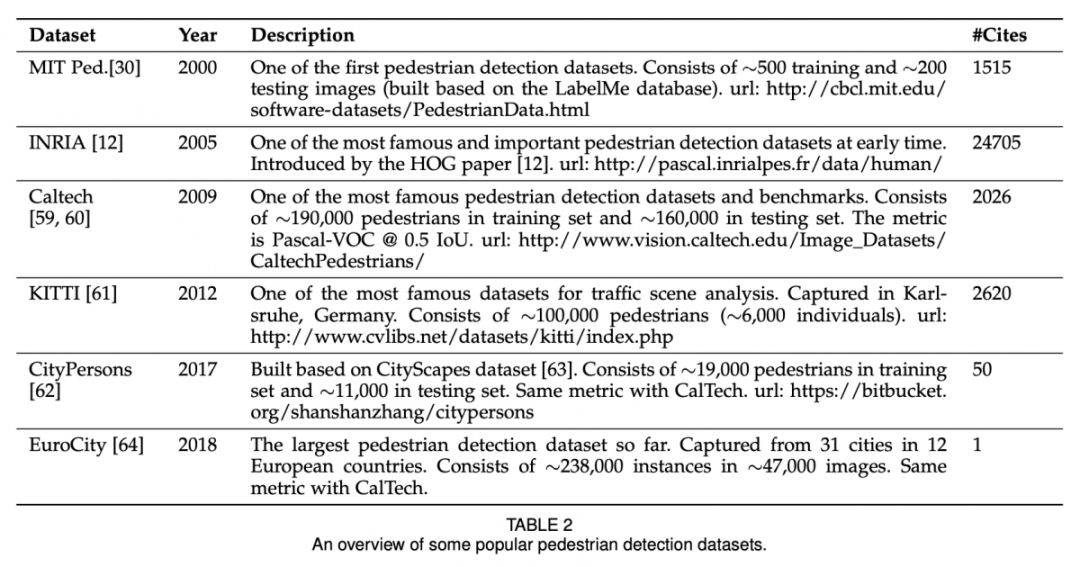

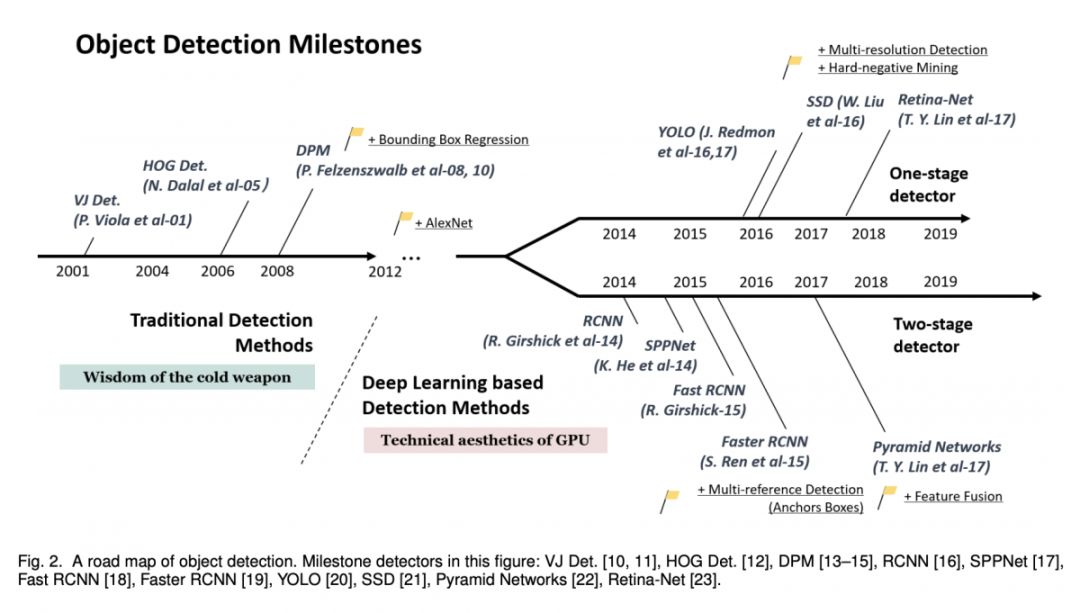

#Object Detection

本文是比较全面的一篇目标检测综述,几乎涵盖了 20 年来目标检测的各种里程碑,从传统方法到深度学习,值得一看。

▲ 论文模型:点击查看大图

@erutan 推荐

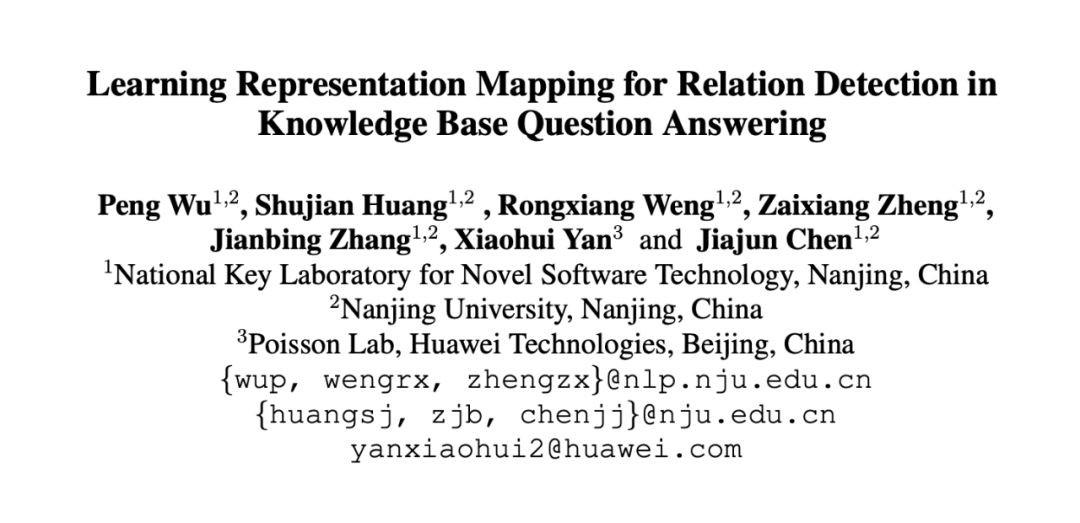

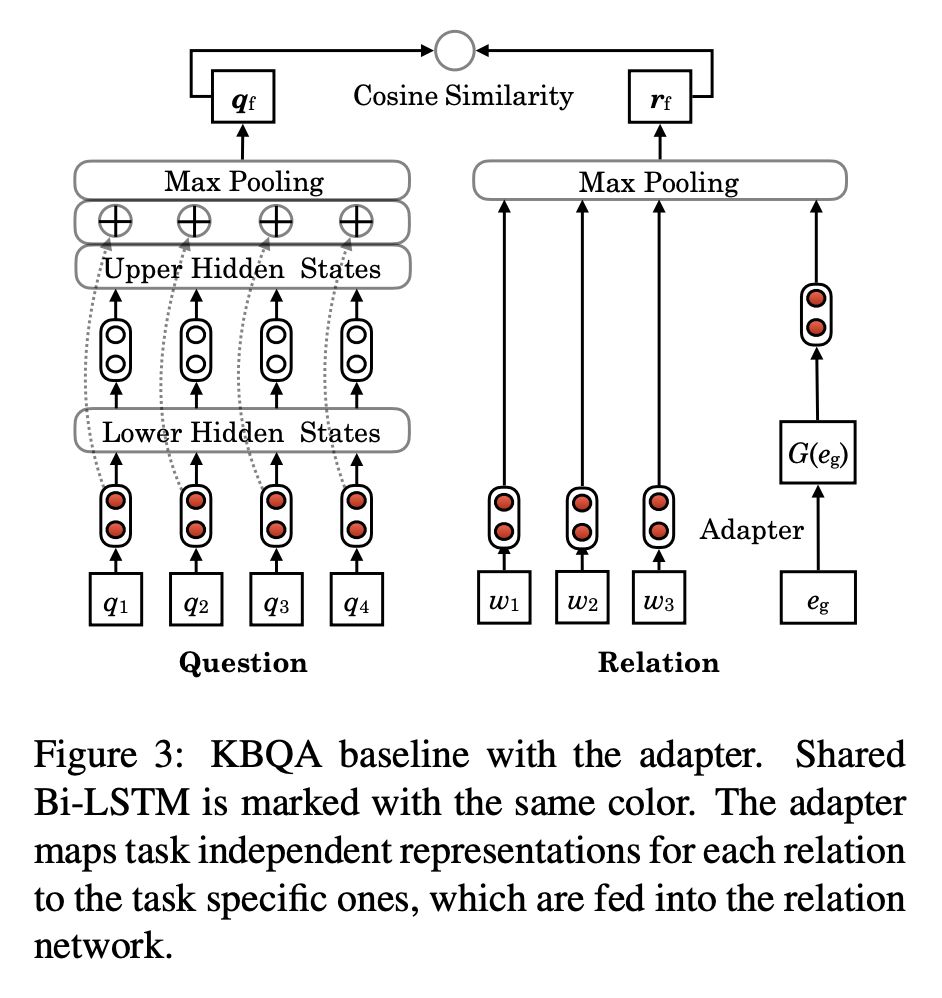

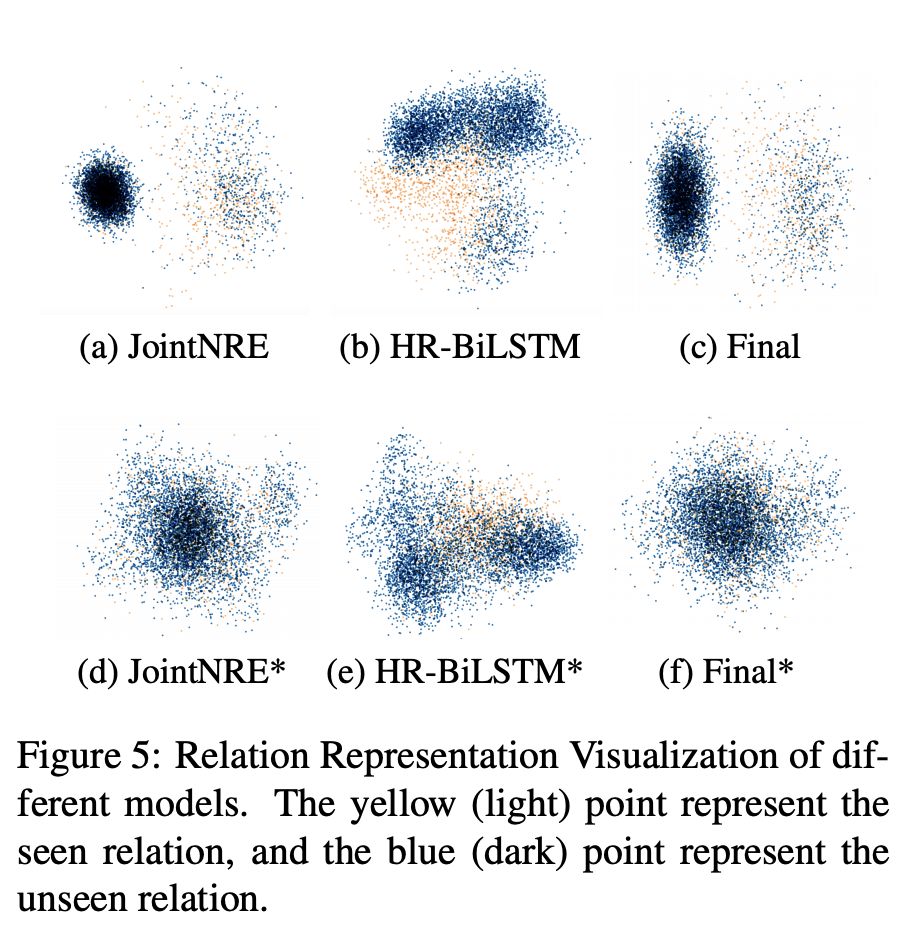

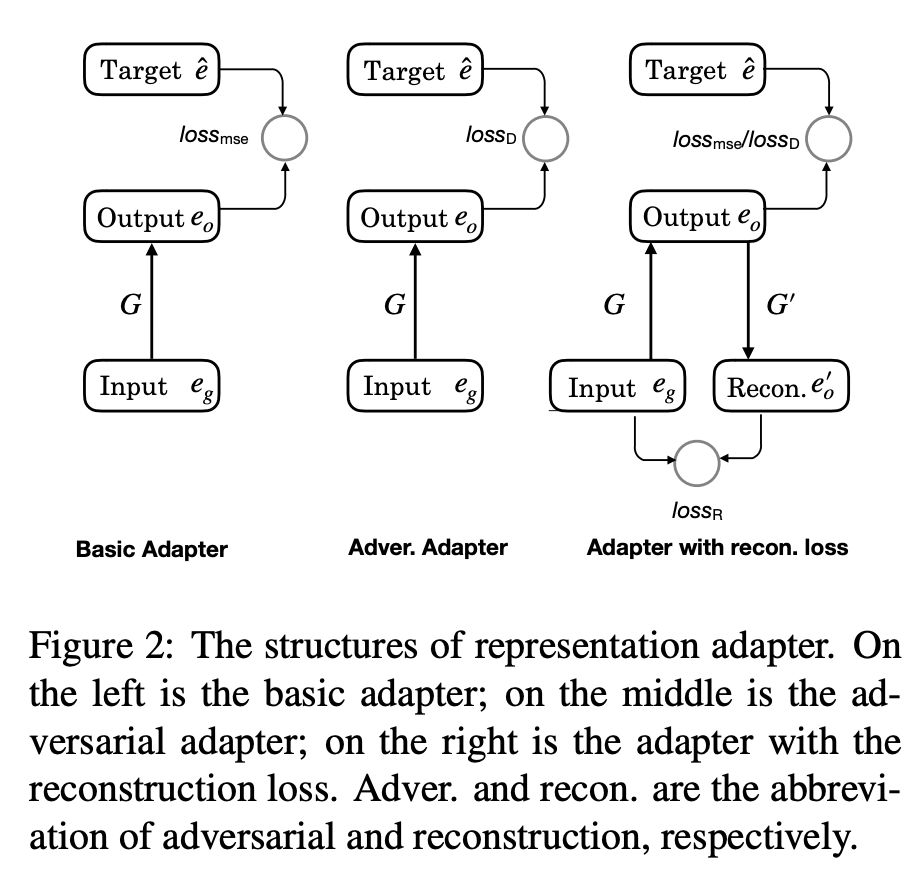

#Question Answering

本文是南京大学和华为发表于 ACL 2019 的工作,论文关注的是单关系 KBQA 中关系抽取任务,认为没怎么见过的关系做不对是因为这类关系缺乏一个很好的表示。所以本文用了一个 adapter ,去基于预先训练的关系表示,学习没见过的关系应该如何表示。引入对抗目标与重构目标,用重构 simpleQ 做的实验。结论表示在 unseen 部分有显著提升,其它部分也是 comparable 的。

▲ 论文模型:点击查看大图

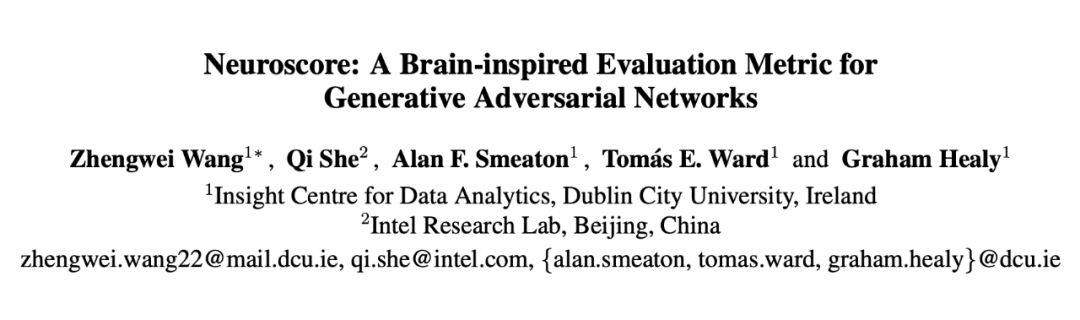

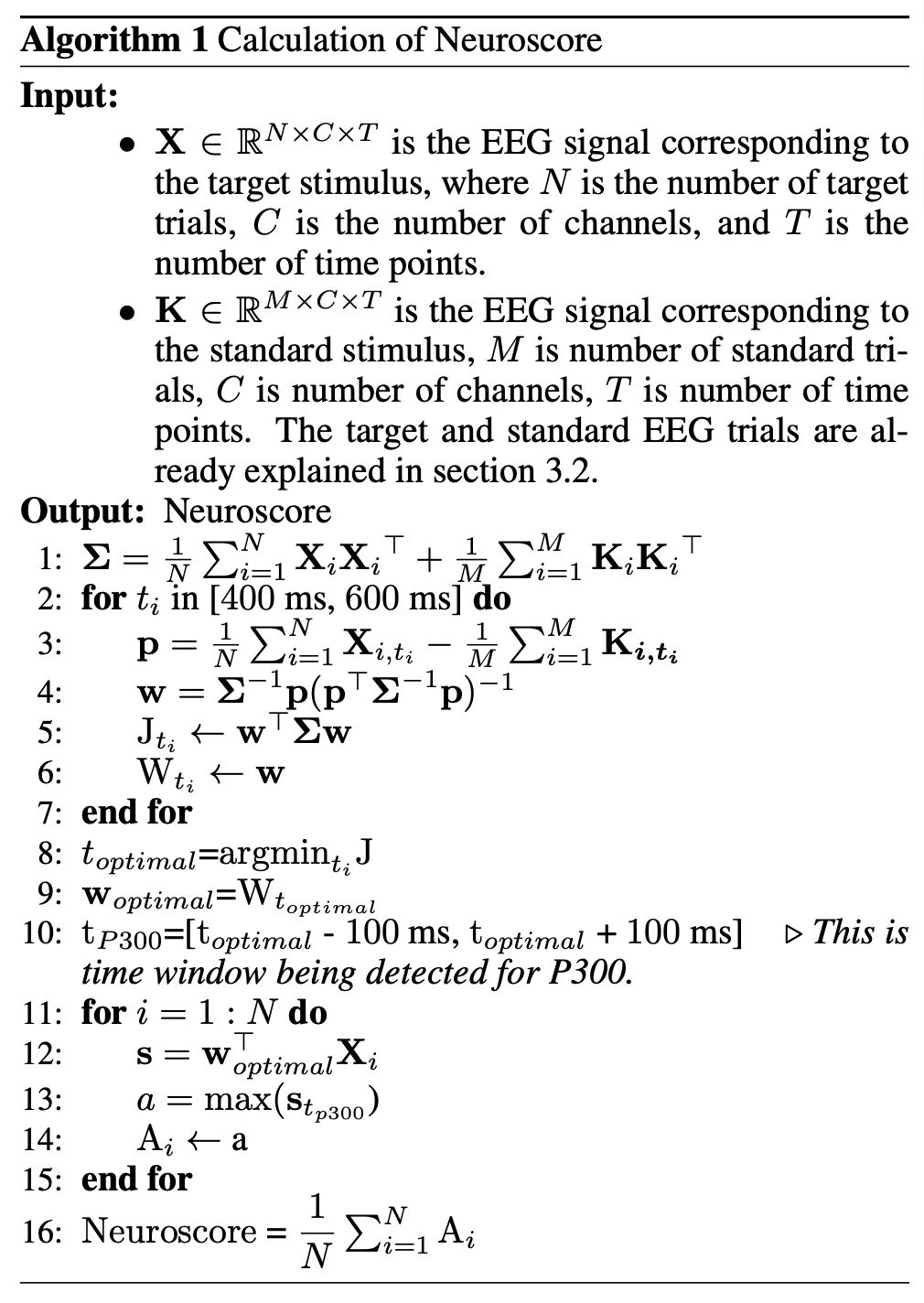

@villawang 推荐

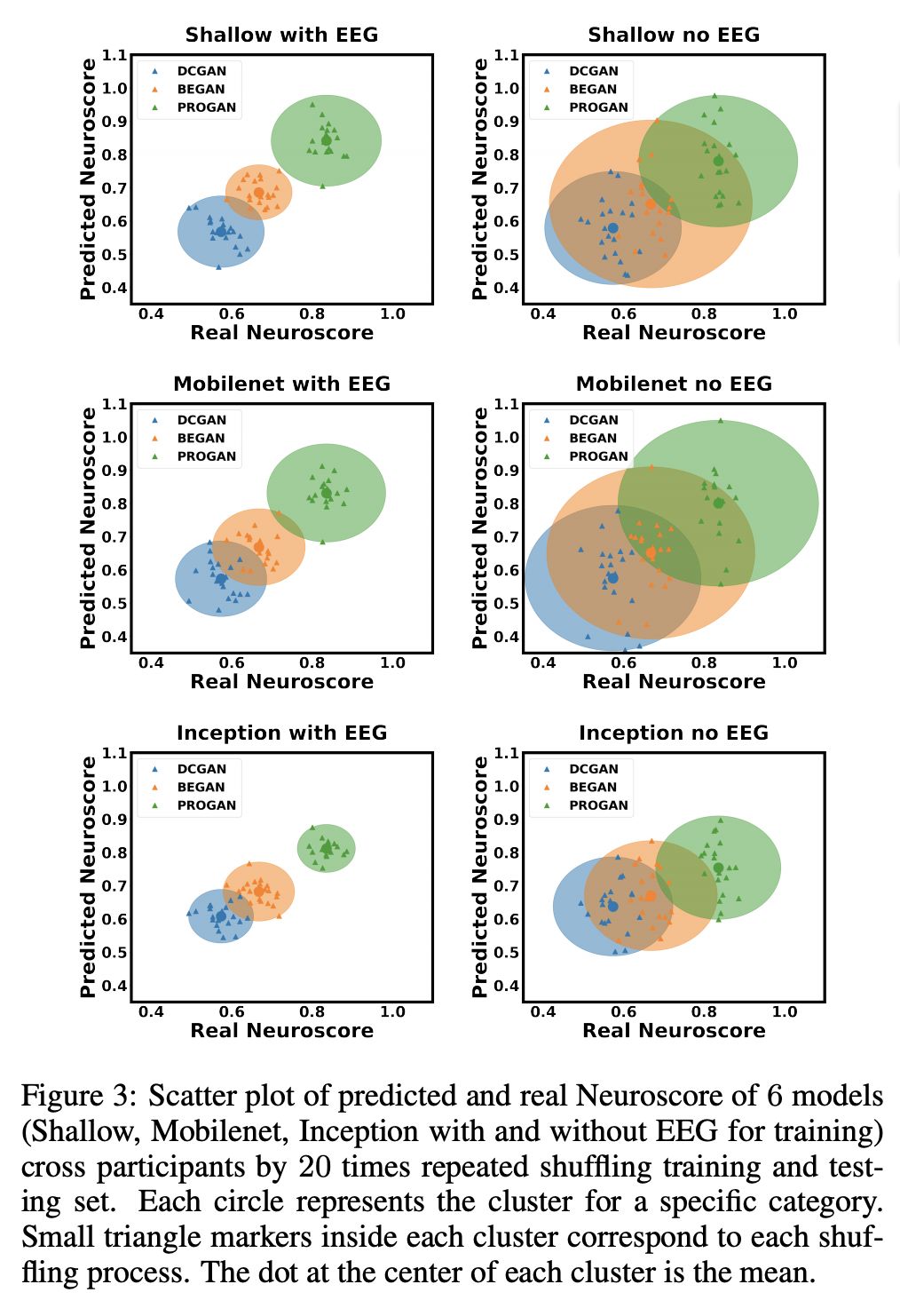

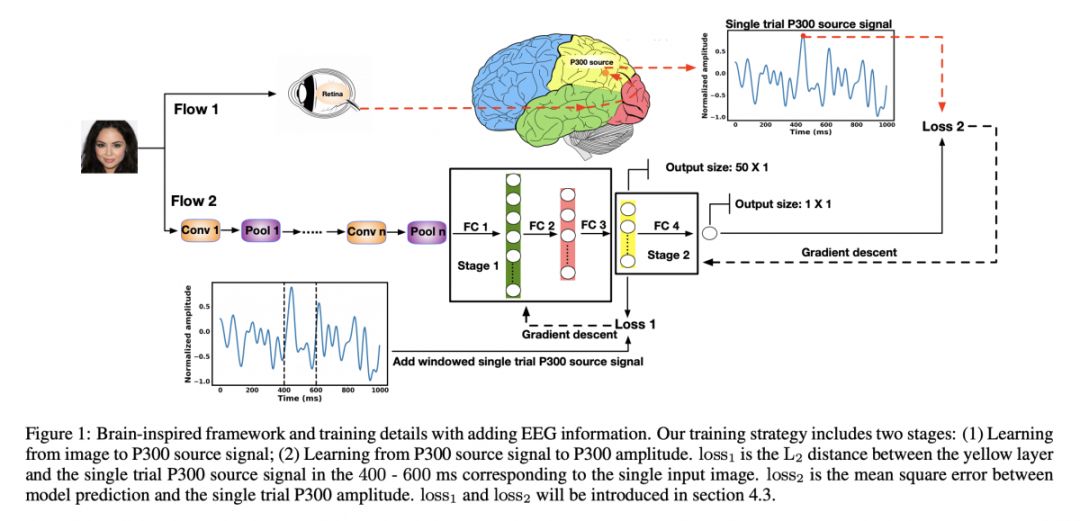

#Generative Adversarial Networks

本文来自柏林城市大学和英特尔。论文引入了一种以神经信号作为监督信息来训练 CNN 的新思想。此外,论文还引入与人类感知相一致的 GAN 的评价指标,并且该指标只需要更小的样本量。

▲ 论文模型:点击查看大图

@QAQ 推荐

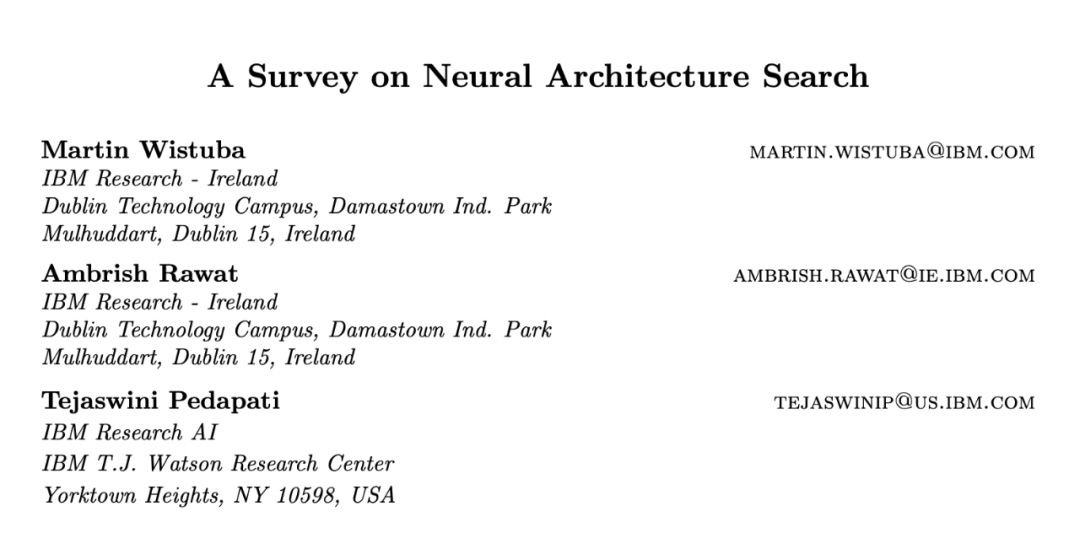

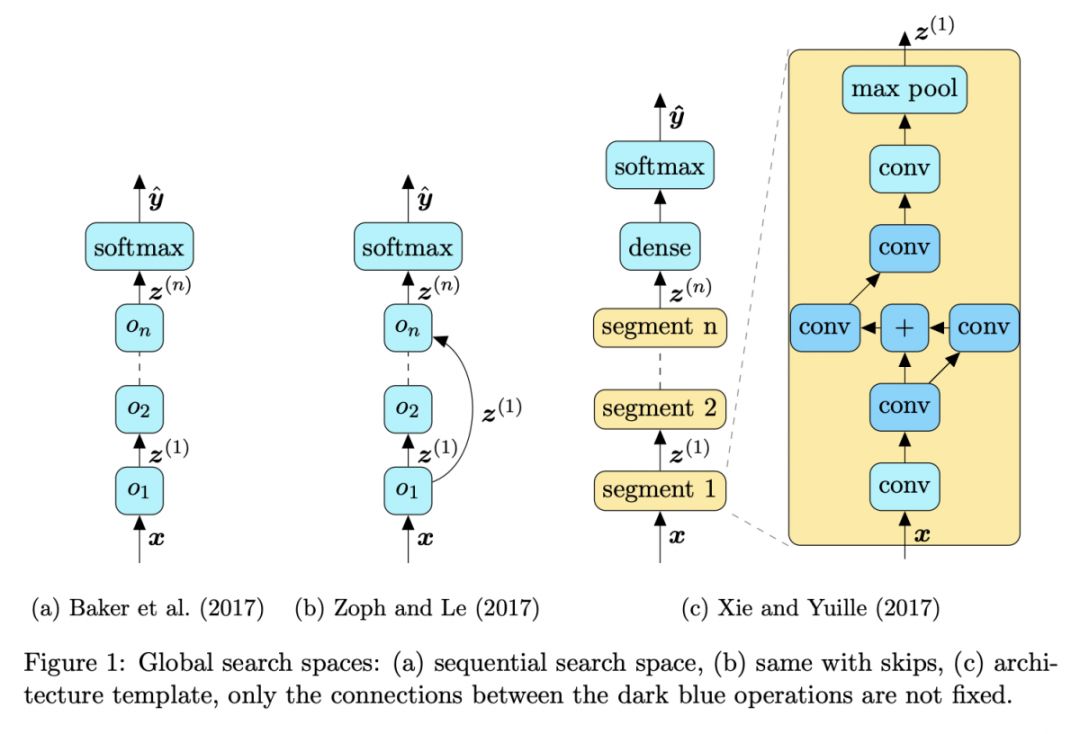

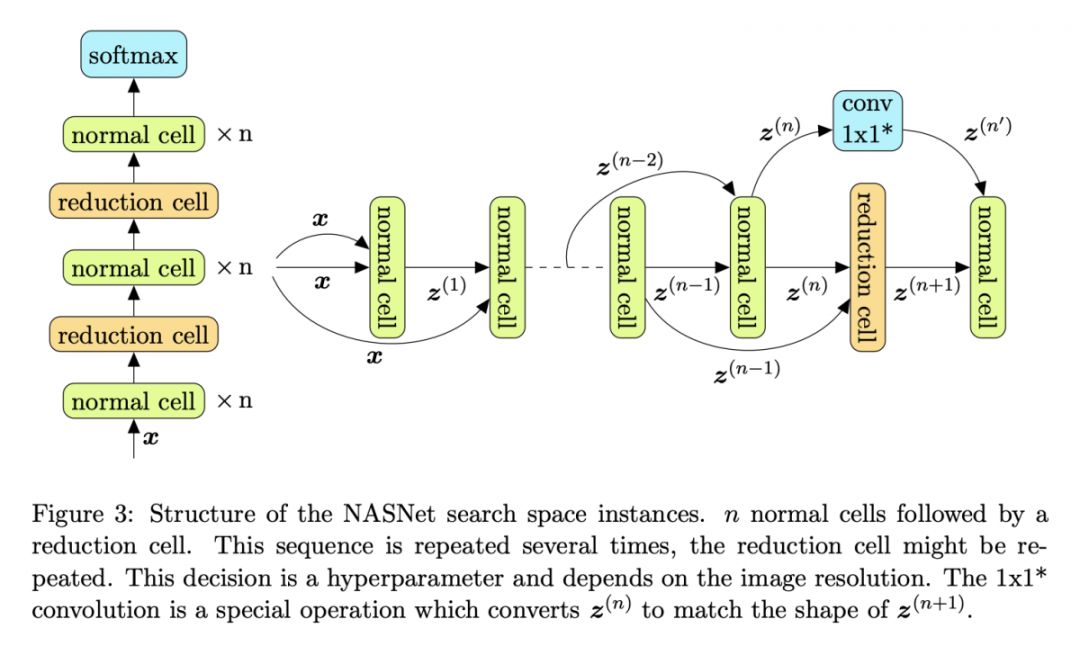

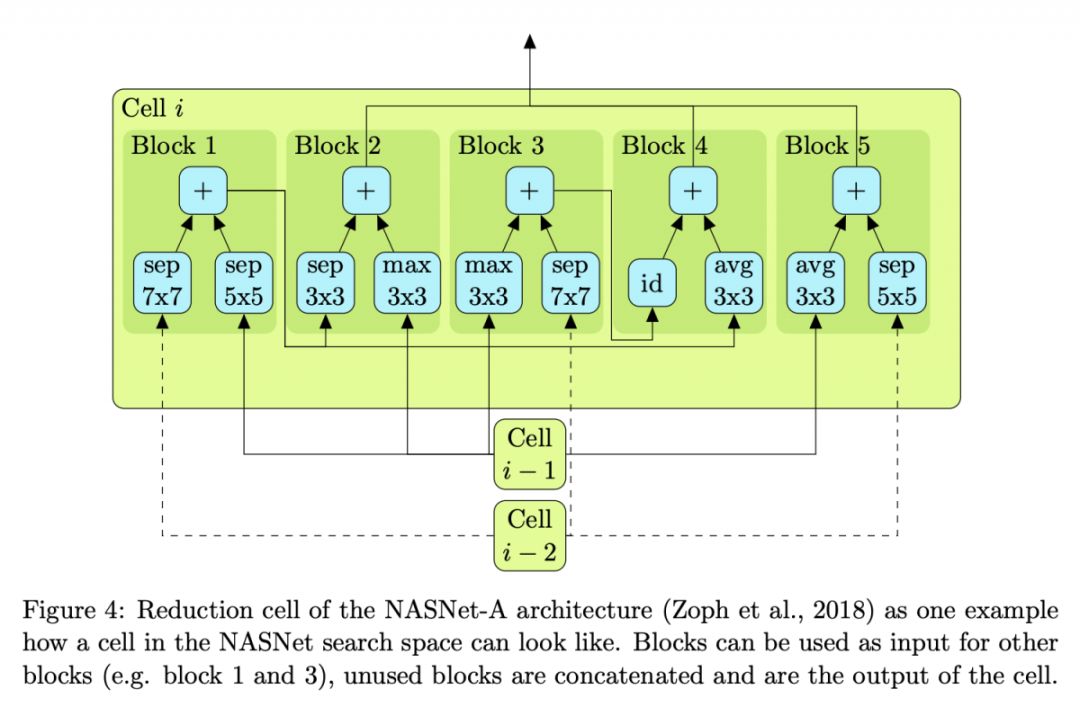

#Neural Architecture Search

本文是来自 IBM Research 的 NAS 综述。作者从强化学习与遗传算法、代理与 one-shot 的角度对 NAS 的进展进行了总结,并对约束和多目标架构搜索、自动数据增强、优化器和激活函数搜索等进行了讨论。

▲ 论文模型:点击查看大图

@xy118 推荐

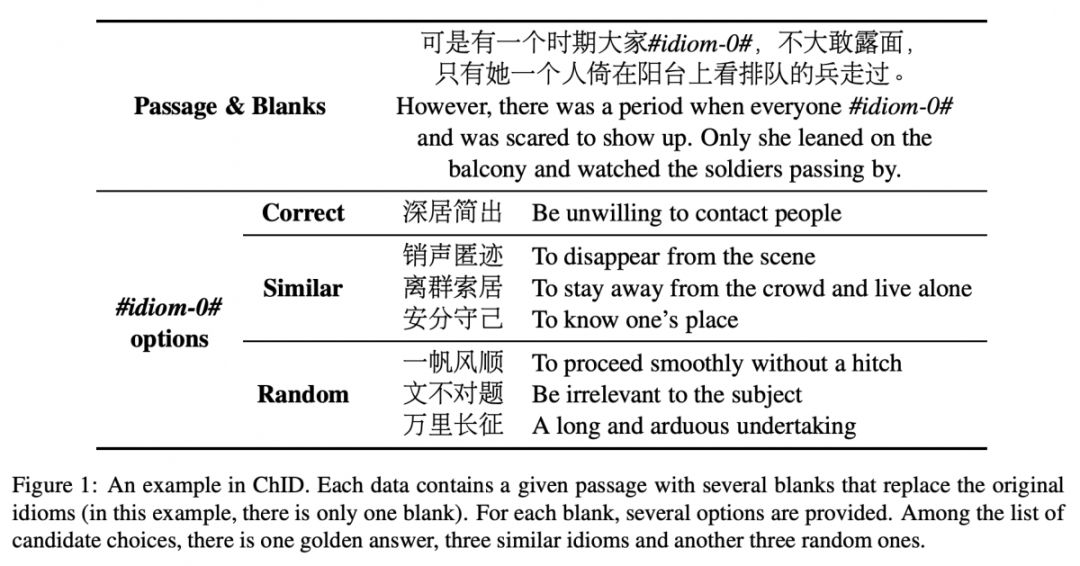

#Cloze Test

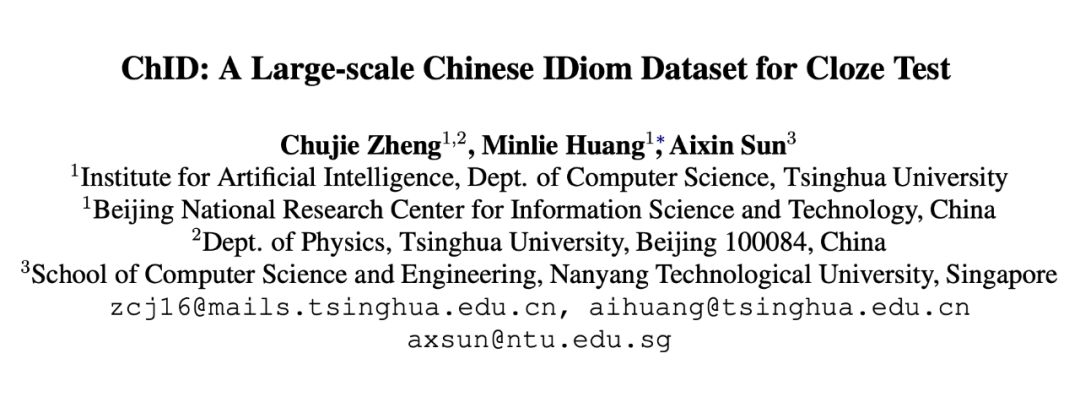

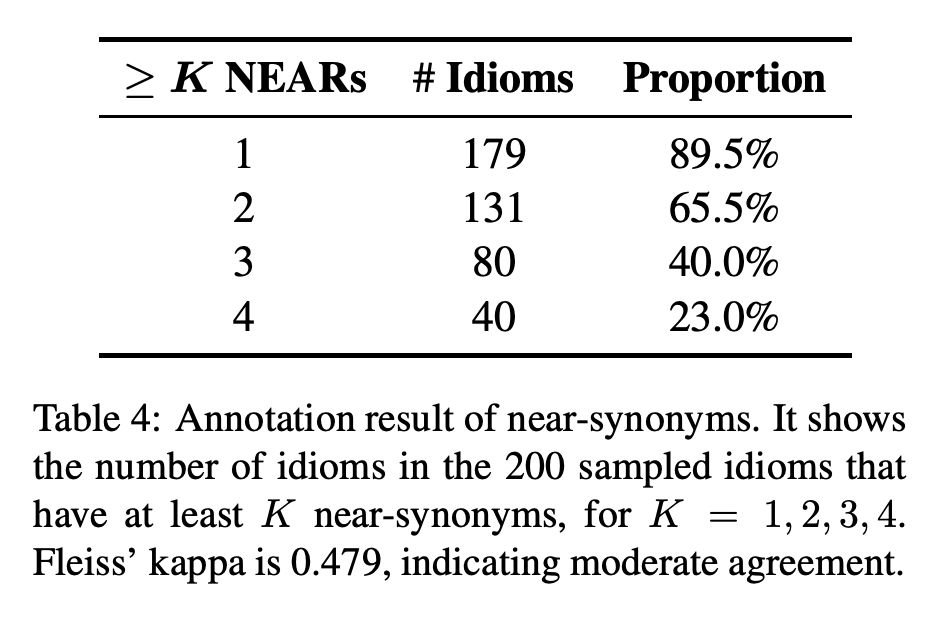

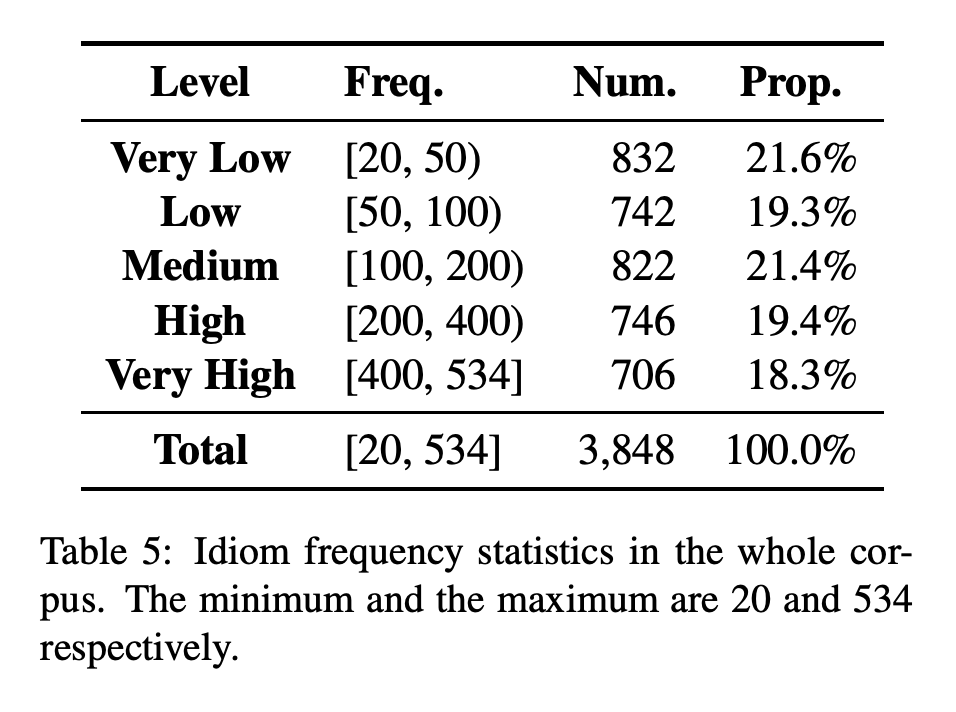

本文来自清华大学和南洋理工。完形填空测试,由于其简单的形式,常被用来考察机器阅读理解能力,中文方面已经有了人民日报(PD)、儿童寓言故事(CFT)、CMRC2017 等数据集。

而这篇论文中,作者以完形填空的形式对中文里特有的语言现象——成语进行了测试和研究。成语在日常交流及各种文献中经常被使用,机器如何更好地对成语进行理解和表征这一问题的重要性不言而喻。与其他词语相比,成语的语义具有以下两个特点:非合成性、隐喻。此外,近义词的存在也会对机器在特定语境下选出正确选项造成干扰。

▲ 论文模型:点击查看大图

@sheqi0399 推荐

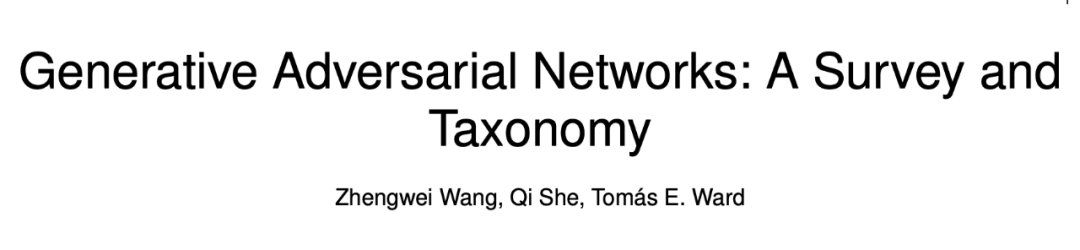

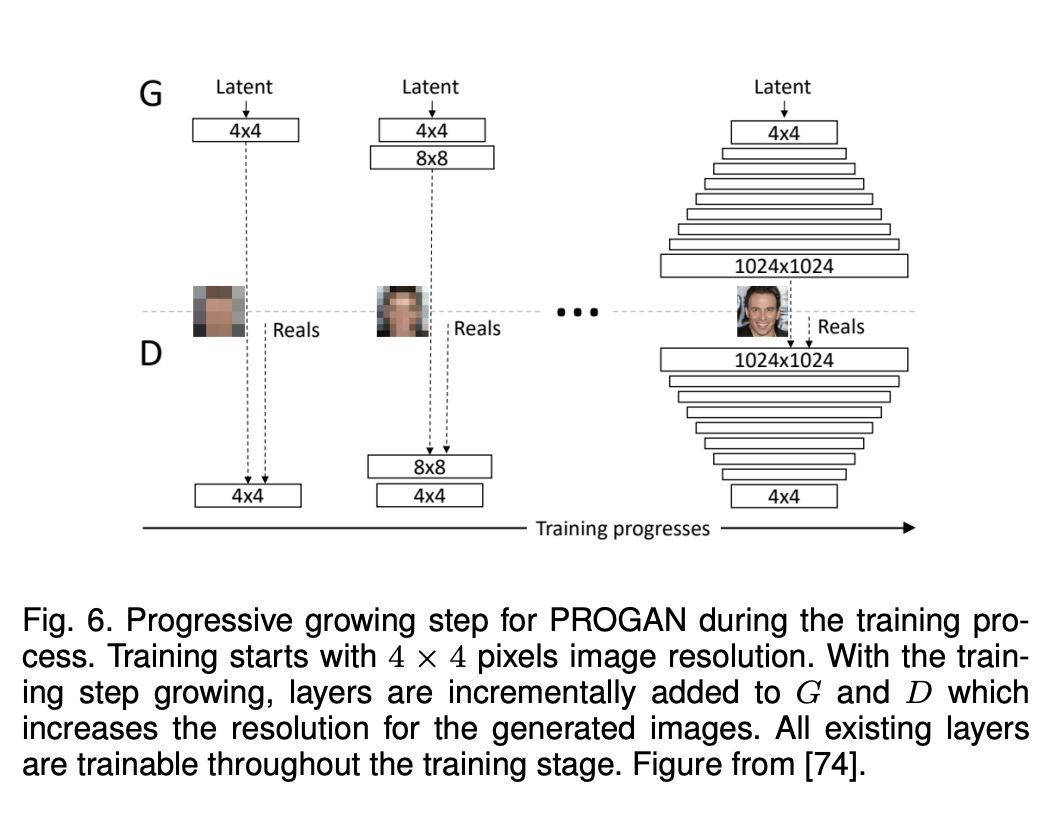

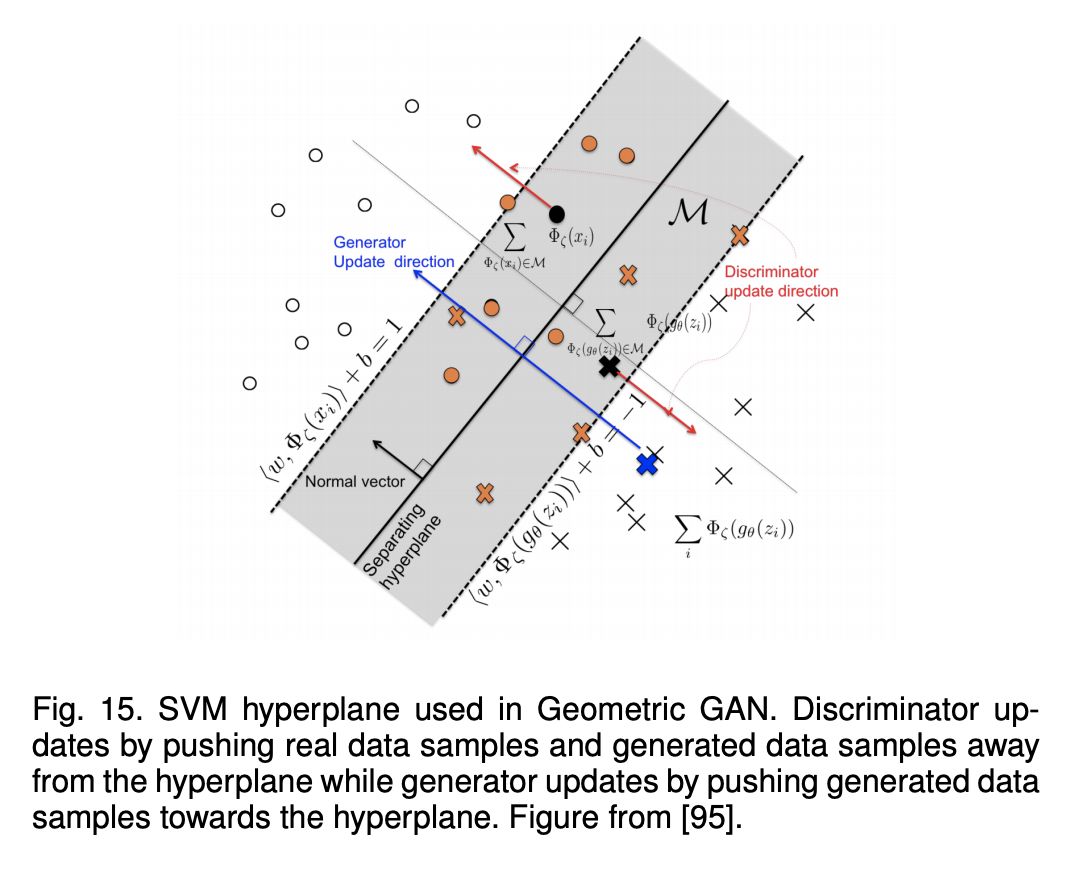

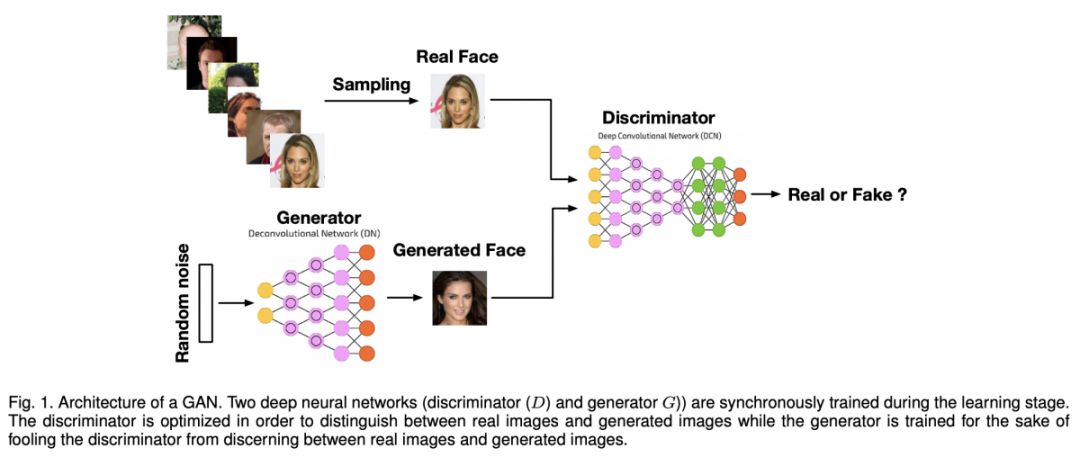

#Generative Adversarial Networks

本文是一篇来自柏林城市大学和英特尔的综述文章,作者对最近几年的 GAN 研究进行了梳理,以 loss 和网络结构进行分类,并对一些经典的 GAN 结构和变种进行了对比。

▲ 论文模型:点击查看大图

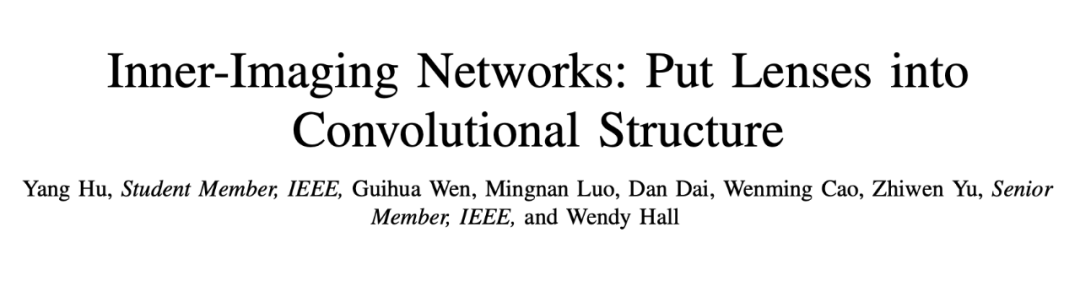

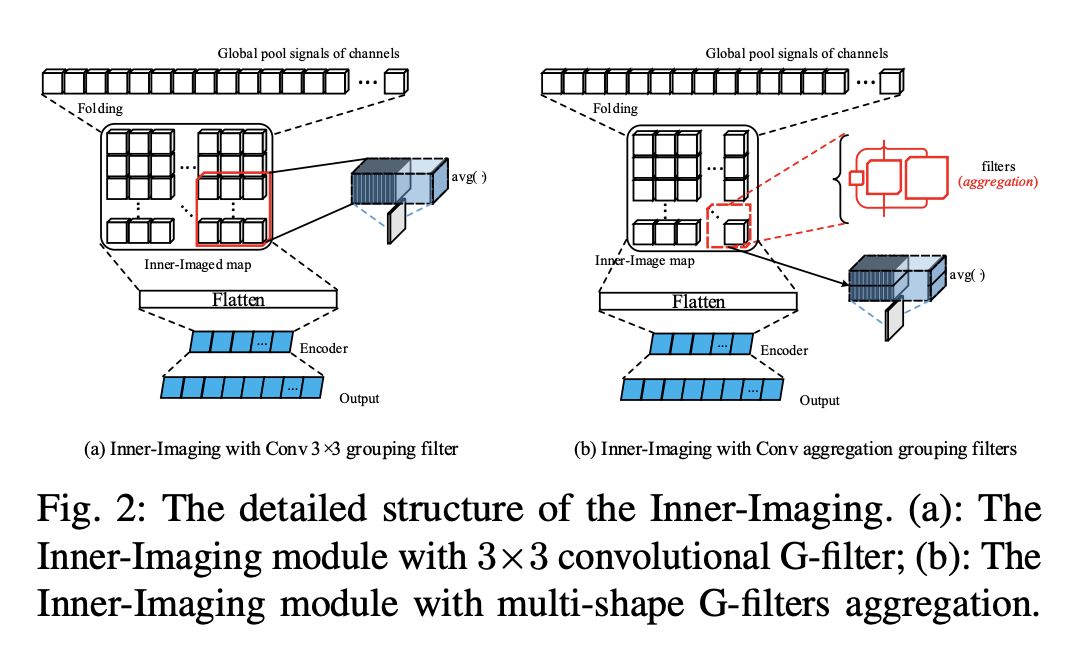

@superhy 推荐

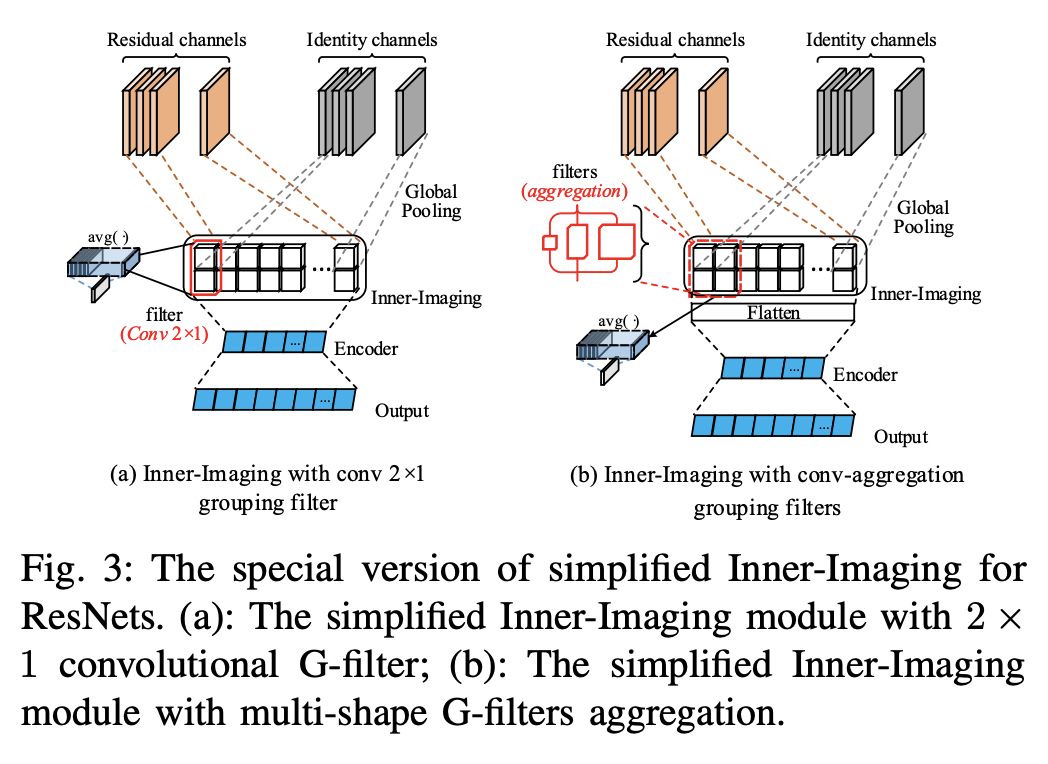

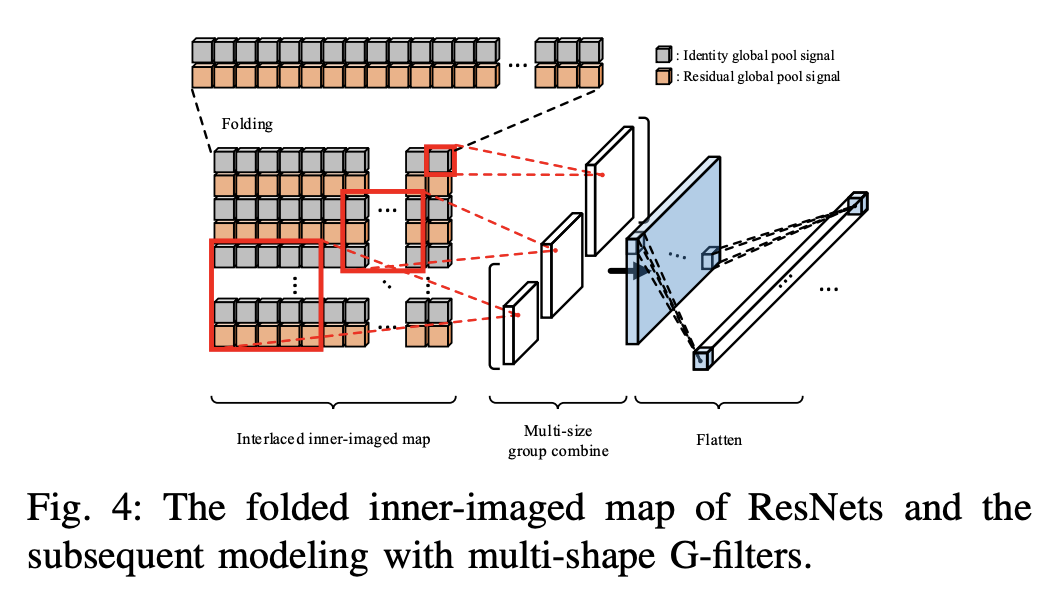

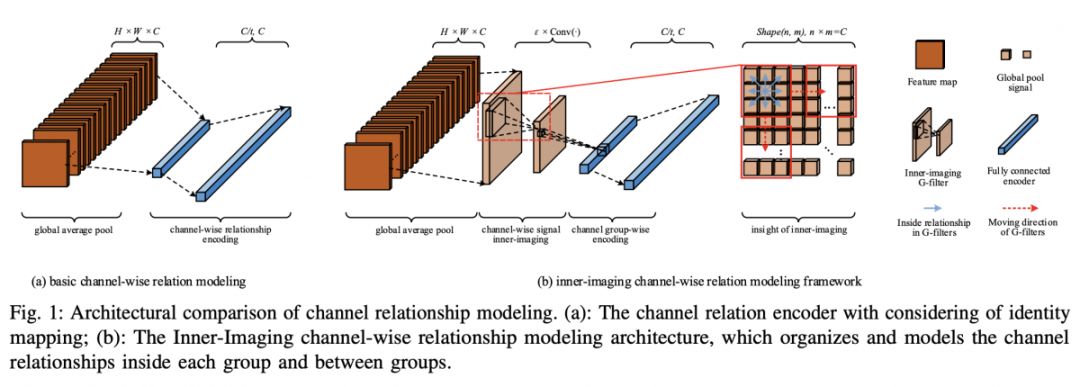

#Convolutional Neural Network

本文提出了一种新的“内成像”机制来模拟卷积通道的分组关系。该方法可以提高卷积网络的效率,增强信道间的协作。内成像机构的设计是非常独特的,它就像把透镜放入卷积网络。卷积滤波器是一种建模局部区域特征关系的利器,“内成像”这种设计让我们能够利用卷积滤波器来建模卷积通道间的成组关系,比 SE 模型更明显地提升卷积网络的建模效率。所提出的内成像机制可以应用于各种 CNN 体系结构。它重量轻、可扩展、适应性强,具有良好的应用前景。模型设计轻便简洁,可以有效激发更小规模的卷积网络接近甚至超越更大规模网络结构的效果。

▲ 论文模型:点击查看大图

@erutan 推荐

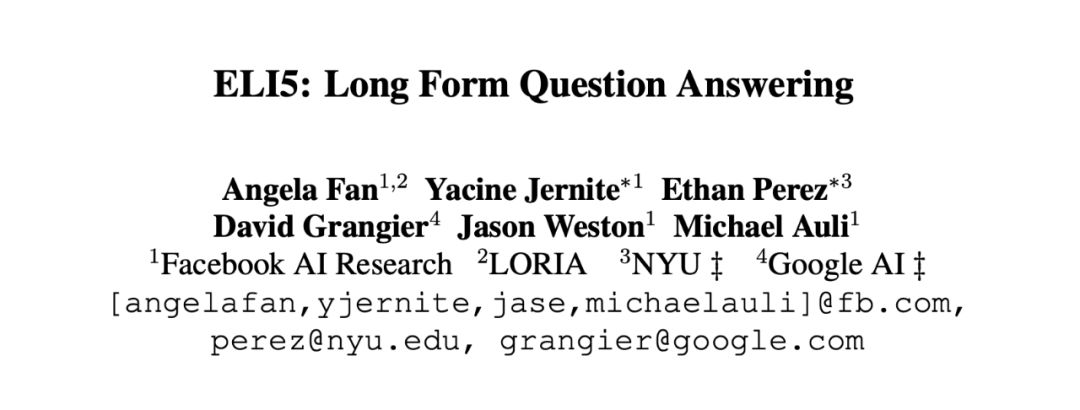

#Question Answering

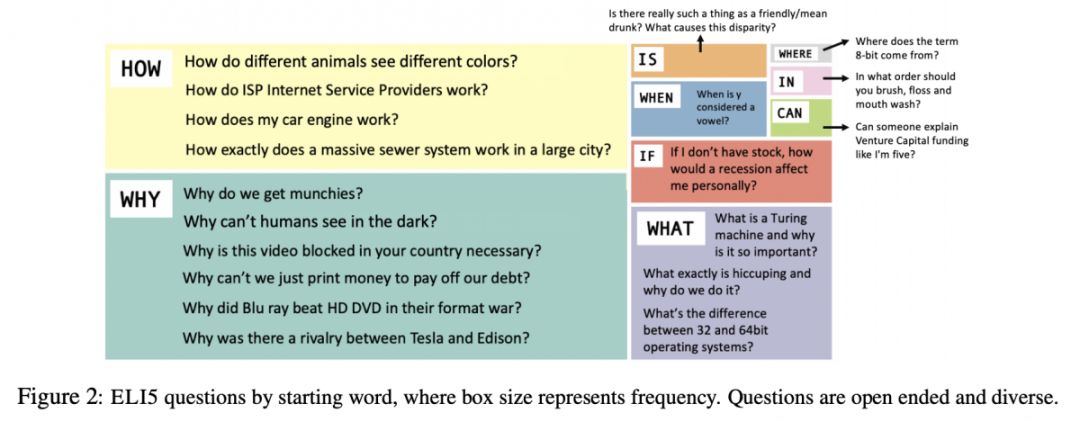

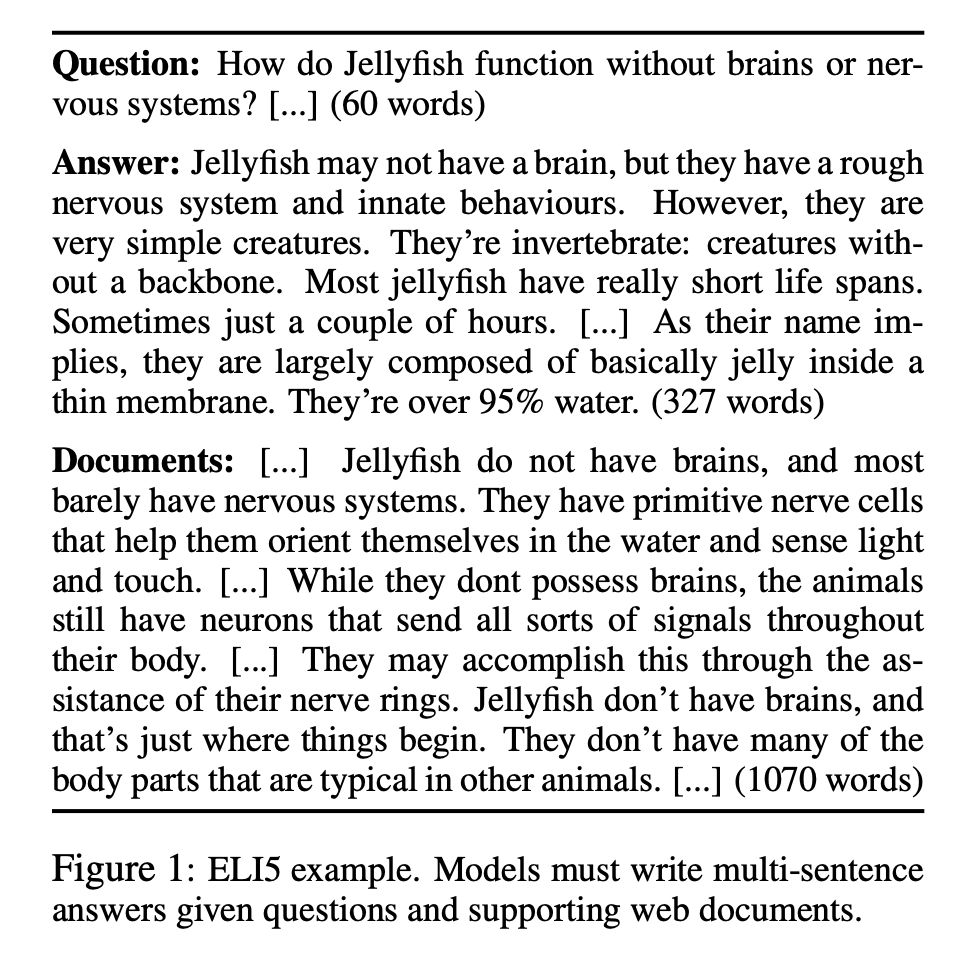

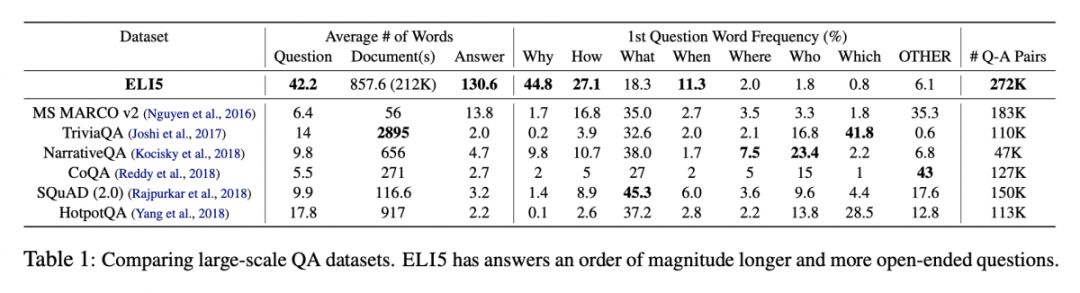

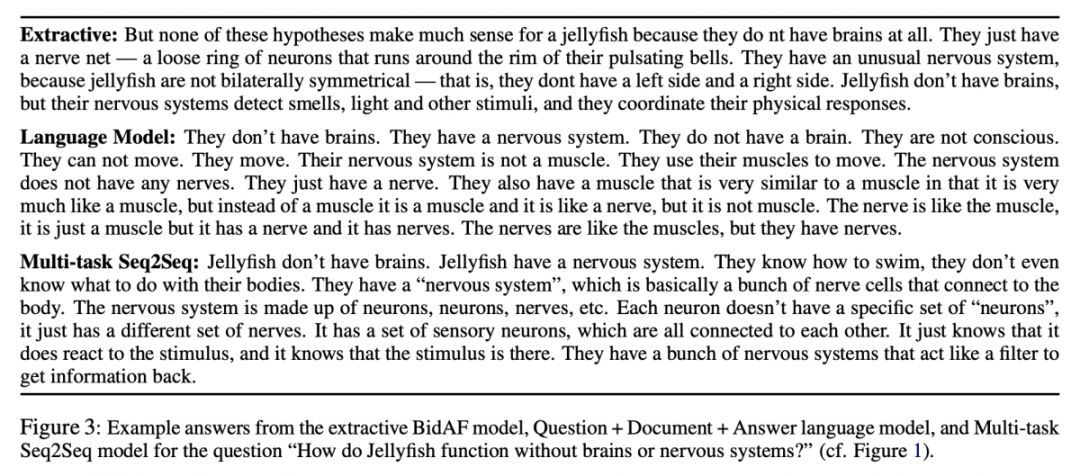

一堆 big name 的公司搞的一个 QA 数据集,100k 级别,回答是比较长的生成式的文字,从 Reddit ELI5 中获得,即回答使用语言是 5 岁小朋友可以看懂的那种。问题以 how、why 为主,what 开头的复合问题也有一些。评价指标以 ROUGE 等为主。

@jimy 推荐

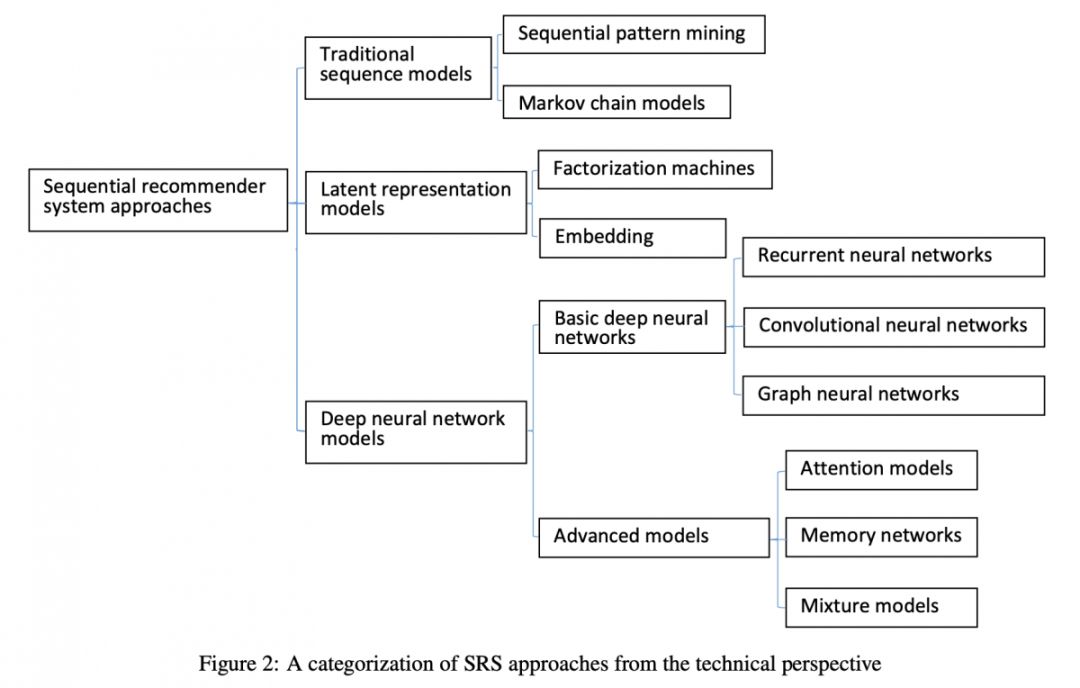

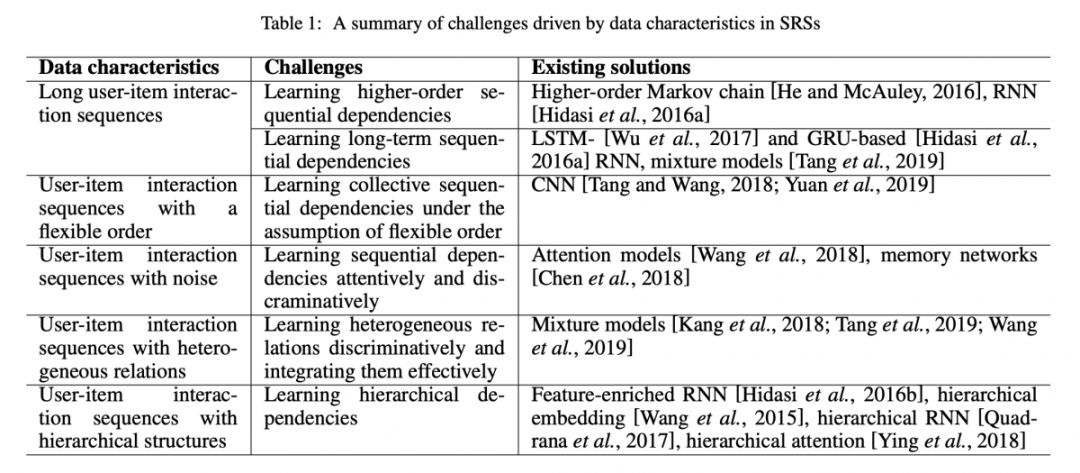

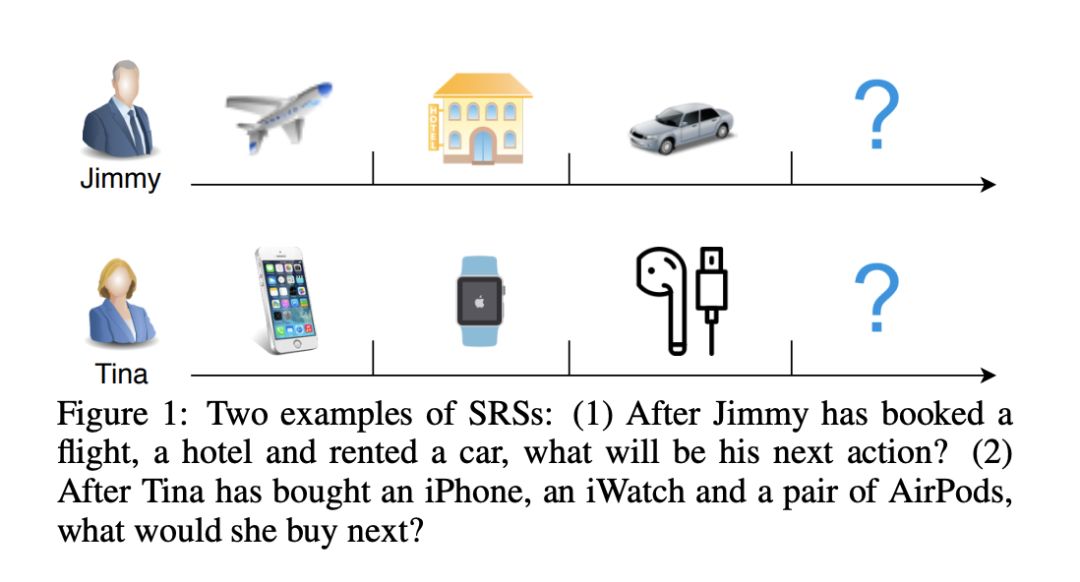

#Recommender Systems

本文是麦考瑞大学和悉尼科技大学发表于 IJCAI 2019 的综述文章,论文对当前深受大家关注的序列推荐系统做了一个系统的总结和回顾。该文章系统阐述了为什么需要序列推荐系统,它与传统的推荐系统如协同过滤有什么差别,以及什么是序列推荐系统。

作者从数据特征的角度出发,系统阐述了序列推荐系统中面临的主要问题和挑战以及目前的相应解决方案,系统地总结了整个序列推荐系统的技术发展脉络。该文章深入浅出,浅显易懂,避免了高深的数学公式和复杂的逻辑推导与定义,很容易读懂,但同时包含了该领域最新的发展动态。特别适合于想进入这个领域的初学者阅读。

▲ 论文模型:点击查看大图

@Layumi 推荐

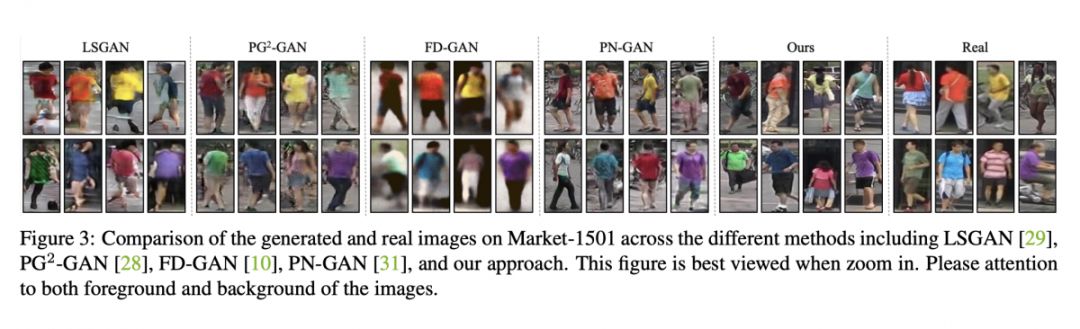

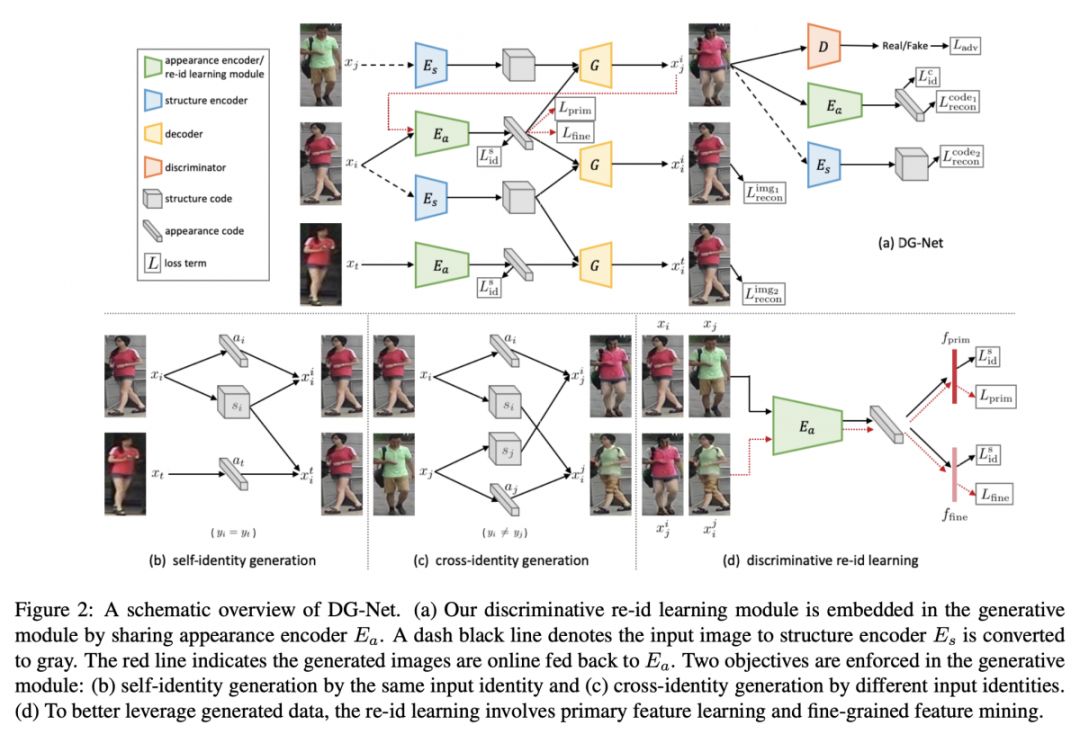

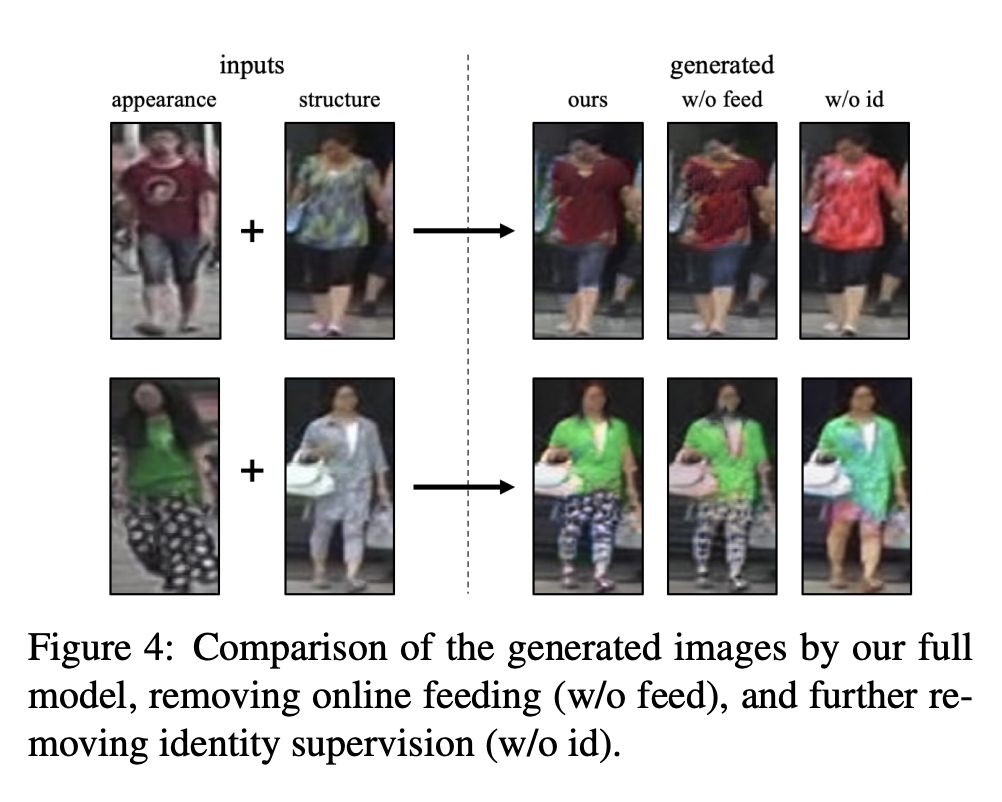

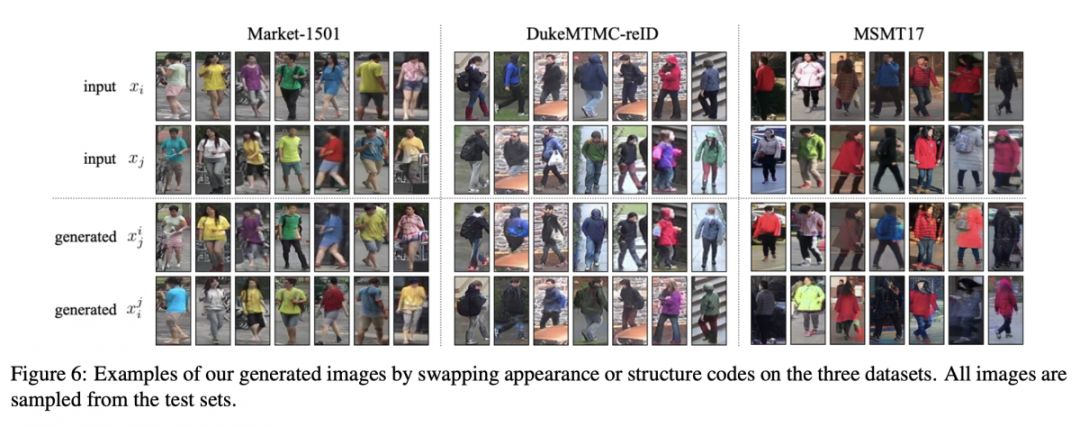

#Person Re-identification

本文是英伟达、悉尼科技大学和澳大利亚国立大学发表于 CVPR 2019 的工作。行人重识别的难点在于不同摄像头下人的类内变化(包括摄像头的视角/光照/人的姿态等)。本文没有使用任何部件匹配的损失,而是仅仅让模型去“看”更多的训练图像来提升行人重识别的效果。而这些训练图像都是由 GAN 生成的。

相比于 ICCV 2017 时第一篇使用 GAN 来生成行人图像的文章,本文不仅在生成图像质量上有了大的提升,同时也将行人重识别的模型与生成模型做了有机的结合。从行人重识别模型提取好的行人特征可以作为 GAN 的 input,而 GAN 生成图像可以用来finetune行人重识别模型。

▲ 论文模型:点击查看大图

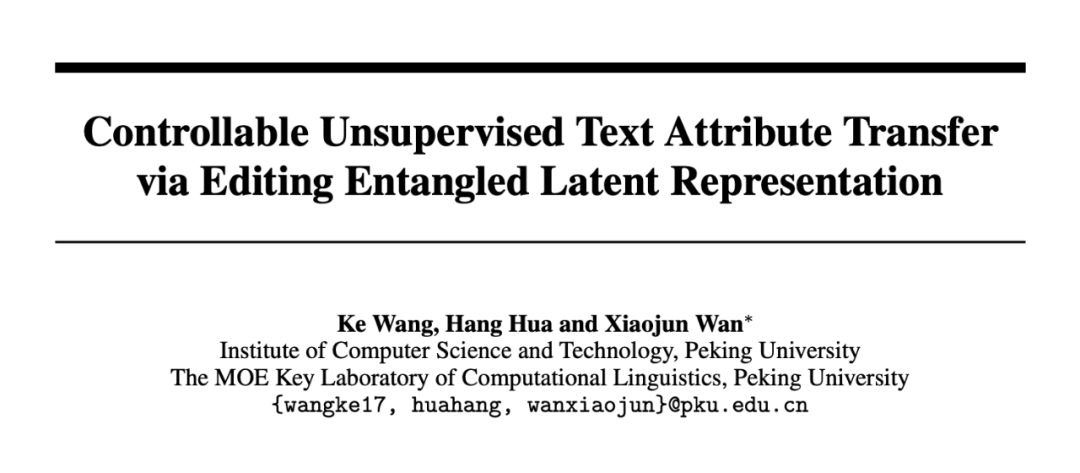

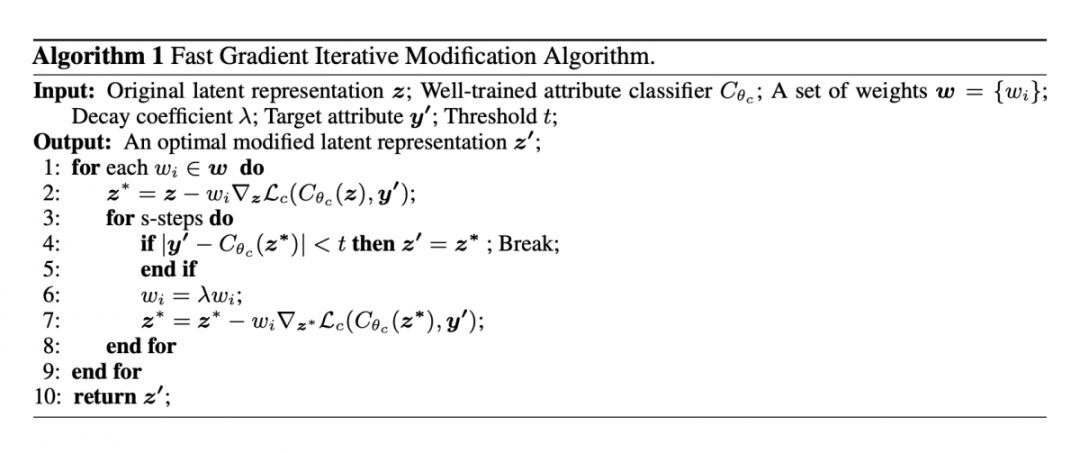

@tobiaslee 推荐

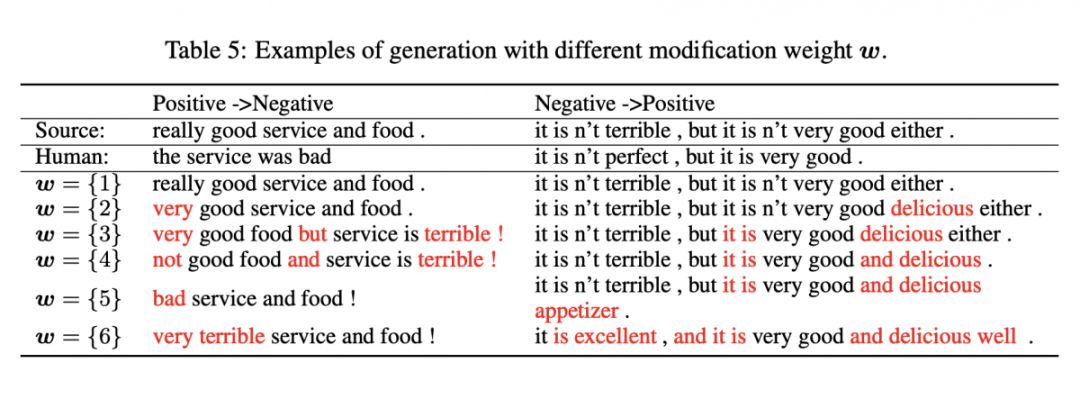

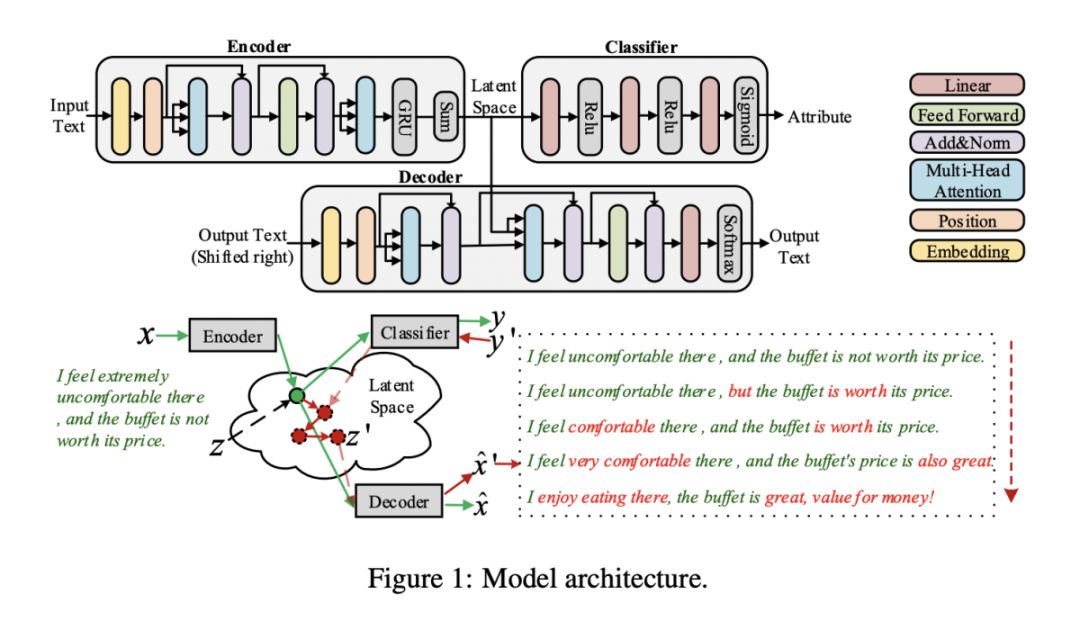

#Text Style Transfer

本文是北大万小军老师组的文章,关注的是文本的风格迁移任务。文章通过 autoencoder 编码输入,在得到的 latent representation 上做扰动,直到分类器对其进行分类的结果为目标风格,再利用改变后的 latent vector 解码得到目标风格的文本。这方法和之前 Goodfellow 的 adversarial example 非常类似,通过对 loss function 计算梯度来更新输入从而改变分类器的分类结果,这里巧妙地和文本风格迁移相结合,能够达到控制迁移的层次(aspect)以及强度(degree)。

▲ 论文模型:点击查看大图

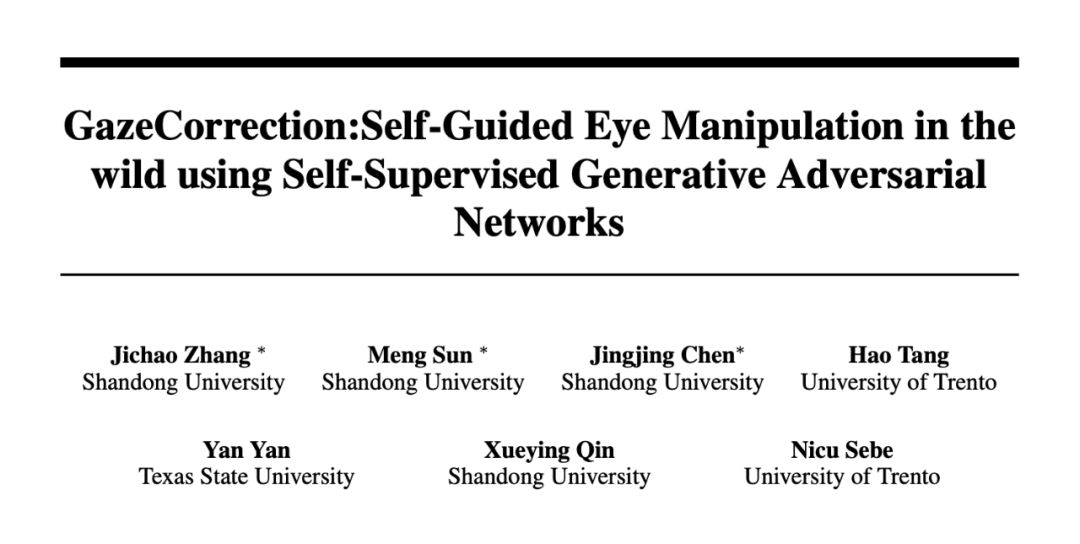

@zhangjichao 推荐

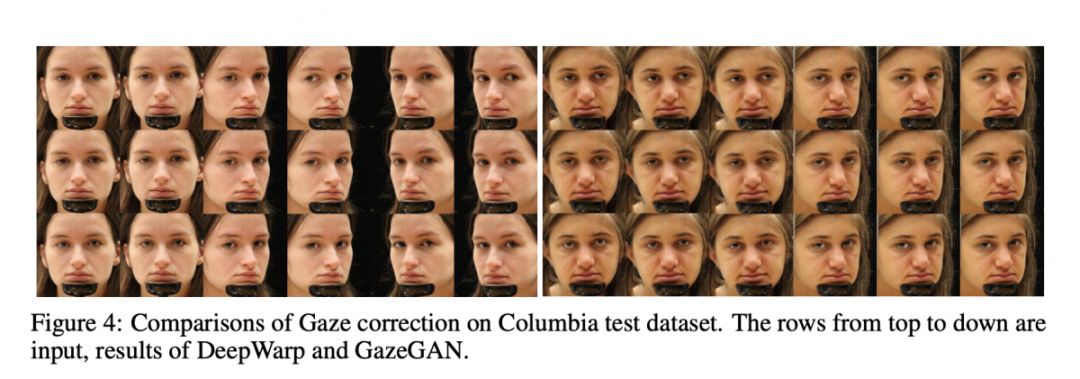

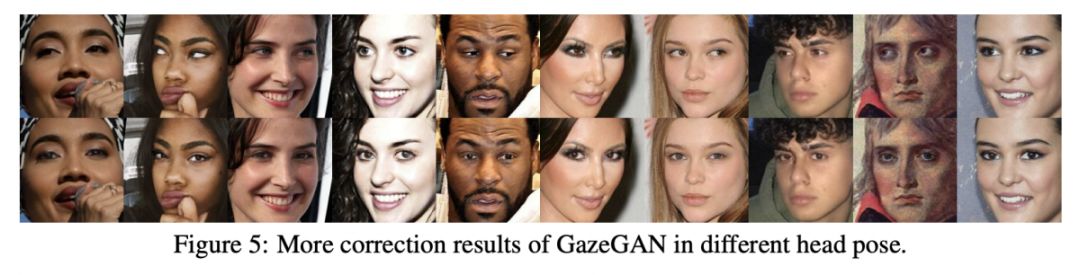

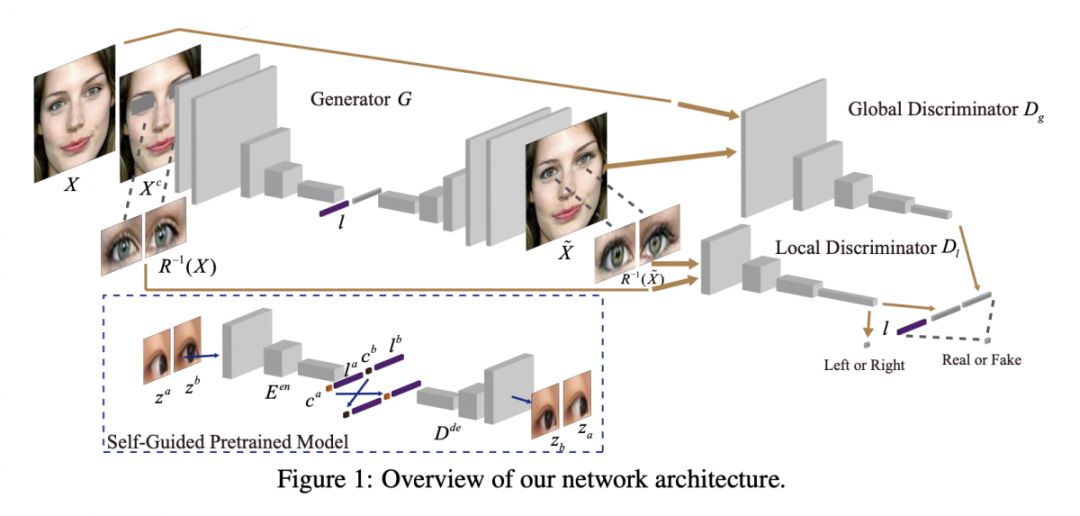

#Image-to-image Translation

本文提出了一种新颖的方式去解决人眼注意力矫正的问题,在经典的 GAN-based 修复方法上提出了一种自我引导的预训练模型来引导修复,进而保持修复的身份特征。本文为了稳定网络的训练和提高修复的质量,提出了一种自监督学习。这种新颖简单的自监督学习很容易扩展到其他图像翻译、图像修复领域中。

▲ 论文模型:点击查看大图

@xwzhong 推荐

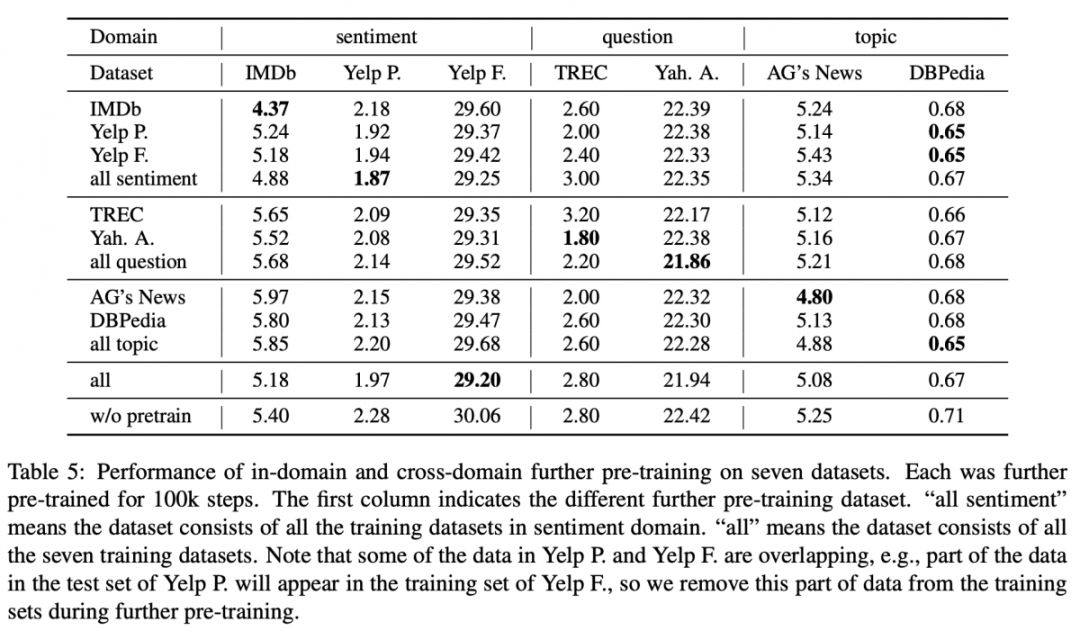

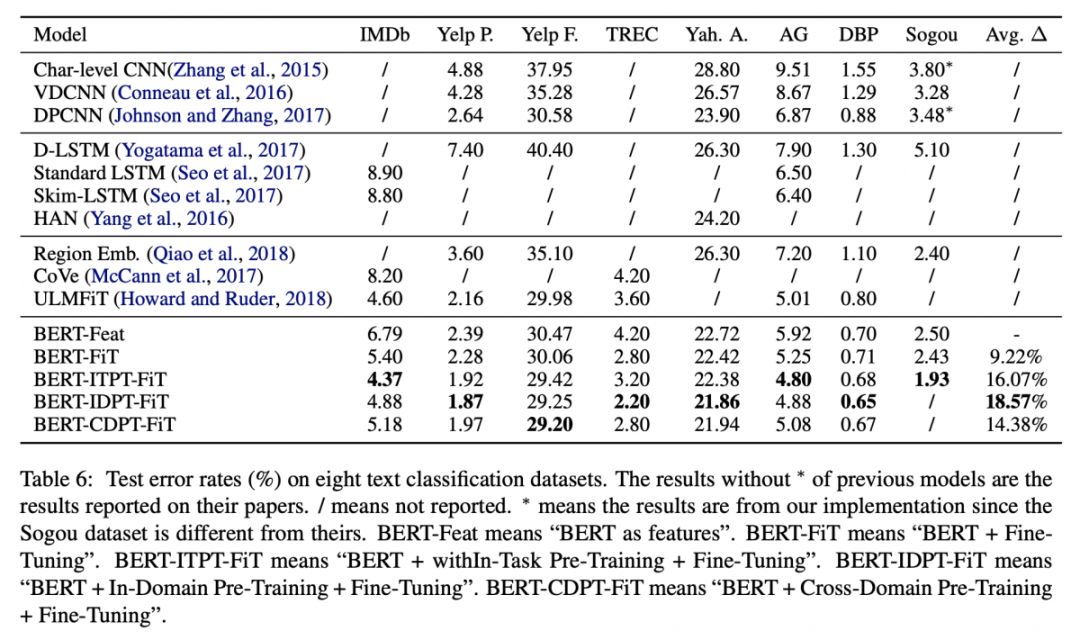

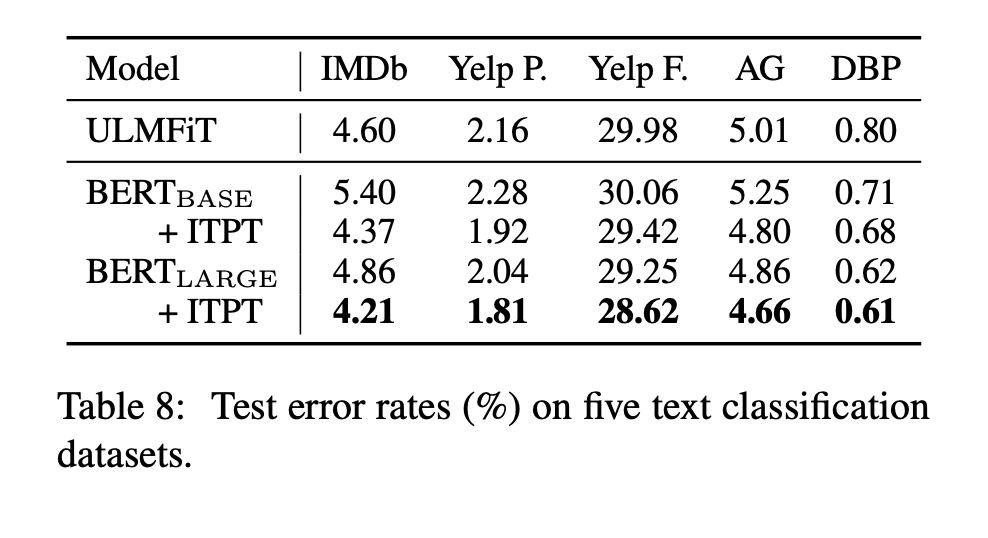

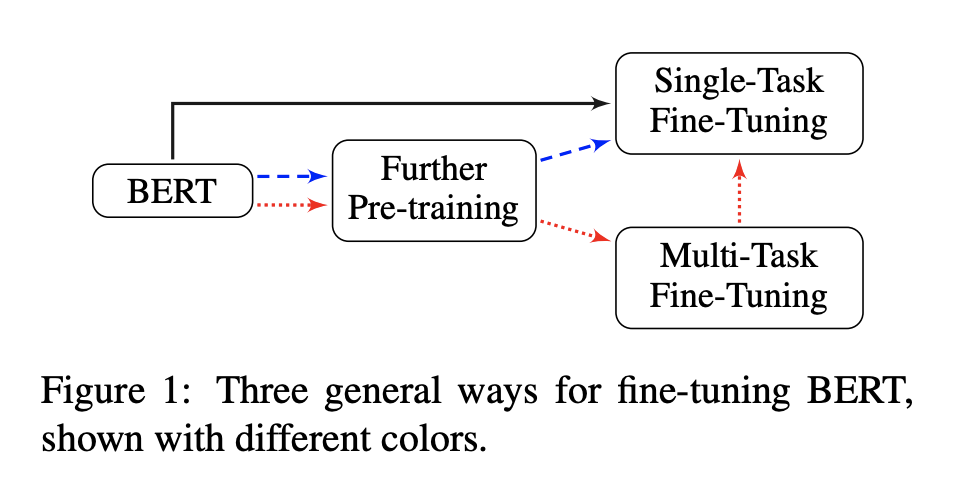

#Text Classification

本文来自复旦大学。针对 BERT 在文本分类中的应用,作者尝试了不同的微调方式来评测 BERT 的效果,主要分三大类:Fine-Tuning Strategies、Further Pretraining 和 Multi-task Fine-Tuning。

这是一篇实验性的文章,把 BERT 尽可能的微调方式都列举了,总的来讲效果比较好的方式是:

长文本仍需要进行实验才能确定是用 head、tail 还是 head+tail,这个跟具体的任务特点相关;

从准确率来看,一般选择最后一层 [CLS] 的输出,但如果要考虑线上的时间效率问题,则可以使用中间层输出,个人在其他任务中也发现,随着 [CLS] 层数的增加,准确率确实不断往上增,但时间复杂度也如此;

如果具体任务内的无标注数足够多,则用其再预训练,如果不多,则可利用领域内的数据,同时输出中间结果,并进行具体任务的微调测试。

▲ 论文模型:点击查看大图

本期所有入选论文的推荐人

均将获得PaperWeekly纪念周边一份

▲ 深度学习主题行李牌/卡套 + 防水贴纸

礼物领取方式

推荐人请根据论文详情页底部留言

添加小助手领取礼物

*每位用户仅限领取一次

想要赢取以上周边好礼?

点击阅读原文即刻推荐论文吧!

点击以下标题查看往期推荐:

让你的论文被更多人看到

如何才能让更多的优质内容以更短路径到达读者群体,缩短读者寻找优质内容的成本呢?答案就是:你不认识的人。

总有一些你不认识的人,知道你想知道的东西。PaperWeekly 或许可以成为一座桥梁,促使不同背景、不同方向的学者和学术灵感相互碰撞,迸发出更多的可能性。

PaperWeekly 鼓励高校实验室或个人,在我们的平台上分享各类优质内容,可以是最新论文解读,也可以是学习心得或技术干货。我们的目的只有一个,让知识真正流动起来。

📝 来稿标准:

• 稿件确系个人原创作品,来稿需注明作者个人信息(姓名+学校/工作单位+学历/职位+研究方向)

• 如果文章并非首发,请在投稿时提醒并附上所有已发布链接

• PaperWeekly 默认每篇文章都是首发,均会添加“原创”标志

📬 投稿邮箱:

• 投稿邮箱:hr@paperweekly.site

• 所有文章配图,请单独在附件中发送

• 请留下即时联系方式(微信或手机),以便我们在编辑发布时和作者沟通

🔍

现在,在「知乎」也能找到我们了

进入知乎首页搜索「PaperWeekly」

点击「关注」订阅我们的专栏吧

关于PaperWeekly

PaperWeekly 是一个推荐、解读、讨论、报道人工智能前沿论文成果的学术平台。如果你研究或从事 AI 领域,欢迎在公众号后台点击「交流群」,小助手将把你带入 PaperWeekly 的交流群里。

▽ 点击 | 阅读原文 | 获取更多论文推荐