看电视的时候突然想上厕所,这时候一般人要么用遥控器按一下暂停,要么先不管电视,回头再把视频倒回去。

但无论哪一种方法,我们都需要手动操作一下。如果当时手上恰好沾了水果汁或面粉,即使只是用遥控器按一下暂停也会让人觉得很麻烦。

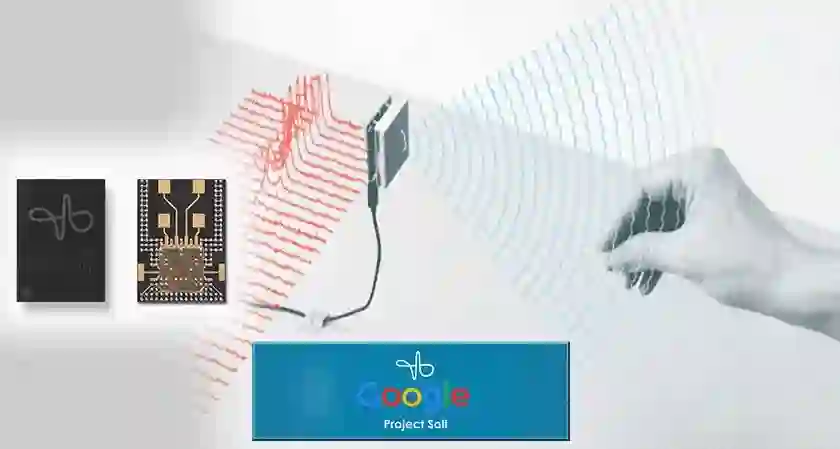

如何实现这一过程的智能化呢?谷歌的先进科技与计划部门(Advanced Technology and Projects,简称 ATAP)最近想了一个好办法:用雷达来理解我们的需求和意图,然后做出对应的反应。也就是说,它可以在你起身离开时帮你暂停视频,然后在你回来后再自动播放。

![]()

为什么要用雷达呢?因为每天被摄像头盯着的日子实在令人不安。

这不是我们第一次看到谷歌使用雷达为其设备提供空间感知。2015 年,谷歌推出了 Soli,这是一款可以利用雷达的电磁波来捕捉精确手势和动作的传感器。这一功能最早出现在谷歌 Pixel 4 上,它能够检测简单的手势,这样用户就可以在不接触智能手机的情况下让闹钟停止或暂停音乐。

![]()

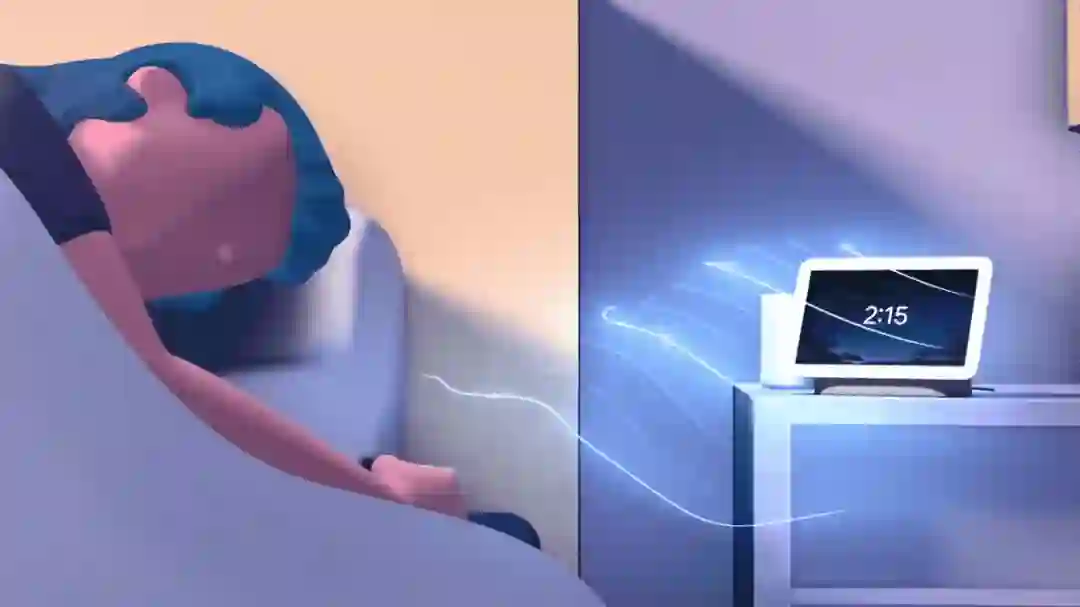

最近,第二代 Nest Hub 智能显示屏中嵌入了雷达传感器,以检测睡在它旁边的人的动作和呼吸模式。该设备的好处在于,它不需要人佩戴智能手环就能跟踪人的睡眠情况。

![]()

同样的 Soli 传感器也被用于新一轮的研究中,但 ATAP 这次并没有使用传感器输入直接控制计算机,而是使用传感器数据使计算机能够识别我们的日常活动,并做出新的选择。

「我们相信,随着科技越来越多地出现在我们的生活中,开始要求科技从我们身上提取更多的线索是非常合理的,」ATAP 设计主管 Leonardo Giust 说。像你妈妈在你出门前提醒你拿把伞一样,也许你的恒温调节器可以在你走过并瞥一眼时传递同样的信息。或者,如果你的电视检测到你在沙发上睡着了,它可以调低音量。

![]()

![]()

Giusti 说,大部分研究都是基于空间关系学(proxemics,即人们如何运用空间进行交流)的。也就是说,当你与另一个人的距离越来越近,意味你期望增加参与度和亲密感。ATAP 团队使用这一点和其他社交线索来确定人和设备拥有自己的个人空间概念。

雷达可以检测到人靠近计算机并进入其个人空间,这可能意味着计算机可以选择执行某些操作,例如无需按下按钮即可启动屏幕。这种交互已经存在于当前的 Google Nest 智能显示器中,但它是使用超声波而不是雷达来测量人与设备的距离。当 Nest Hub 注意到你正在靠近时,它会突出显示当前提醒、日历事件或其他重要通知。

仅仅接近是不够的,如果你最后只是经过了机器并朝不同的方向看,怎么办?为了解决这个问题,Soli 可以捕捉运动和手势的更细微之处,例如身体方向、可能正在走的路径以及头部朝向,然后在机器学习算法的帮助下进一步细化数据。所有这些丰富的雷达信息有助于它更好地猜测你是否确实要开始与设备进行交互,以及参与的类型可能是什么。

这种改进后的感知来源于新冠疫情期间,团队在各自家里的客厅进行了一系列精心设计的任务,包括头戴摄像头跟踪他们的动作和实时雷达感应。

「我们能够以不同的方式移动,我们对该动作进行不同的变化,鉴于这是正在使用的实时系统,我们能够在某种意义上以我们的发现为基础进行即兴创作。」ATAP 的高级交互设计师 Lauren Bedal 说。

拥有舞蹈背景的 Bedal 说,这个过程非常类似于编舞者采用基本的动作理念(称为动作主题)并探索其变化,例如舞者如何改变重心或改变身体姿势和方向。从这些研究中,该团队设计了一组动作,这些动作都受到非语言交流以及我们如何自然地与设备交互的启发:接近或离开、经过、转向或远离以及扫视。

Bedal 列举了一些计算机对这些动作做出反应的例子:如果设备感应到你靠近,它可以拉起触摸控件;靠近设备,它可以突出显示传入的电子邮件;离开房间,电视可以在你离开的地方添加书签,并在你回来时从该位置恢复。

如果设备确定你只是路过,它不会以低优先级通知打扰你;如果你在厨房里按照视频食谱进行操作,设备可以在你离开抓取食材时暂停,并在你退后并表达重新参与的意图时继续。如果你在打电话时看一眼智能显示屏,该设备可以提供转移到视频通话的选项,这样你就可以放下手机了。

![]()

「所有这些动作都表明,未来与计算机交互可以利用我们移动的自然方式,这种方式在感觉上非常隐蔽,计算机可以只在恰当的时刻帮助我们,」Bedal 说。「我们实际上只是在推动我们认为可能进行人机交互的界限。」

利用雷达来影响计算机对我们的反应是一个挑战。比如说,虽然雷达可以探测到一个房间里有多个人,但如果受试者太靠近,传感器只能看到一团乱七八糟的人群,从而混淆了决策过程。未来还有很多工作要做。所以 Bedal 多次强调,这项工作还处于研究阶段,不能指望它出现在下一代智能显示器上。

![]()

人们有充分的理由相信,随着时间的推移,雷达也可以助力了解自己的日常事务。这也是 ATAP 的 Giusti 说的研究路线图上的一个领域,比如提出与你自己目标相关的健康建议。想象一下,当智能显示器意识到你在午夜前往小吃柜时,它会变成一个巨大的停止标志。

当这些设备执行一系列它认为你想要的操作时,它们也需要达到一种平衡。例如:「当我在厨房做饭的时候,如果想让电视开着怎么办?」因为这时雷达不会探测到任何人在看电视,它会暂停电视而不是让电视开着。

「当我们开始研究这些感觉非常无形、无缝和灵活的交互模式时,就需要在用户控制和自动化之间找到一个正确的平衡点,」Bedal 说。「这应该是毫不费力的,但我们应该考虑的是用户可能想要的控制或配置的数量。」

ATAP 团队之所以选择使用雷达,是因为它是收集丰富空间数据的一种更加保密的方法。它的延迟时间很短,能够在黑暗中工作,而且声音或温度等外部因素不会影响它。与照相机不同,雷达不会捕捉和储存你的身体、面部或其他识别方式的可识别图像。

「它更像是一个先进的运动传感器,」Giusti 说。Soli 的探测范围在 9 英尺左右,比大多数照相机的探测范围都要小,但只要在家里安装多个 Soli 传感器的设备,就可以有效地覆盖全部的空间,并创建一个有效的网络来跟踪你在家里的行迹。

值得注意的是,来自当前 Google Nest Hub 中 Soli 传感器的数据是在本地处理的,原始数据不会发送到云上。

![]()

CMU 的人机交互研究员、Future Interfaces Group 实验室负责人 Chris Harrison 表示,消费者必须决定他们是否要交易隐私权,毕竟,谷歌是「将数据货币化的世界领导者」。但他仍然认为,谷歌的无摄像头方法在很大程度上是用户优先和隐私优先的做法。「没有侵犯或不侵犯隐私这回事,」Chris Harrison 说。「一切都是程度问题。」

由于设备不可避免地需要使用传感器 (如 Soli) 来收集更多的数据,因此它们能够更好地理解我们。

「人类天生就能真正理解人类的行为,当计算机破坏了它,就会导致这些额外的令人沮丧的情况发生。」Chris Harrison 说:「将社会科学家和行为科学家等人带入计算机领域,可以让这些体验变得更加愉悦、更加人性化。」

谷歌先进科技与计划部门(ATAP)是谷歌公司内部的一个部门,原隶属于摩托罗拉移动旗下,在摩托罗拉移动出售予联想后保留在了谷歌内部。

该部门的创建者是前谷歌副总裁雷吉娜 · 杜根(Regina Dugan),她之前在 DARPA(美国国防高级研究计划局)工作并担任局长。创建 ATAP 时,杜根对外宣称,她将领导一个秘密的硬件部门打造不一样的未来。

![]()

前谷歌副总裁雷吉娜 · 杜根,2016 年跳槽去了 Facebook,2020 年开始担任 Wellcome Leap 的 CEO(Wellcome Leap 是由全球性慈善基金会 Wellcome 创立的非营利组织,旨在加速有利于全球健康的创新)。

在摩托罗拉时期,ATAP 对 Moto X(由摩托罗拉移动在成为 Google 子公司后研制的 Android 智能手机)的开发计划有重要贡献。

在谷歌,ATAP 的定位是颠覆性技术开发实验室,这些年主导的项目包括 Project Tango(能让手机和平板感知 3D 空间)、Project Jacquard(智能外套,在衣服表面滑动就能控制手机)、Project Vault(Micro - SD 卡上的安全计算环境)、Project Soli(支持雷达的手势界面)、Project Ara(可高度模块化的智能手机)等。当然,这项项目有成功,也有失败。

![]()

这个团队体现了杜根在 DARPA 工作时使用的原则,即创建由高绩效人员组成的小团队,并充分利用组织框架之外的资源。ATAP 与几十个国家的数百个合作伙伴合作,包括学校、公司、初创企业、政府和非营利组织,与斯坦福大学、麻省理工学院和加州理工学院等一流大学签订了常备合同,以便在需要时快速安排研究工作。

参考链接:https://en.wikipedia.org/wiki/Google_ATAP

时在中春,阳和方起——机器之心AI科技年会

机器之

心AI科技年会将于3月23日在北

京举办,在分享交流对人工智能的判断与思考外,更重要的是与读者、合作伙伴和好友们真实的见一面。

这是一次注重交流与见面的聚会,所以叫「年会」,没叫「大会」。

在这场年会上,有三个方向我们希望和大家分享:人工智能、AI for Science和智能汽车。

人工智能论坛关注高性能计算、联邦学习、系统机器学习、强化学习、CV与NLP发展、RISC-V等。

AI x Science论坛关注AI与蛋白质、生物计算、数学、物理、化学、新材料和神经科学等领域的交叉研究进展。

首席智行官大会关注智能汽车、汽车机器人、无人驾驶商业化、车规级芯片和无人物流等。

当然,按以往的惯例,我们还将邀请行业内最具代表性与专业的权威嘉宾带来他们的思考与判断。

欢迎大家点击「阅读原文」报名活动,「中春」见。

© THE END

转载请联系本公众号获得授权

投稿或寻求报道:content@jiqizhixin.com