图注意力网络一作:图表征学习在算法推理领域的研究进展

机器之心整理

整理:Racoon、张倩

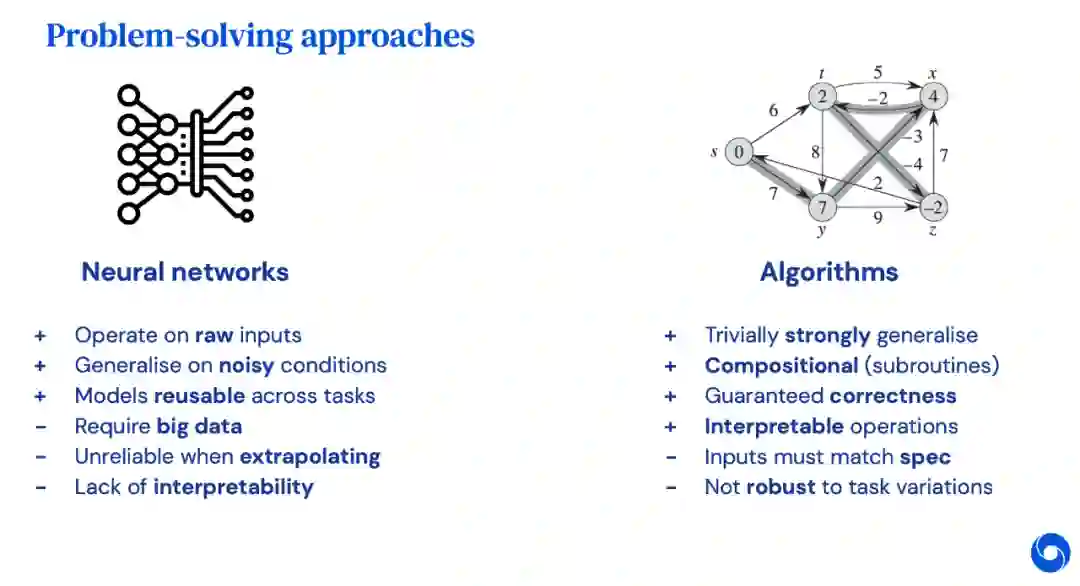

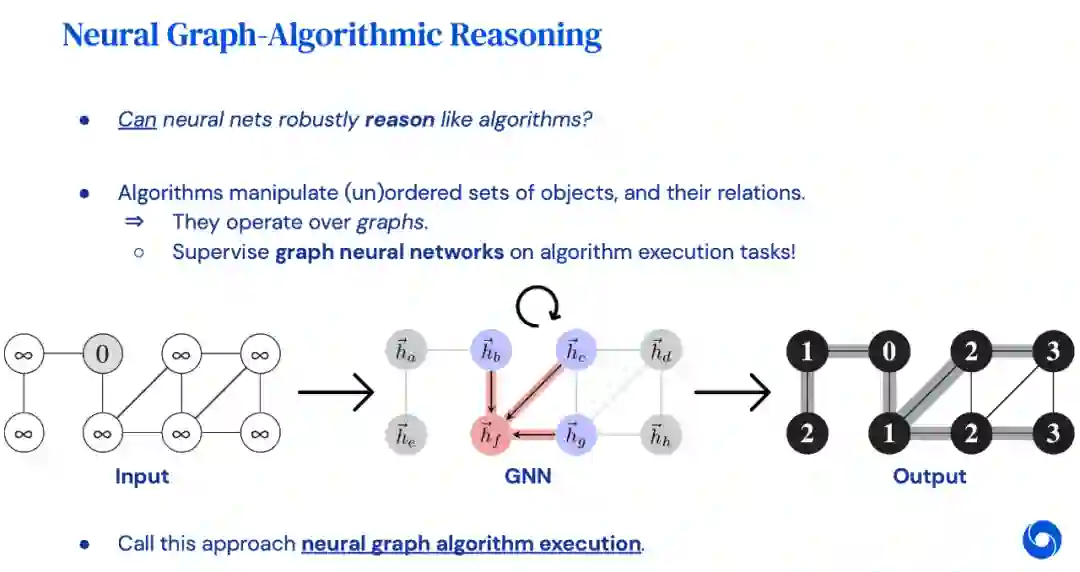

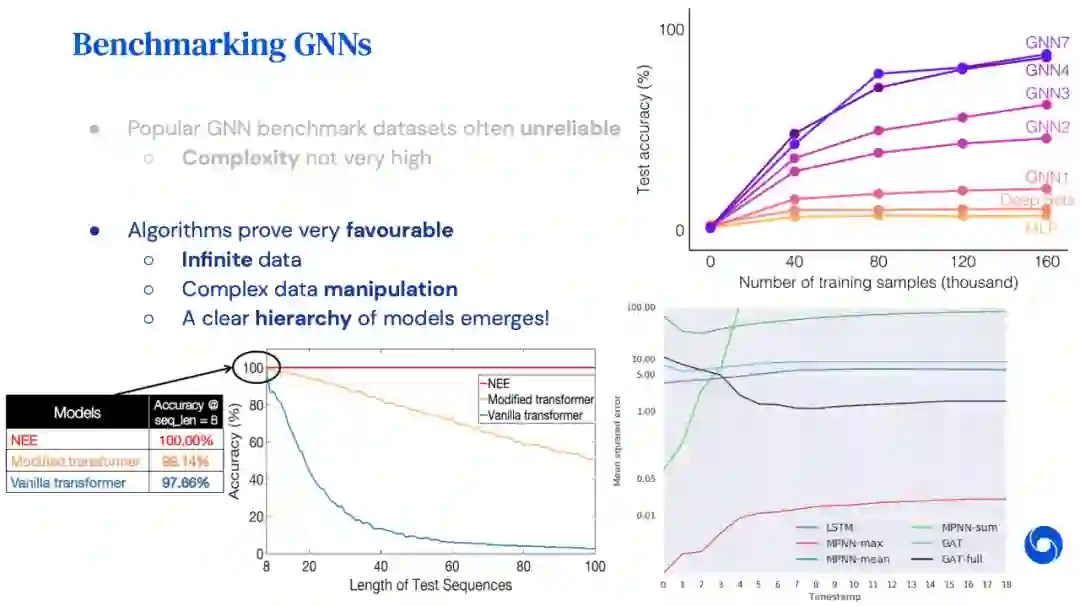

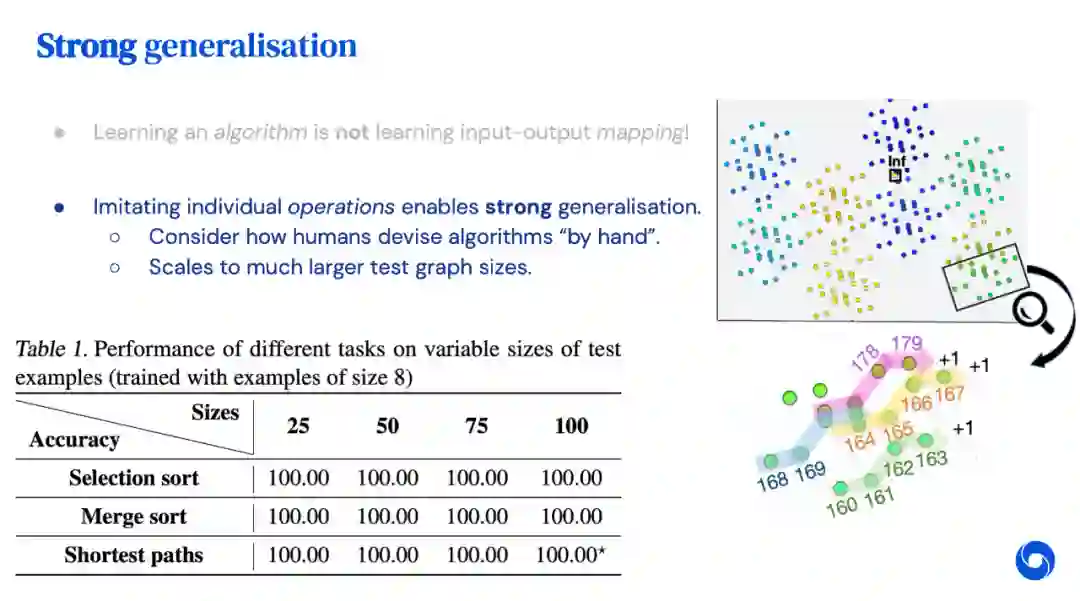

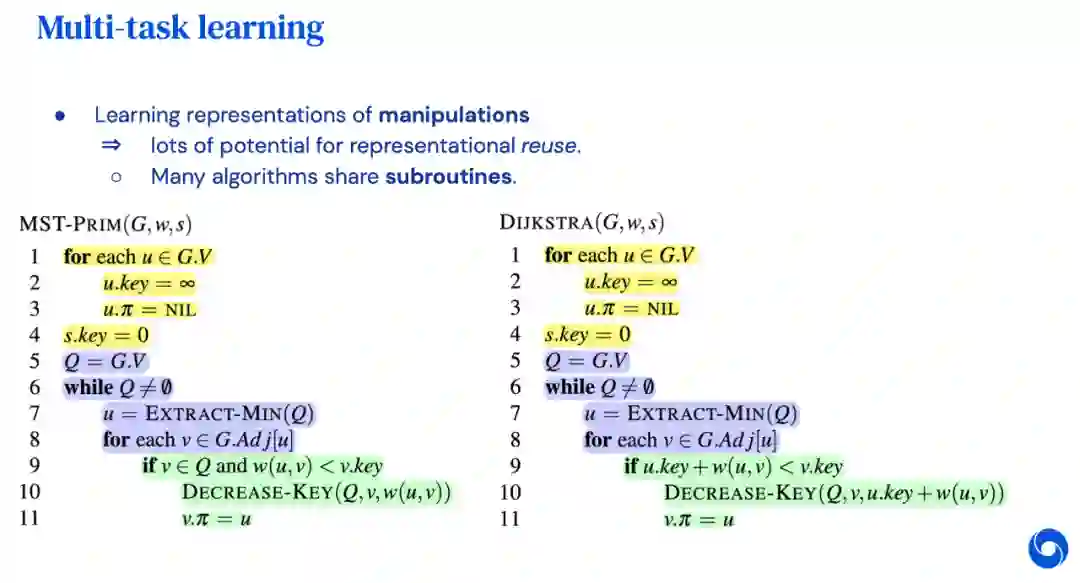

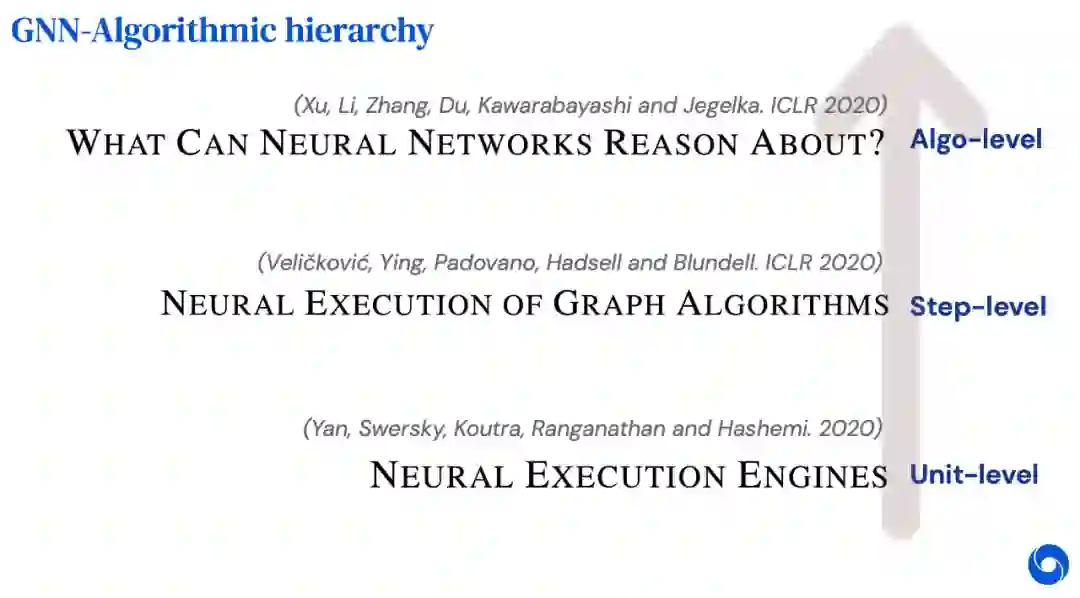

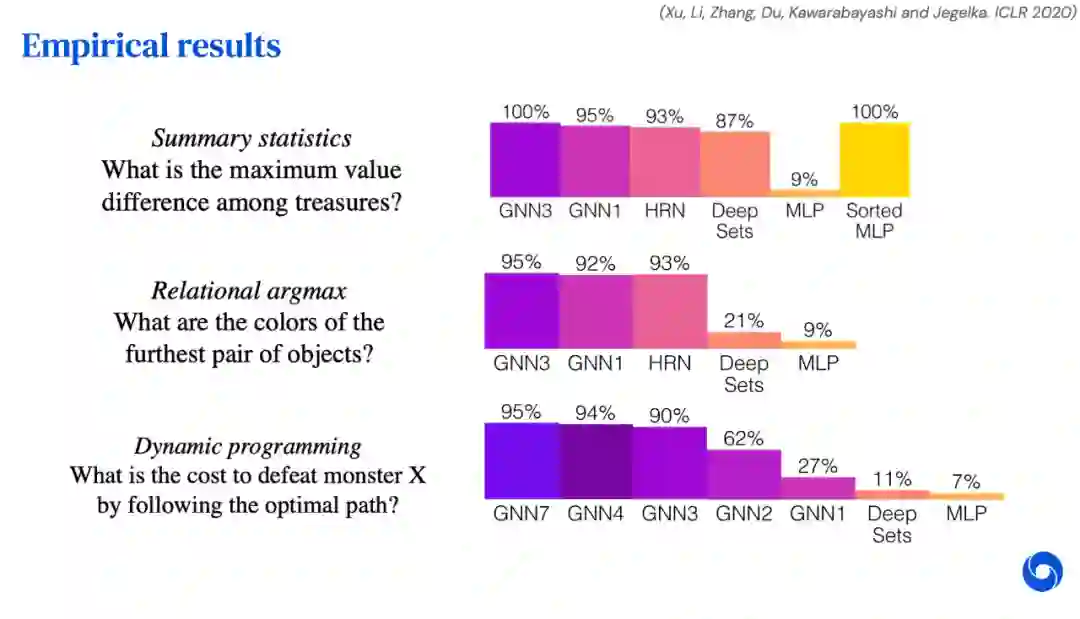

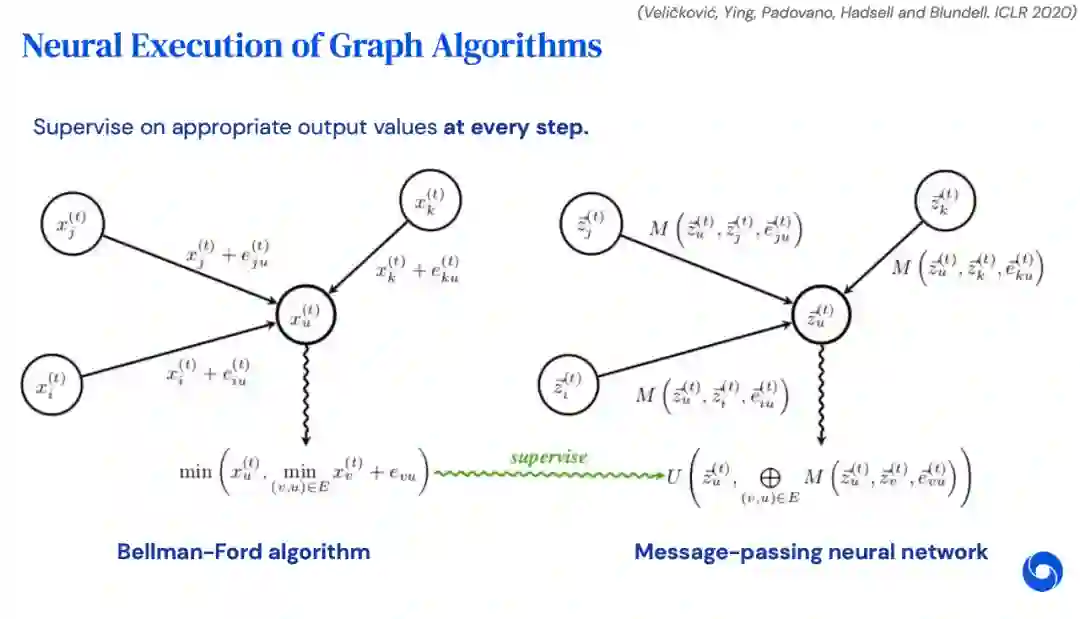

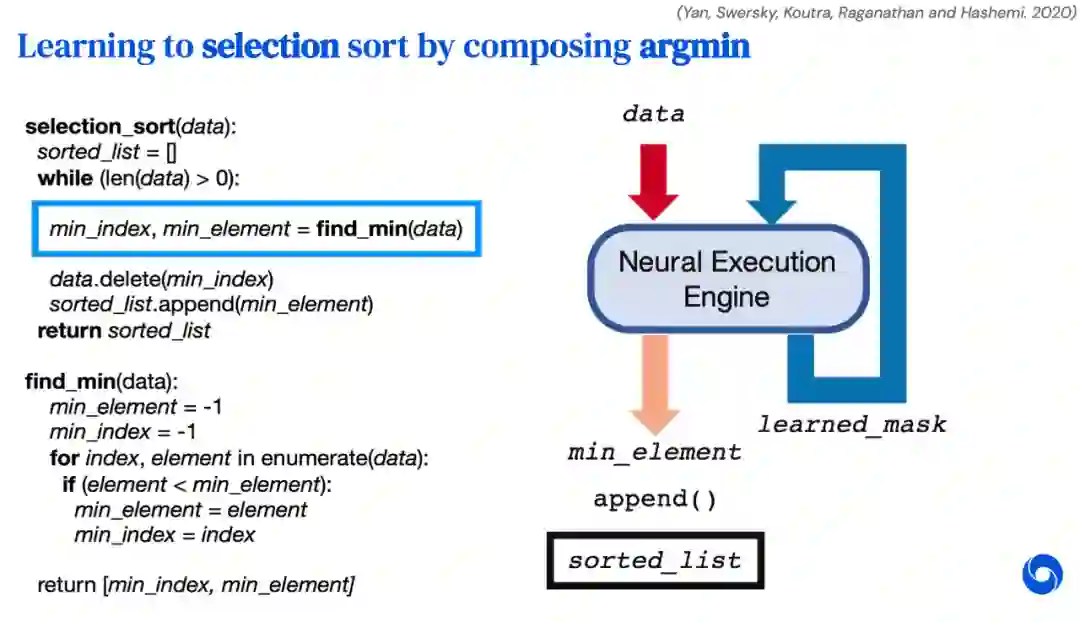

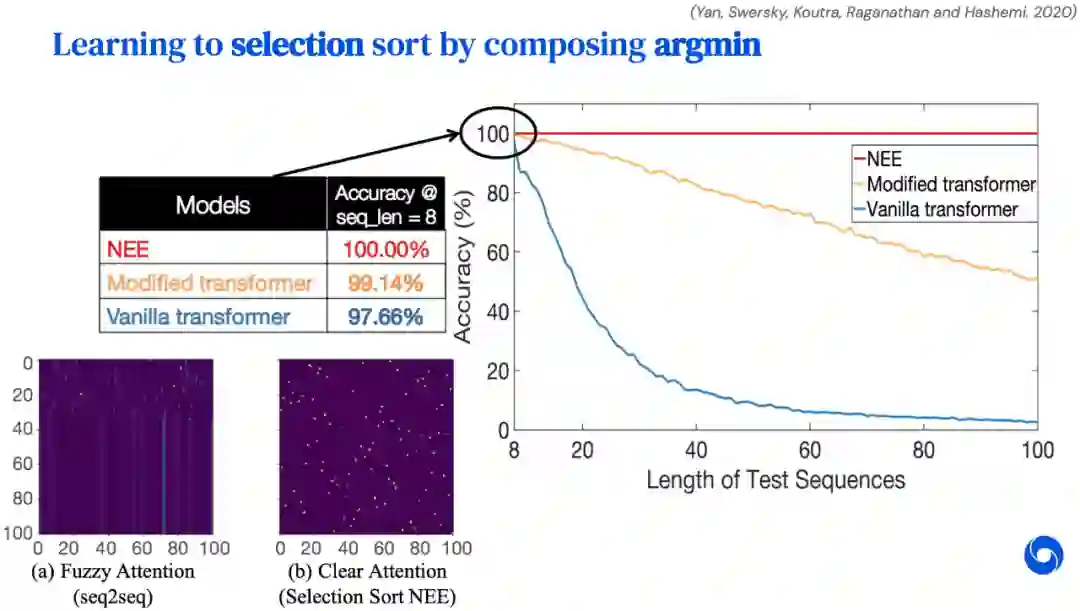

这是一份来自 DeepMind 研究员、图注意力网络一作 Petar Veličković 的演讲,他为我们介绍了图表征学习在算法推理领域的研究进展。Veličković 指出,算法推理是图表征学习的一个令人激动的新领域,他希望自己的这次演讲能够吸引更多的人了解或关注这个领域,为该领域的研究贡献一份力量。

登录查看更多

相关内容

专知会员服务

99+阅读 · 2020年7月3日