基于行列式点过程的推荐多样性提升算法的直观理解

作者:杨旭东

来源:https://zhuanlan.zhihu.com/

p/94464178

整理:深度传送门

介绍

多样性和相关性是衡量推荐系统的常用的指标,这两个指标同时影响着推荐系统的商业目标和用户体验。Hulu在NIPS 2018 会议上发表的论文《Fast Greedy MAP Inference for Determinantal Point Process to Improve Recommendation Diversity》(Hulu视频推荐如何提升推荐中的多样性)中,提出了基于行列式点过程的推荐多样性提升算法,虽然网上可以找到很多解读文章,但个人觉得解释得不是很直观和易懂。本文尝试给出一种更加简单和容易理解的解读,并且给出算法的实现代码,是对自己理解过程的一次总结,也希望能够帮助到读者。

我们有一个待推荐的候选商品集合

如何量化推荐列表的多样性和相关性

相关性很好理解,就是推荐给用户的商品必须符合用户的兴趣,满足用户的购物需求。用户会用点击行为来表达兴趣,用下单行为来满足购物需求。用户的点击和购买行为就是系统收集到的样本,基于这些样本推荐系统的从业者一直以来都在做的点击率和转化率预估,其实就是对相关性的一种衡量和量化。给定用户

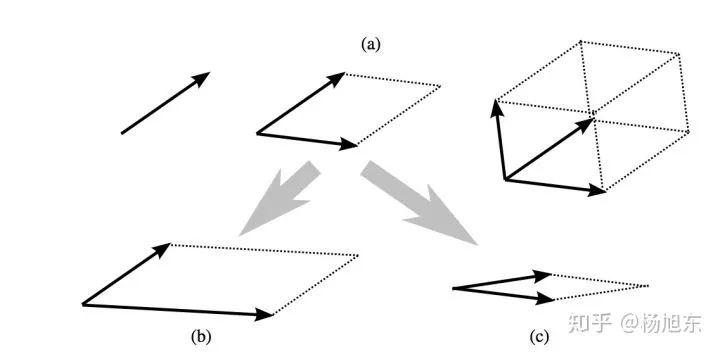

推荐多样性(diversity)衡量单个推荐列表中物品之间的差异程度,通过计算在同一个推荐 list 中两两 Item 之间的相似度的平均值来进行衡量。那么如何量化推荐列表的多样性呢?要量化推荐列表的多样性,我们首先要能够计算列表中任意两个商品之间的相似性(similarity)。计算两个对象之间的相似性有很多方法,这里我们假设用特征向量的余弦相似度的方法来计算。商品在表示成特征向量之后,两个特征向量之间的夹角越小,说明这两个向量越相似,也就是对应的两个商品越相似。

推荐列表中的商品彼此之间的相似度越低,推荐列表的多样性也就越高。我们用一个定义在商品集合的相似度矩阵上的函数

一个很好的选择就是矩阵

现在我们可以分别度量相关性和多样性了,接下来的问题就是能否在同一个过程中同时度量相关性和多样性。答案当然是肯定的,具体地,我们引入一个叫做核矩阵(kernel matrix)的概念,用核矩阵的行列式来同时度量商品集合的多样性和相关性。那么核矩阵是如何定义的呢?怎么构建核矩阵才能有机融合相关性和多样性呢?

核矩阵是由

给定一个大小为的实对称矩阵

,若对于任意长度为

的非零向量

,有

成立,则矩阵

是一个 半正定矩阵。

因为核矩阵

其中,

其中,

假设系统筛选出的推荐给用户的商品子集为

其中,

如何选择能够最大化相关性和多样性的商品子集

前一小节解释了如何度量推荐列表的相关性和多样性,但并未解释如何从候选商品集合中选择商品组成最终的推荐列表。商品列表选择的过程其实就是从所有的候选商品子集中选择一个能使上述量化值最大的子集,而这个选择的过程需要借助行列式点过程来实现。

DPP(Determinantal Point Process)行列式点过程,是一种性能较高的概率模型,其将复杂的概率计算转换成简单的行列式计算,通过核矩阵的行列式计算每一个子集的概率。该概率可以理解为用户对推荐列表满意的概率,受到相关性与多样性两个因素的影响。具体地,对于一个离散的集合

其中,

为了描述的方便,给出一些符合定义:

集合使用大写字母表示,比如:

。

向量和矩阵分别通过粗体小写字母和粗体大写字母表示。

表示向量或矩阵的转置。

是向量

和

的内积。

给定子集

和

,

是

的sub-matrix,通过行中的

和列中的

索引。

出于简洁,我们假设:

,

以及

。

是矩阵

的行列式,惯例上令

。

推荐列表就是从候选商品集合中选择能够最大化后验概率的商品子集,这一筛选过程就是行列式点过程的最大后验概率推断MAP(maximum a posteriori inference)。

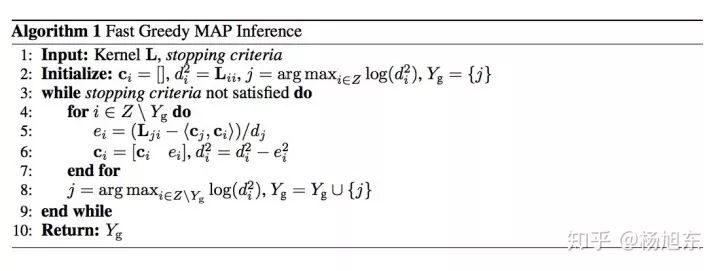

行列式点过程的MAP求解是一个复杂的过程,Hulu的论文中提出了一种改进的贪心算法能够快速求解,该算法的时间复杂度为

这一求解过程简单来说就是每次从候选集中贪心地选择一个能使边际收益( marginal gain)最大的商品加入到最终的结果子集中,直到满足停止条件为止,即每次选择商品

其中行列式

其中

其中,等式右边右上角的子矩阵为0向量,是因为

另外,根据等式(2), 可以得到:

因此,等式(1)可以简化为:

一旦等式(6)被求解,根据等式(2),

其中,

对于每个item

根据等式(3)和等式(7),我们有:

通过将等式(3)和等式(8)组合,我们可以对

等式(4)意味着:

最初,

其中,停止条件(stopping criteria)为

实现代码

Python代码如下:

import numpy as npimport mathdef dpp(kernel_matrix, max_length, epsilon=1E-10):"""fast implementation of the greedy algorithm:param kernel_matrix: 2-d array:param max_length: positive int:param epsilon: small positive scalar:return: list"""item_size = kernel_matrix.shape[0]cis = np.zeros((max_length, item_size))di2s = np.copy(np.diag(kernel_matrix))selected_items = list()selected_item = np.argmax(di2s)selected_items.append(selected_item)while len(selected_items) < max_length:k = len(selected_items) - 1ci_optimal = cis[:k, selected_item]di_optimal = math.sqrt(di2s[selected_item])elements = kernel_matrix[selected_item, :]eis = (elements - np.dot(ci_optimal, cis[:k, :])) / di_optimalcis[k, :] = eisdi2s -= np.square(eis)selected_item = np.argmax(di2s)if di2s[selected_item] < epsilon:breakselected_items.append(selected_item)return selected_items

测试代码:

from dpp import *import timeitem_size = 5000feature_dimension = 5000max_length = 1000scores = np.exp(0.01 * np.random.randn(item_size) + 0.2)feature_vectors = np.random.randn(item_size, feature_dimension)feature_vectors /= np.linalg.norm(feature_vectors, axis=1, keepdims=True)similarities = np.dot(feature_vectors, feature_vectors.T)kernel_matrix = scores.reshape((item_size, 1)) * similarities * scores.reshape((1, item_size))print 'kernel matrix generated!'t = time.time()result = dpp(kernel_matrix, max_length)print 'algorithm running time: ' + '\t' + "{0:.4e}".format(time.time() - t)

参考资料

Learning and Enforcing Diversity with Determinantal Point Processe

本文转载自公众号:深度传送门,作者 杨旭东

推荐阅读

Google工业风最新论文, Youtube提出双塔结构流式模型进行大规模推荐

关于AINLP

AINLP 是一个有趣有AI的自然语言处理社区,专注于 AI、NLP、机器学习、深度学习、推荐算法等相关技术的分享,主题包括文本摘要、智能问答、聊天机器人、机器翻译、自动生成、知识图谱、预训练模型、推荐系统、计算广告、招聘信息、求职经验分享等,欢迎关注!加技术交流群请添加AINLP君微信(id:AINLP2),备注工作/研究方向+加群目的。

的实对称矩阵

的实对称矩阵

,若对于任意长度为

,若对于任意长度为

,有

,有

成立,则矩阵

成立,则矩阵

表示向量或矩阵的转置。

表示向量或矩阵的转置。 是向量

是向量  的内积。

的内积。 和

和  是

是  ,

, 。

。 是矩阵

是矩阵  。

。