【Google-MIT-哥伦比亚-ICRA2020】先看后学:操作前的视觉训练,Visual Pre-training

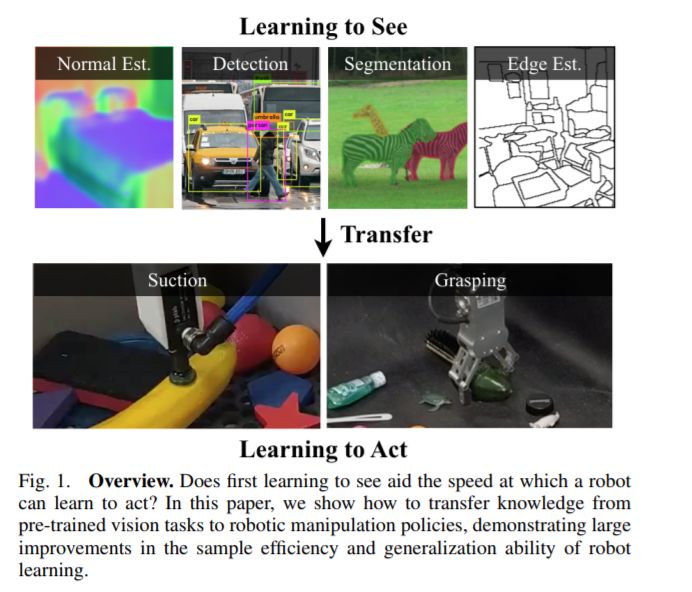

拥有视觉先验(例如,检测物体的能力)是否有助于学习执行基于视觉的操作(例如,拾取物体)?我们在迁移学习的框架下研究这个问题,其中模型首先被训练在一个被动的视觉任务上,然后被调整来执行一个主动的操作任务。我们发现视觉任务的预训练显著地提高了学习操作对象的泛化和样本效率。然而,实现这些收益需要谨慎地选择模型的哪些部分进行转换。我们的主要观点是,标准视觉模型的输出与操作中常用的可视性映射高度相关。因此,我们探索了将模型参数直接从视觉网络转移到启示预测网络的方法,并证明了这一方法可以成功地实现零距离自适应,即机器人可以在零经验的情况下拾取特定的物体。只需少量的机器人经验,我们就可以进一步微调启示模型,以获得更好的结果。只需10分钟的吸力体验或1小时的抓取体验,我们的方法就可以获得80%的成功率来抓取新奇的对象。

https://yenchenlin.me/vision2action/

专知便捷查看

便捷下载,请关注专知公众号(点击上方蓝色专知关注)

后台回复“VPM” 就可以获取《【Google-MIT-哥伦比亚-ICRA2020】先看后学:操作前的视觉训练,Visual Pre-training》专知下载链接

登录查看更多

相关内容

Arxiv

3+阅读 · 2019年7月8日