【PNAS2020-斯坦福】自监督训练的人工神经网络中的涌现语言结构

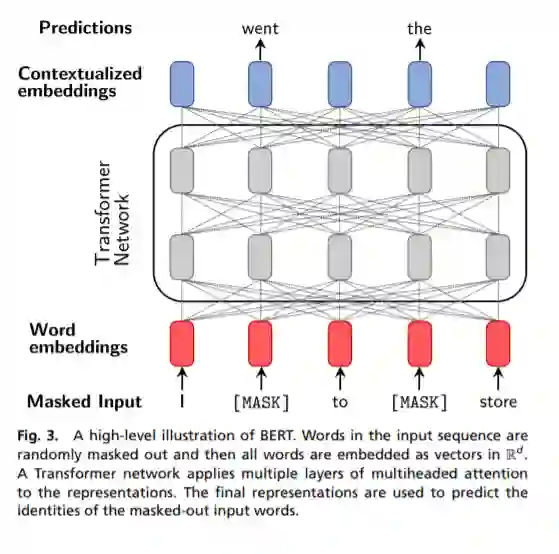

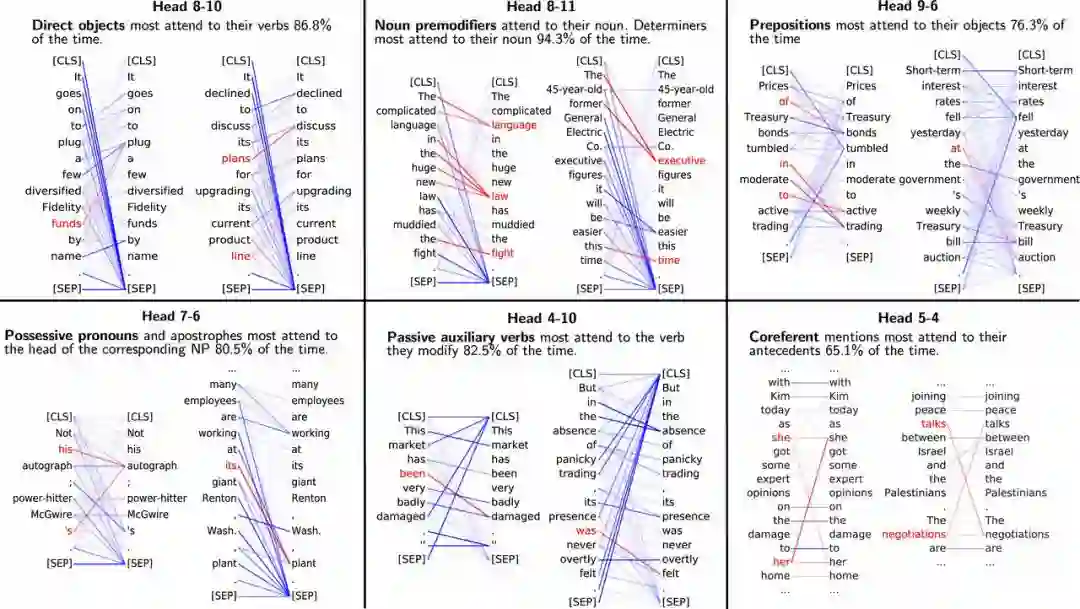

本文探讨了大型人工神经网络学习的语言结构知识,通过自监督训练,该模型简单地尝试预测给定上下文中的一个掩蔽词。人类的语言交流是通过词语序列进行的,但是语言理解需要构建丰富的从未被明确观察到的层次结构。这一机制一直是人类语言习得的一个主要奥秘,而工程工作主要是通过在树堆上有监督的句子学习来完成的,这些句子是手写标记的这种潜在结构。然而,我们证明,现代的深度语境化语言模型在没有任何明确监督的情况下学习这种语言结构。我们开发了识别人工神经网络中涌现的语言层次结构的方法,并证明了这些模型中的组件关注于语法关系和回指共指。事实上,我们表明,在这些模型中学习的嵌入的线性转换捕获了解析树的距离,达到了令人惊讶的程度,允许大致重建通常由语言学家假定的句子树结构。这些结果有助于解释为什么这些模型在许多语言理解任务中带来了如此大的改进。

https://www.pnas.org/content/early/2020/06/02/1907367117

专知便捷查看

便捷下载,请关注专知公众号(点击上方蓝色专知关注)

后台回复“ELS” 可以获取《【PNAS2020-斯坦福】自监督训练的人工神经网络中的涌现语言结构》专知下载链接索引

登录查看更多

相关内容

Arxiv

16+阅读 · 2019年5月24日