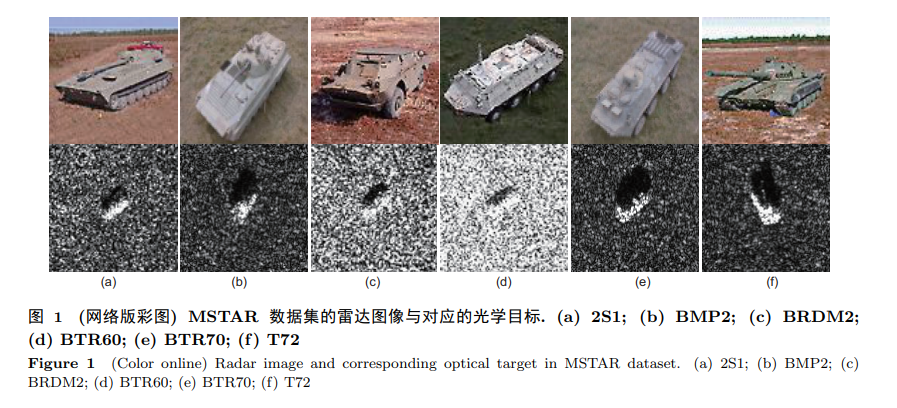

雷达图像深度学习模型的可解释性研究与探索

专知便捷查看

便捷下载,请关注专知公众号(点击上方蓝色专知关注)

后台回复“RDLE” 就可以获取《雷达图像深度学习模型的可解释性研究与探索》专知下载链接

登录查看更多

相关内容

Arxiv

0+阅读 · 2022年9月14日

Arxiv

10+阅读 · 2021年5月10日

Arxiv

17+阅读 · 2021年3月19日