©PaperWeekly 原创 · 作者|张咪

学校|武汉大学硕士生

研究方向|情感分析、信息抽取等

本文介绍一篇发表于 EMNLP 2020 的论文《Convolution over Hierarchical Syntactic and Lexical Graphs for Aspect Level Sentiment Analysis》,简称 BiGCN。该工作提出了一种新颖的体系结构,其目标在于更好地利用语料库级别的单词共现信息以及不同类型的句法依存关系。

为此,该文首先创造性地提出了句法和词汇的概念层次,并以此为基础建立了层次句法图和层次词汇图,随后设计了双层交互式图卷积网络以充分融合层次句法和词汇图。论文在五个基准数据集上进行了大量实验,结果表明 BiGCN 方法达到了最佳性能。

论文标题:

Convolution over Hierarchical Syntactic and Lexical Graphs for Aspect Level Sentiment Analysis

论文链接:

https://www.aclweb.org/anthology/2020.emnlp-main.286.pdf

代码链接:

https://github.com/NLPWM-WHU/BiGCN

背景简介

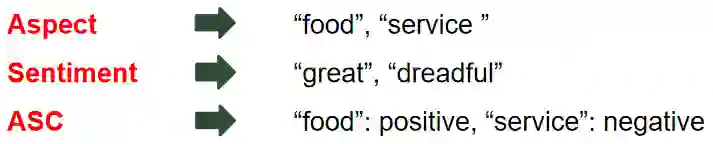

ASC (Aspect-based Sentiment Classification):目的在于确定针对特定方面的情感极性。

例如:

great food but the service was dreadful.

给定两个方面词的术语“food”和“service”,目标是推断方面的情感极性:对 food 是 positive,对 service 是 negative。

1.1 Existing Studies

ASC 的最新进展集中在开发各种类型的深度学习模型上。我们简要回顾了不考虑语法的神经模型,然后转到基于语法的模型。

1.1.1 Neural models without considering syntax

不考虑语法模型的神经模型主要可以分为几种类型:基于 LSTM,基于 CNN,基于 memory 和其他混合方法。

缺点:这些模型将句子表示为一个单词序列,而忽略了单词之间的句法关系 ,因此,此类方法很难找到远离 aspect 的意见单词。

1.1.2 Neural models considering syntax

句法信息可以使依赖性信息保留在冗长的句子中,并有助于缩短方面词和观点词之间的距离。最近的一些研究(Zhang 等人,2019;Huang 和 Carley,2019; Sun 等人,2019)利用基于图的模型来集成句子的句法结构,并且表现出更好的性能。

缺点:尽管上述方法取得了一定的效果,但其忽略语料库级别的单词共现信息 。对语法依赖的不同类型也没有加以区分 。

问题与动机

2.1 Task Definition

给定由n个单词和从第(a + 1)个位置开始、长度为m的方面组成的句子

2.2 Motivations

2.1.1 频繁出现的词对代表着语言学中的固定搭配。

例如,在句子“food was okay, nothing special”中,单词“nothing special”对在 SemEval 训练集中出现了 5 次,表示负极性。如果没有这样的全局信息来抵消“okay”的正面影响,基于语法的方法将对“food”做出错误的预测。

2.1.2 每种类型的句法依存关系都表示一种特定的关系 。

例如,在“i like hamburgers”中,“i like”是 nsubj(名词主语)关系,而“like hamburgers”是 dobj(直接宾语)关系。如果 nsubj 关系和 dobjs 关系得到同等对待,我们将无法区分动作“like”的主语和宾语。

2.3 Our solution

为了解决上述限制,我们提出了一种新颖的网络模型,用于有效地融合词对共现信息和句法依存信息。

我们建立了用于训练语料库的全局词汇图 ,和每个句子的局部层次句法图和局部层次词汇图 。

(1)全局词汇图是我们首次提出来 用于 ASC 任务:对语料库级别的单词共现信息进行编码,其中节点是单词,边表示训练语料库中两个单词节点之间的频率。

(2)我们还在局部句法图和词汇图上建立概念层次结构 ,以区分不同类型的依存关系或词对共现关系。

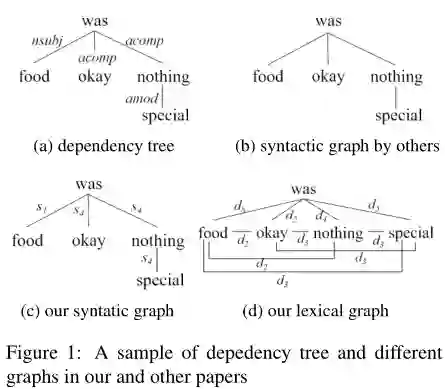

图1显示了一个带有其依赖关系树的示例句子,其它现有模型句法图,以及我们改进的局部层次句法图和独创的局部层次词汇图。

BiGCN - Architecture

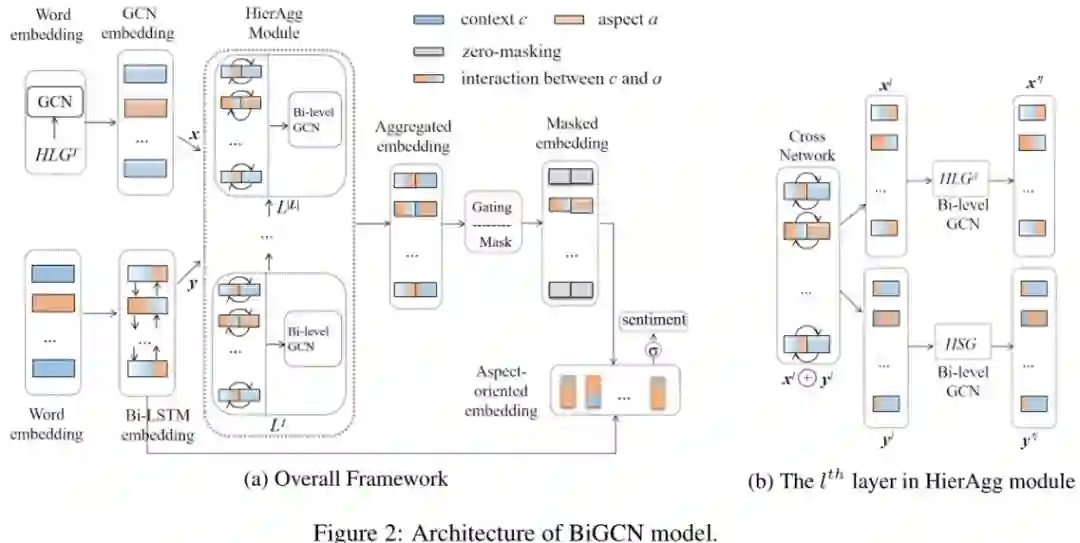

我们提出的 BiGCN 模型架构包含三个模块,如图 2 所示:

1)首先将全局词汇图和单词序列作为输入来获得初始句子表示。

2)随后引入 HiarAgg 模块,让局部层次词汇图和层次句法图交互以精化句子表示。

3)最后通过 mask 和门控机制获得面向方面的表示,以更好地预测句子中特定方面的情感极性。

3.1 Getting Initial Sentence Representation

我们提出了两种类型的文本表示形式改进句子的 embedding。一种是基于我们的全局词汇图的 GCN embedding;另一个是基于双向 LSTM 的 Bi-LSTM embedding。

首先,我们希望将语料库特有的词汇信息编码进句子的表示形式中。我们对全局词汇图执行 GCN,获得整个训练集的词汇嵌入矩阵。然后,通过该矩阵得到序列 S 的 GCN embedding,在图 2(a)中用 x 表示。

其次,更接近方面词的词汇可能会对判断其情感做出更大的贡献。我们计算从每个上下文词到相应方面词的绝对距离,并获得 S 的位置序列。S 中的每个单词都含有预训练单词 embedding 和位置 embedding。具有上述表示形式的句子 S 发送到 Bi-LSTM 层以获得 Bi-LSTM embedding,在图 2(a)中用 y 表示。

3.2 Refining Sentence Representation

以上述 GCN embedding 和 Bi-LSTM embedding 作为初始句子表示,我们进一步利用局部 层次词汇图 和层次句法图 以获得句子 S 的更好表示。基本思想是让这两个图在经过精心设计的 HierAgg 模块中深入交互。

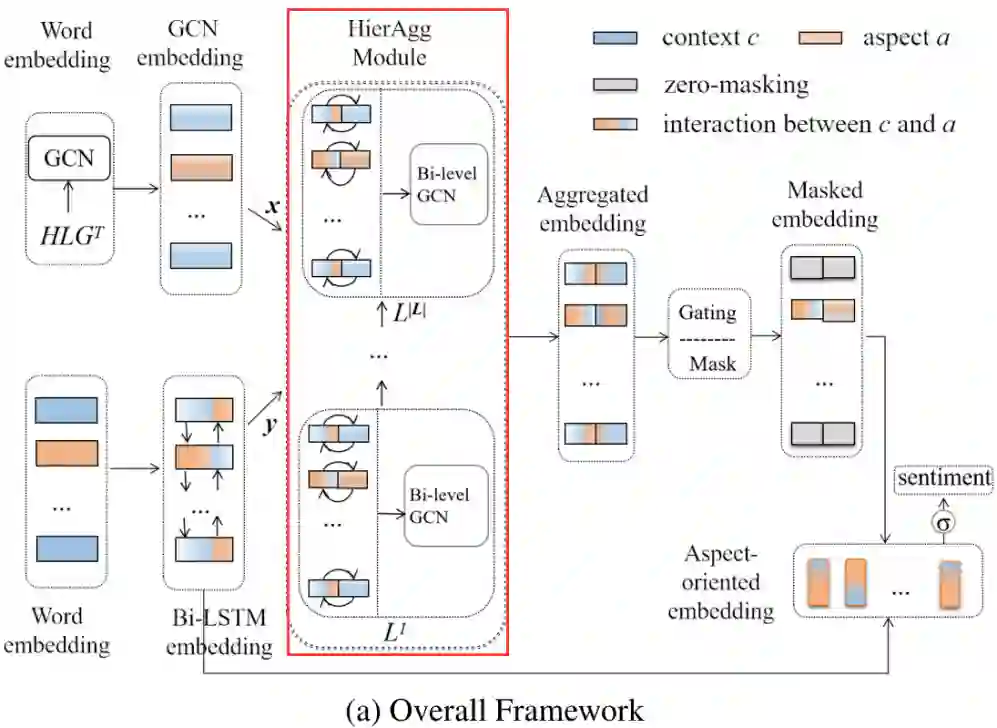

HierAgg 是一个多层结构,其中每层包括一个交叉网络以融合 GCN 和 Bi-LSTM embedding,以及一个双层 GCN 以在层次句法和局部层次词汇图上进行卷积。多层结构确保了在不同级别执行的不同类型信息的协作。本节详细介绍了 HierAgg 中的一层,如下图所示。

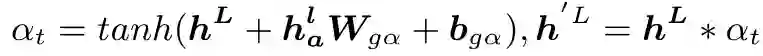

(1)Cross Network

为了深入融合 GCN embedding(x)和 Bi-LSTM embedding(y),我们采用了简单但有效的交叉网络结构。在跨网络的每一层中,我们使用以下公式更新融合的嵌入。每层中的融合嵌入将用作 Bi-level GCN 中两个图的输入节点表示。

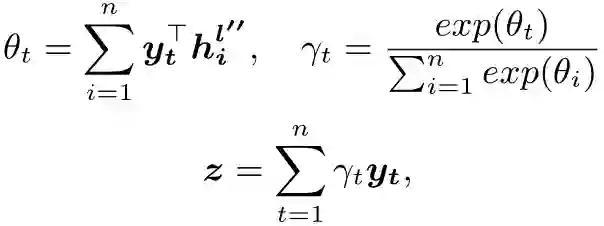

(2)Bi-level GCN

由于我们的局部句法图和词汇图包含概念层次结构,因此普通 GCN 无法在带有标记边的图上卷积。为了解决该问题,我们提出了一个用于合并不同关系类型的双层 GCN。给定一个带有两个图的句子,我们将使用两个聚合操作执行双层卷积。

第一次聚合(低级): 将具有相同关系类型的节点聚合到虚拟节点,然后在 GCN 中使用相同的归一化隐藏特征总和作为聚合函数来获取虚拟节点嵌入

。

第二次聚合(高级): 将所有虚拟节点及其特定关系聚合在一起。使用平均聚合函数针对不同关系类型(虚拟节点)更新目标词 t 的表示形式:

(3)Finally aggregated embedding

我们分别在局部层次词汇图和层次句法图上进行第一次和第二次聚合以获得精炼的句子表示形式,将其用作下一层的输入。

在 Hier-Agg 模块的最后一层中,我们将 x 和 y 组合在一起以形成聚集嵌入。

3.3 Generating Aspect-oriented Representation

为了更好地预测一个方面的情感极性,我们使用门控机制以过滤面向特定 aspect 的情感信息流:

接下来在门控嵌入 h 中对非方面词进行 mask,并使方面词保持不变,并且得到 zero-mask 的嵌入:

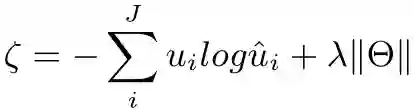

最后,我们检索与方面单词在语义上相关的重要特征,并使用自注意力机制为每个上下文单词设置基于检索的注意力权重,将其加权求和之后即可获得面向方面的句子表示 z。

3.4 Model Training

我们将上述 z 输入一个全连接层和一个 softmax 层,得到样本句 s 的预测值:

模型的训练目标为最小化所有训练样本的交叉熵损失,我们采用标准梯度下降算法训练模型:

实验与分析

4.1 Datasets

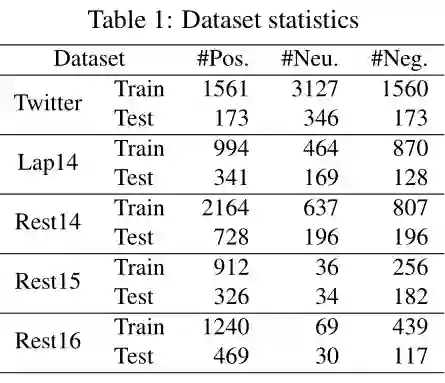

我们在五个基准数据集上评估了我们提出的模型。一种是 Twitter 数据集。它由推特帖子组成。其他四个数据集(Lap14,Rest14,Rest15,Rest16)全部来自 SemEval 任务,其中包含有关笔记本电脑和餐厅的评论,其统计信息如下表 1 所示。

4.2 Result

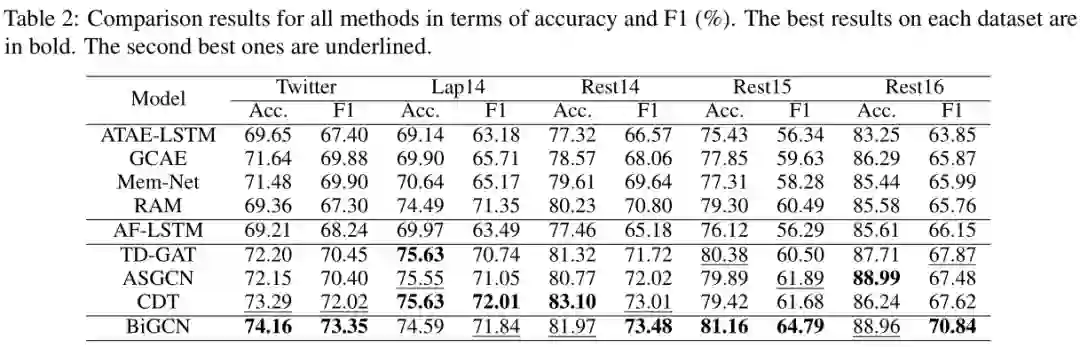

我们与八种最经典或性能最好的方法进行了比较,其中前四种方法是具有典型神经结构(如注意力,LSTM,CNN,memory 和 RNN)的模型,中间的 AF-LSTM 则利用单词共现信息(但是没有表示成图结构),其余三种方法是基于图和语法关系集成的。

我们采用 Accuracy 和 Macro-F1 作为评估指标,其结果是对随机初始化的三次运行结果求平均值。所有方法的比较结果显示在表 2 中。由表 2 可知,我们提出的 BiGCN 模型在所有数据集上的 Macro-F1 得分均达到了最佳结果。

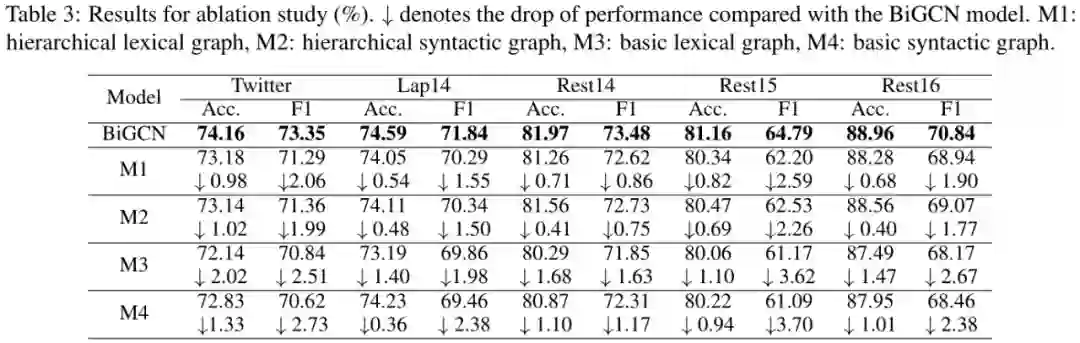

4.3 Ablation Study

为了检查 BiGCN 模型中每个组件的影响,我们进行了一项分离实验,并将结果显示在表 3 中。我们首先研究局部层次词汇(M1)和句法图(M2)的影响。然后,我们进一步从 M1 和 M2 中删除关系类型来显示概念层次结构的影响,从而得到基本的词汇(M3)和句法图(M4)。表 3 的结果清楚地证明了我们提出的概念层次和词汇图的有效性。

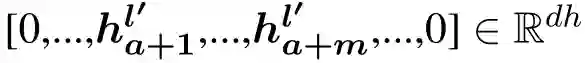

4.4 Case Study

为了更好地了解 BiGCN 的工作原理,我们通过三个测试示例对几种方法进行了对比,如下图所示。BiGCN 对三个句子都能作出正确的判断,其它方法则或对或错。其中:

由于缺少语法和词汇共现信息,RAM 对所有三个句子都做出错误的判断。

由于相同的原因,AF-LSTM 在第一和第二句话中也会做出错误的预测。

对于第三个句子,集成了语法的方法 TD-GAT,ASGCN 和 CDT 过于依赖解析的结果,将“great” 和 “pad”, “needed” 和 “feature”联系到一起,从而做出了错误的判断。相反地,AF-LSTM 和我们的 BiGCN 通过利用单词共现信息,能够正确地预测 cooling pad 的情感极性。

结论

本文为方面级情感分析任务提出了一种结合层次句法和词汇图的新型网络结构。其主要贡献在于首次使用词汇图来捕获全局单词共现信息,其次,在局部词汇和句法图上建立概念层次,用于区分不同类型的依存关系或词对共现关系的独特贡献;最后设计了一个深度融合模块,使得局部层次词汇图和句法图能够更好地协同工作。大量实验表明本文方法达到了 SOTA 的性能。

如何才能让更多的优质内容以更短路径到达读者群体,缩短读者寻找优质内容的成本呢?答案就是:你不认识的人。

总有一些你不认识的人,知道你想知道的东西。PaperWeekly 或许可以成为一座桥梁,促使不同背景、不同方向的学者和学术灵感相互碰撞,迸发出更多的可能性。

PaperWeekly 鼓励高校实验室或个人,在我们的平台上分享各类优质内容,可以是最新论文解读 ,也可以是学习心得 或技术干货 。我们的目的只有一个,让知识真正流动起来。

📝 来稿标准:

• 稿件确系个人原创作品 ,来稿需注明作者个人信息(姓名+学校/工作单位+学历/职位+研究方向)

• 如果文章并非首发,请在投稿时提醒并附上所有已发布链接

• PaperWeekly 默认每篇文章都是首发,均会添加“原创”标志

📬 投稿邮箱:

• 投稿邮箱: hr@paperweekly.site

• 所有文章配图,请单独在附件中发送

• 请留下即时联系方式(微信或手机),以便我们在编辑发布时和作者沟通

🔍

现在,在「知乎」 也能找到我们了

进入知乎首页搜索「PaperWeekly」

点击「关注」 订阅我们的专栏吧

关于PaperWeekly

PaperWeekly 是一个推荐、解读、讨论、报道人工智能前沿论文成果的学术平台。如果你研究或从事 AI 领域,欢迎在公众号后台点击「交流群」 ,小助手将把你带入 PaperWeekly 的交流群里。