《即时战略游戏和工业应用的安全深度强化学习》2022最新博士论文

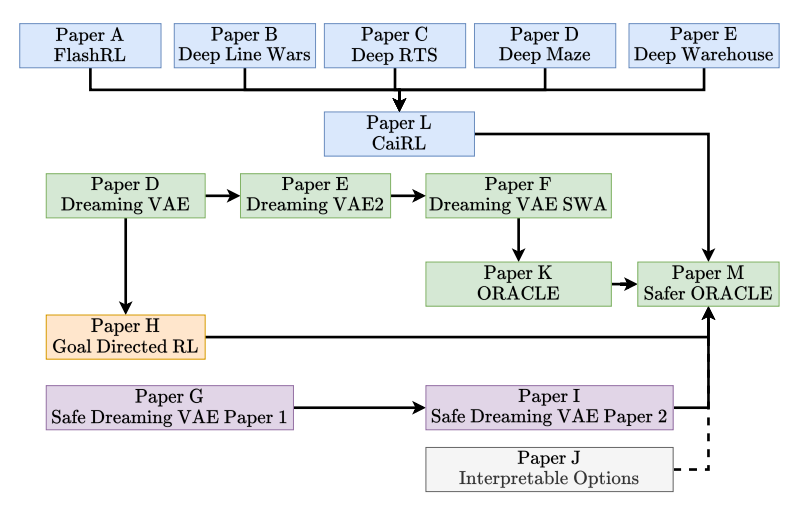

论文大纲

便捷下载,请关注专知人工智能公众号(点击上方蓝色专知关注)

后台回复“RTS” 就可以获取《《即时战略游戏和工业应用的安全深度强化学习》2022最新博士论文》专知下载链接

登录查看更多

相关内容

RTS:Real-Time Systems。

Explanation:实时系统。

Publisher:Springer。

SIT:http://dblp.uni-trier.de/db/journals/rts/

Arxiv

0+阅读 · 2022年11月20日

Arxiv

40+阅读 · 2021年9月15日