傻瓜式无限P图,MIT朱俊彦团队“重写”深度生成模型

作者 | 陈大鑫

编辑 | 丛末

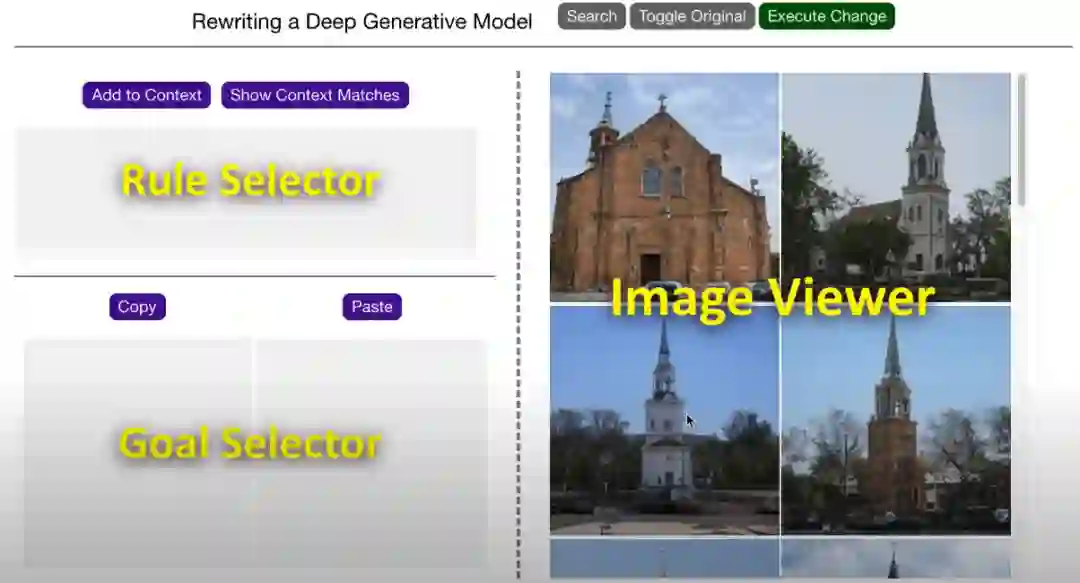

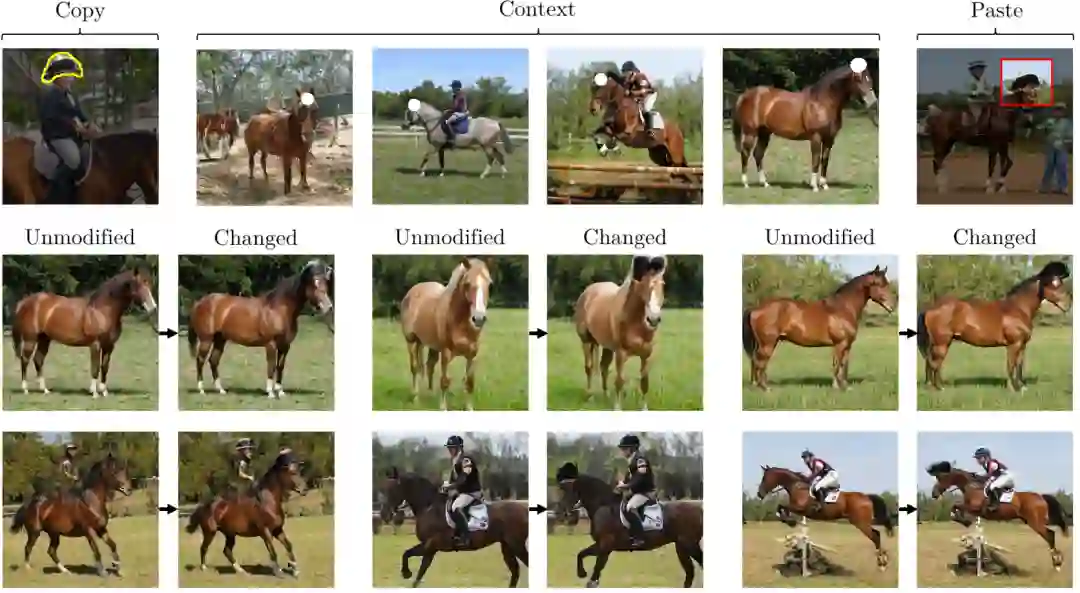

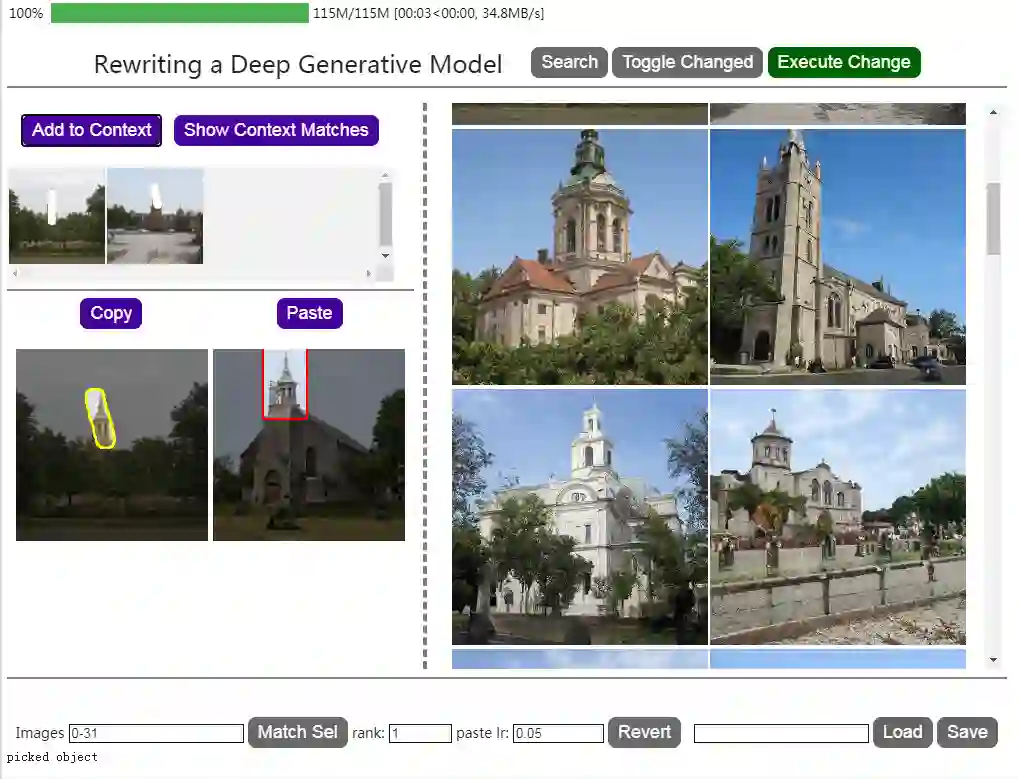

把刚才选择的图像加入context区域:

把刚才选择的图像加入context区域:

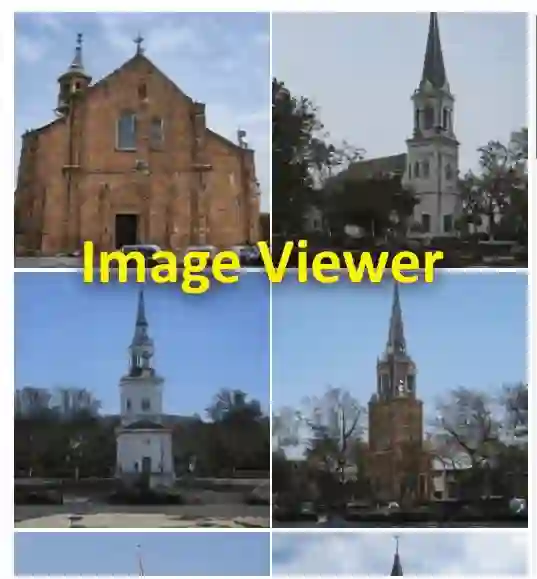

可以显示刚才选择过的图片,再点击一次则可取消显示:

可以显示刚才选择过的图片,再点击一次则可取消显示:

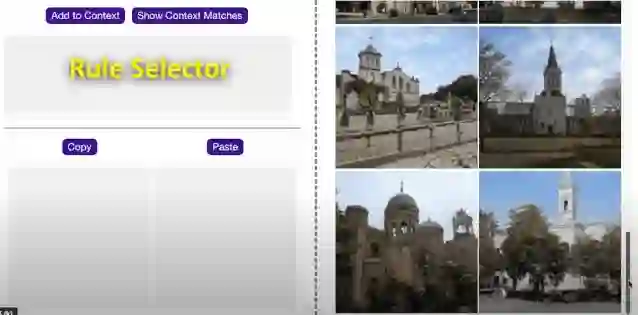

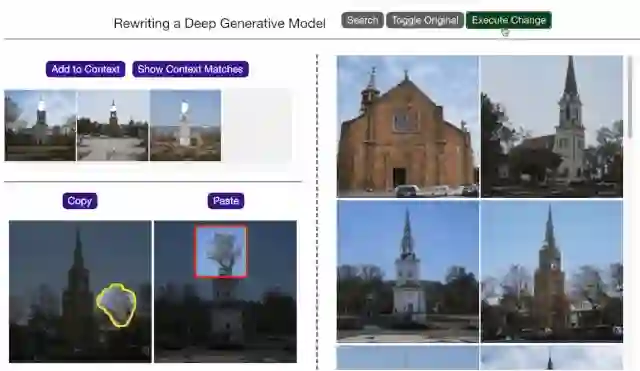

,这样一棵树的模型规则就被复制了:

,这样一棵树的模型规则就被复制了:

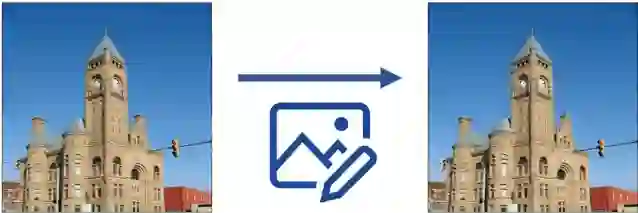

进行粘贴,可以看出塔尖已经被替换成了树:

进行粘贴,可以看出塔尖已经被替换成了树:

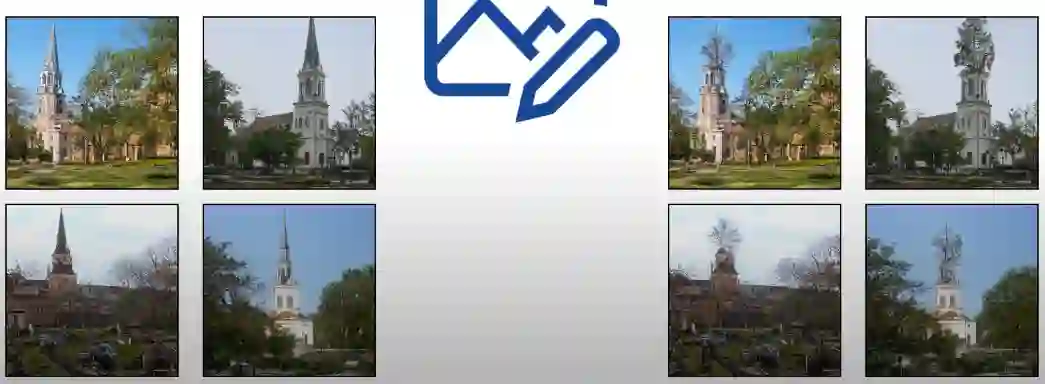

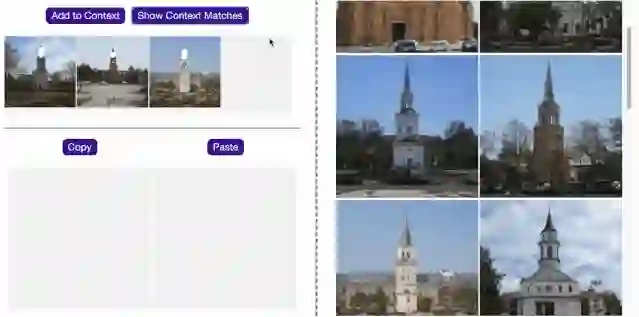

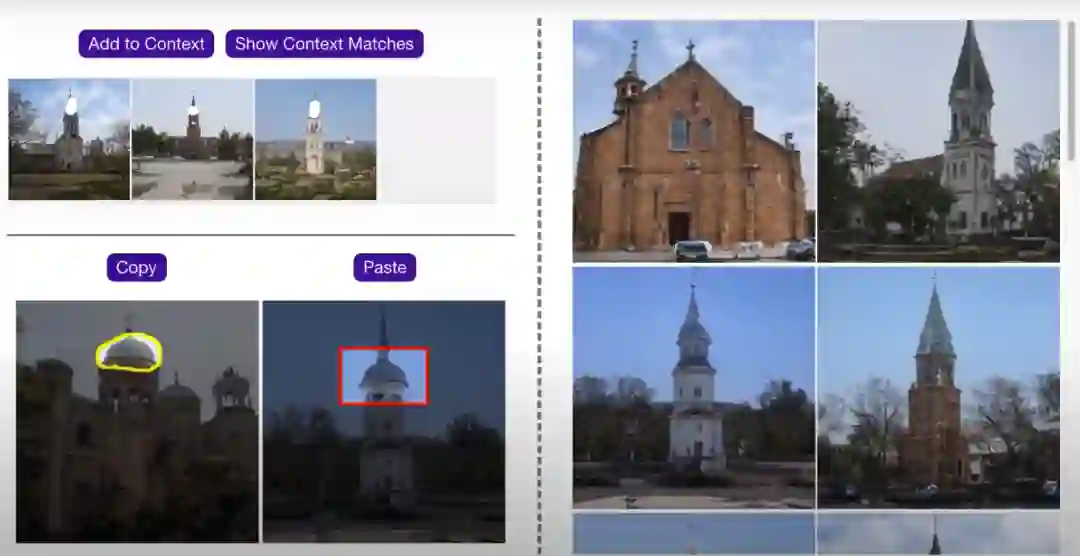

,就可以把“树”的模型规则粘贴到之前选择到context区域的三张图片上面了:

,就可以把“树”的模型规则粘贴到之前选择到context区域的三张图片上面了:

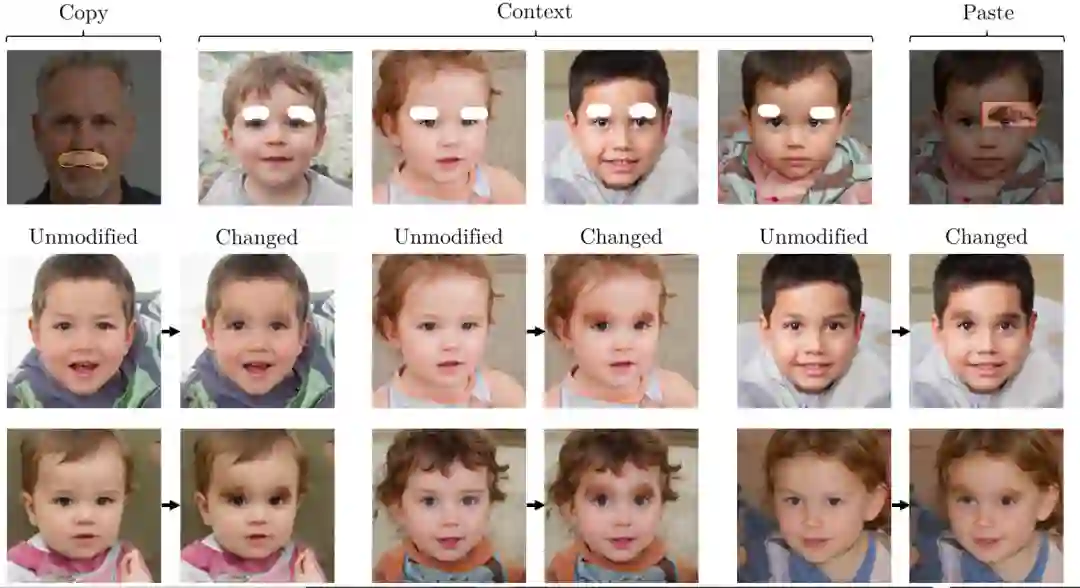

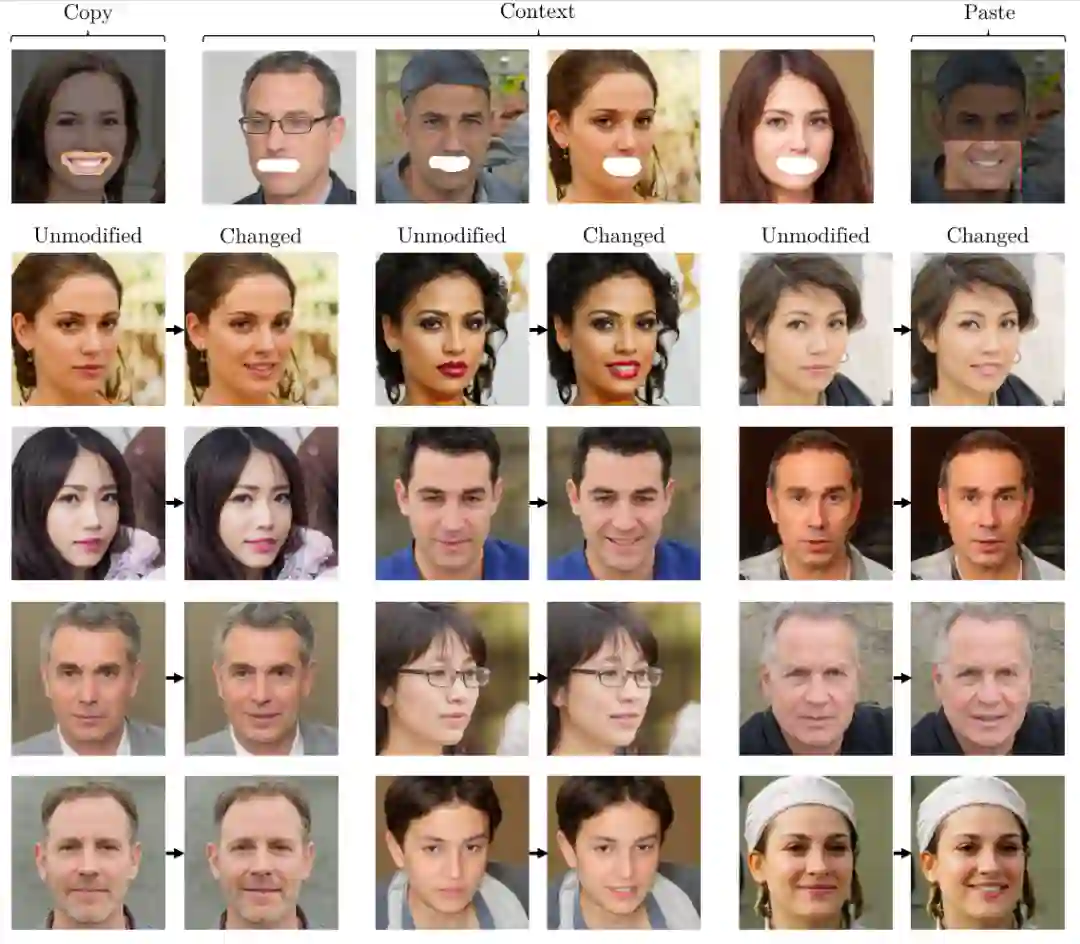

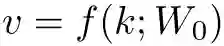

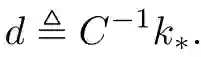

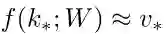

,该插槽对应于由固定的全局键值统计和规则的上下文(key)确定的秩1(rank-one)更新的特定子空间对应的插槽中的权重,而不只是某个数值。

,该插槽对应于由固定的全局键值统计和规则的上下文(key)确定的秩1(rank-one)更新的特定子空间对应的插槽中的权重,而不只是某个数值。

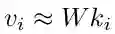

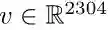

,

权重为

,

权重为

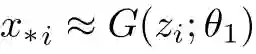

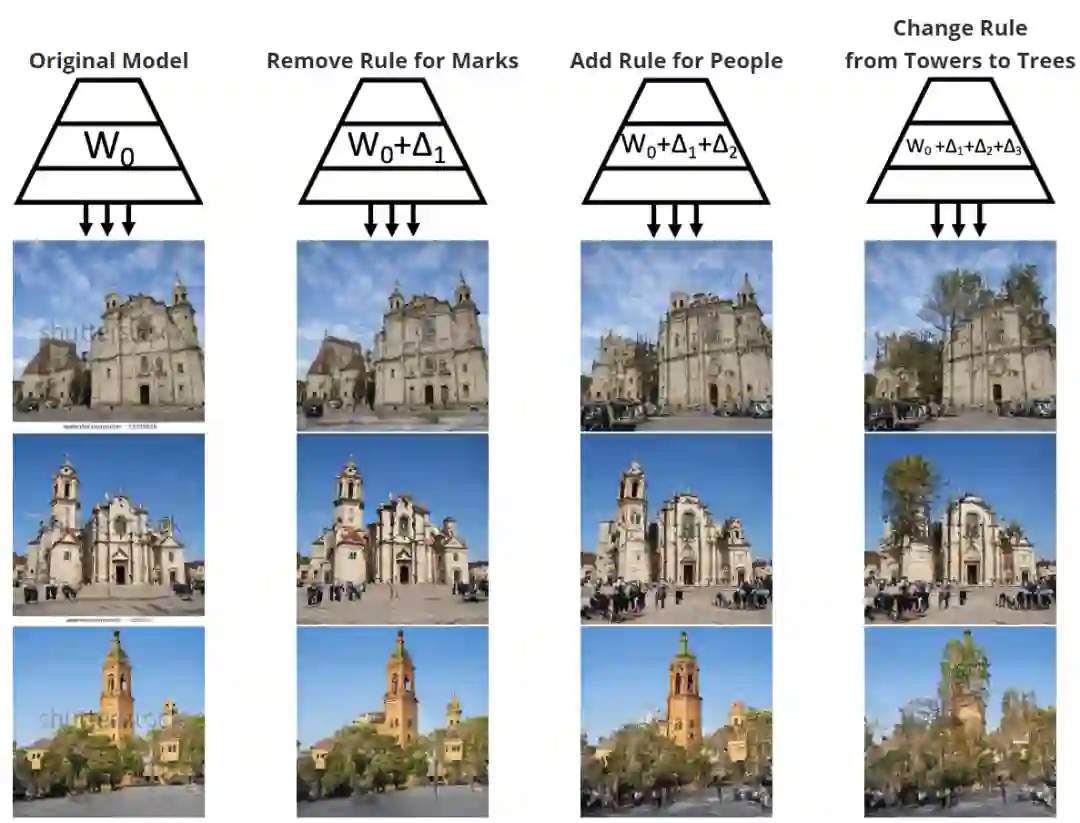

,我们可以合成多个图像

,我们可以合成多个图像

,其中每个图像由一个潜在编码

,其中每个图像由一个潜在编码

生成。假设我们已经为这些情况手动创建了所需更改的

生成。假设我们已经为这些情况手动创建了所需更改的

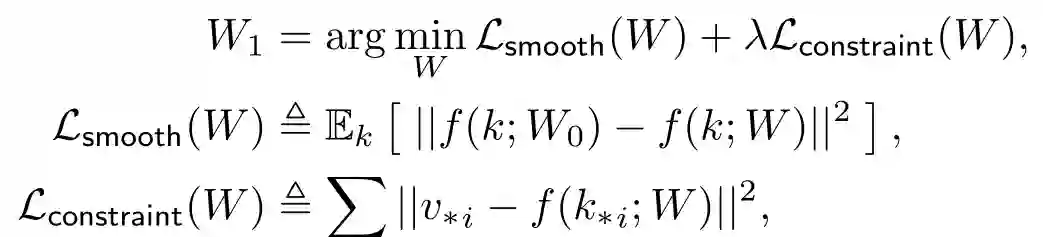

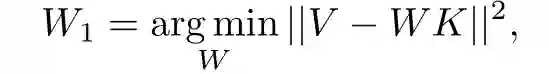

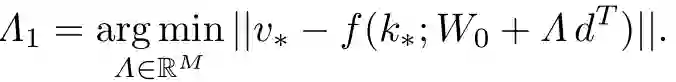

。我们希望找到更新后的权重

。我们希望找到更新后的权重

,它能改变计算规则以匹配我们的目标示例

,它能改变计算规则以匹配我们的目标示例

,同时最小化对其他行为的干扰:

,同时最小化对其他行为的干扰:

是度量图像之间感知距离的距离度量。

是度量图像之间感知距离的距离度量。

-

通过在一个特定层修改权重W来减少自由度,而不是修改所有的θ。 -

对于目标函数,直接在同一层的输出特征空间中最小化损失距离。

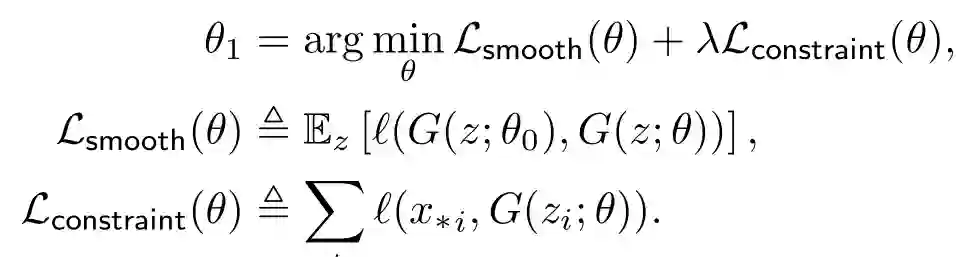

表示层L本身的计算,预训练权重是

表示层L本身的计算,预训练权重是

。对于每个潜在样本

。对于每个潜在样本

,这些层产生特征

,这些层产生特征

和

和

。现在假设对于每个目标示例

。现在假设对于每个目标示例

,用户手动创建了一个特性更改

,用户手动创建了一个特性更改

。

。

表示L2损失,即使在一个层中,权重W也包含很多参数。但是,自由度可以进一步减小,以将变化约束到我们将导出的特定方向;这个额外的方向约束将允许我们从单个

表示L2损失,即使在一个层中,权重W也包含很多参数。但是,自由度可以进一步减小,以将变化约束到我们将导出的特定方向;这个额外的方向约束将允许我们从单个

例子中创建一个广义的变化。为了理解这种限制,将单个卷积层解释为联想存储器是很有帮助的,下面简要回顾一下这一经典概念。

例子中创建一个广义的变化。为了理解这种限制,将单个卷积层解释为联想存储器是很有帮助的,下面简要回顾一下这一经典概念。

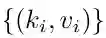

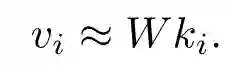

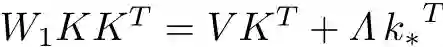

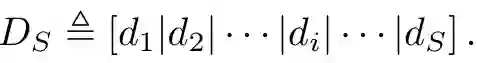

,这些键值对可以通过矩阵乘法来检索:

,这些键值对可以通过矩阵乘法来检索:

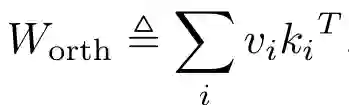

形成一组相互正交的单位范数向量,那么无误差内存可以创建为

形成一组相互正交的单位范数向量,那么无误差内存可以创建为

。

。

时,由于

时,由于

,当乘以

,当乘以

时,所有不相关的项都会被消除,就会得到

时,所有不相关的项都会被消除,就会得到

。

。

与前面所有键正交,就可以通过向矩阵中添加

与前面所有键正交,就可以通过向矩阵中添加

来存储新值。

N×M矩阵可以用来存储N×N的关联。

来存储新值。

N×M矩阵可以用来存储N×N的关联。

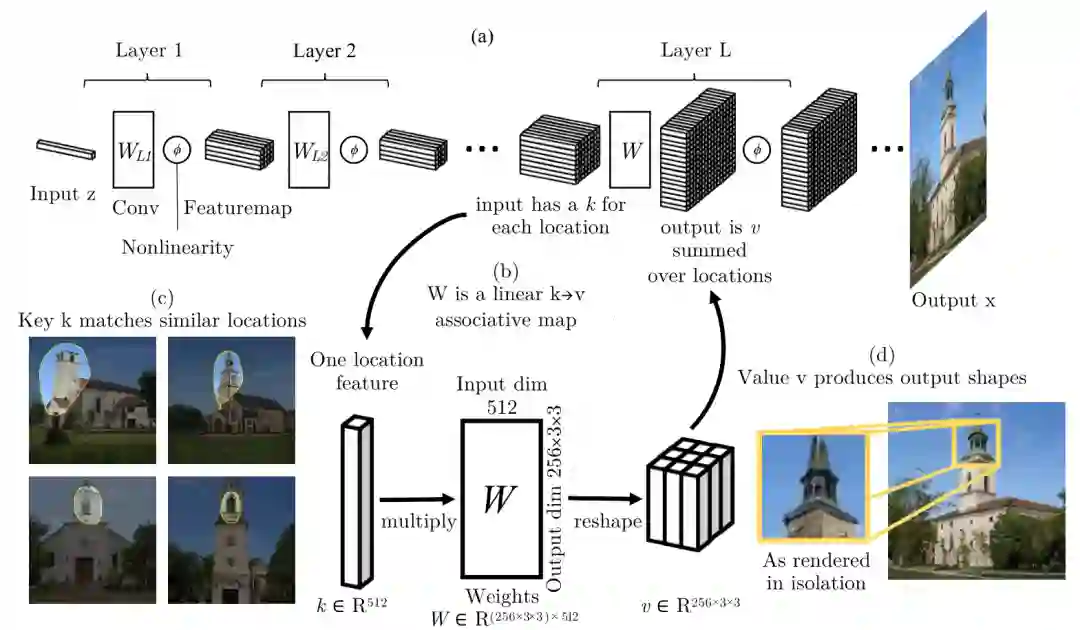

,我们的层将调用一个值

,我们的层将调用一个值

来表示256个通道特征的3×3输出模式,之后平摊到一个向量,如

来表示256个通道特征的3×3输出模式,之后平摊到一个向量,如

。我们将层解释为联想记忆并没有改变计算:张量被简单地重塑并处理为一个稠密的矩阵

。我们将层解释为联想记忆并没有改变计算:张量被简单地重塑并处理为一个稠密的矩阵

,其任务是通过

,其任务是通过

将key(键) 映射到value(值)

将key(键) 映射到value(值)

。

。

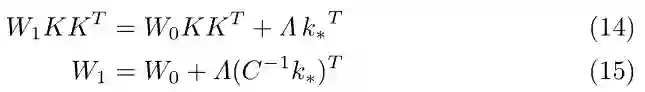

? 假定一个新的

? 假定一个新的

,现在希望覆盖一个新的键值,经修改后,新矩阵

,现在希望覆盖一个新的键值,经修改后,新矩阵

应满足两个条件:

应满足两个条件:

来解决。

来解决。

是一个秩为

1的矩阵,每行都是向量

是一个秩为

1的矩阵,每行都是向量

的倍数。

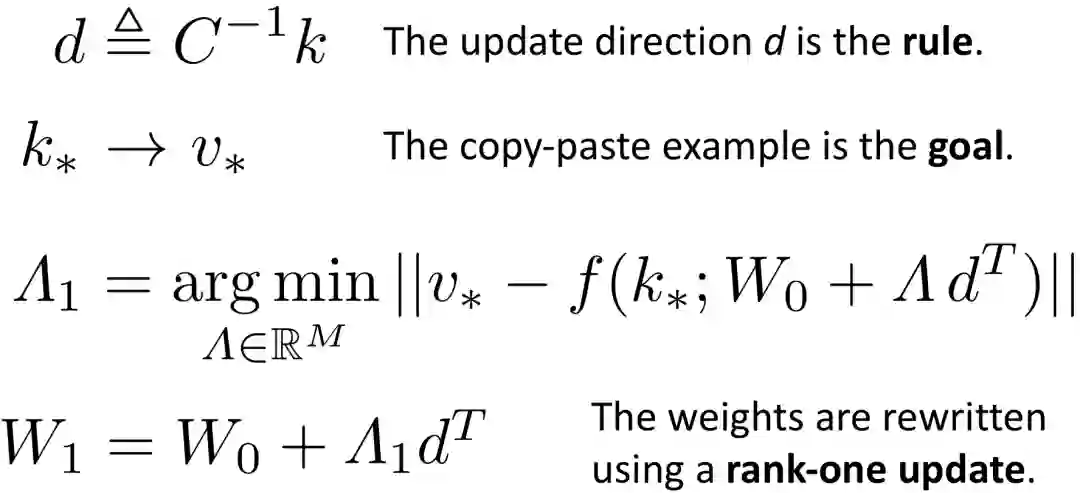

等式15揭示了更新方向只由总体键值统计信息和特定的目标密钥

的倍数。

等式15揭示了更新方向只由总体键值统计信息和特定的目标密钥

决定。协方差C是一个可以预先计算和缓存的模型常数,更新方向由键决定,而不管存储的值是什么。∧规定了每一行变化的幅度,取决于目标值

决定。协方差C是一个可以预先计算和缓存的模型常数,更新方向由键决定,而不管存储的值是什么。∧规定了每一行变化的幅度,取决于目标值

。

。

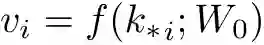

然后假设有一个非线性神经层

然后假设有一个非线性神经层

,它遵循线性运算W,并附加了非线性步骤。

因为等式15对W的行空间敏感,

对列空间不敏感,我们可以用相同的更新形式来约束

,它遵循线性运算W,并附加了非线性步骤。

因为等式15对W的行空间敏感,

对列空间不敏感,我们可以用相同的更新形式来约束

的优化。

的优化。

来更新层权重,通过减少

来更新层权重,通过减少

的秩,可以产生更具体的变化。

的秩,可以产生更具体的变化。

。

。

-

深入了解深度网络如何组织其知识。 -

为了使富有创造力的用户能够快速创建没有现有数据集的新颖模型。

登录查看更多

相关内容

Arxiv

3+阅读 · 2018年8月20日