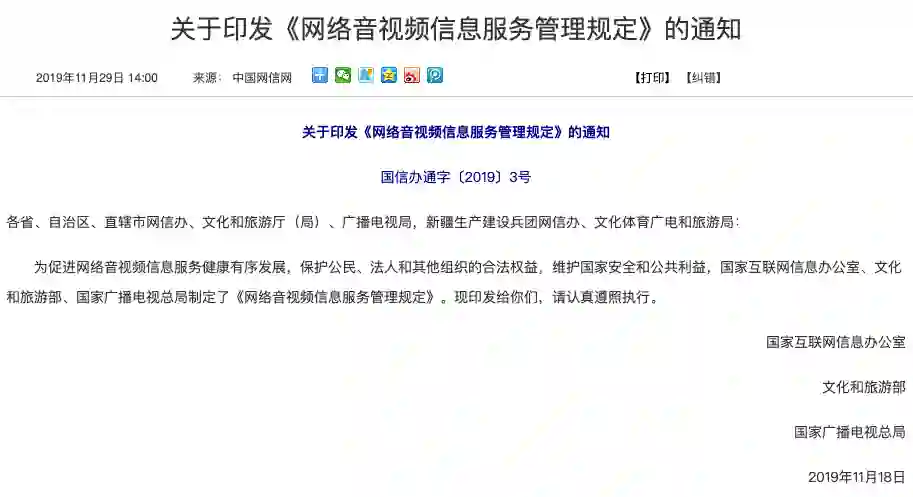

「资讯」AI造假泛滥,首部法规即将出台!

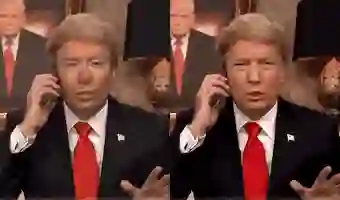

色情、假新闻、诈骗,Deepfake引发的全球恐慌

道德、技术、法律,能否圈出技术的边界?

//

DJI Mavic Mini 上手体验

跟随王自如来一场欧洲新能源之旅

登录查看更多

相关内容

Arxiv

6+阅读 · 2017年12月27日