WWW 2020 | 信息检索中的对话式问题建议

©PaperWeekly 原创 · 作者|金金

单位|阿里巴巴研究实习生

研究方向|推荐系统

论文标题:

Leading Conversational Search by Suggesting Useful Questions

论文来源:

WWW 2020

论文链接:

https://www.microsoft.com/en-us/research/uploads/prod/2020/01/webconf-2020-camera-rosset-et-al.pdf

简介

本文由微软 AI 研究院发表于 WWW 2020,当前对话式搜索引擎主要存在两个挑战:1. 用户仍然习惯使用查询词而并非自然语言进行搜索;2. 搜索引擎的能力需要超出仅解决当前查询的问题。

本文提出了对话式问题建议(Conversatioal question suggestion)这一新的方式,帮助用户通过更接近于对话式检索的方式,获得更好的搜索体验。

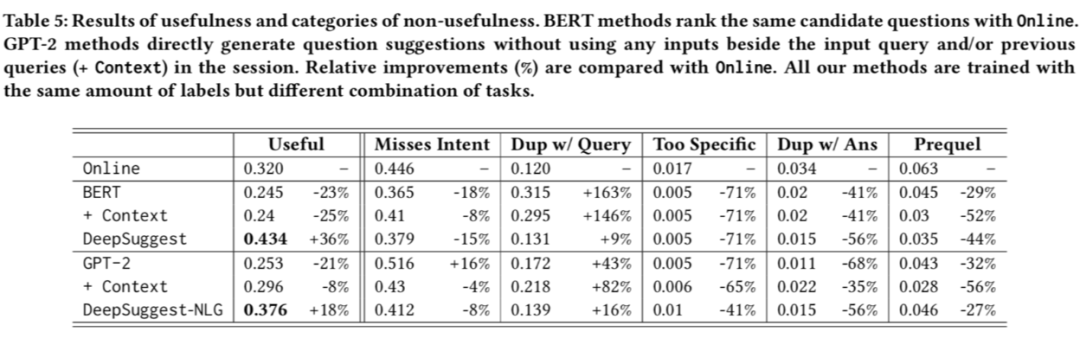

从相关性到有用性

Misses Intent:该问题完全和主题不符,或者不是用准确的自然语言进行表达。

Too Specific:问题过于具体,导致能覆盖的人群较少。

Prequel:问题的答案是用户已知的内容。

Duplicate with Query:提问和查询完全重复。

-

Duplicate with Answer:提问可以被当前查询中所显示的结果解答。

问题推荐框架

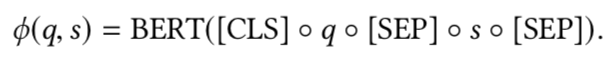

二者均在以下四个任务上完成训练:

-

相关性分类:该任务针对一个具体的“查询-问题对”判断它们是否相关,是一个二分类问题。 -

相关点击率预测:该任务抽取了同一查询下,两个具有点击率显著差异的问题(30%以上),目标是模型能准确预测出点击率更高的问题。 -

点击预测:该任务针对一个具体的“查询-问题对”,判断在显示该查询的情况下,该问题是否会被点击,是一个二分类问题。该任务可以被认为是该模型的主任务。 -

用户搜索轨迹模拟:该部分首先抽取出一些真实搜索引擎中的会话,并借助下一查询预测任务,使得我们的模型预测下一查询中的用户意图。具体来说 GPT-2 模型直接根据之前的查询生成下一查询,而 BERT 模型则对最可能出现的模型进行排序筛选。

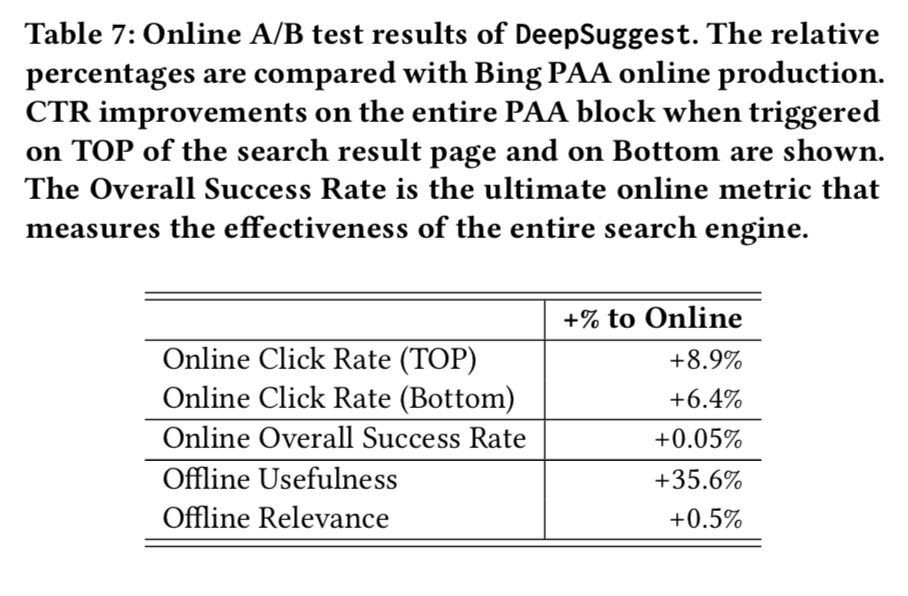

实验

本文首先提出了对话式问题建议(Conversatioal question suggestion)这一新的方式,帮助用户获得更好的搜索体验。本文此后提出了更加合理的评价指标 usefulness 替代 relevance,以衡量建议问题的性能。

更多阅读

#投 稿 通 道#

让你的论文被更多人看到

如何才能让更多的优质内容以更短路径到达读者群体,缩短读者寻找优质内容的成本呢?答案就是:你不认识的人。

总有一些你不认识的人,知道你想知道的东西。PaperWeekly 或许可以成为一座桥梁,促使不同背景、不同方向的学者和学术灵感相互碰撞,迸发出更多的可能性。

PaperWeekly 鼓励高校实验室或个人,在我们的平台上分享各类优质内容,可以是最新论文解读,也可以是学习心得或技术干货。我们的目的只有一个,让知识真正流动起来。

📝 来稿标准:

• 稿件确系个人原创作品,来稿需注明作者个人信息(姓名+学校/工作单位+学历/职位+研究方向)

• 如果文章并非首发,请在投稿时提醒并附上所有已发布链接

• PaperWeekly 默认每篇文章都是首发,均会添加“原创”标志

📬 投稿邮箱:

• 投稿邮箱:hr@paperweekly.site

• 所有文章配图,请单独在附件中发送

• 请留下即时联系方式(微信或手机),以便我们在编辑发布时和作者沟通

🔍

现在,在「知乎」也能找到我们了

进入知乎首页搜索「PaperWeekly」

点击「关注」订阅我们的专栏吧

关于PaperWeekly

PaperWeekly 是一个推荐、解读、讨论、报道人工智能前沿论文成果的学术平台。如果你研究或从事 AI 领域,欢迎在公众号后台点击「交流群」,小助手将把你带入 PaperWeekly 的交流群里。