本周NLP、CV、机器学习论文精选推荐

在碎片化阅读充斥眼球的时代,越来越少的人会去关注每篇论文背后的探索和思考。

在这个栏目里,你会快速 get 每篇精选论文的亮点和痛点,时刻紧跟 AI 前沿成果。

点击本文底部的「阅读原文」即刻加入社区,查看更多最新论文推荐。

@paperweekly 推荐

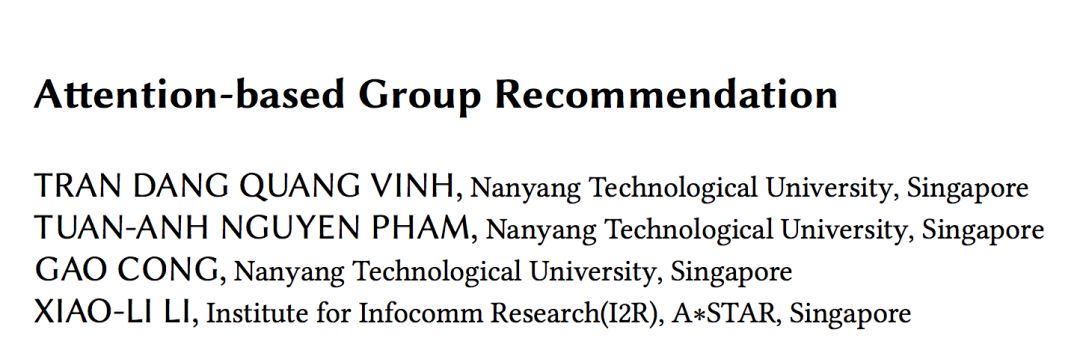

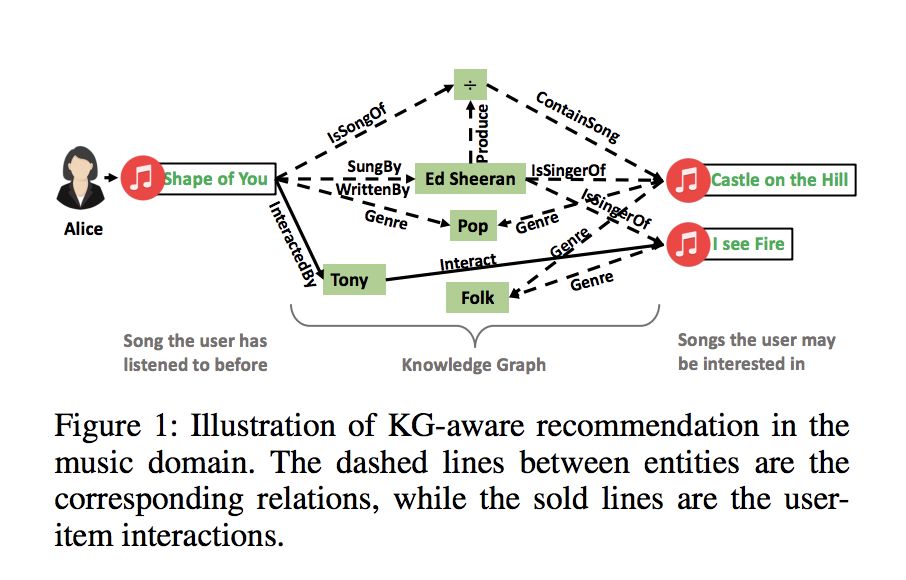

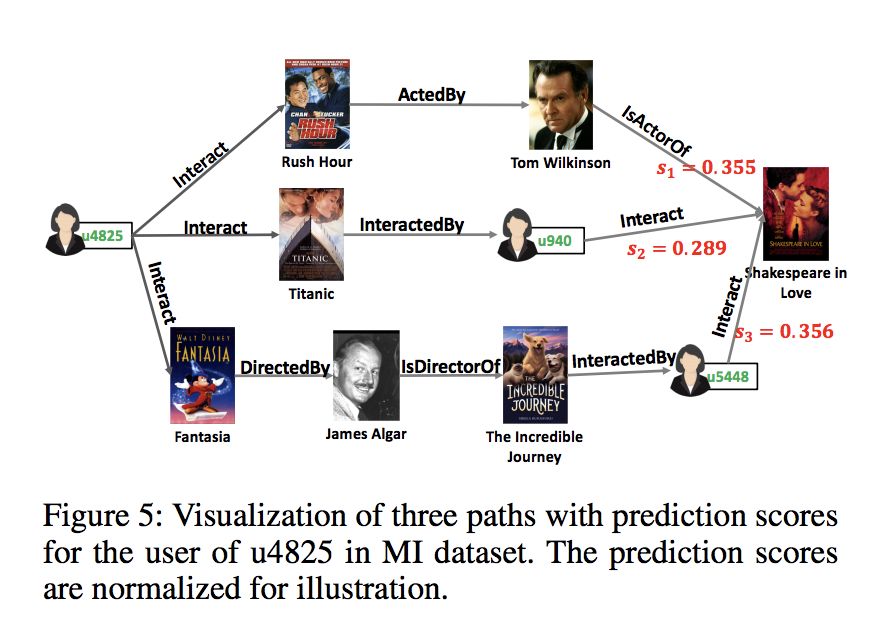

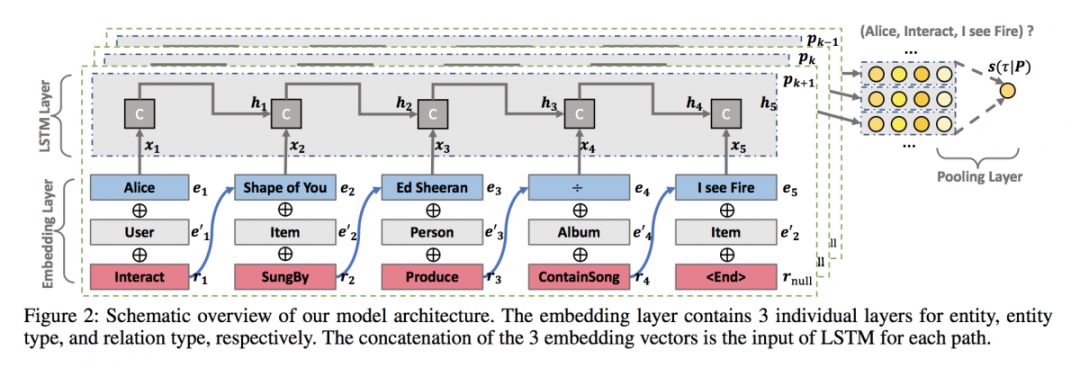

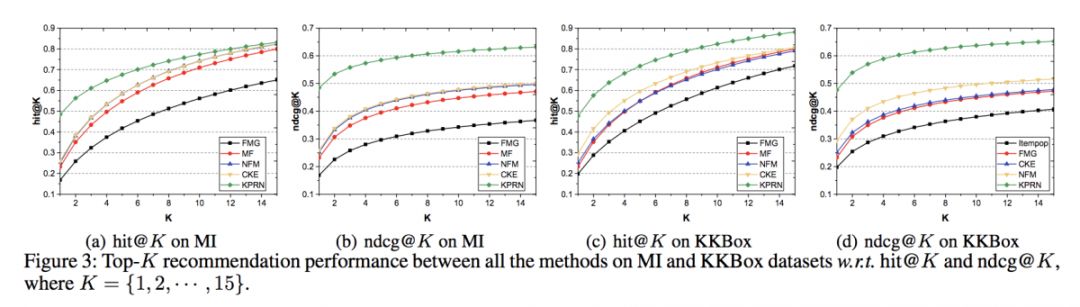

#Knowledge Graph

本文是新加坡国立大学和 eBay 发表于 AAAI 2019 的工作,论文提出了一种基于循环神经网络的推荐模型,对用户和物品之间的交互特征在知识图谱中存在的关联路径进行建模,为用户提供可解释性推荐。

该模型基于 LSTM 学习关联路径的表示,充分考虑了实体、关系间产生的序列依赖性,具备较强的推理能力。实验表明,本文模型在电影数据集 MI 和音乐数据集 KKBox 上取得了当前最优结果。

▲ 论文模型:点击查看大图

@zkt18 推荐

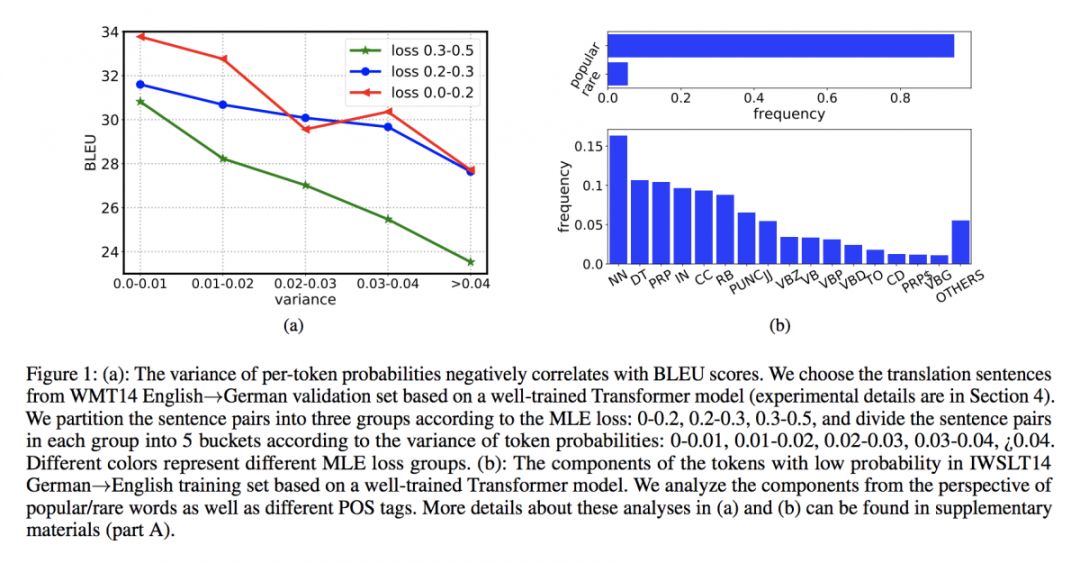

#Sequence to Sequence Learning

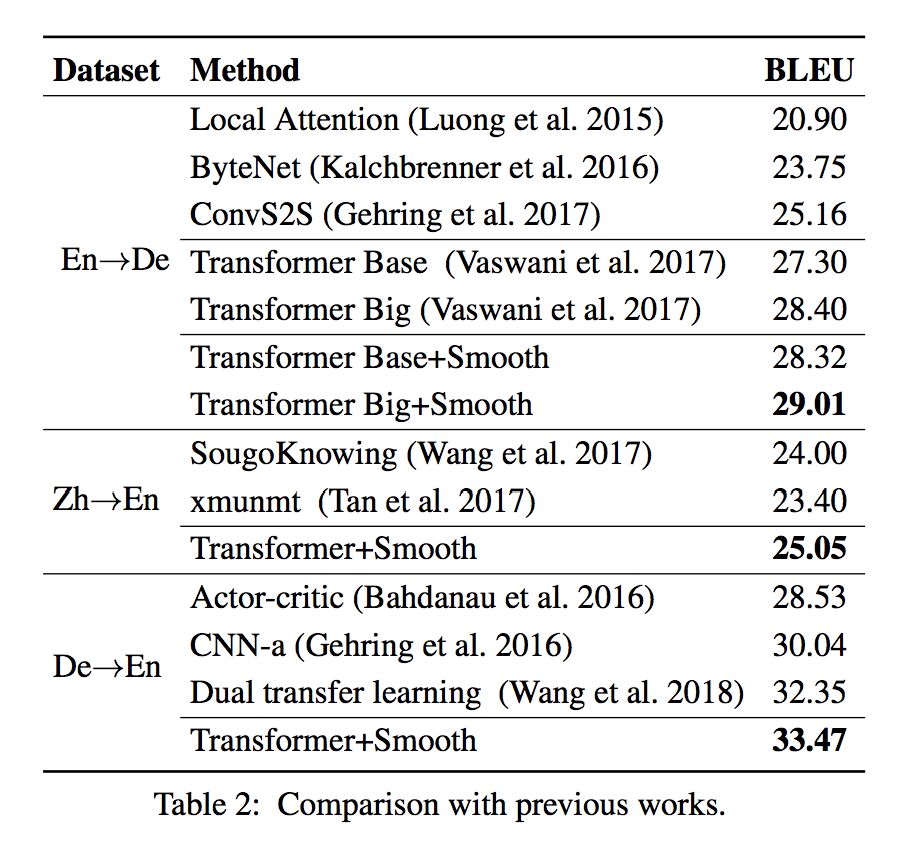

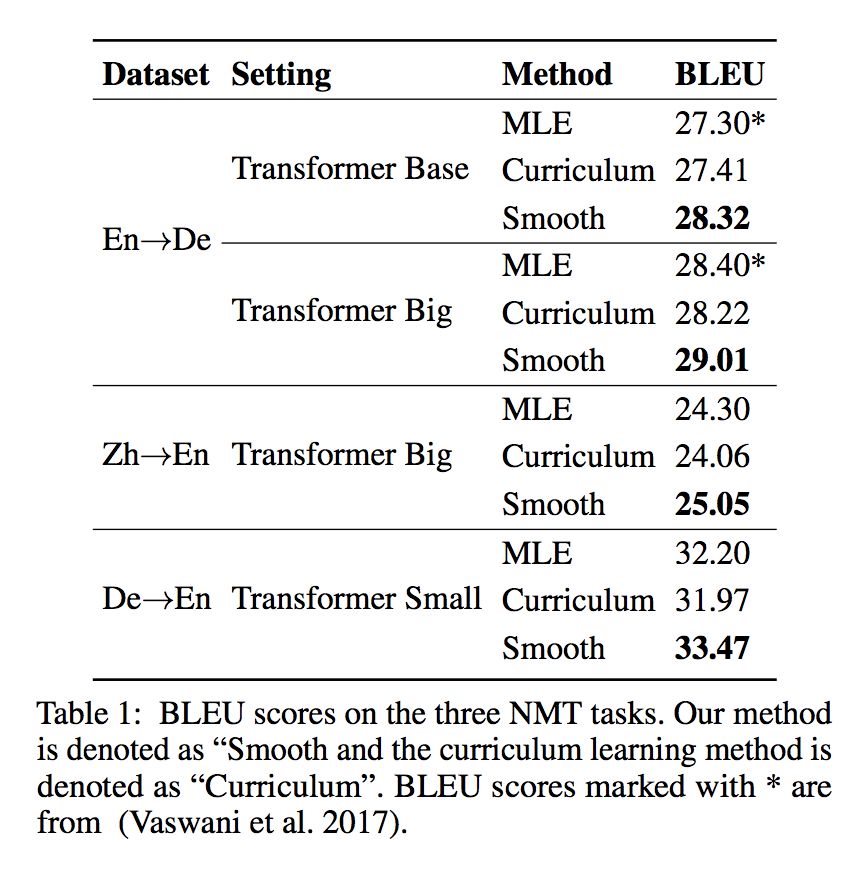

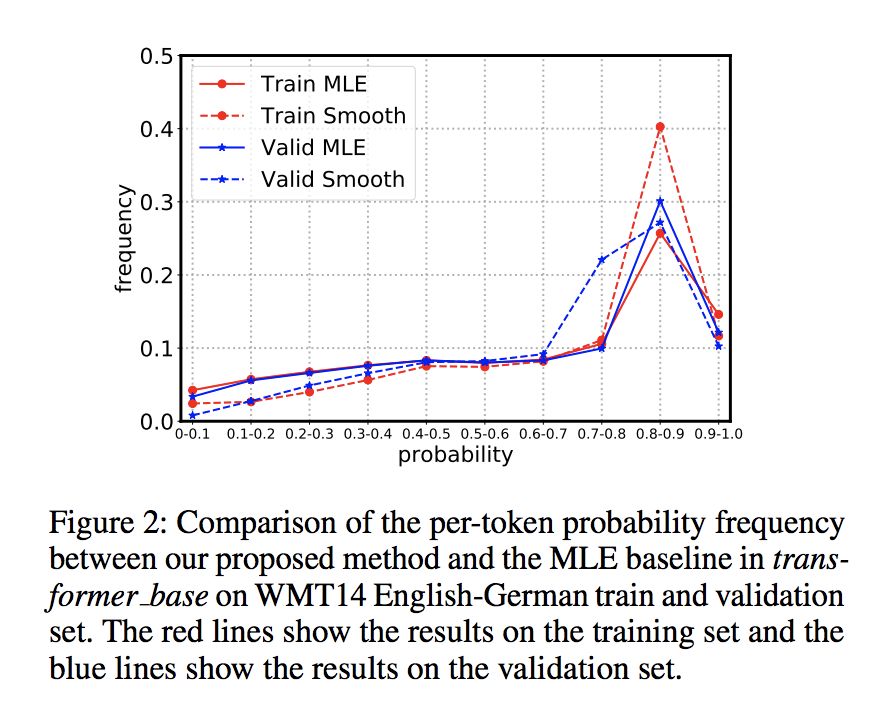

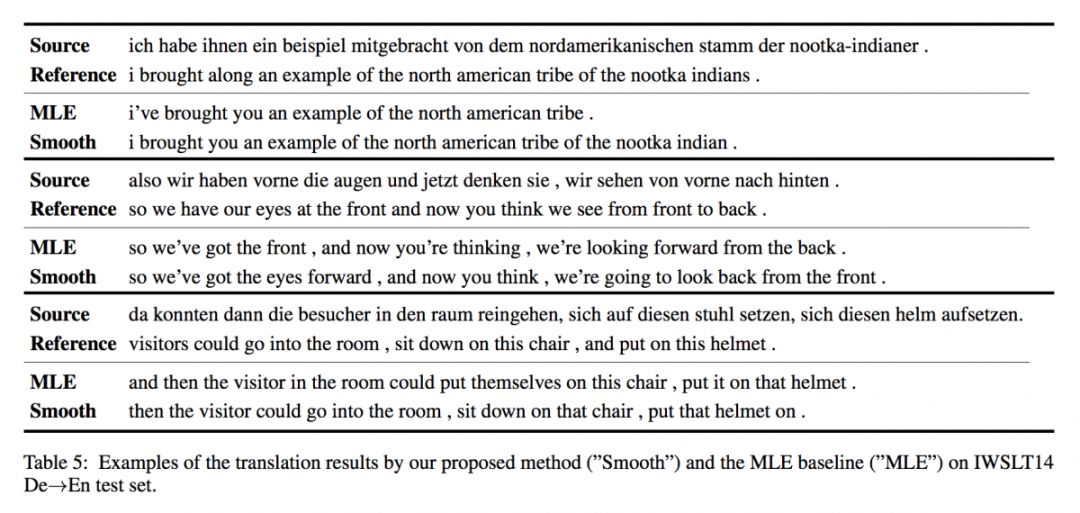

本文是北京大学和微软发表于 AAAI 2019 的工作。最大似然估计常被用作评估 Seq2Seq 生成序列的效果,根据实证研究,作者认为非平滑方法往往效果较差。

本文提出了一种句子正则化方法,为目标序列中的所有 token 输出平滑的预测概率。在三个神经机器翻译任务和一个文本摘要任务上的实验表明,本文效果超出传统MLE,每个token概率越平滑,BLEU分数越高。

▲ 论文模型:点击查看大图

@zkt18 推荐

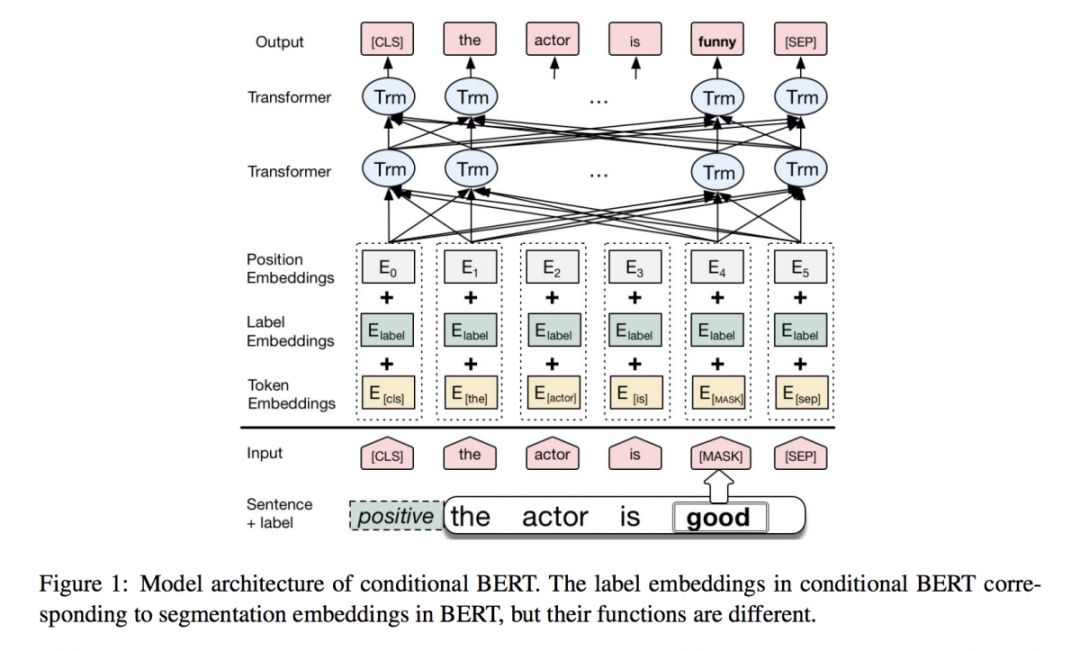

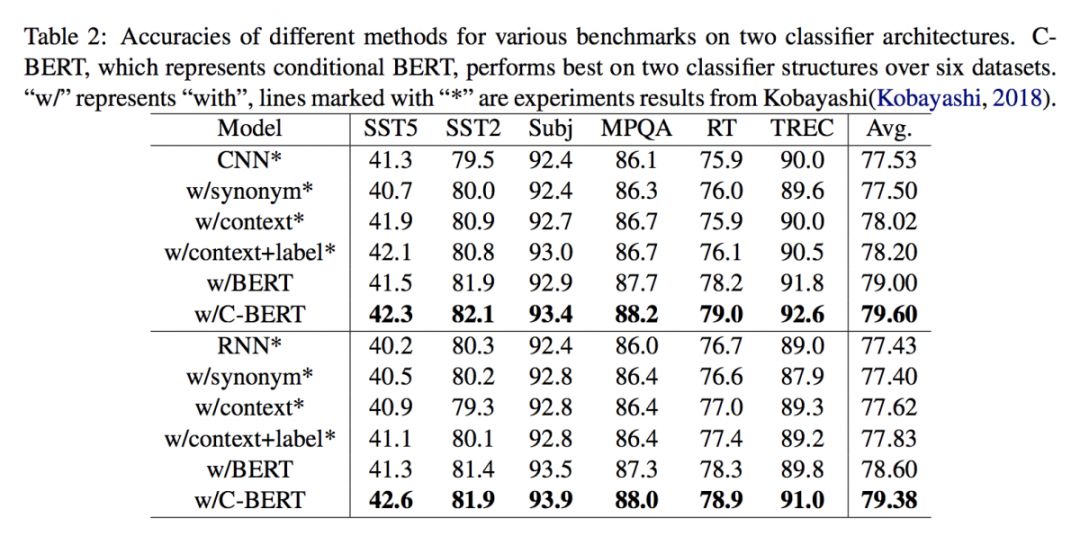

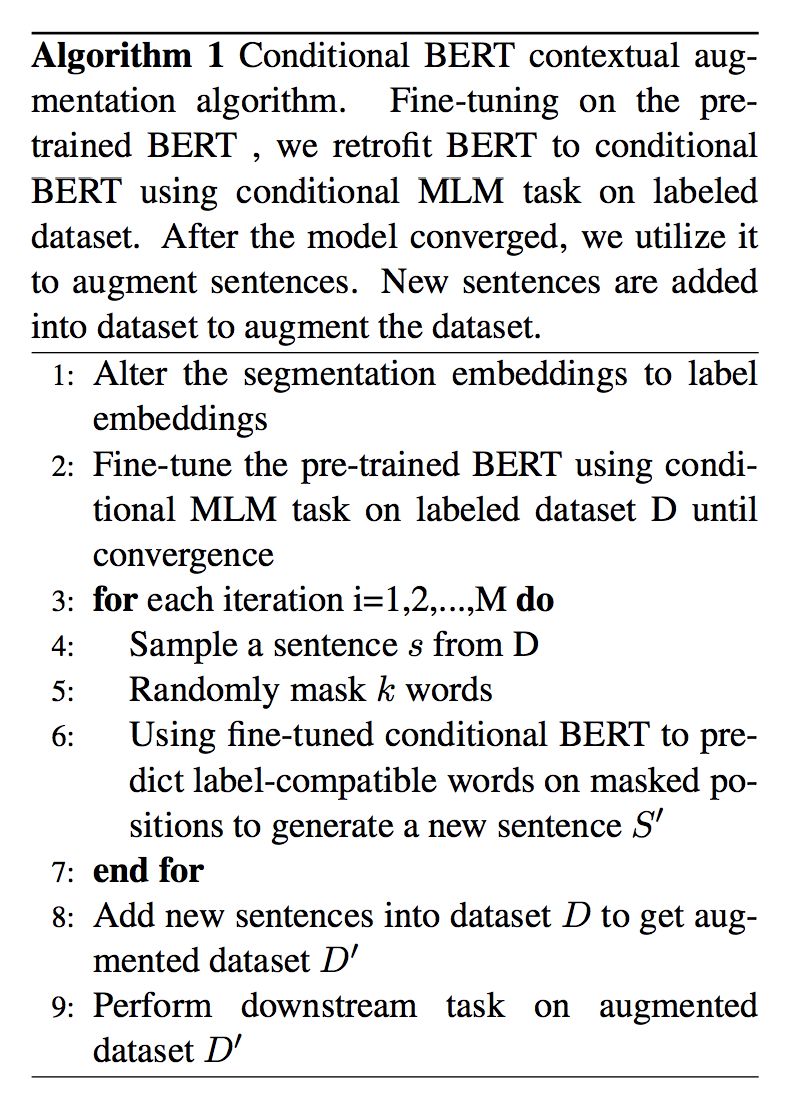

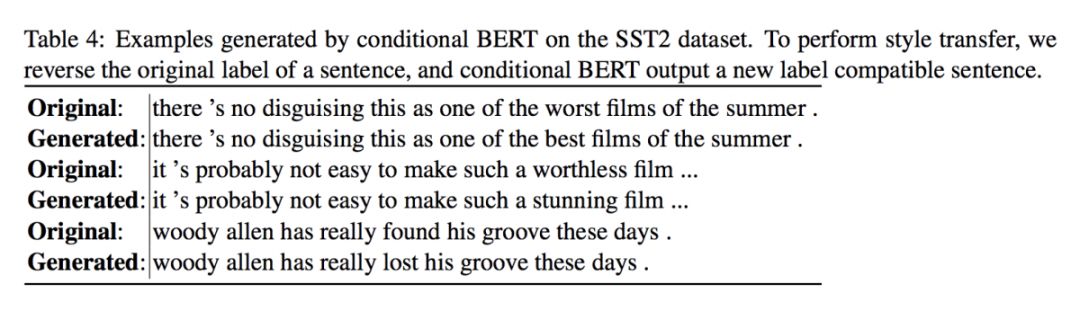

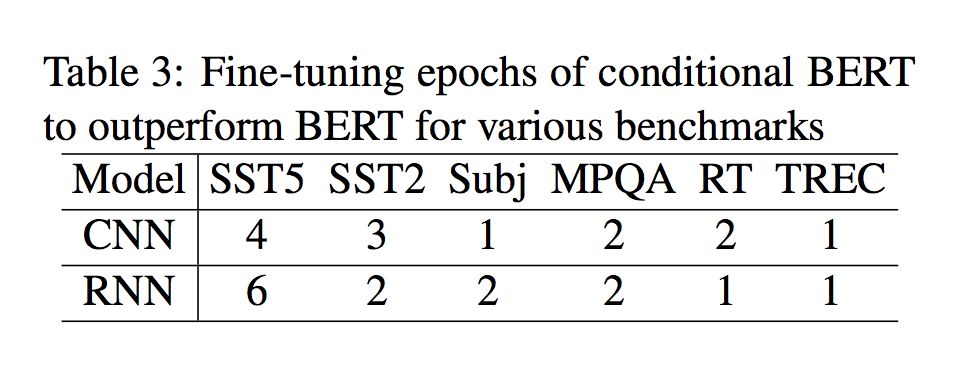

#Contextual Augmentation

本文来自中国科学院大学。传统 GAN 与 VAE 生成句子在一致性与可读性方面难以保证质量,近年基于词语替换的方法取得了成功。

BERT 使用 Masked Language Model(MLM)任务来预训练,MLM 任务是利用上下文的填空任务(cloze)。这个任务和短文本的语境增强(Contextual Augmentation,使用语言模型来预测并替换句子中的部分词,生成新句子)任务非常贴近。

预训练好的 BERT 模型, 可以通过 MLM 任务来实现语境增强。对于有类别标签的短文本,为了使预测出的替换词和原标签兼容,本文提出一个 Conditional MLM 的 fine-tuning 任务。

BERT 输入中的 Segmentation Embeddings 被替换成 Label Embeddings,在下游目标任务数据集上训练 Conditional MLM 任务,得到 Conditional BERT。将 Conditional BERT 应用于语境增强,对 6 个短文本分类数据集进行文本增强,都得到了分类效果的明显提升。

▲ 论文模型:点击查看大图

@guohao916 推荐

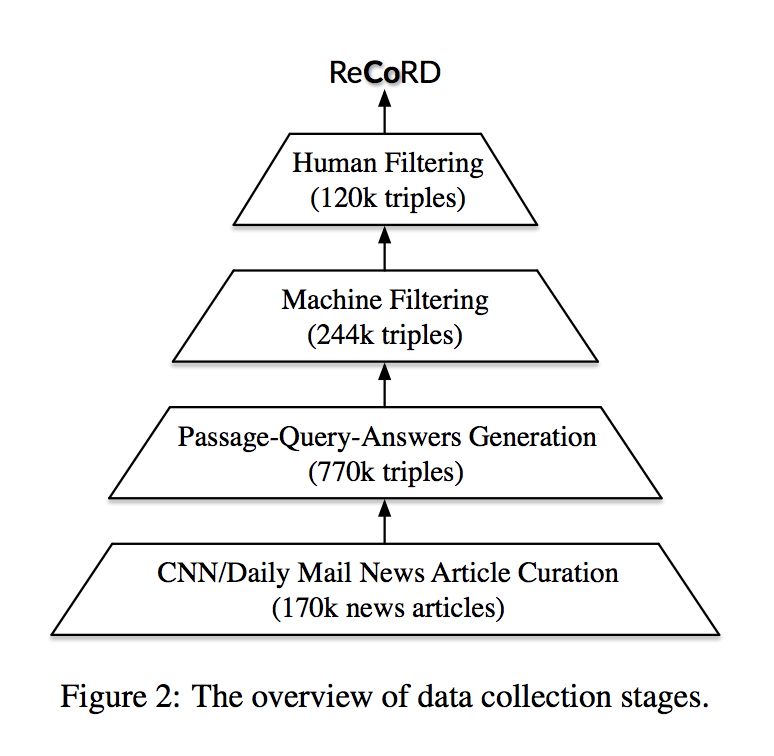

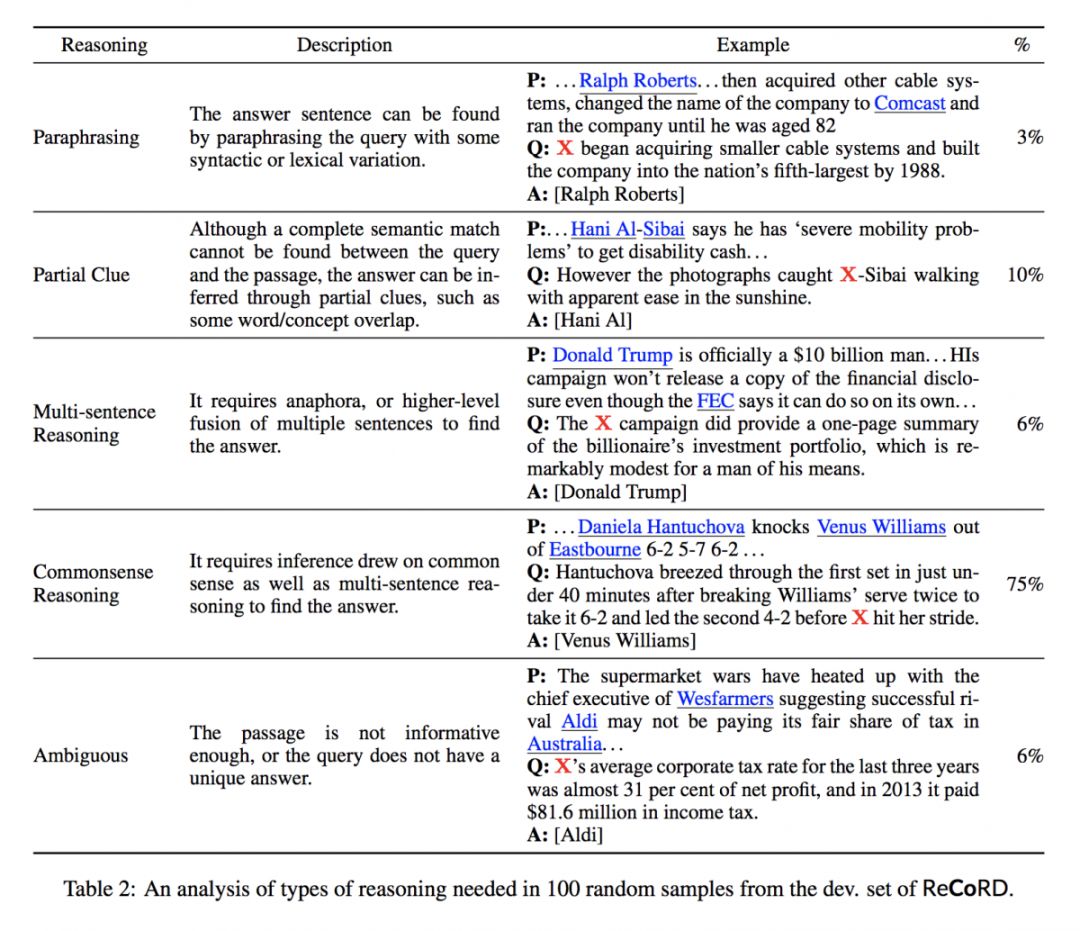

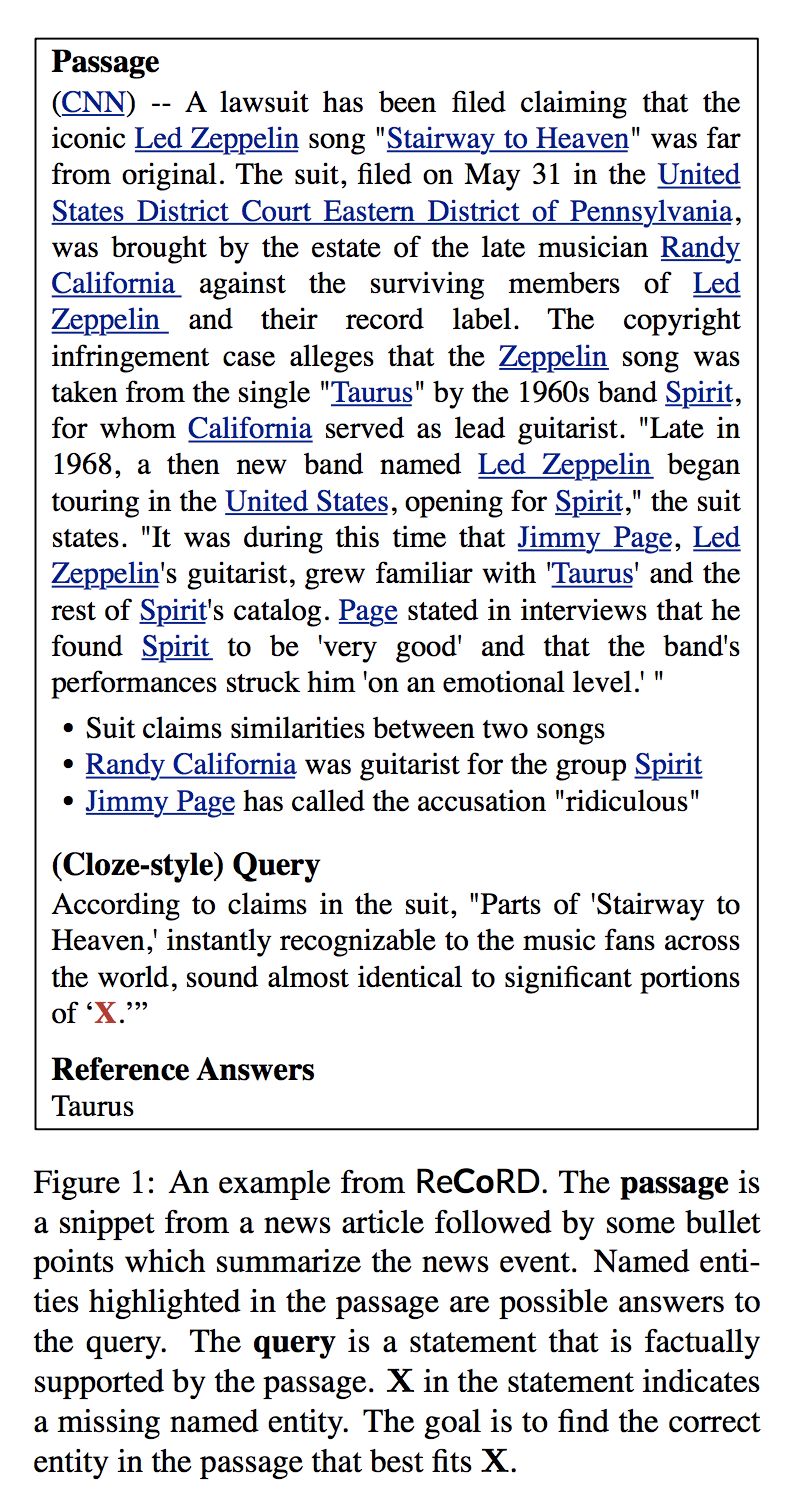

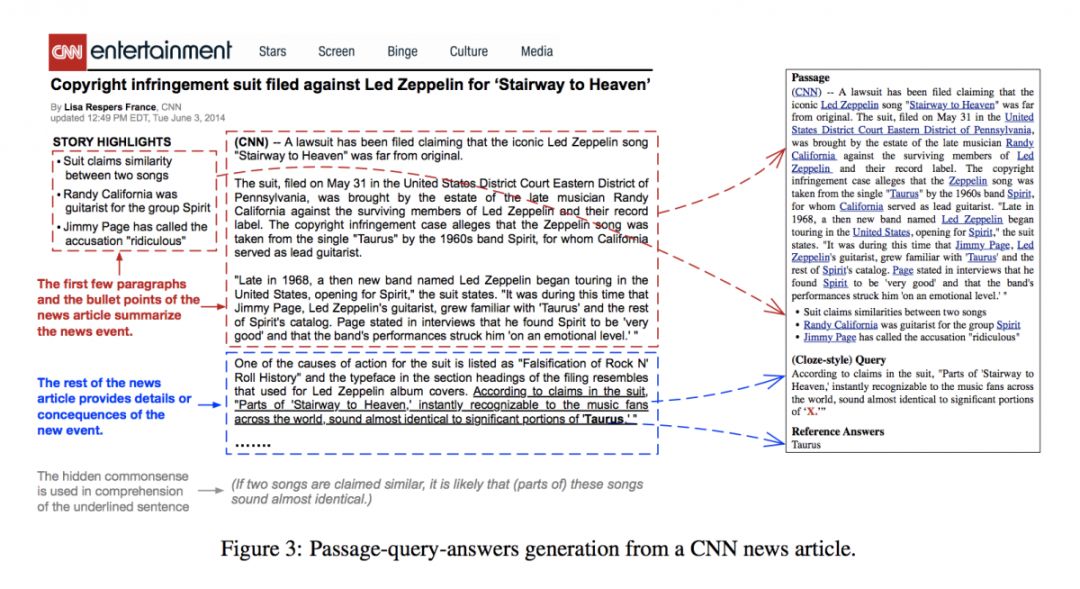

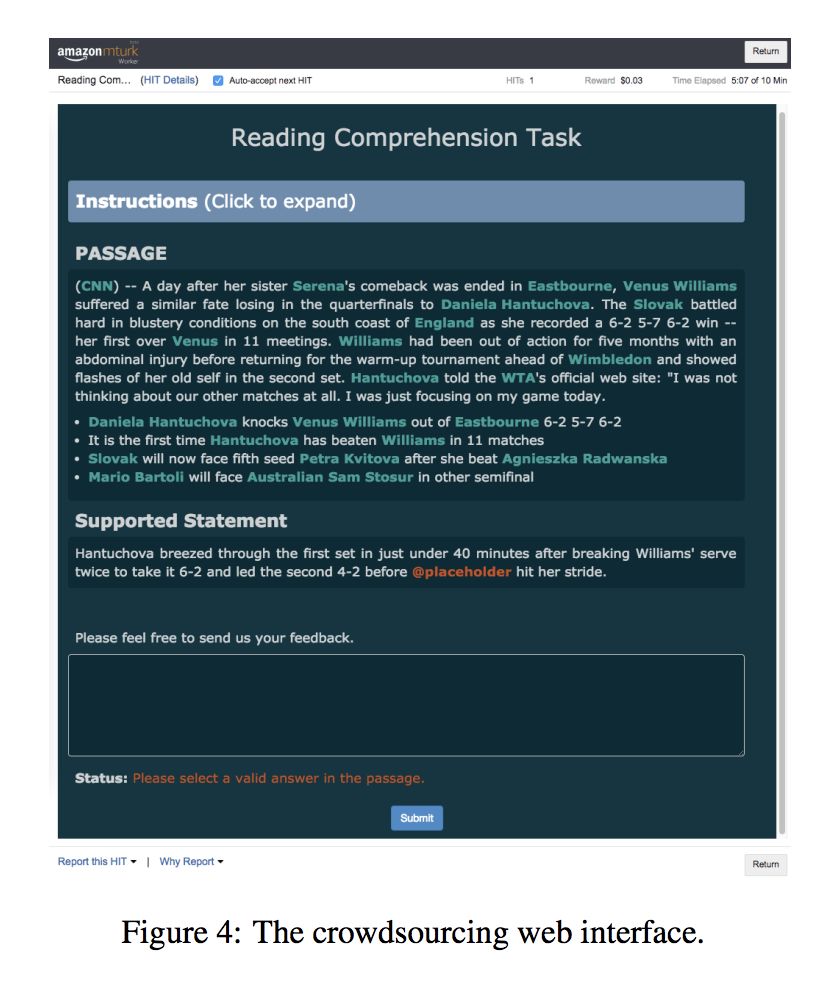

#Machine Reading Comprehension

本文来自约翰霍普金斯大学和微软,论文发布了一个带有常识性推理的机器阅读理解数据集。实验结果表明目前的最新阅读理解模型在该数据集上的结果显著弱于人工评估结果。ReCoRD 数据集为研究如何缩小人与机器之间对于常识推理的理解提供了机会。

▲ 论文模型:点击查看大图

@Zsank 推荐

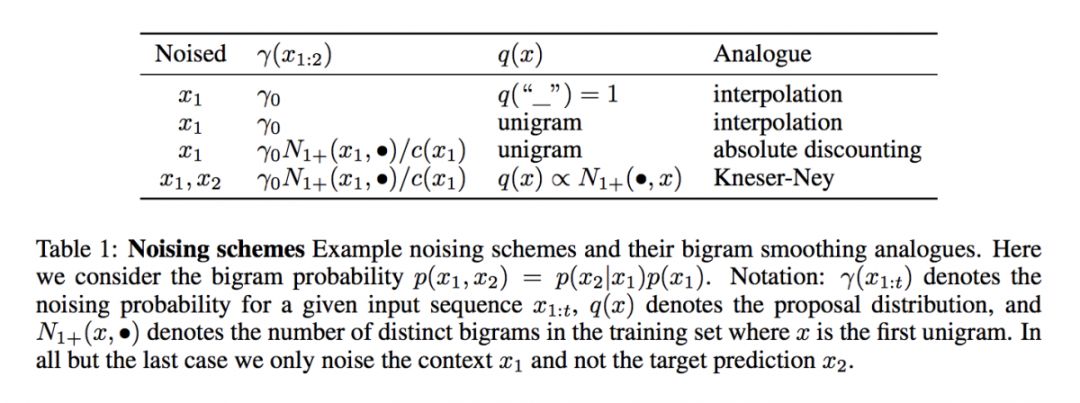

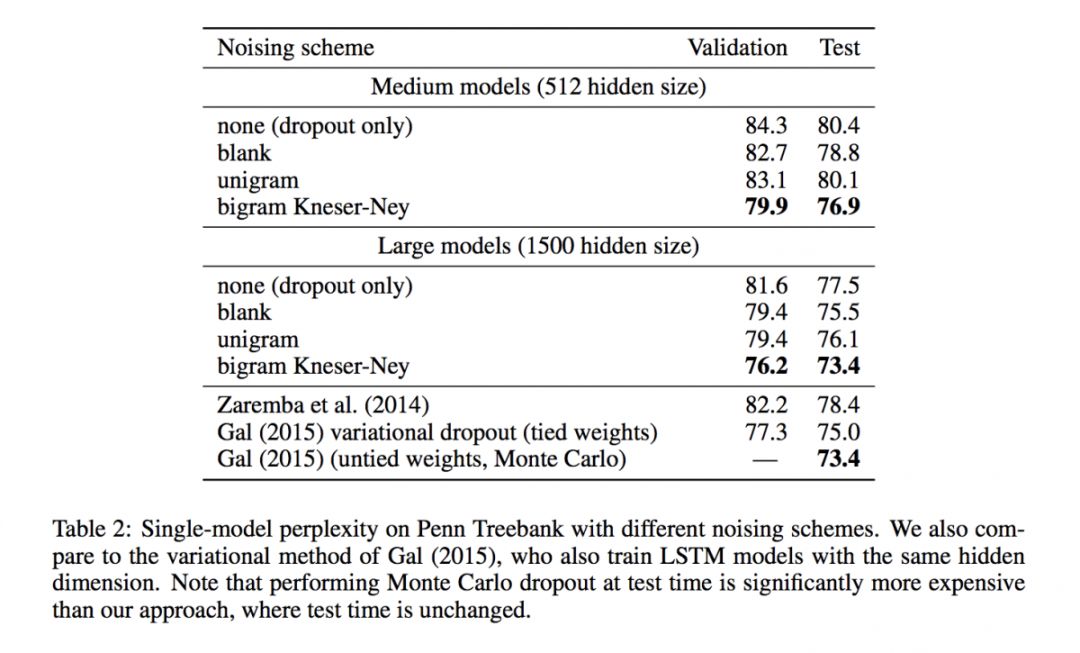

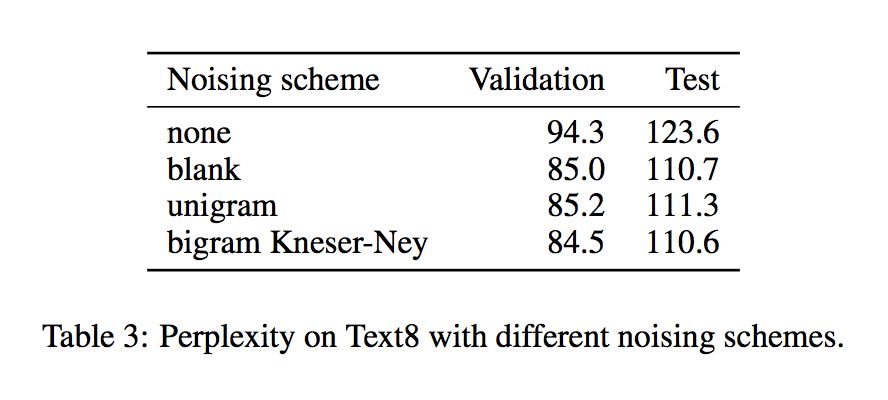

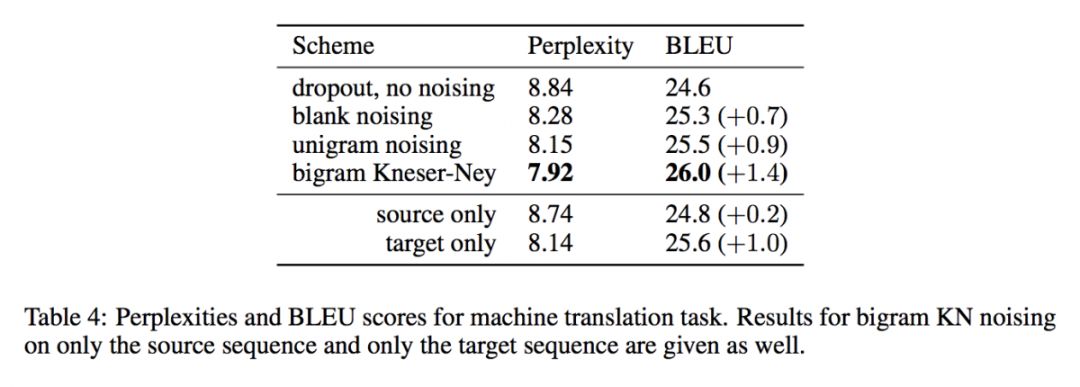

#Neural Language Model

本文来自斯坦福大学 Andrew Ng 团队。数据增强作为一种能够显著提升模型性能的方法,已经在 CV 领域证明了其有效性,但鲜有用于 NLP 领域中。在 NLP 领域,正则化一般是对权重(如 L2 正则化)或者隐层单元(如 dropout)进行处理的,而不是直接对数据本身。

在本文中,作者证明了神经语言模型中,对数据施加噪声相当于n-gram的插值平滑,能够提升神经语言模型的性能。BERT 也是用了神经语言模型,并且训练时使用了 Mask 方法。而 Mask 方法为什么有效正是这篇论文的一个重点。虽然两者方法不同,但也可以作为 BERT 的扩展阅读。况且,就凭该论文的作者们的名字也值得一看。

▲ 论文模型:点击查看大图

@zkt18 推荐

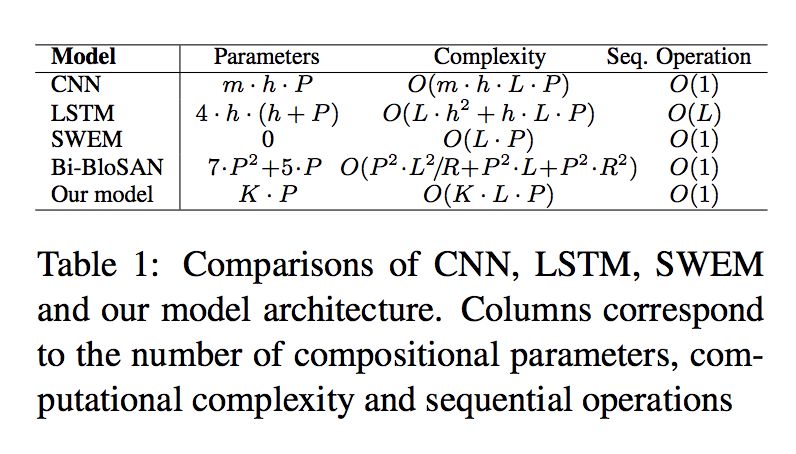

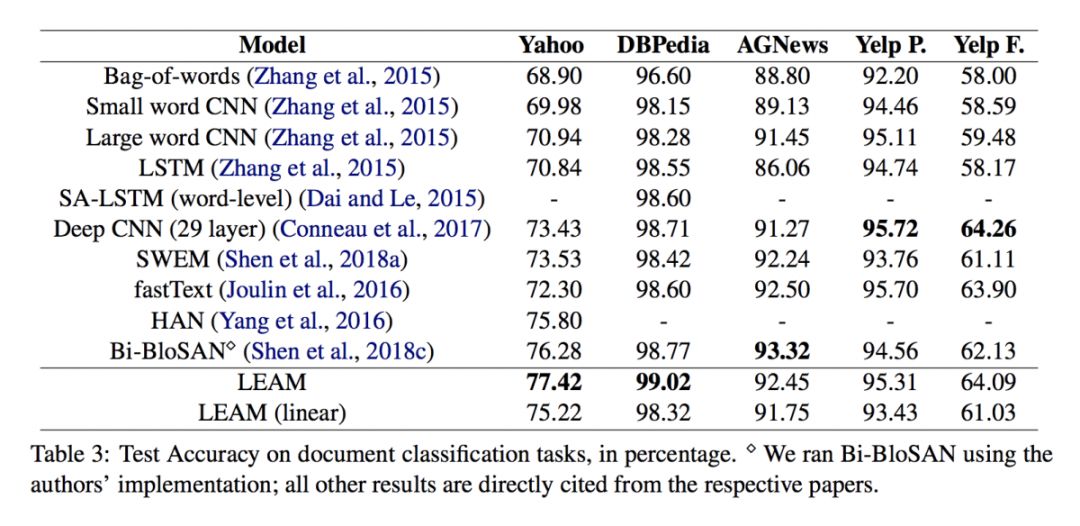

#Text Classification

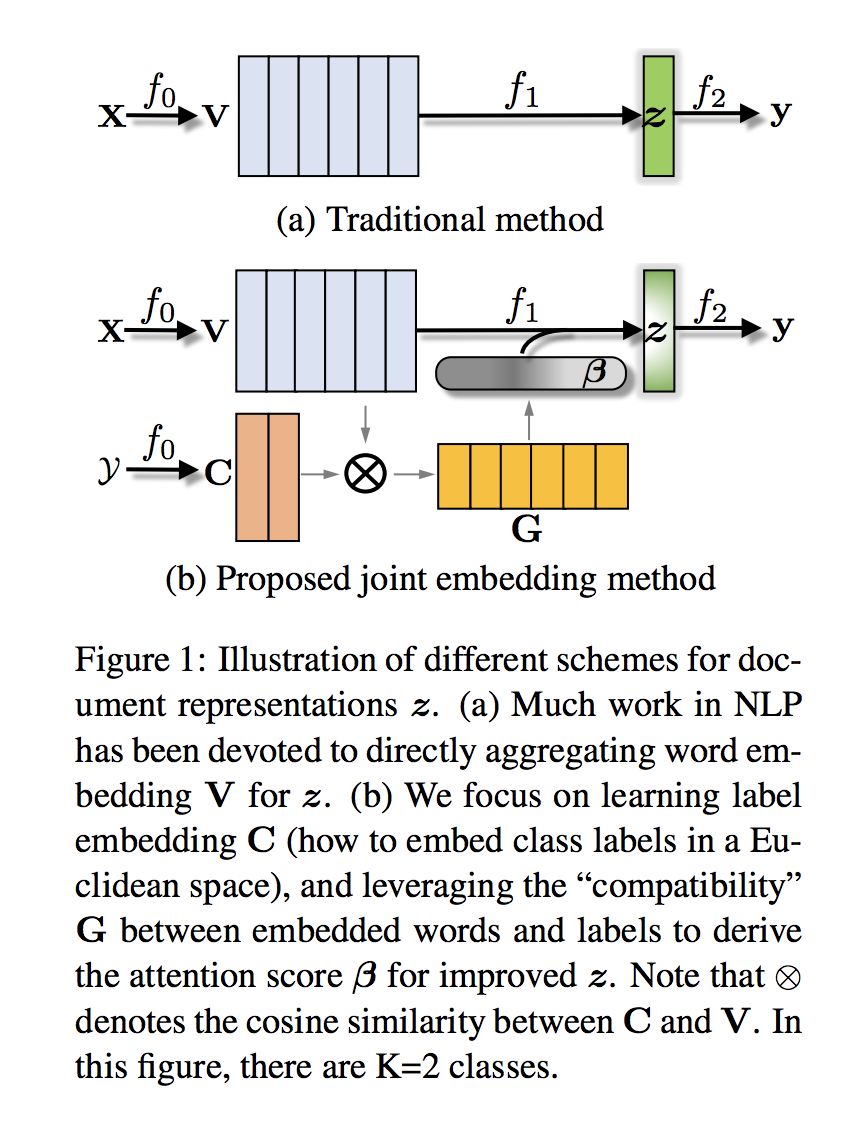

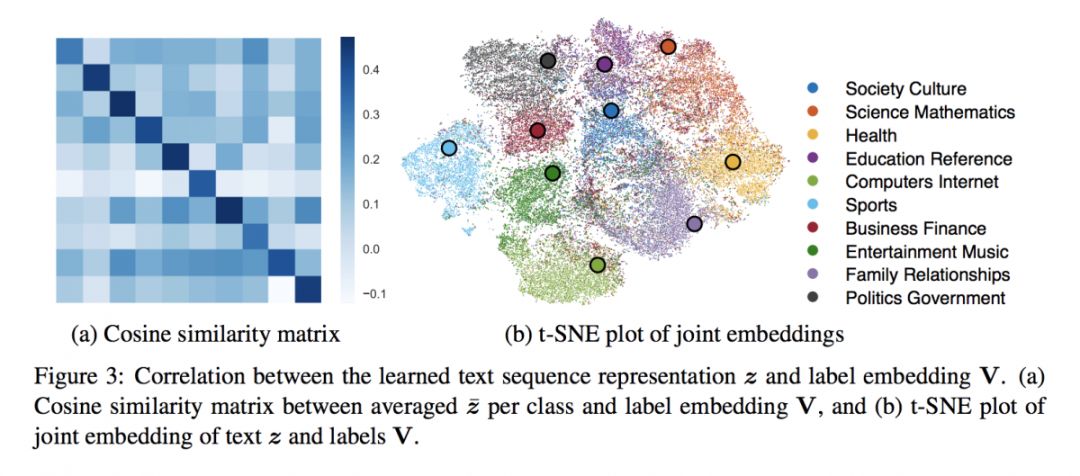

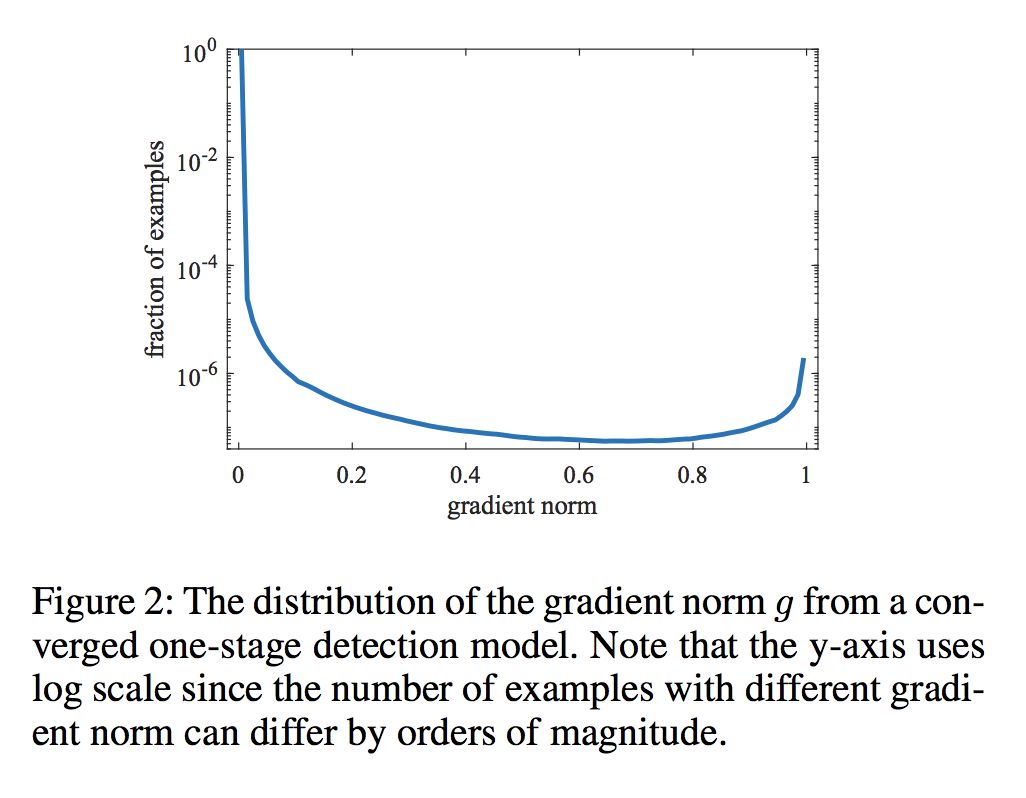

本文是杜克大学发表于 ACL 2018 的工作。作者将文本分类看作 words and labels joint embedding:每一 label 嵌入到词向量的同一位置。使用 attention 训练,确保对于一个文本序列,相关词的权重比非相关词高。Word Embedding 效果对于提高任务准确率十分重要,重点在于如何使用 label 信息构建文本序列表示。

NLP 任务通常有三步操作,embed->encode->predict。本文在 embed 中加入 label 信息,在 encode 中使用关于 word 和 label 的注意力,简单模型即可取得先进结果。

▲ 论文模型:点击查看大图

@darksoul 推荐

#Object Detection

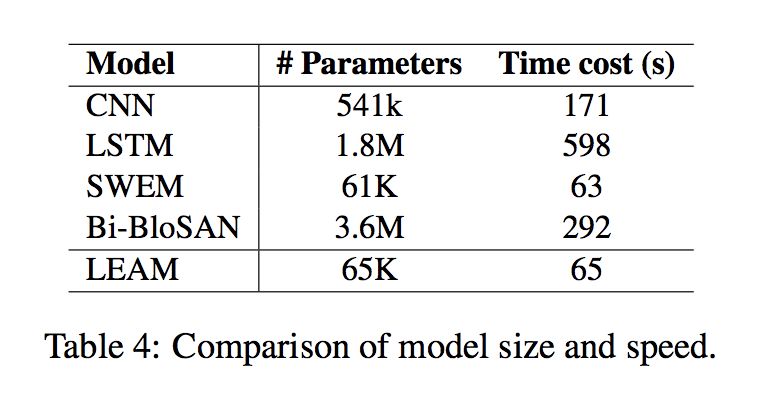

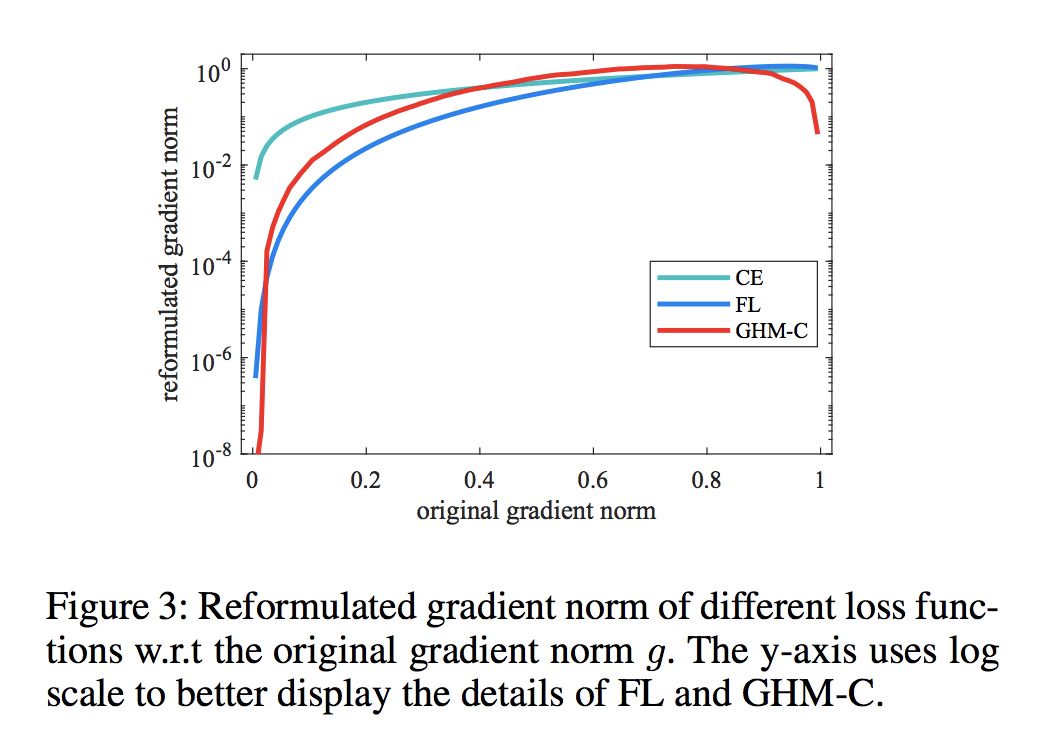

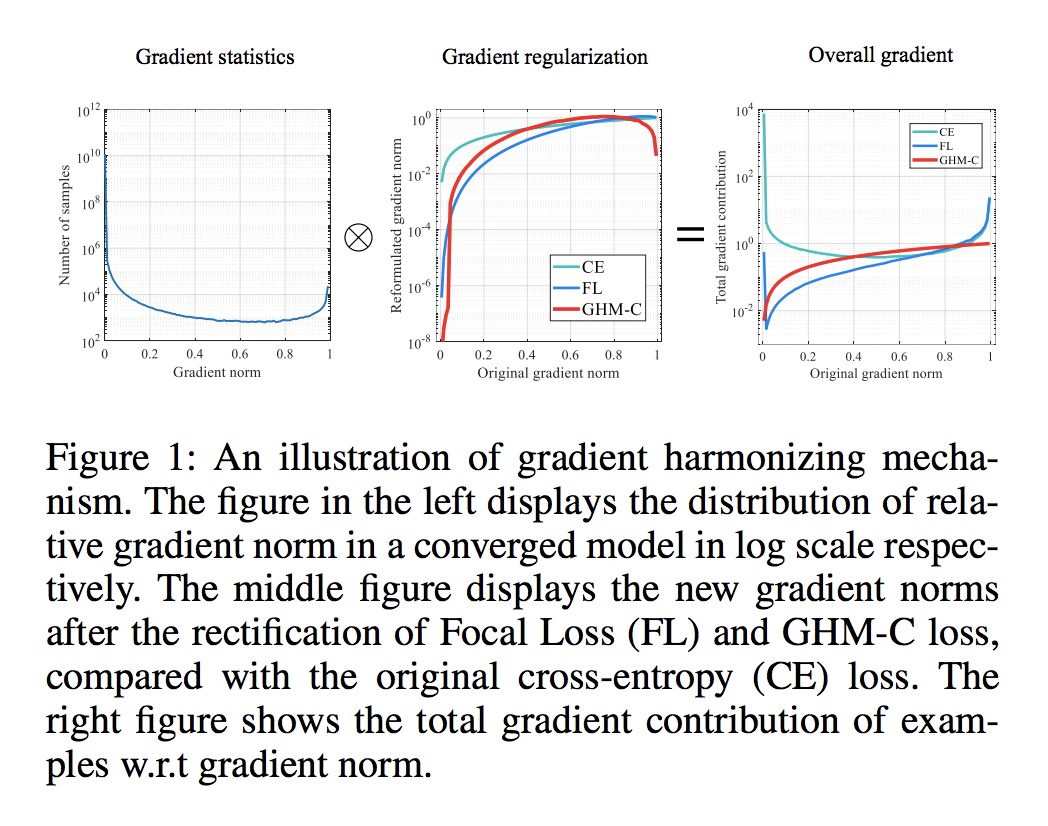

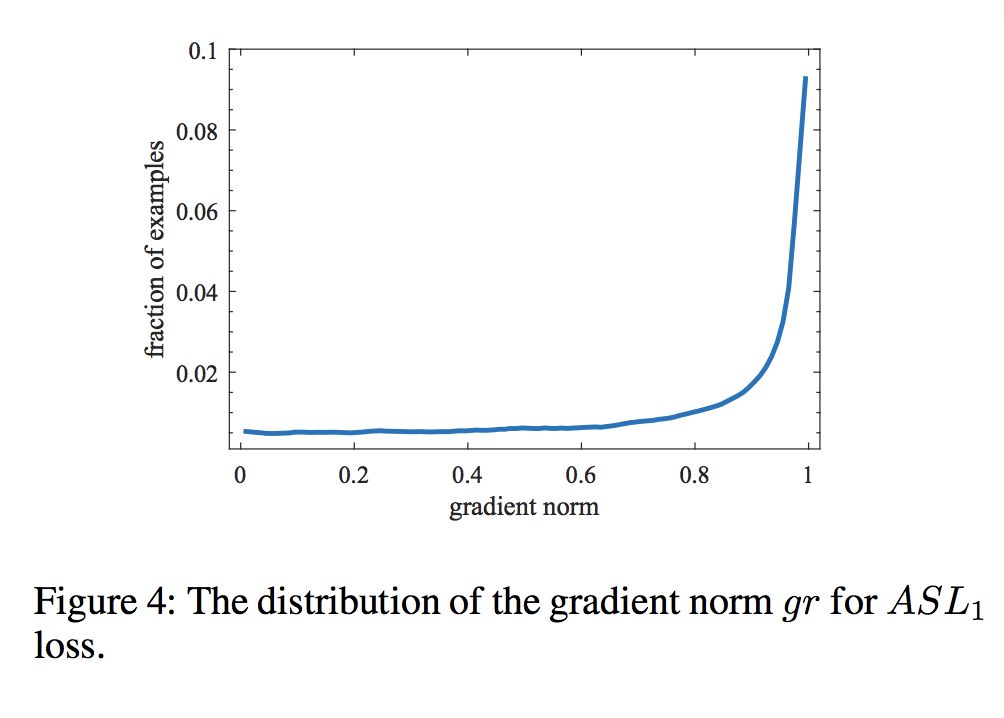

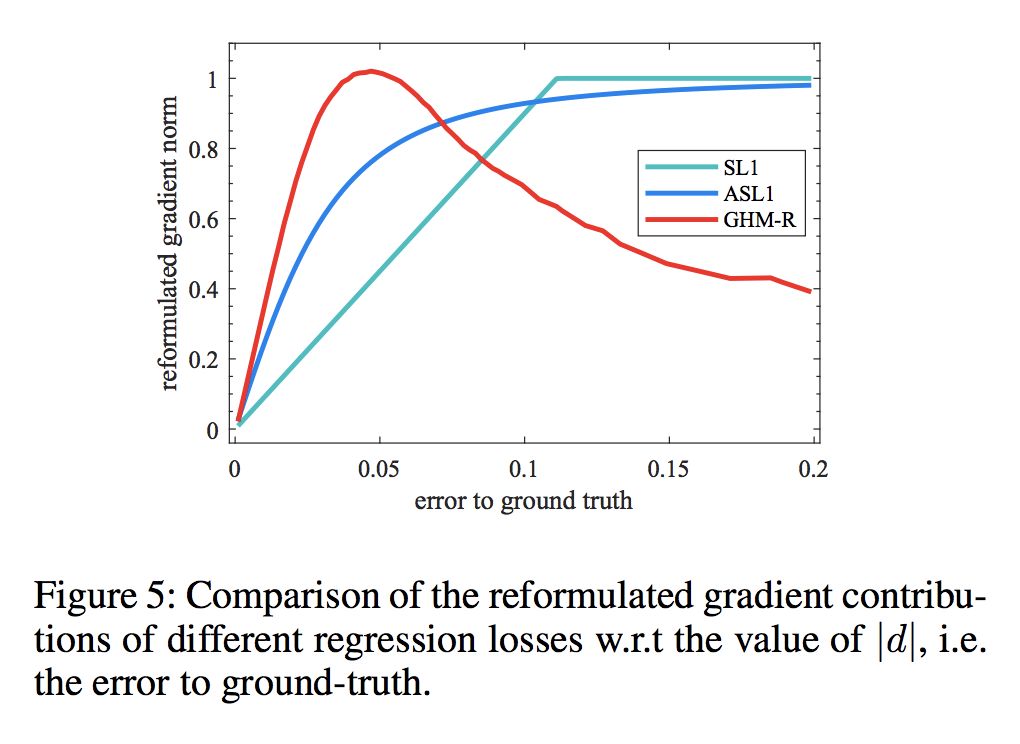

本文是香港中文大学发表于 AAAI 2019 的工作,文章从梯度的角度解决样本中常见的正负样本不均衡的问题。从梯度的角度给计算 loss 的样本加权,相比与 OHEM 的硬截断,这种思路和 Focal Loss 一样属于软截断。

文章设计的思路不仅可以用于分类 loss 改进,对回归 loss 也很容易进行嵌入。不需要考虑 Focal Loss 的超参设计问题,同时文章提出的方法效果比 Focal Loss 更好。创新点相当于 FL 的下一步方案,给出了解决 class-imbalance 的另一种思路,开了一条路,估计下一步会有很多这方面的 paper 出现。

▲ 论文模型:点击查看大图

@wangshy 推荐

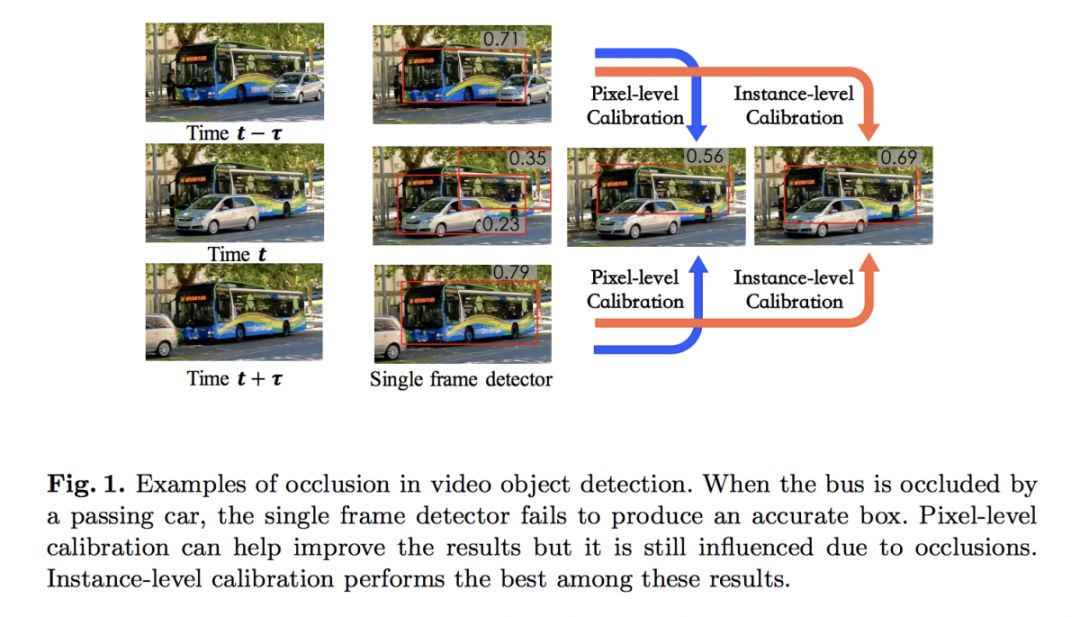

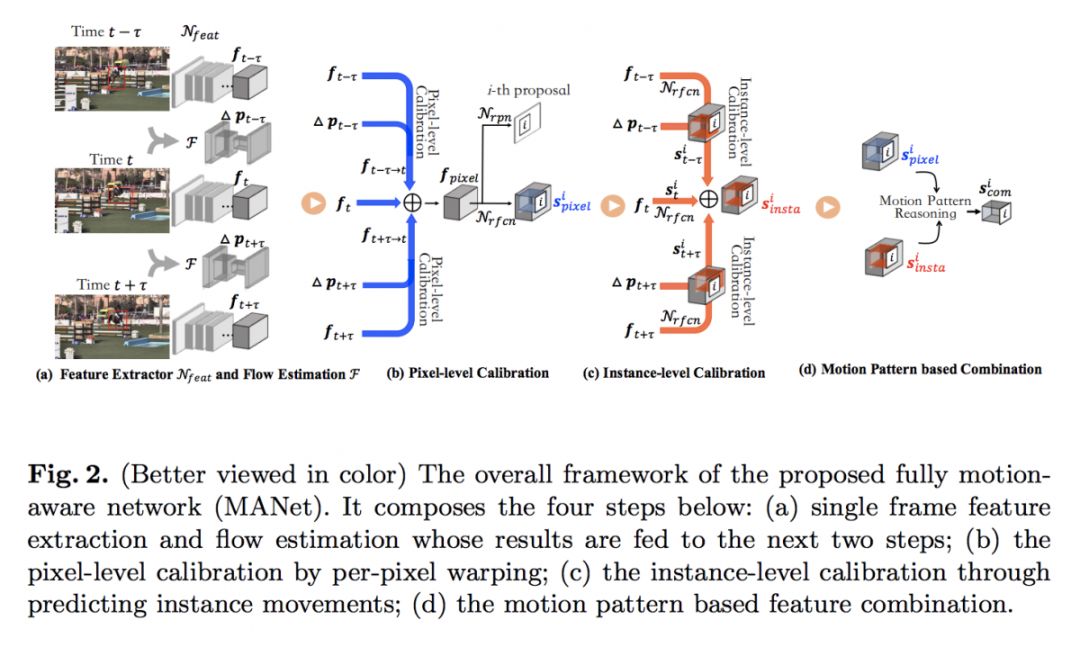

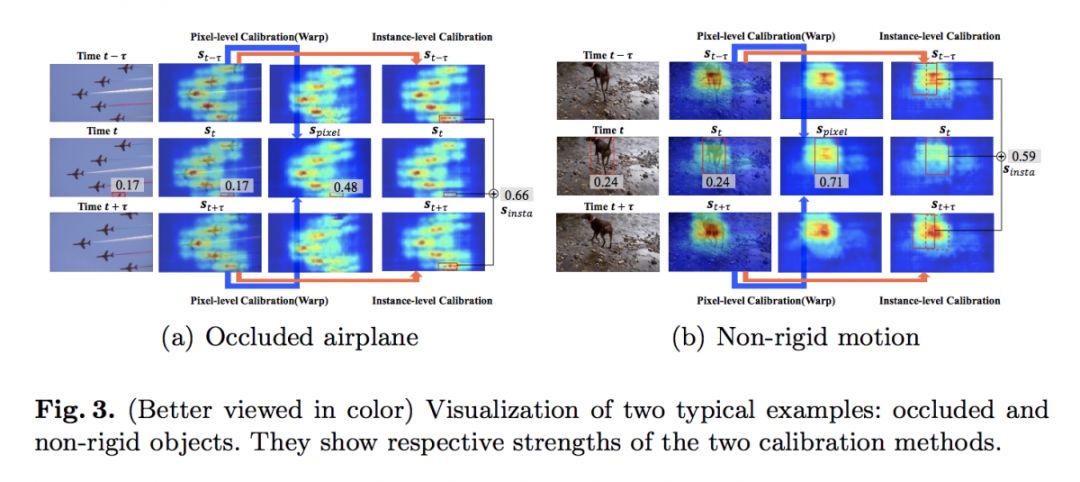

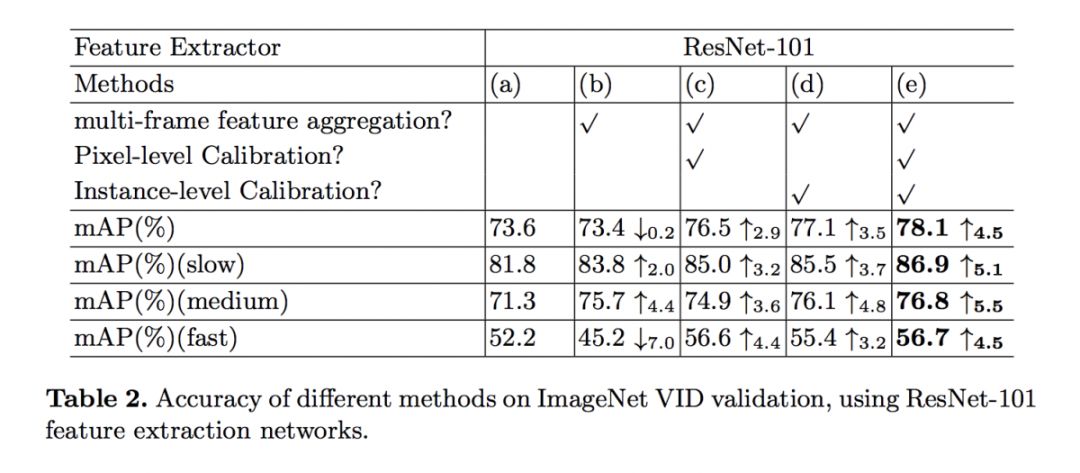

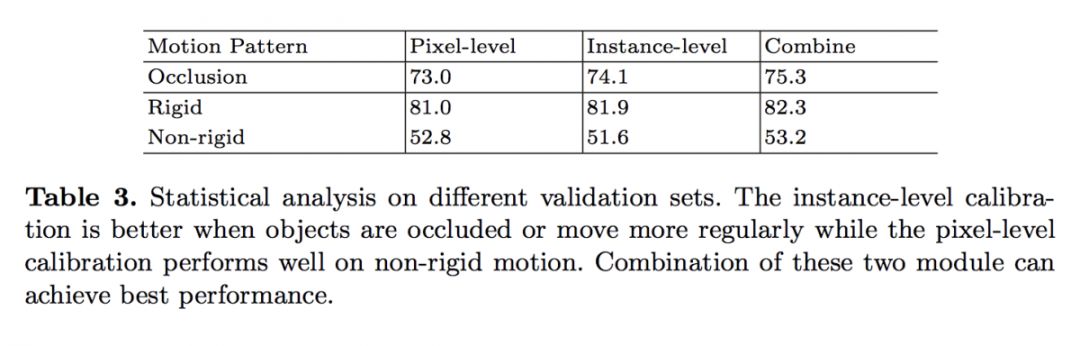

#Video Object Detection

本文是清华大学和商汤科技发表于 ECCV 2018 的工作。在视频物体检测任务中,作者提出了一种关注运动信息(Fully Motion-Aware Network:MANet)的端到端模型,它在统一的框架中同时进行像素级和实例级的特征对准来提高检测精度。

像素级校准可灵活地建模细节运动,而实例级校准更多地捕捉物体整体运动信息,以便对遮挡具有鲁棒性。实验表明,本文模型在ImageNet VID数据集上达到了领先的精度。

▲ 论文模型:点击查看大图

@pyy 推荐

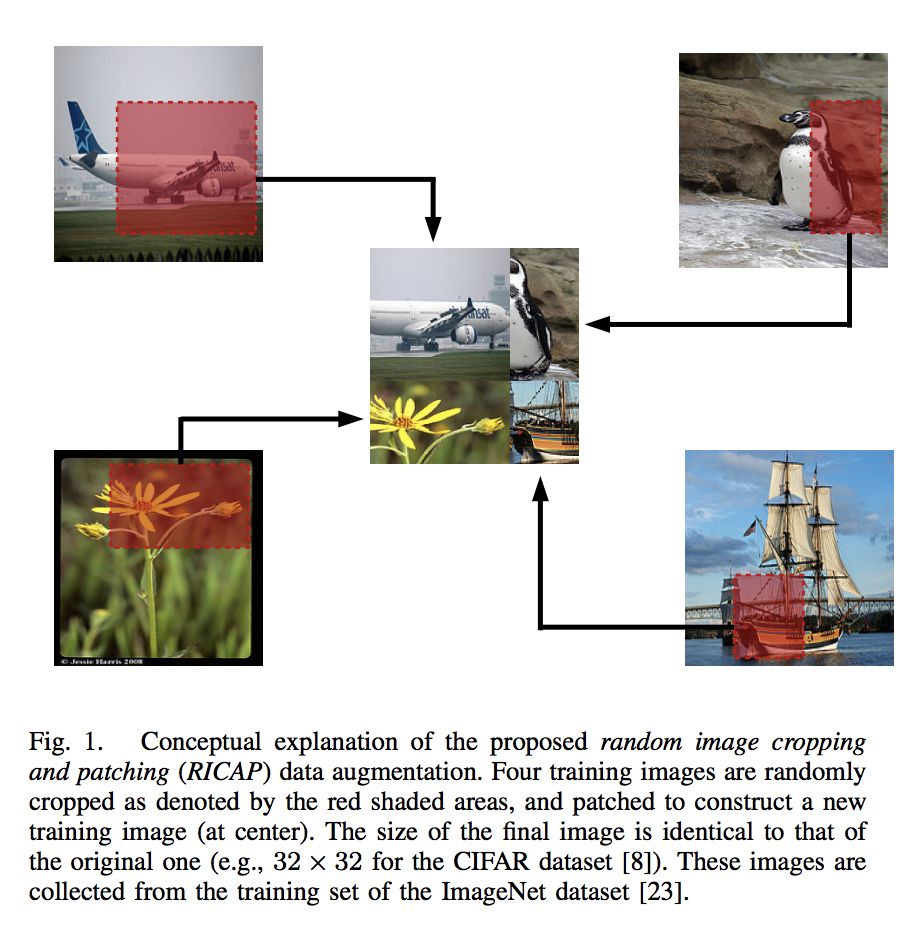

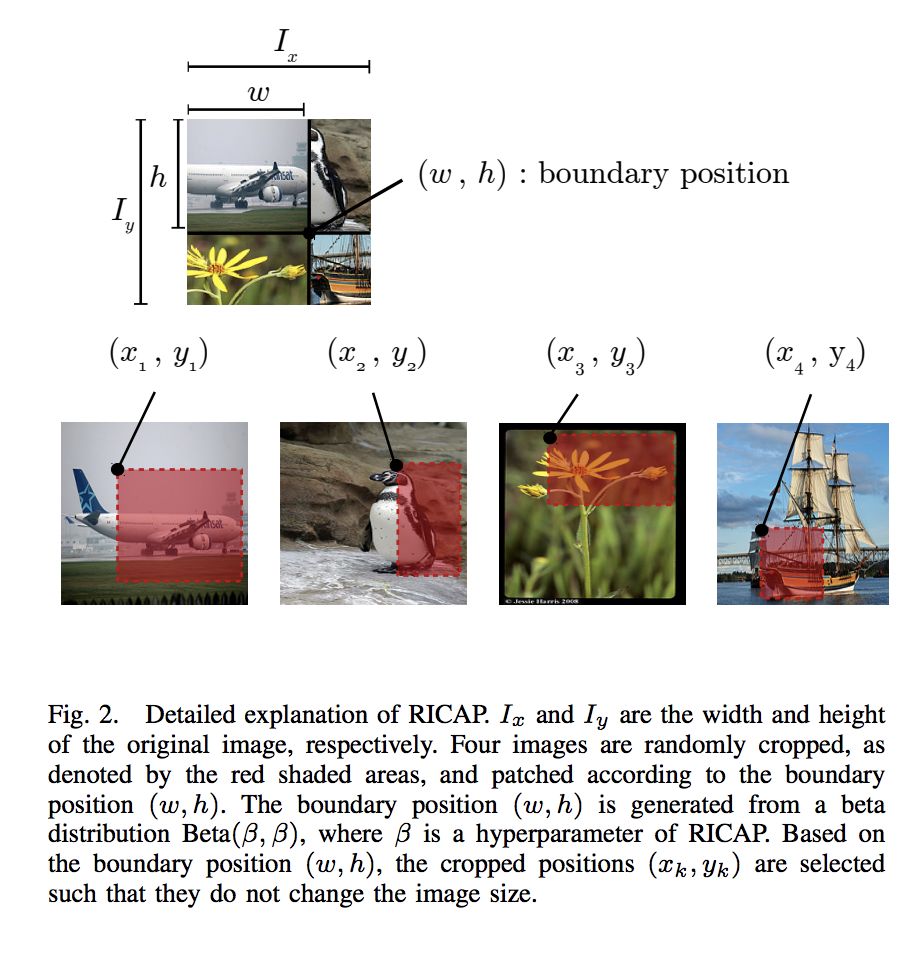

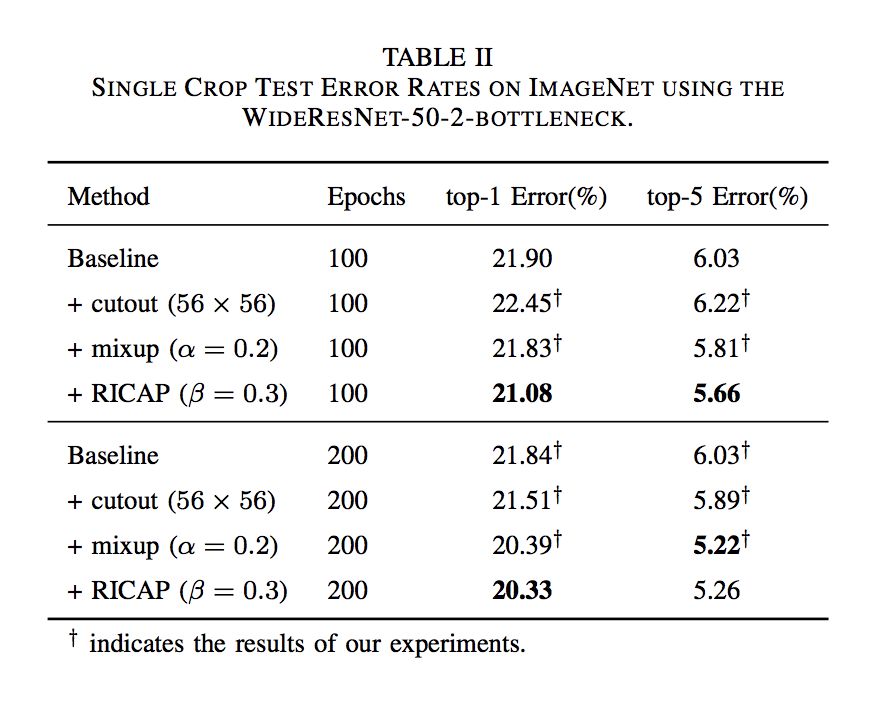

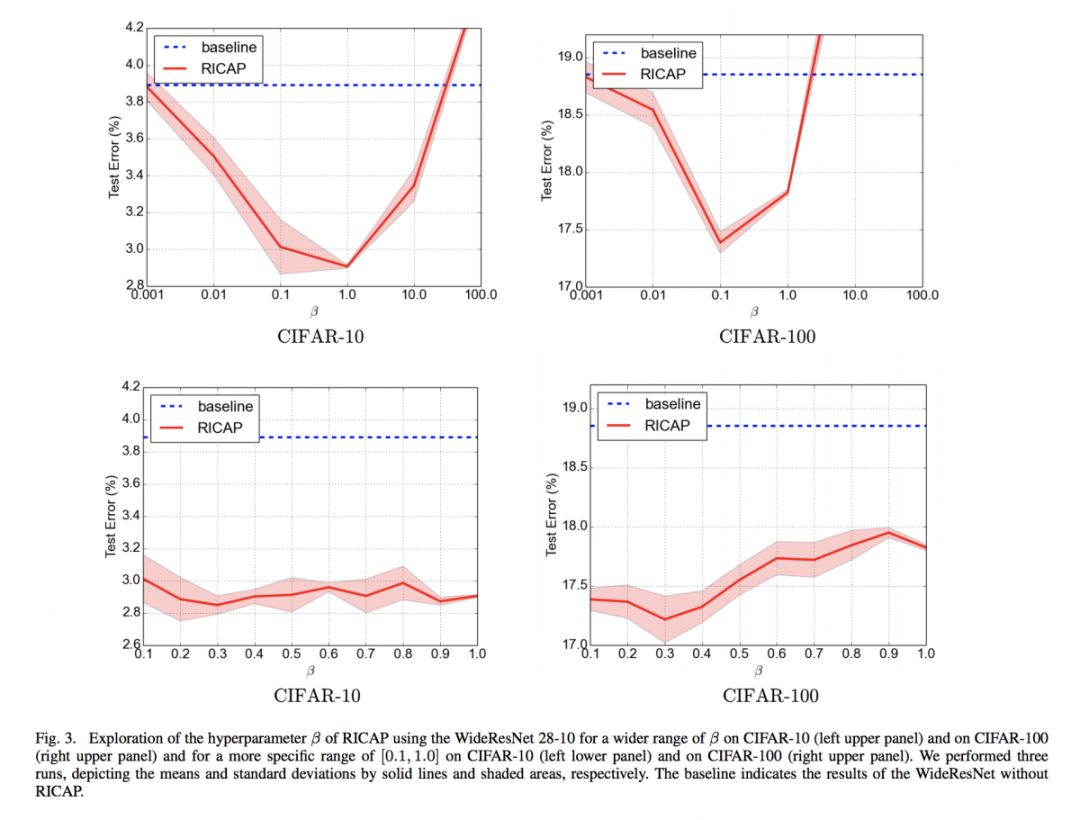

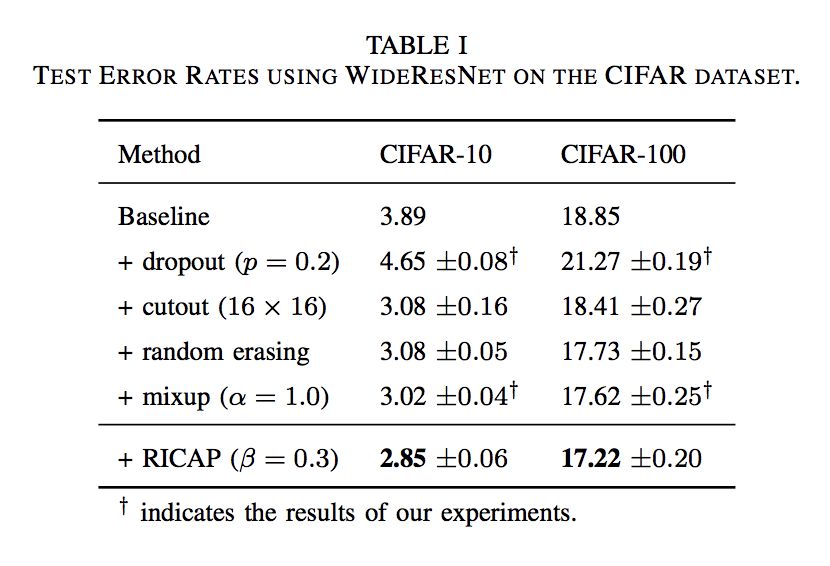

#Data Augmentation

本文来自神户大学,论文提出了一种基于随机图像裁剪和修补的图像预处理方法 RICAP,随机裁剪四个图像并对其进行修补以创建新的训练图像。该方法非常简单实用,把几张图拼在一起,然后 label 就是这几张图类别占图片大小的比率。实验表明,本文方法在 CIFAR-10 数据集上实现了 2.19% 的测试误差。

▲ 论文模型:点击查看大图

@Kralkatorrik 推荐

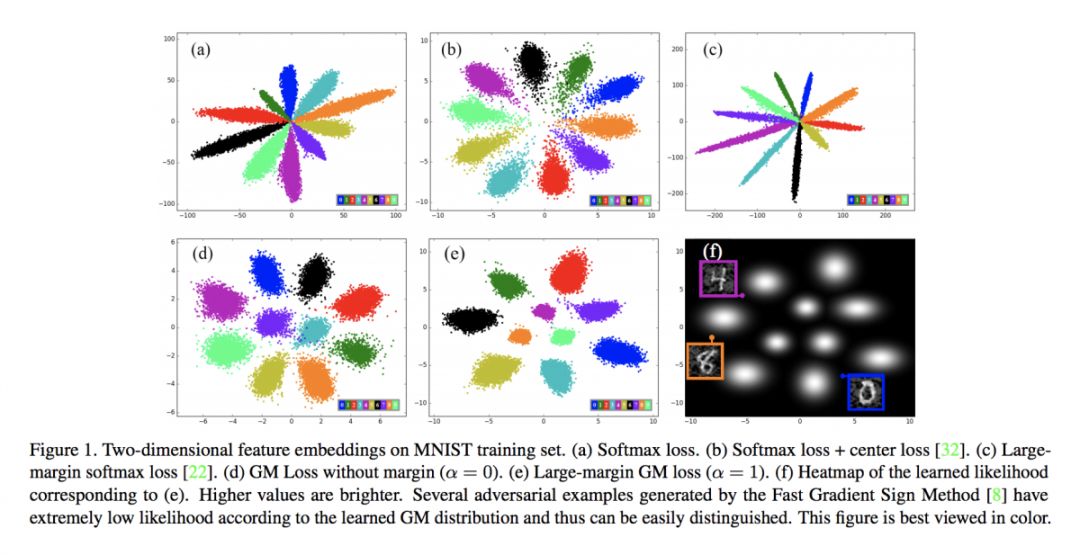

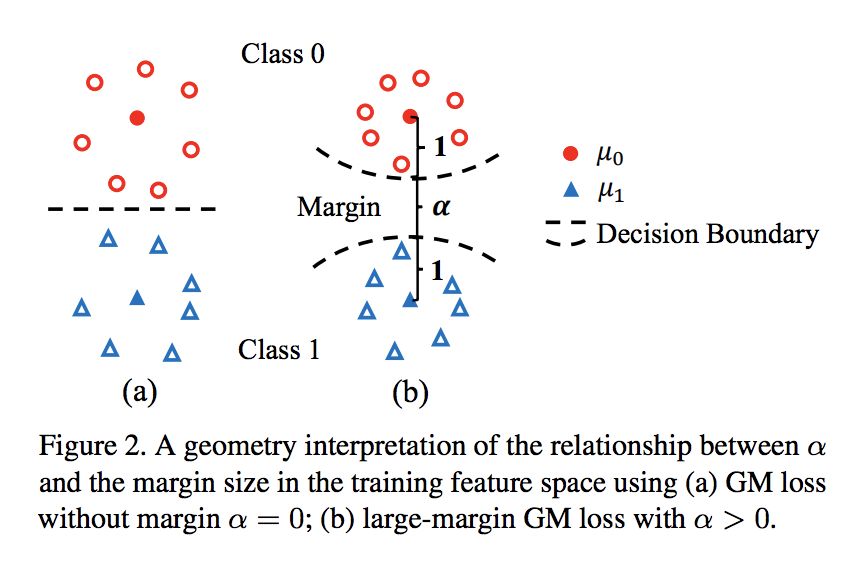

#Image Classification

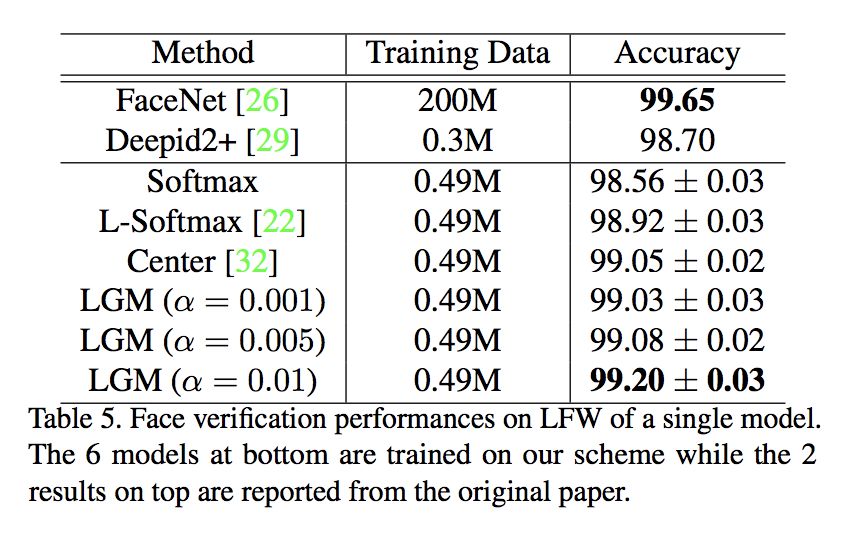

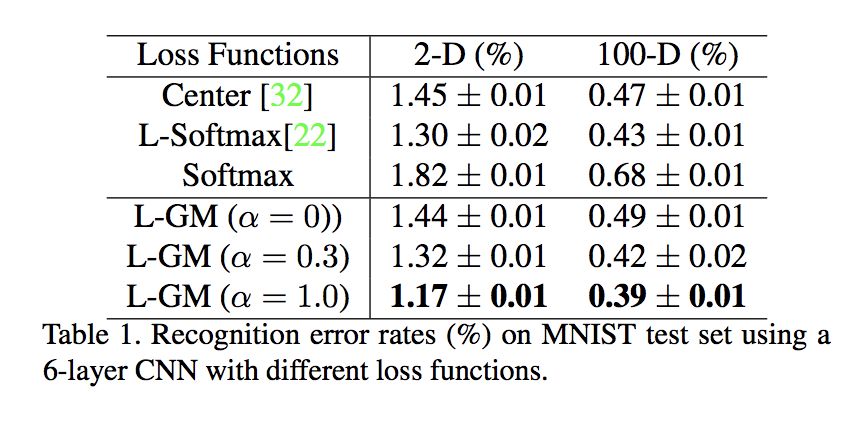

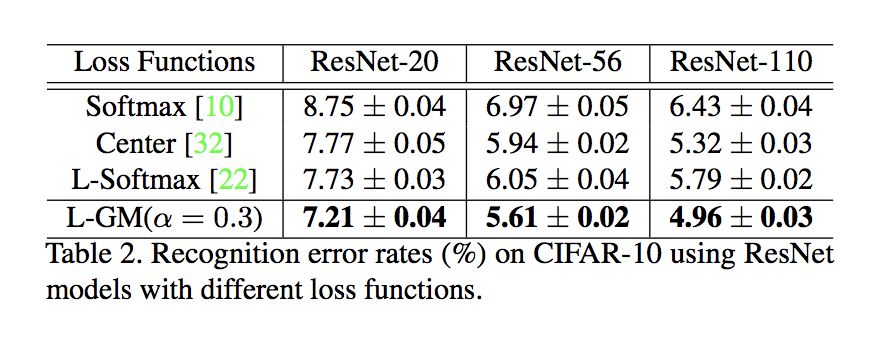

本文是清华大学和 UIUC 发表于 CVPR 2018 的工作。这篇文章假定数据样本在特征空间服从高斯混合分布,使用 Gaussian Mixture 代替 Softmax 做概率表示,用交叉熵损失来做优化。除此之外,遵循约束类内距离增加类间距离的思想,引入 L_likehood 损失,并在 GM 中增加 margin,构成了最终的 LGM Loss。

▲ 论文模型:点击查看大图

@paperweekly 推荐

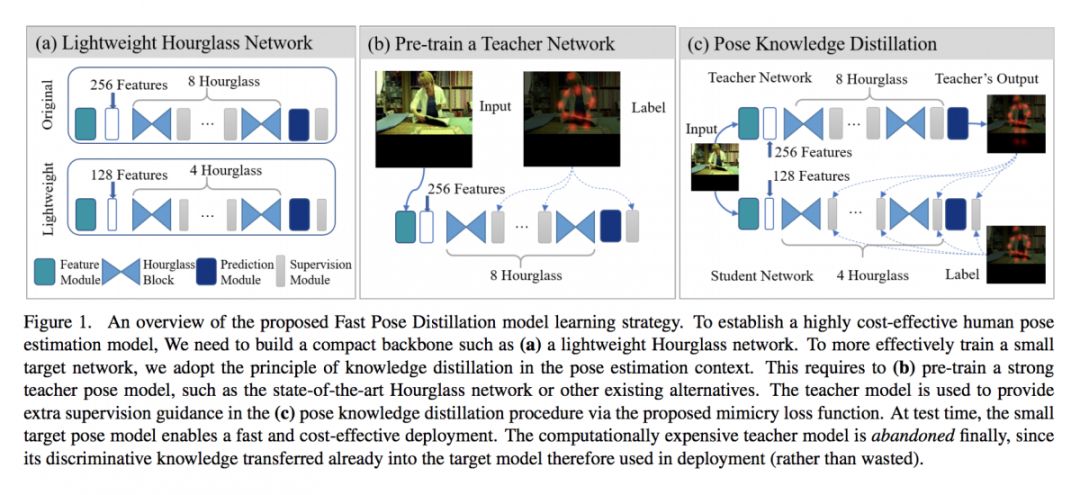

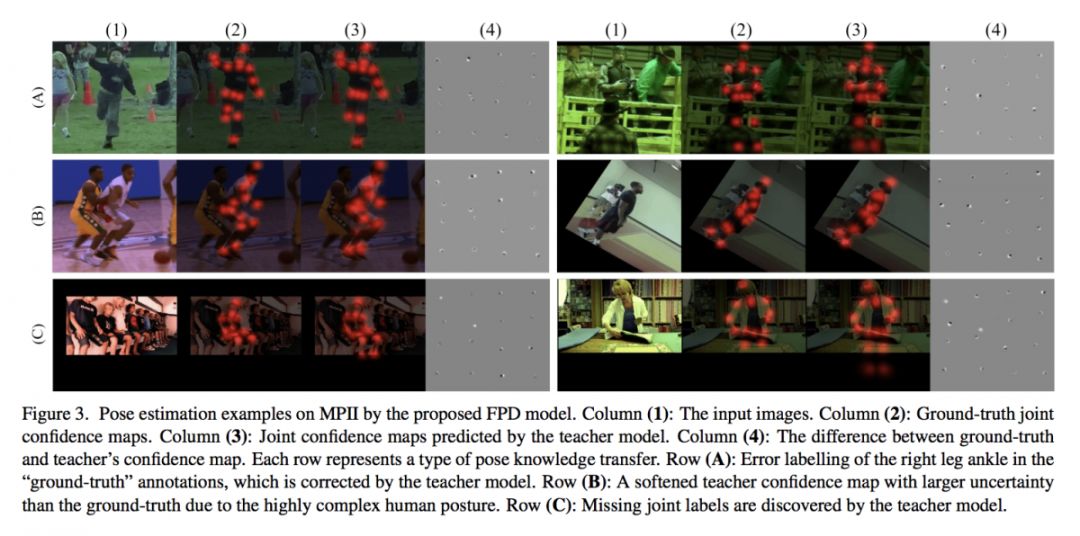

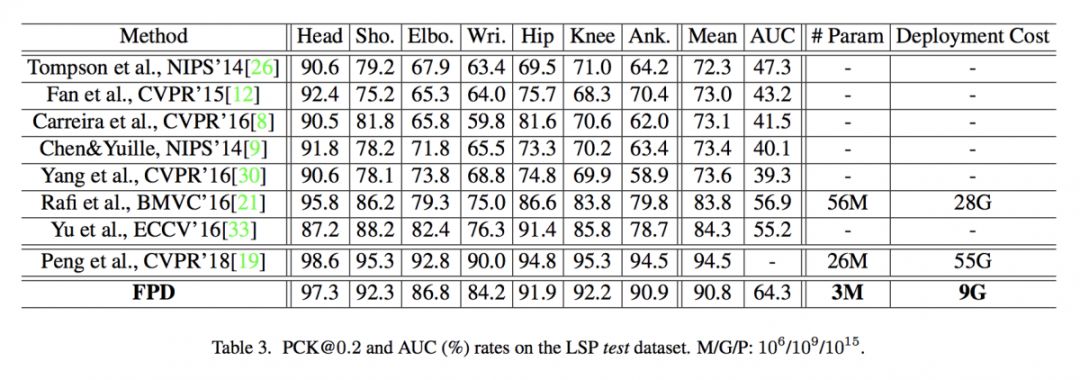

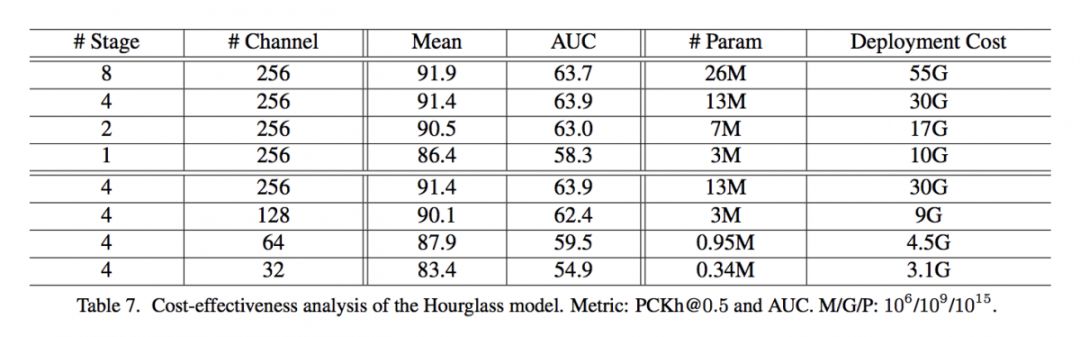

#Human Pose Estimation

本文来自电子科技大学和 Vision Semantics。现有的人体姿态估计方法通常更侧重于设计网络学习更适合的特征,从而使得定位精度更高。往往容易忽视在模型实际部署时,可能面临模型较大和计算复杂度过高的问题。本文基于一个轻量级的 Hourglass 网络和知识蒸馏,提出了一种模型复杂度更低、模型 size 更小的全新方法——FPD。

▲ 论文模型:点击查看大图

@haonan 推荐

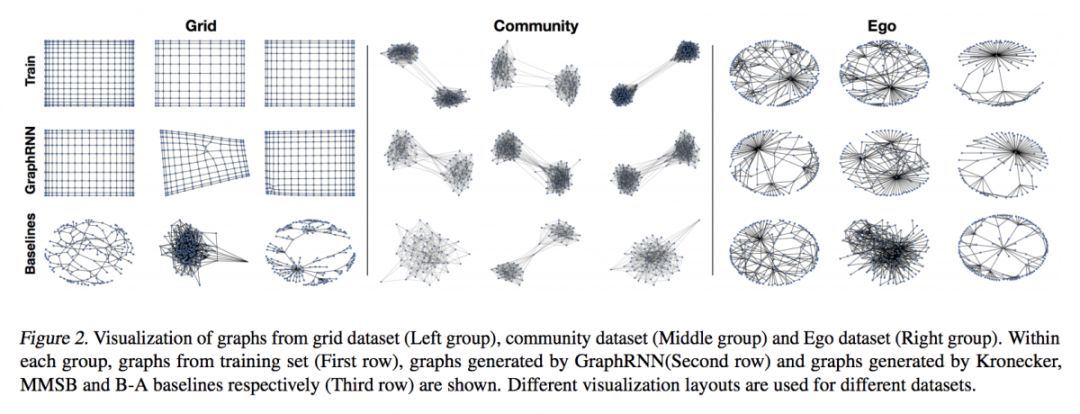

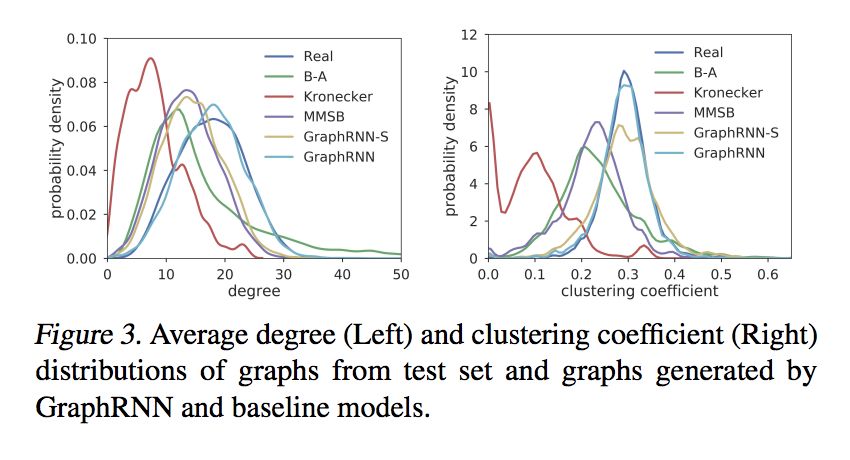

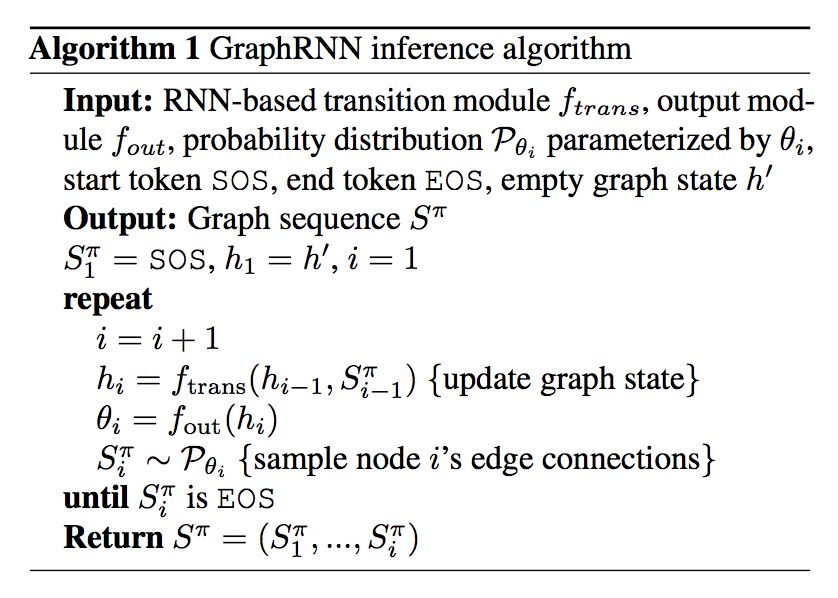

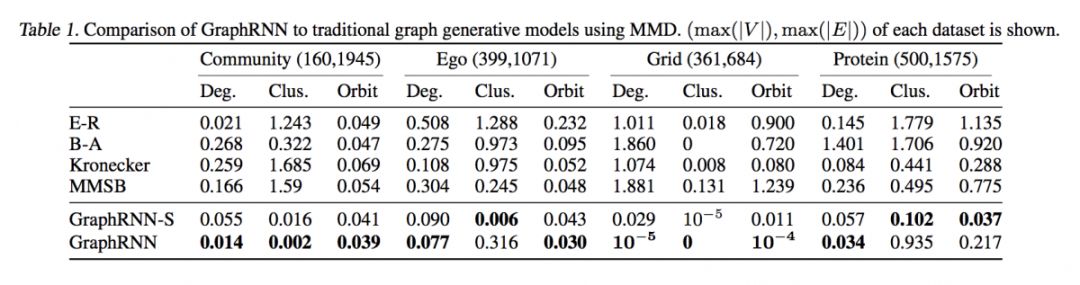

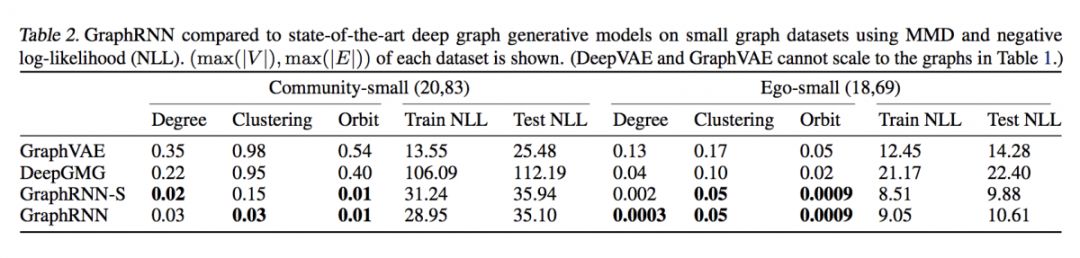

#Generative Graph

本文是斯坦福大学和南加州大学发表于 ICML 2018 的工作,论文关注的问题是基于图的概率生成模型,作者提出了一种全新的深度自回归模型 GraphRNN。写作动机如下:1. 因为需要表示 node 之间的关系,所以 space 大;2. node 的表示顺序多种多样;3. node 的生成顺序需要依赖已经生成的 node 顺序。

▲ 论文模型:点击查看大图

@xuzhou 推荐

#Time Series Analysis

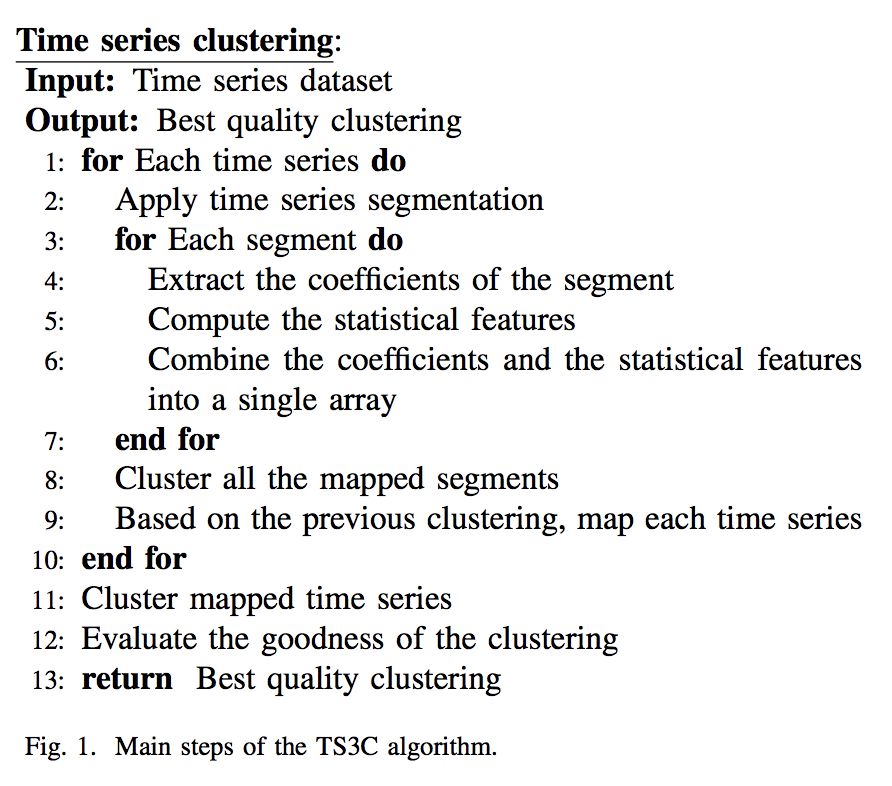

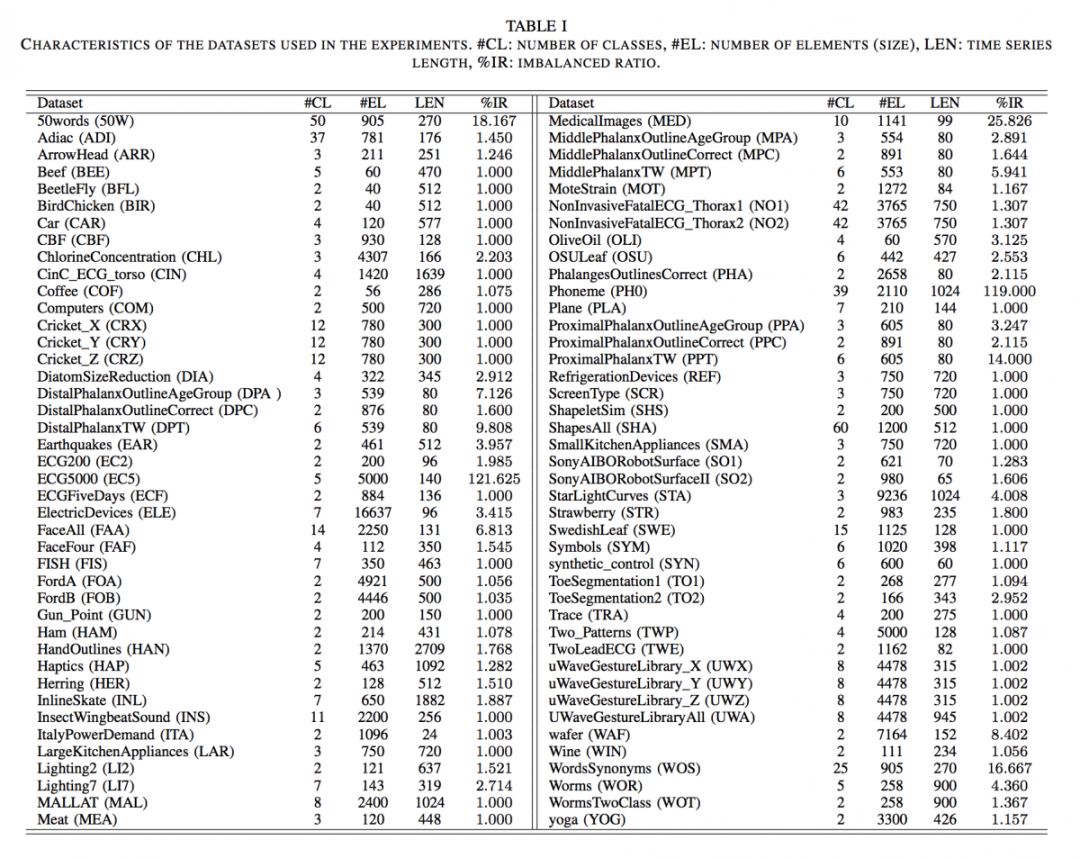

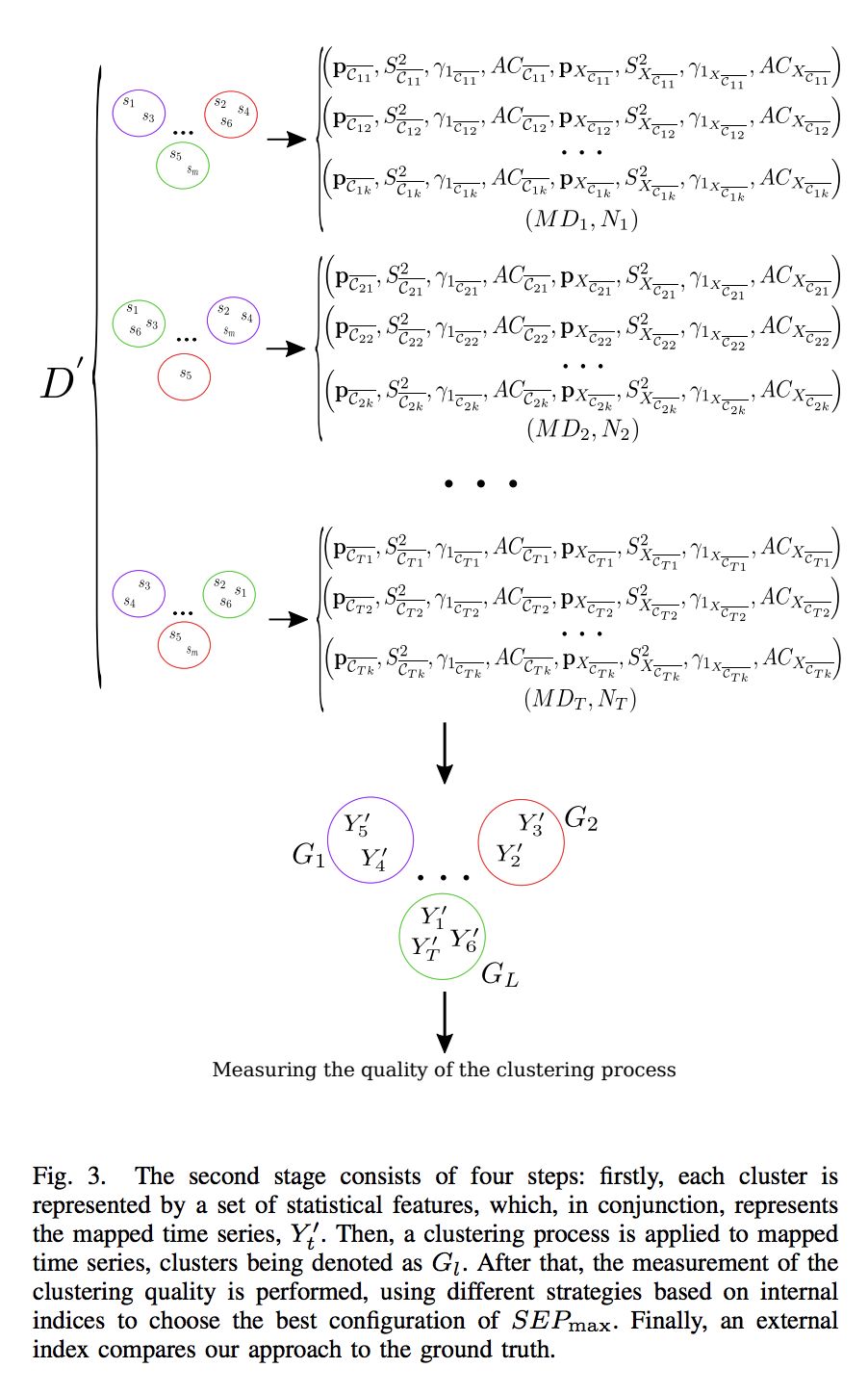

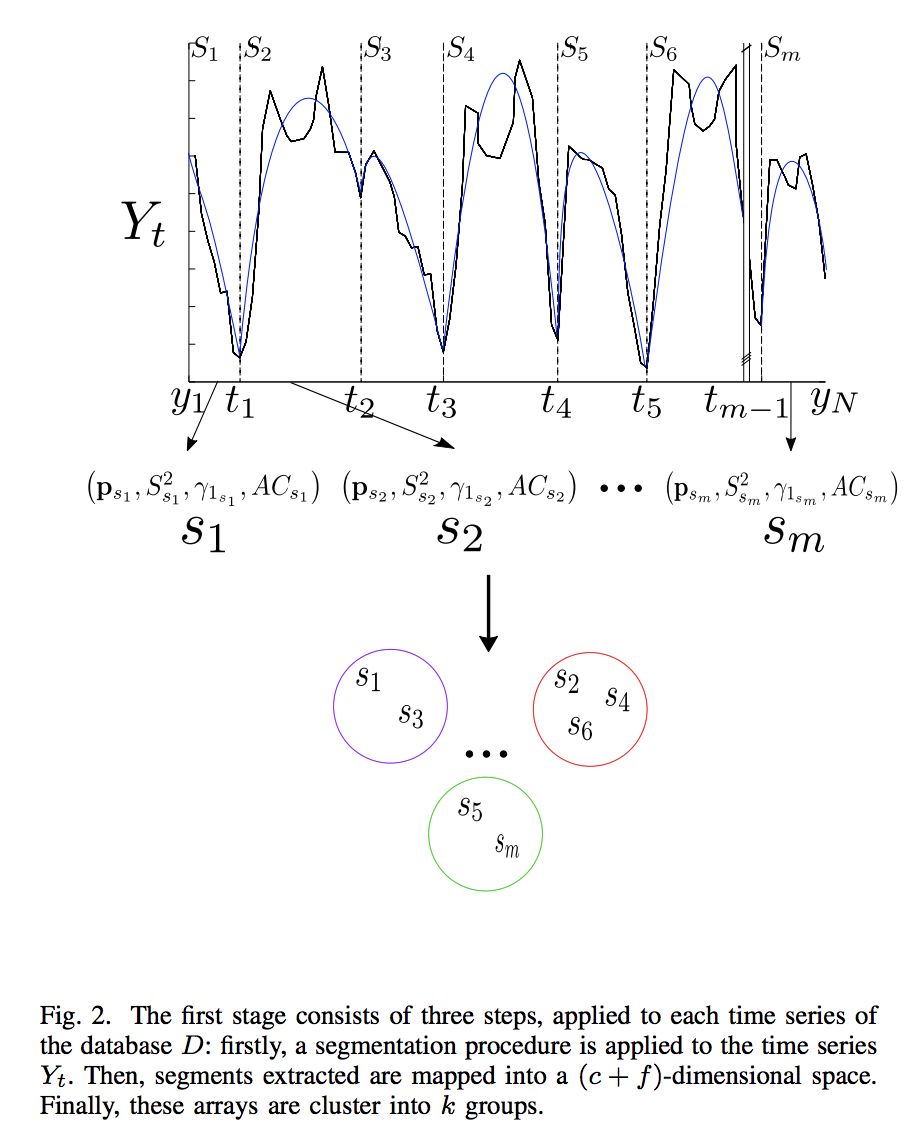

时间序列聚类是根据序列之间的相似性或者特征进行分类。之前的方法通常是将特定的距离衡量方法和标准的聚类算法结合起来。但是这些方法没有考虑每一个序列的子序列之间的相似性,这可以被用来更好地比较时间序列。

本文提出了一个新颖的基于两个聚类步骤的聚类算法。第一步,对每个时间序列进行最小平方多项式分割,该技术是基于逐渐变大窗口技术并返回不同长度的分割。然后基于模型近似分割和统计特征系数将所有的分割被映射到相同的维度空间。第二步,对所有时间序列对象进行组合。作者考虑到了算法自动调整主要参数的特点。实验证明了该方法的优越性。

▲ 论文模型:点击查看大图

@paperweekly 推荐

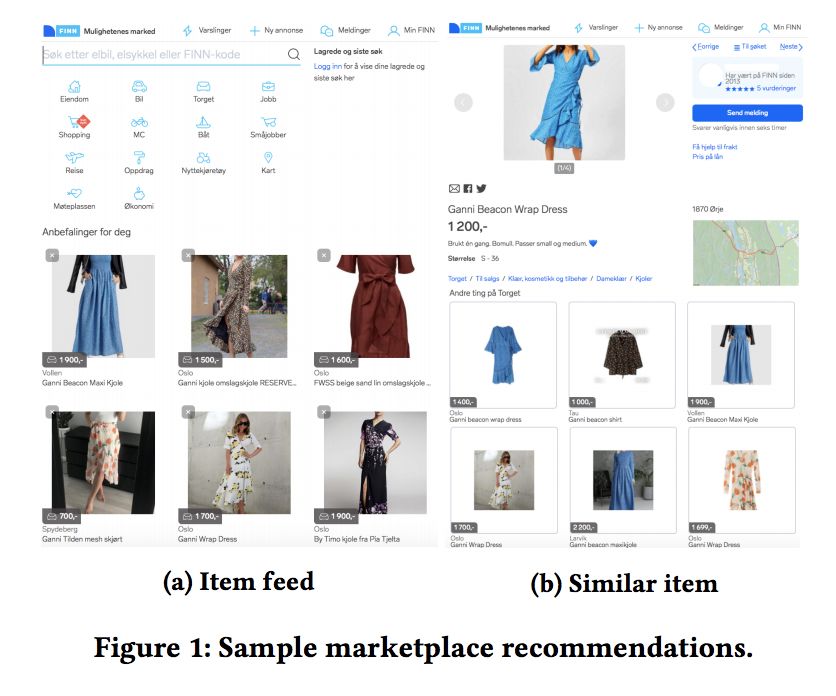

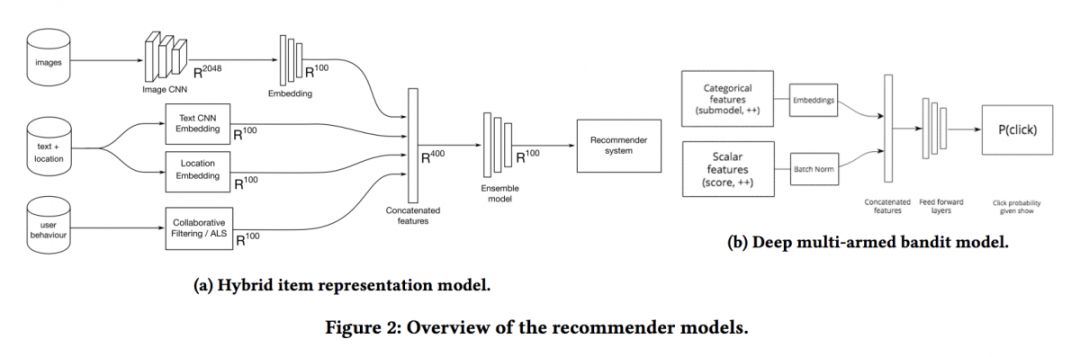

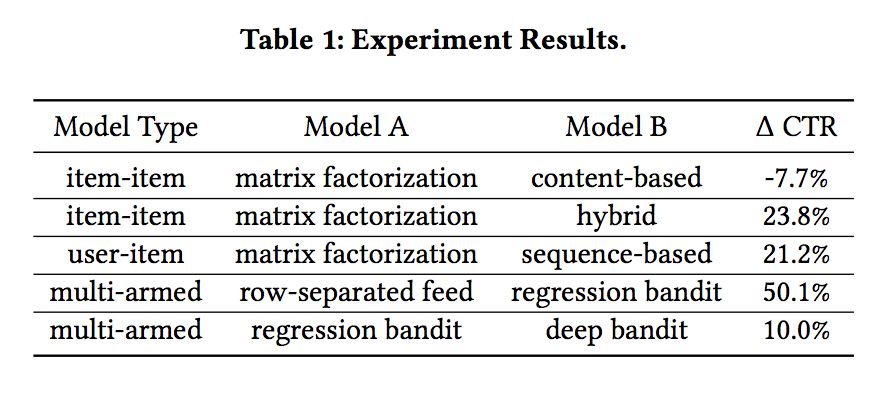

#Recommender System

本文是 Schibsted Media Group 发表于 RecSys 2018 的工作。论文关注的问题是推荐系统在二手市场上的应用,作者通过在线实验对三种基于深度神经网络的推荐模型进行了基准测试,对比它们在生产环境中的性能表现。这三种模型分别为混合项目-项目推荐器、基于序列的用户项目推荐器以及一种更高级的多臂bandit算法。

结果表明,在冷启动和基于序列的模型中,将协同过滤和内容特性相结合可以更好地表示项目。此外,作者还在其他推荐算法的基础上,将bandit作为更高级的再排序工具,这种方法对于利用上下文信息和组合多个业务领域的推荐系统非常有用。

▲ 论文模型:点击查看大图

@zhangjun 推荐

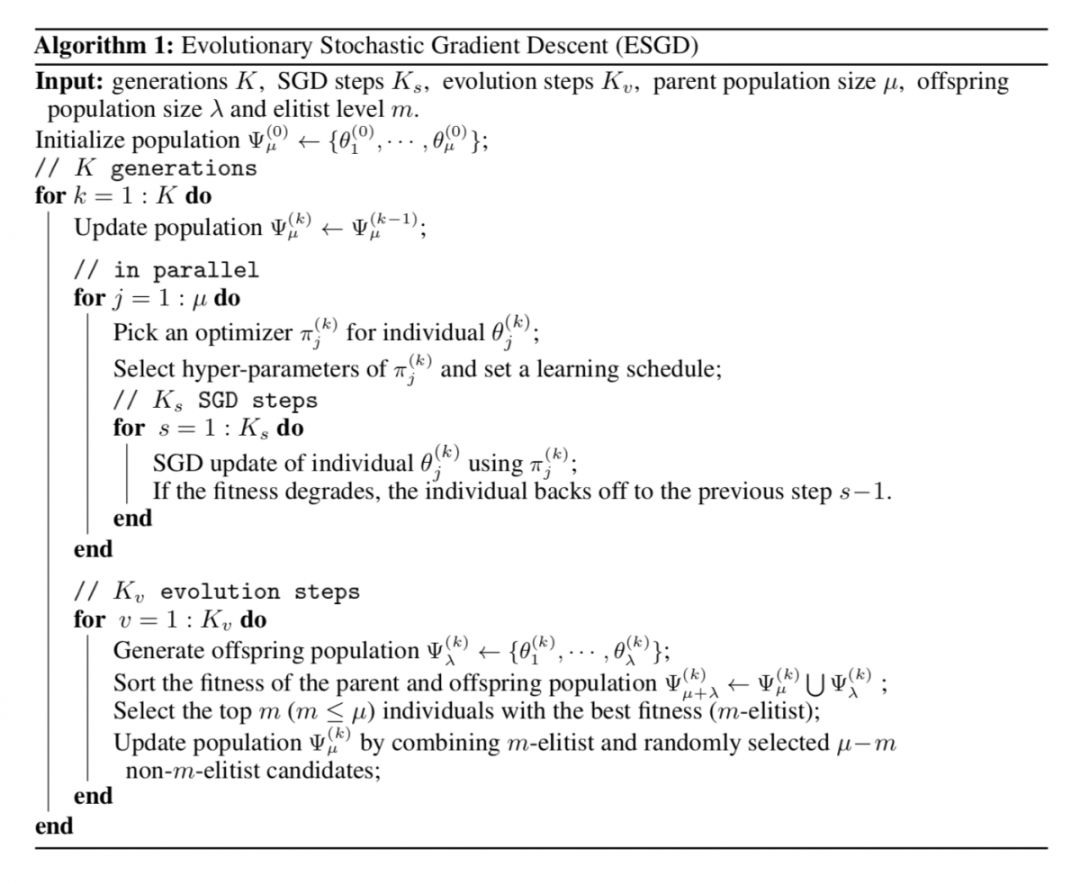

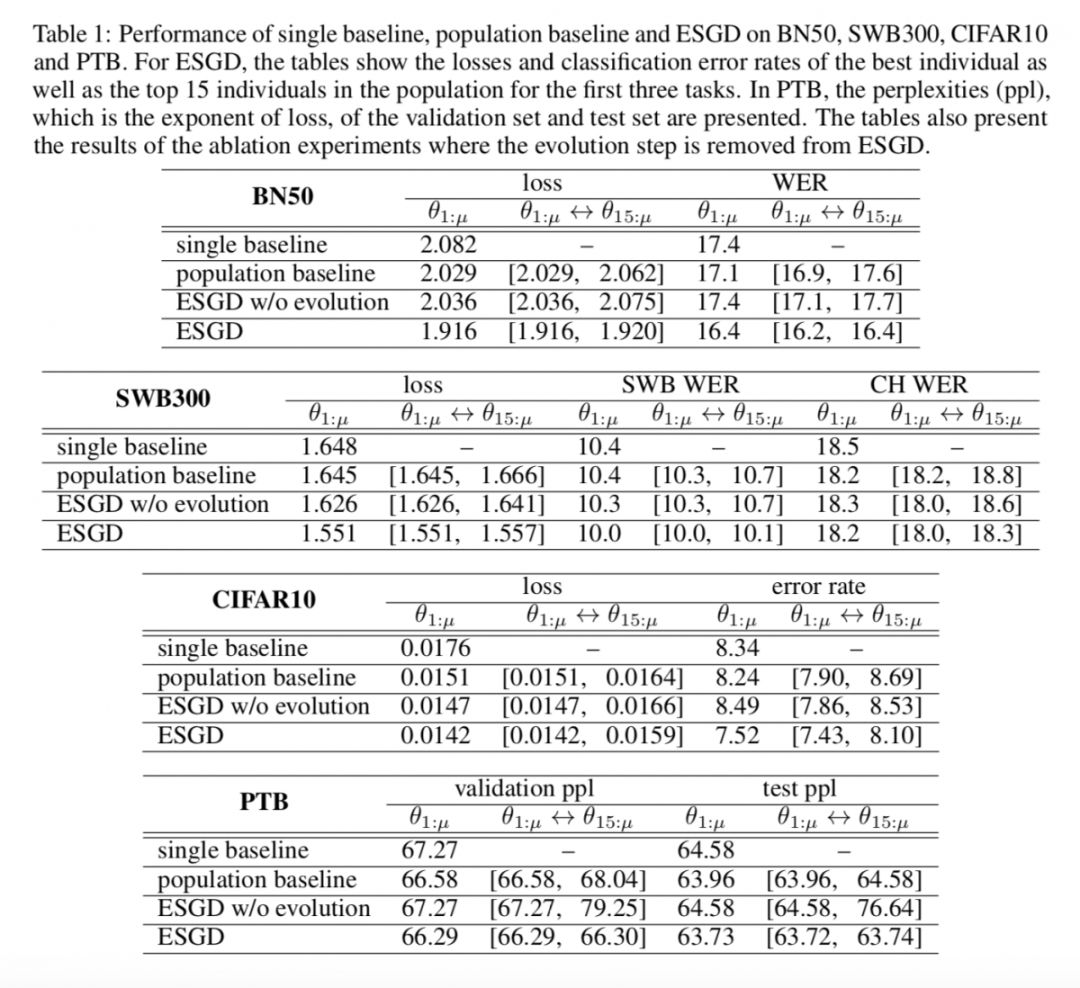

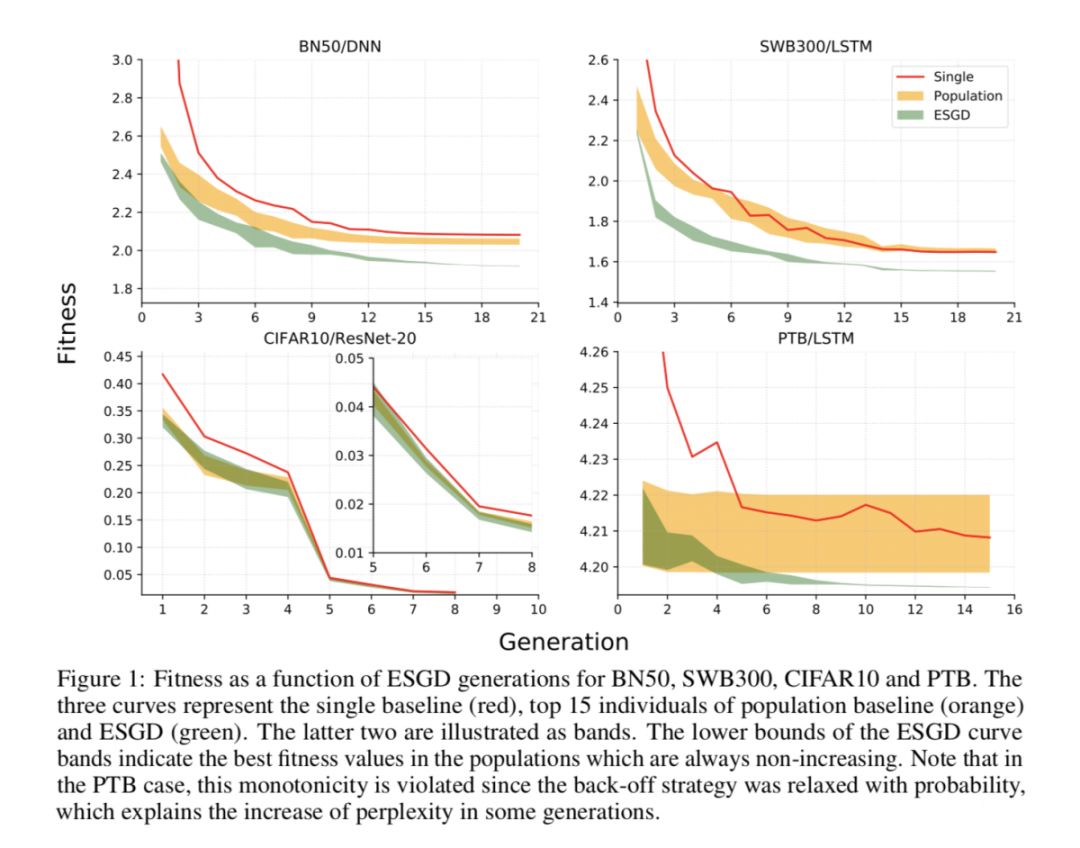

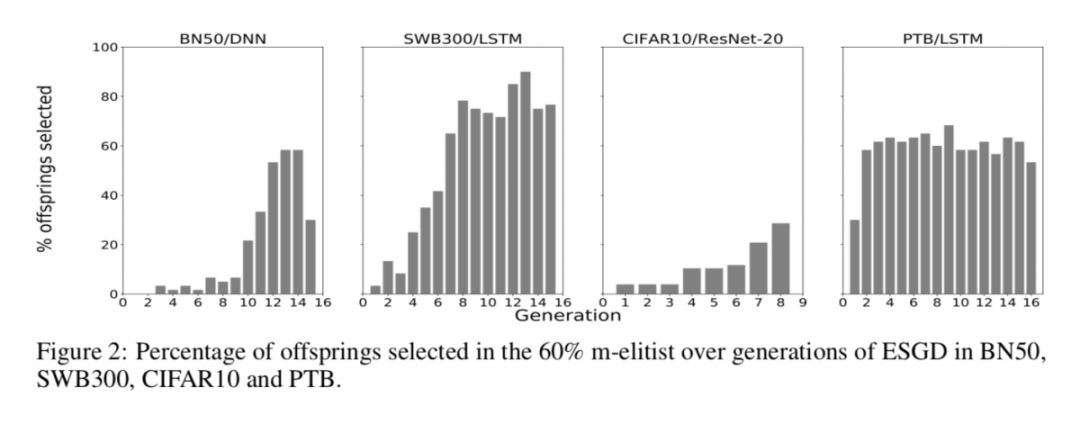

#Evolutionary Algorithm

本文是 IBM Research AI 发表于 NeurIPS 2018 的工作,亮点在于将 SGD 和进化算法融合起来,提高机器学习优化算法的有效性。

SGD 是一种常见的基于目标函数梯度的算法,常用于机器学习和深度学习模型参数学习,优化效率较高,但容易陷入局部最优解;而进化算法是一种全局优化算法,只要进化代数足够大,总会找到全局最优解,但计算效率相对低下。基于此,本文提出了两者结合的优化框架,并在 CV、NLP、ASR 任务上进行了测试,验证了本文方法的有效性。

▲ 论文模型:点击查看大图

@ZSCDumin 推荐

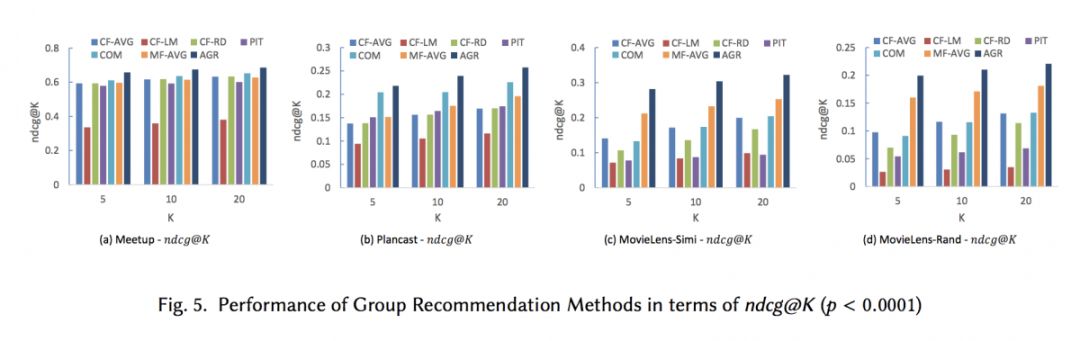

#Recommender System

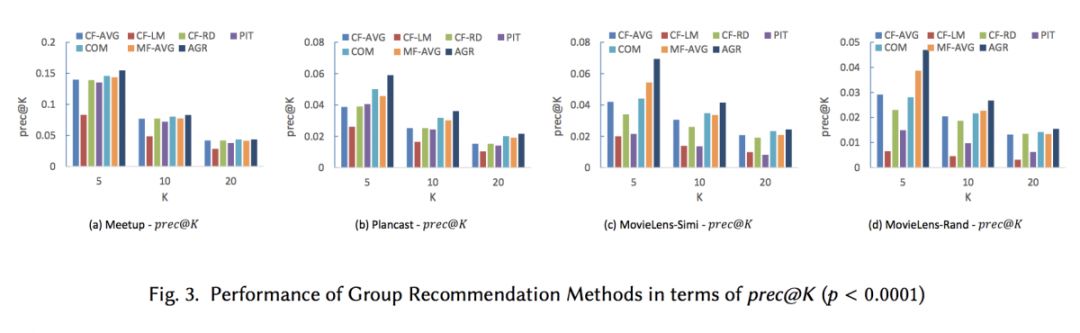

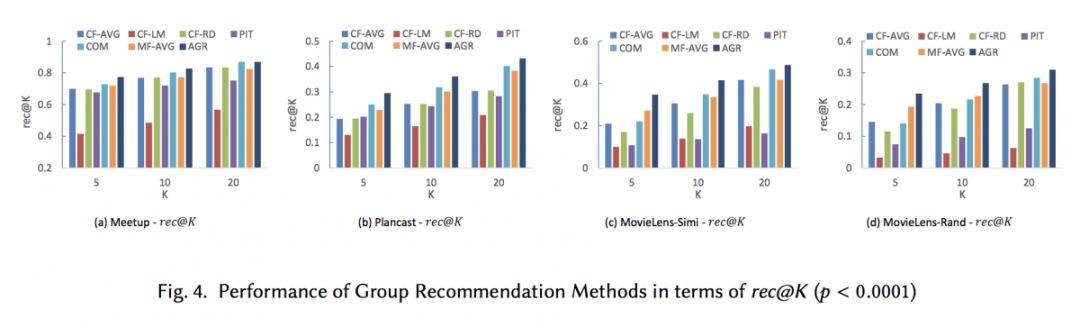

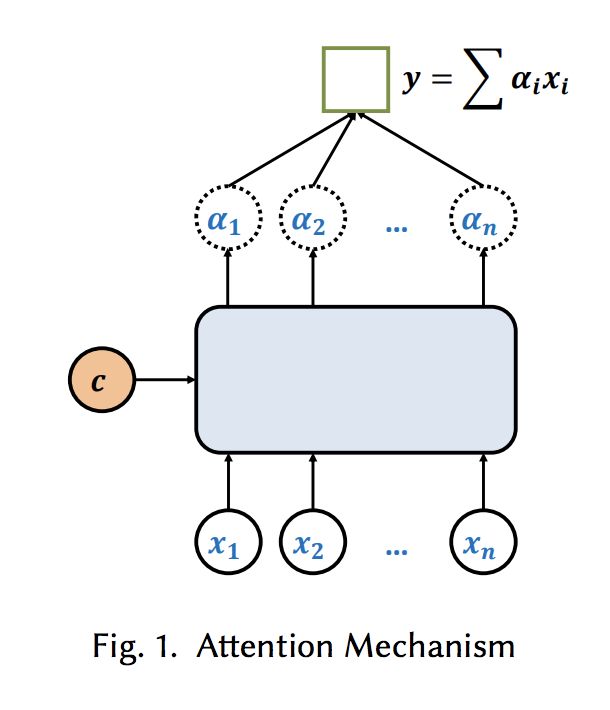

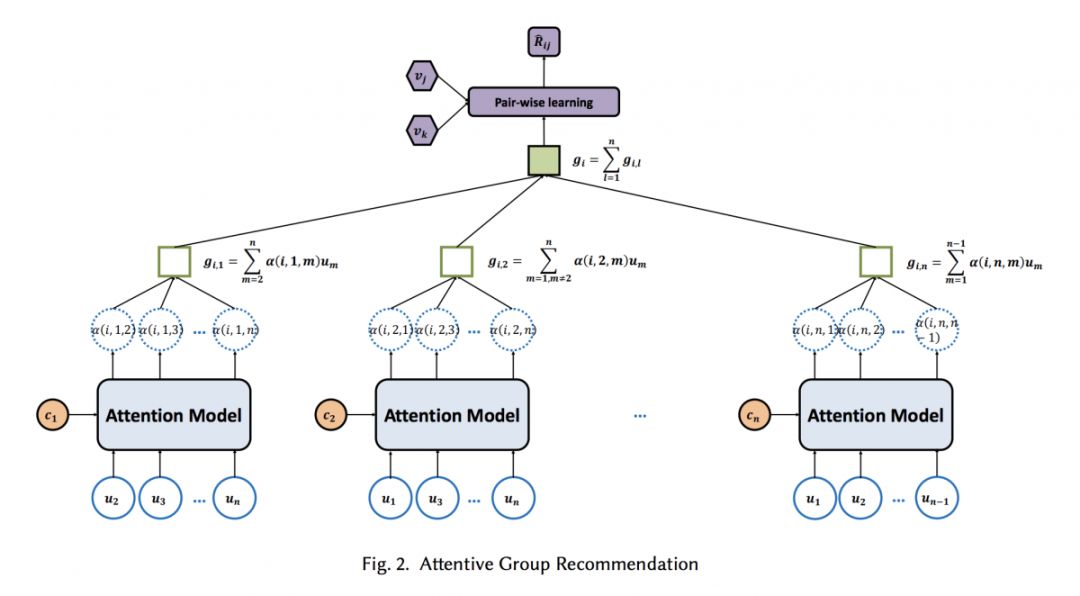

本文来自南洋理工大学。作为个体的用户和群组成员的行为是不同的,作者基于用户评级历史的深度学习技术,提出了一个注意力群体推荐模型来解决群体推荐问题,模型自动学习群组中的每个用户的影响权重并根据其成员的权重偏好为群组推荐项目。虽然基于图和概率的模型已经得到了广泛的研究,但本文是第一个将 Attention 机制应用到群体推荐中的。

▲ 论文模型:点击查看大图

本期所有入选论文的推荐人

均将获得PaperWeekly纪念周边一份

▲ 深度学习主题行李牌/卡套 + 防水贴纸

礼物领取方式

推荐人请根据论文详情页底部留言

添加小助手领取礼物

*每位用户仅限领取一次

想要赢取以上周边好礼?

点击阅读原文即刻推荐论文吧!

点击以下标题查看往期推荐:

让你的论文被更多人看到

如何才能让更多的优质内容以更短路径到达读者群体,缩短读者寻找优质内容的成本呢? 答案就是:你不认识的人。

总有一些你不认识的人,知道你想知道的东西。PaperWeekly 或许可以成为一座桥梁,促使不同背景、不同方向的学者和学术灵感相互碰撞,迸发出更多的可能性。

PaperWeekly 鼓励高校实验室或个人,在我们的平台上分享各类优质内容,可以是最新论文解读,也可以是学习心得或技术干货。我们的目的只有一个,让知识真正流动起来。

📝 来稿标准:

• 稿件确系个人原创作品,来稿需注明作者个人信息(姓名+学校/工作单位+学历/职位+研究方向)

• 如果文章并非首发,请在投稿时提醒并附上所有已发布链接

• PaperWeekly 默认每篇文章都是首发,均会添加“原创”标志

📬 投稿邮箱:

• 投稿邮箱:hr@paperweekly.site

• 所有文章配图,请单独在附件中发送

• 请留下即时联系方式(微信或手机),以便我们在编辑发布时和作者沟通

🔍

现在,在「知乎」也能找到我们了

进入知乎首页搜索「PaperWeekly」

点击「关注」订阅我们的专栏吧

关于PaperWeekly

PaperWeekly 是一个推荐、解读、讨论、报道人工智能前沿论文成果的学术平台。如果你研究或从事 AI 领域,欢迎在公众号后台点击「交流群」,小助手将把你带入 PaperWeekly 的交流群里。

▽ 点击 | 阅读原文 | 获取更多论文推荐