深度学习预测RNA二级结构,蚂蚁金服提出端到端模型E2Efold

选自openreview.net

在新冠状肺炎的疫情防控之战中,人工智能技术正发挥着重要作用。本文将介绍一种用于预测 RNA 二级结构的端到端深度学习模型 E2Efold,在结构预测方面具有显著更优表现,同时大大缩短新冠病毒 RNA 二级结构预测时间,为病毒研究、药物筛选、疫苗研制等工作提供更多助力。这项成果来自蚂蚁金服的研究团队,目前这篇论文已被 ICLR 2020 接收为 Talk 论文。

。

这个能量函数要么是通过基于物理学的热力学实验估计的,要么就是通过数据学习到的。

。

这个能量函数要么是通过基于物理学的热力学实验估计的,要么就是通过数据学习到的。

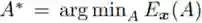

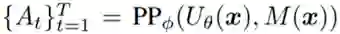

,然后可以用端到端的方式从数据中学习得到 θ。

此外,还可以通过直接优化相关的损失来拟合这个前向模型。

,然后可以用端到端的方式从数据中学习得到 θ。

此外,还可以通过直接优化相关的损失来拟合这个前向模型。

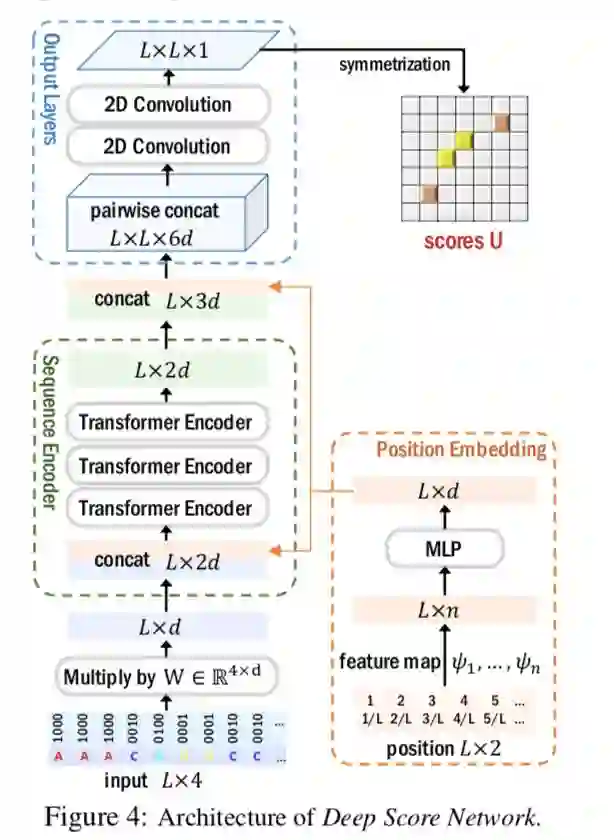

都表示核苷酸 x_i 和 x_j 的配对分数。

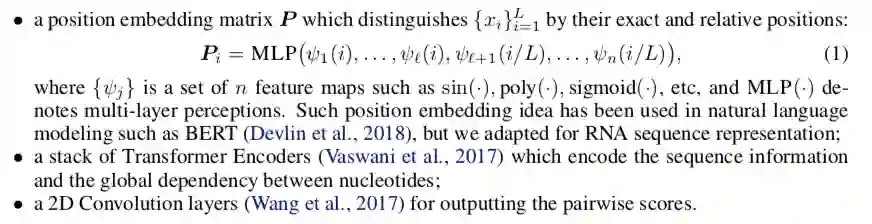

这个网络的输入 x 是 L × 4 维的 one-hot 嵌入。

图 4 展示了 U_θ 的具体架构。

都表示核苷酸 x_i 和 x_j 的配对分数。

这个网络的输入 x 是 L × 4 维的 one-hot 嵌入。

图 4 展示了 U_θ 的具体架构。

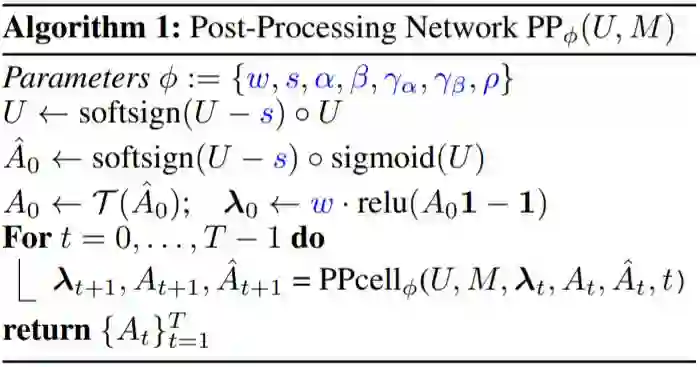

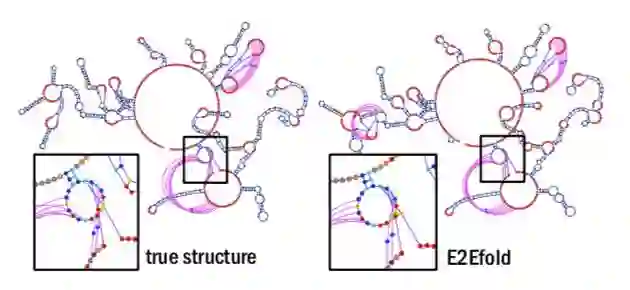

时 A_ij = 1。

但是,A_ij 的这种逐项独立预测可能得到一个有违可行 RNA 二级结构约束的矩阵 A。

时 A_ij = 1。

但是,A_ij 的这种逐项独立预测可能得到一个有违可行 RNA 二级结构约束的矩阵 A。

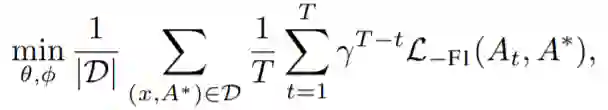

,γ ≤ 1 是折现因子。

,γ ≤ 1 是折现因子。

登录查看更多