编辑:好困 David

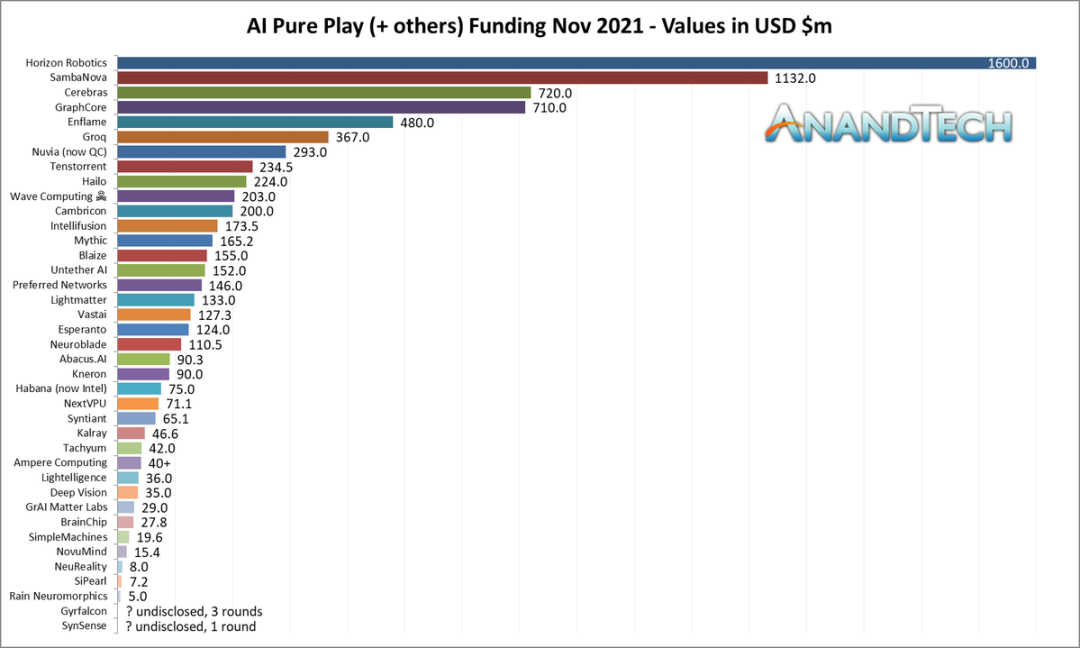

【新智元导读】刚刚,明星AI芯片企业Cerebras宣布获得2.5亿美元F轮融资,投后估值超40亿美元。目前该公司拥有世界最大的计算机芯片WSE-2,和世界最快的AI计算机集群CS-2,是英伟达在AI领域的强劲对手。

这次是曾打造出世界最大芯片、世界最快AI计算机的Cerebras。

当地时间周三,Cerebras宣布,通过其Alpha Wave Ventures和Abu Dhabi Growth获得Edge Capital领投的2.5亿美元F轮融资。

参与本轮融资的其他投资方还包括Altimeter Capital、Benchmark Capital、Coatue Management、Eclipse Ventures、Moore Strategic Ventures和VY Capital。

计入此次融资后, Cerebras 的总融资额达到7.5亿美元,投后估值超过40亿美元。

此前,Cerebras在2019年的E轮融资中估值为24亿美元。

Cerebras联合创始人兼首席执行官Andrew Feldman表示:

「Cerebras团队和我们非凡的客户已经取得了令人难以置信的技术突破,正在改变人工智能,使以前无法想象的成为可能。」

「这笔资金使我们能够将全球领导地位扩展到新的地区,使人工智能进一步普及,开创高性能AI计算新时代,解决当今最紧迫的社会挑战,如药物发现、气候变化等问题。」

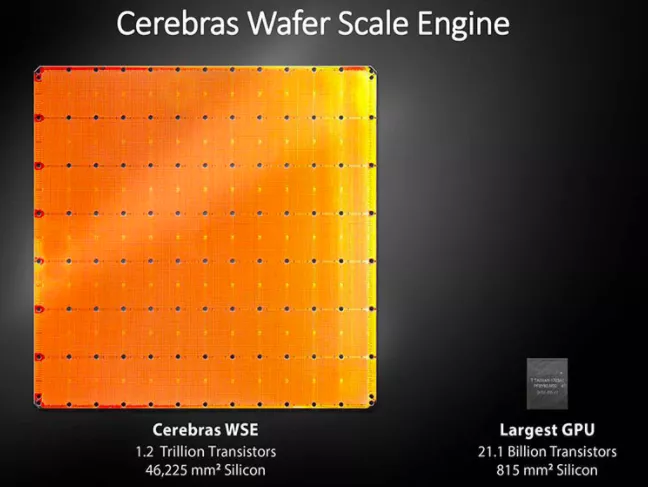

目前,Cerebras与AI芯片巨头英伟达处于竞争状态,都在力图围绕世界上最大芯片构建完整计算机系统和服务,Cerebras称之为「Wafer-Scale」引擎。

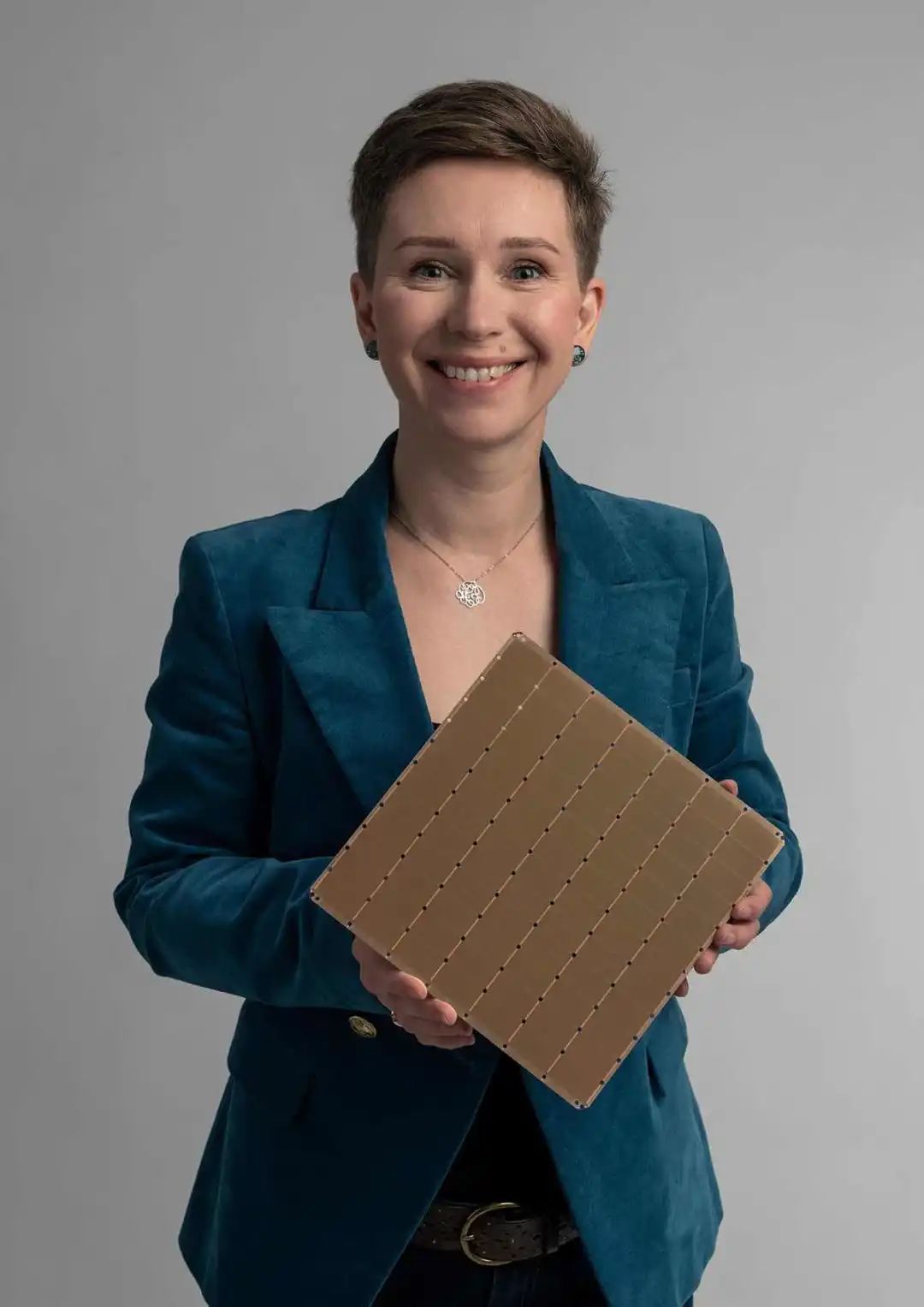

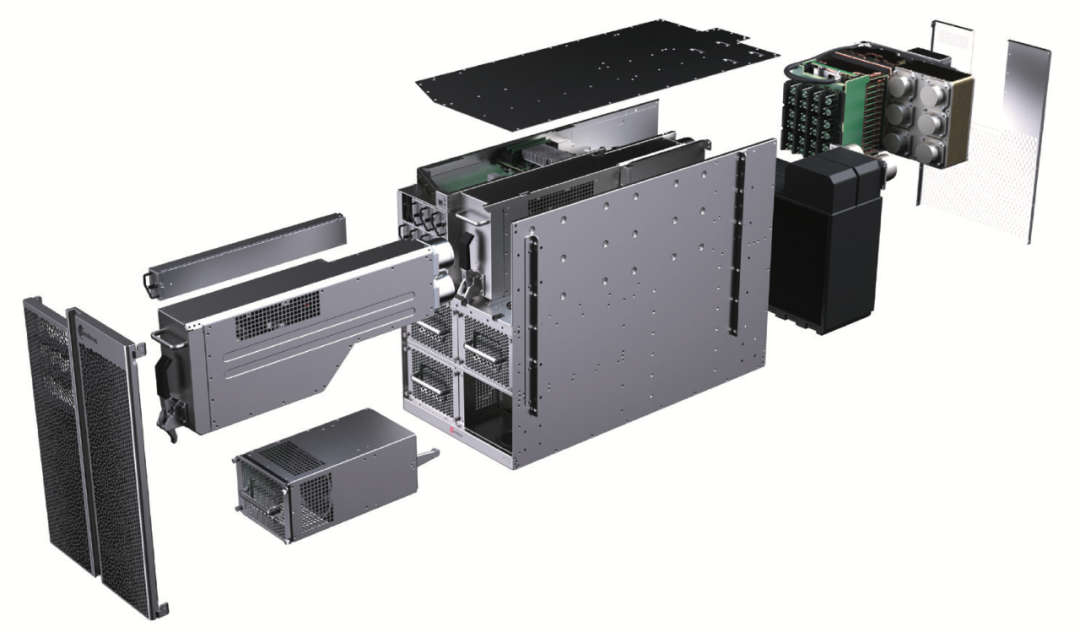

Cerebras打造的CS-2是目前世界上最快的AI计算机。该机由Cerebras晶圆级引擎WSE-2提供核心算力。

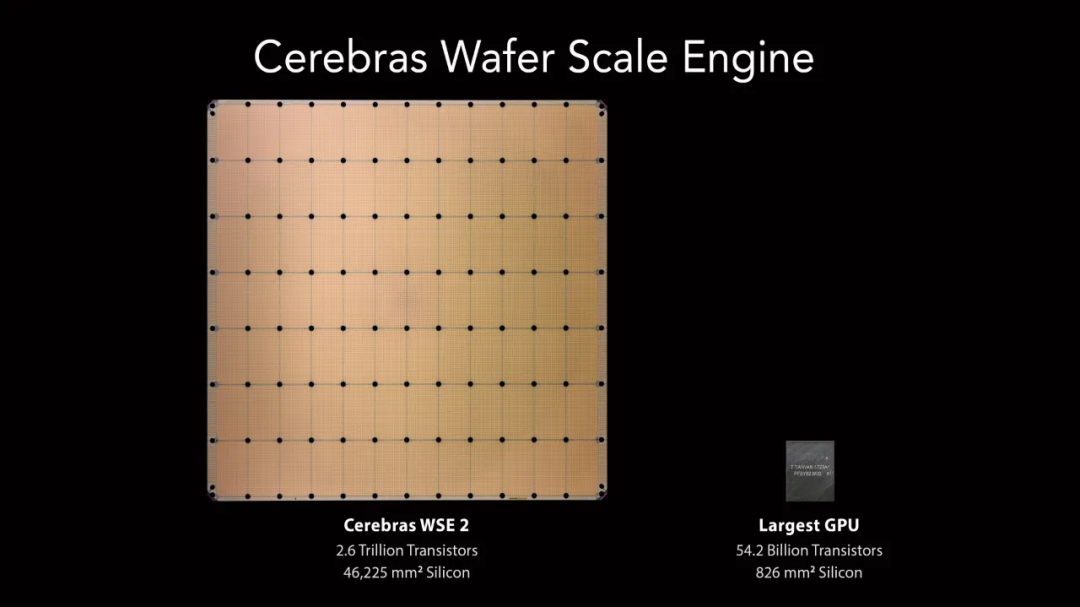

WSE-2是有史以来最大的芯片,包含2.6万亿个晶体管,面积超过46225平方毫米。

相比之下,英伟达最大的GPU只有540亿个晶体管,面积为815平方毫米。

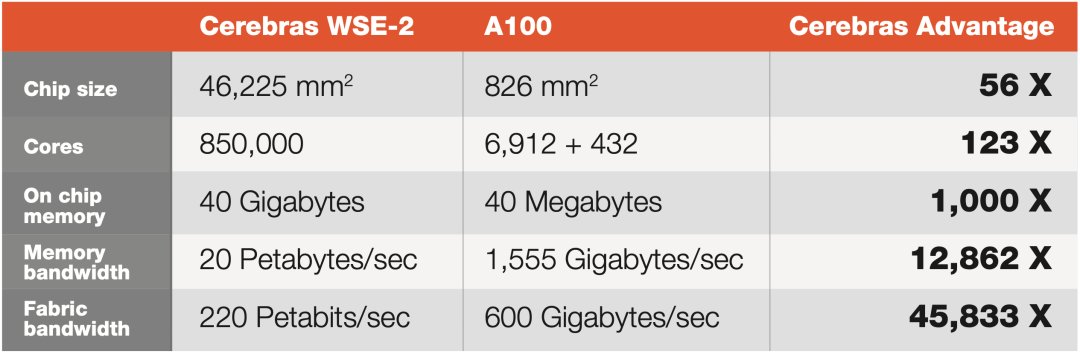

此外,WSE-2还有着竞品123倍的计算内核,1000倍的高速片上内存,12862倍的内存带宽和45833倍的结构带宽。

对于AI任务来说,大型芯片可以更快地处理信息,在更短的时间内产生答案。

Cerebras WSE-2与英伟达A100 GPU的性能参数对比

今年9月,该公司宣布与云运营商Cirrascale建立了合作伙伴关系,提供CS-2的出租服务。

Cerebras表示,公司的基础设施能够计算包含数万亿个参数的超大型神经网络。而且,在非AI问题上,比如物理学和其他基础科学问题上,公司也取得了巨大成果。

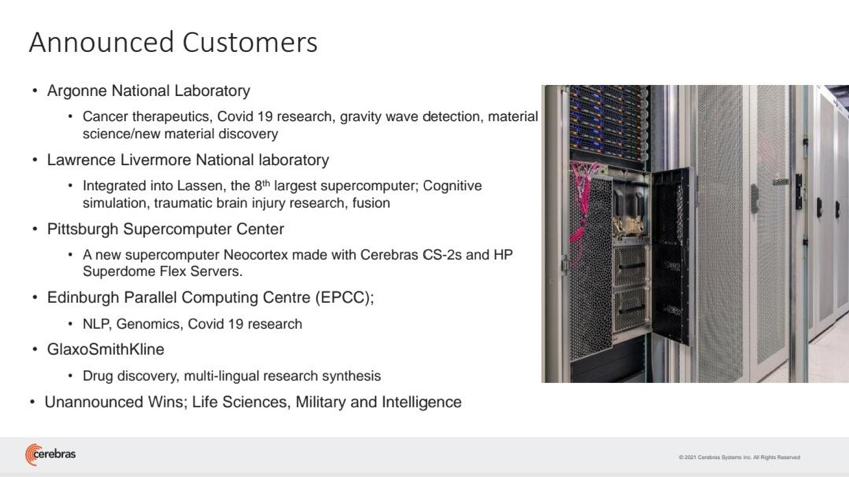

Cerebras 最初是为美国国家研究实验室的客户服务的,后来扩展到更多商业企业。

目前Cerebras 客户名单包括阿贡国家实验室、劳伦斯利弗莫尔国家实验室、匹兹堡超级计算中心的Neocortex AI超级计算机EPCC、爱丁堡大学超级计算中心、东京电子设备公司、制药巨头葛兰素史克、阿斯利康等。

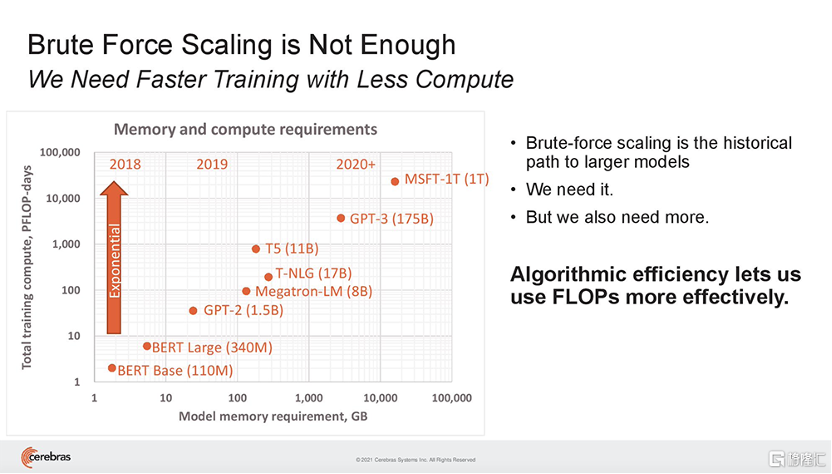

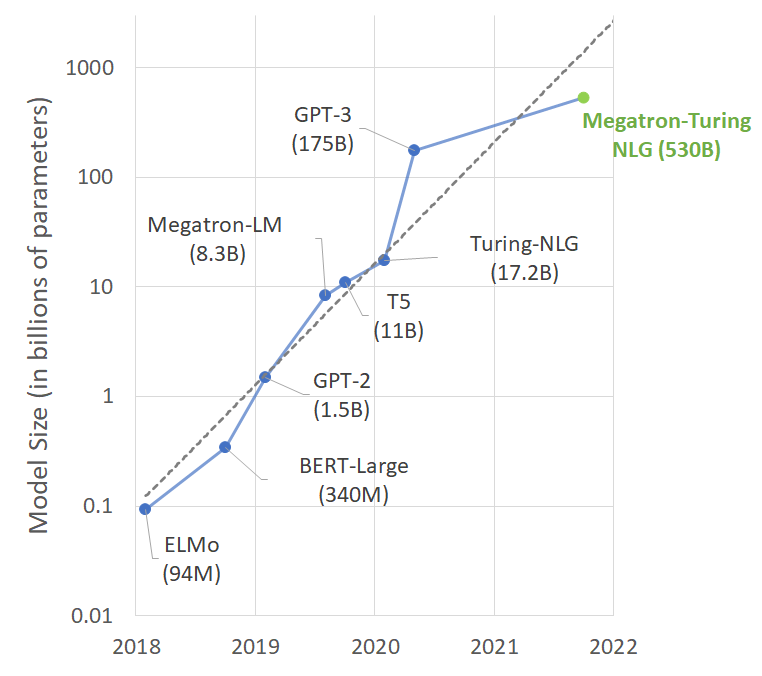

近几年,神经网络的规模一直在稳步增长。在过去的一年里,OpenAI的GPT-3自然语言处理程序,一度以1750亿参数成为世界上最大的神经网络,后来很快被谷歌的1.6万亿参数模型Switch Transformer超过。

![]()

如此庞大的模型会遇到算力瓶颈问题,系统需求已经远远超出了单个计算机系统的处理能力。单个GPU的内存约为16GB,而GPT-3等模型所需的内存往往高达几百TB。

像过去一样,单纯进行简单粗暴的算力扩展,已经难以满足需求。

因此,系统集群变得至关重要。 而如何实现集群,是一个最关键的问题。

要让每台机器都保持忙碌,否则系统的利用率就会下降。比如,今年英伟达、斯坦福和微软打造了一个1万亿参数的GPT-3,并将其扩展到3072个GPU上。但是系统的利用率,仅为机器理论上应该能够达到的峰值操作的52%。

今年8月,Cerebras发布了世界上第一个大脑级AI解决方案——一个可以支持120万亿参数AI模型的单一系统。

除了用到最大芯片,Cerebras还揭露了4项新技术。

这种技术组合可以轻松组建大脑规模的神经网络,并将工作分配到人工智能优化的核心集群上。

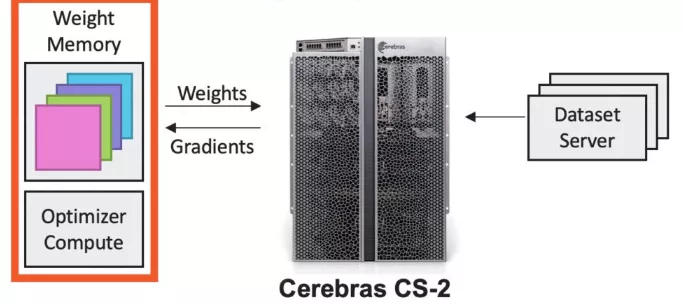

Cerebras Weight Streaming:分解计算和内存

这是一种新的软件执行模式,可以将计算和参数存储分解,使规模和速度得以独立且灵活地扩展,同时解决了小型处理器集群存在的延迟和内存带宽问题。

这项技术首次实现了在芯片外存储模型参数,同时提供与在芯片上相同的训练和推理性能。

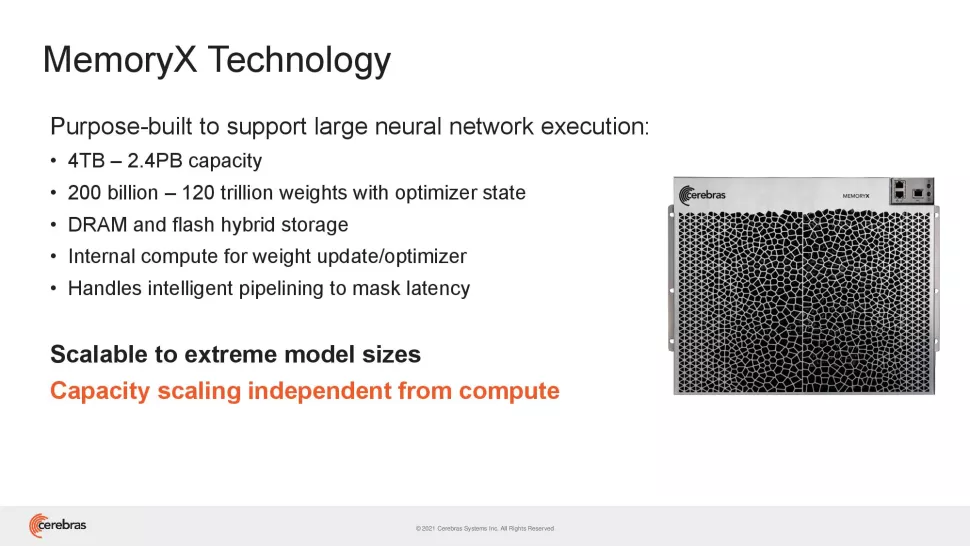

Cerebras MemoryX:启用百万亿参数模型

这是一种一内存扩展技术,它使模型参数能够存储在芯片外,并有效地流式传输到CS-2上,实现同在芯片上那样的性能。

这一架构灵活性极强,支持4TB到2.4PB的存储配置,2000亿到120万亿的参数大小。

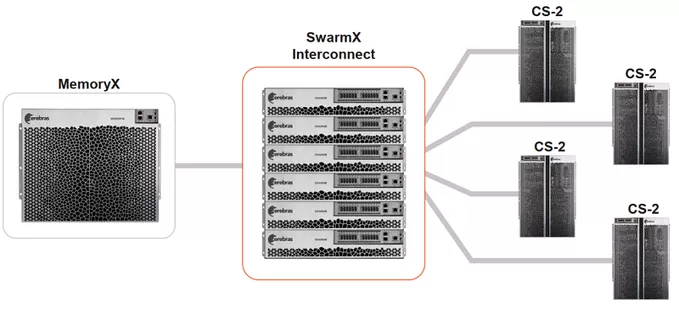

Cerebras SwarmX:提供更大、更高效的集群

这是一种人工智能优化的高性能通信结构,可将Cerebras的芯片内结构扩展到芯片外,从而扩展AI集群,而且使其性能实现线性扩展。

也就是说,10个CS-2有望实现比单个CS-2快10倍的相同解决方案,鉴于每个CS-2提供85万个AI优化内核,Cerebras便可连接1.63亿个AI优化内核集群。

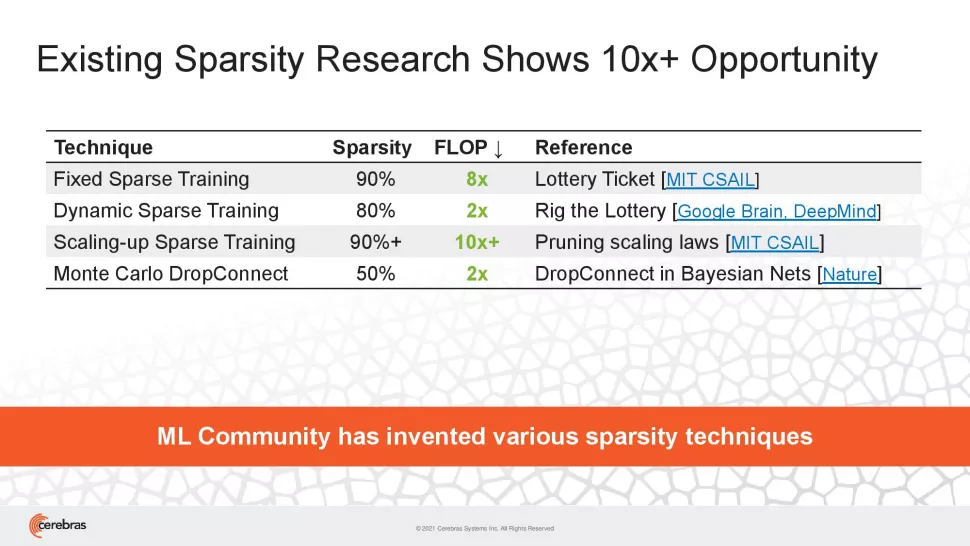

Selectable Sparsity:缩短时间

Cerebras架构独有的数据流调度和巨大的内存带宽,使这种类型的细粒度处理能够加速所有形式的稀疏性。

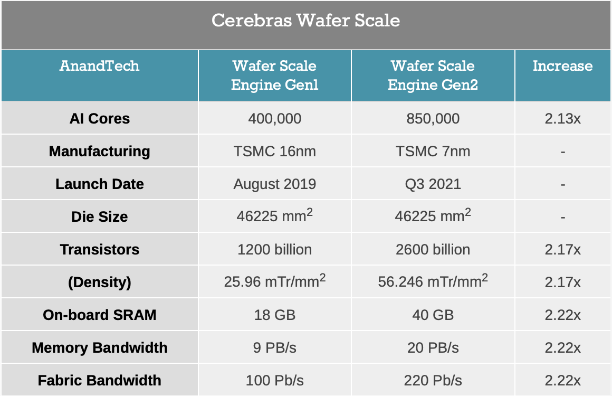

早在2019年,Cerebras就发布了第一代WSE(Wafer Scale Engine)芯片。

通常情况下,芯片制造商会将12英寸的硅切成薄片,切完后,晶圆片会继续被切割成数百个独立的小芯片,然后在这些小芯片上集成晶体管。而WSE-1则是直接「生长」在一整块晶圆上。

作为当时最大的AI芯片,WES-1有40万个AI可编程内核和1.2万亿个晶体管,使用台积电16nm工艺制程。

与传统芯片相比,WSE还包含3000倍的高速片上存储器,并具有10000倍的存储器带宽。WSE的总带宽为每秒100petabits。

当时最强的英伟达GA100核心,面积超过800平方毫米、有540亿晶体管,然而在Cerebras的WSE-1芯片面前,GA100也得叫爸爸。

今年4月,Cerebras再次推出最新的Wafer Scale Engine 2(WSE-2)芯片,达到了破纪录的2.6万亿个晶体管和85万颗AI内核,采用台积电的7nm工艺制造。

与第一代WSE芯片相比,WSE-2的晶体管数、内核数、内存、内存带宽和结构带宽等性能特征增加了一倍以上。

在先进工艺的支持下,Cerebras可以在同样的8x8英寸,面积约46225平方毫米的芯片中塞进更多的晶体管。

此外,台积电的7nm工艺可以让电路之间的宽度达到七十亿分之一米。

而这次的融资,也让Cerebras距离下一代5nm工艺更近了一步,毕竟制造芯片所需的光掩模成本,每一个将能达到数百万美元。

https://cerebras.net/news/cerebras-systems-raises-250m-in-funding-for-over-4b-valuation-to-advance-the-future-of-artificial-intelligence-compute/

https://venturebeat.com/2021/11/10/chip-developer-cerebas-bolsters-ai-powered-workload-capabilities-with-250m/

https://venturebeat.com/2019/08/19/cerebras-systems-unveils-a-record-1-2-trillion-transistor-chip-for-ai/

https://www.zdnet.com/article/ai-chip-startups-cerebras-nabs-250-million-series-f-round-at-over-4-billion-valuation/