清华学神吴佳俊在MIT新研究:让AI像婴儿一样理解世界

新智元报道

新智元报道

来源:news.mit.edu

编辑:肖琴

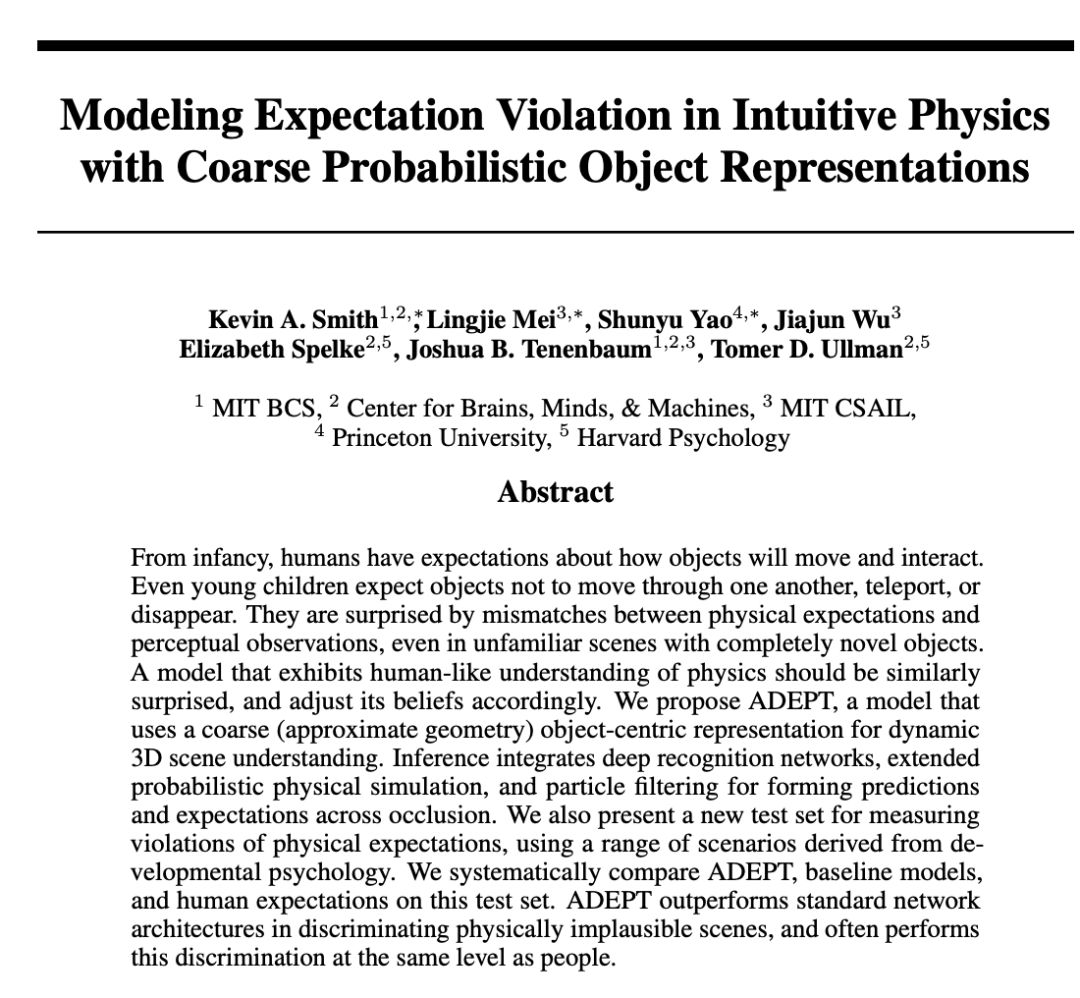

【新智元导读】MIT的研究人员设计了一个模型,展示了对物体应该如何运动的一些基本的“直觉物理学的理解。当场景中的物体做了一些意想不到的事情时,模型会记录下“surprise”,这可以用来构建更智能的人工智能,并反过来提供信息,以帮助科学家理解婴儿的认知。来新智元 AI 朋友圈和AI大咖一起讨论吧~

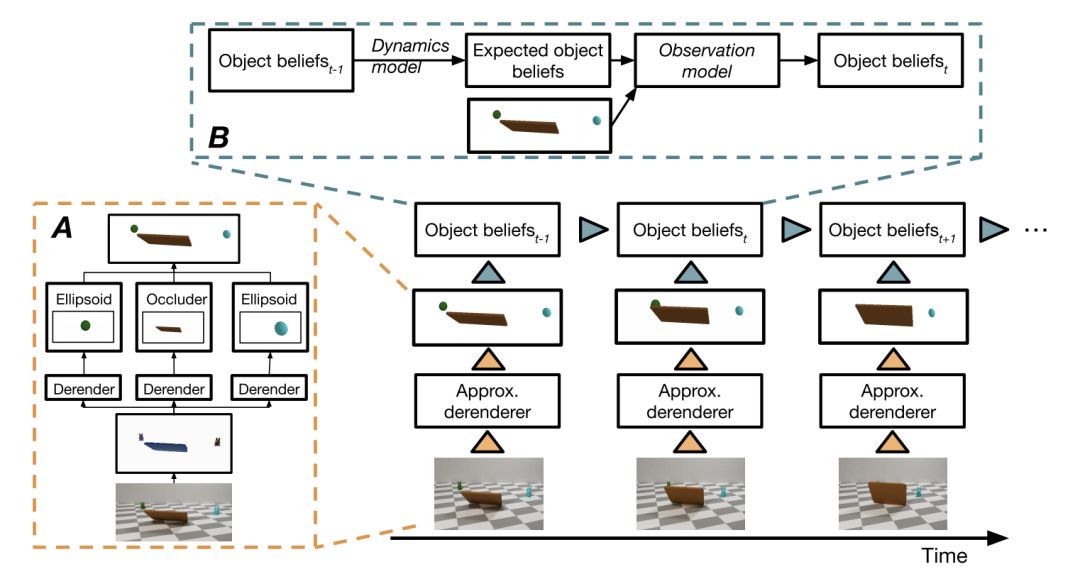

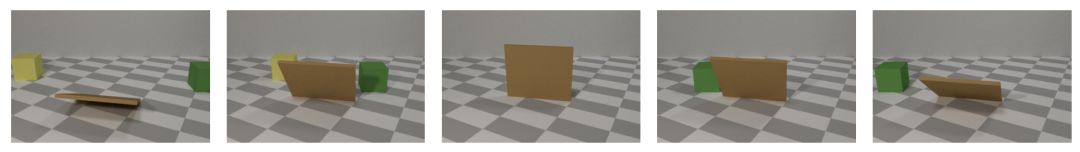

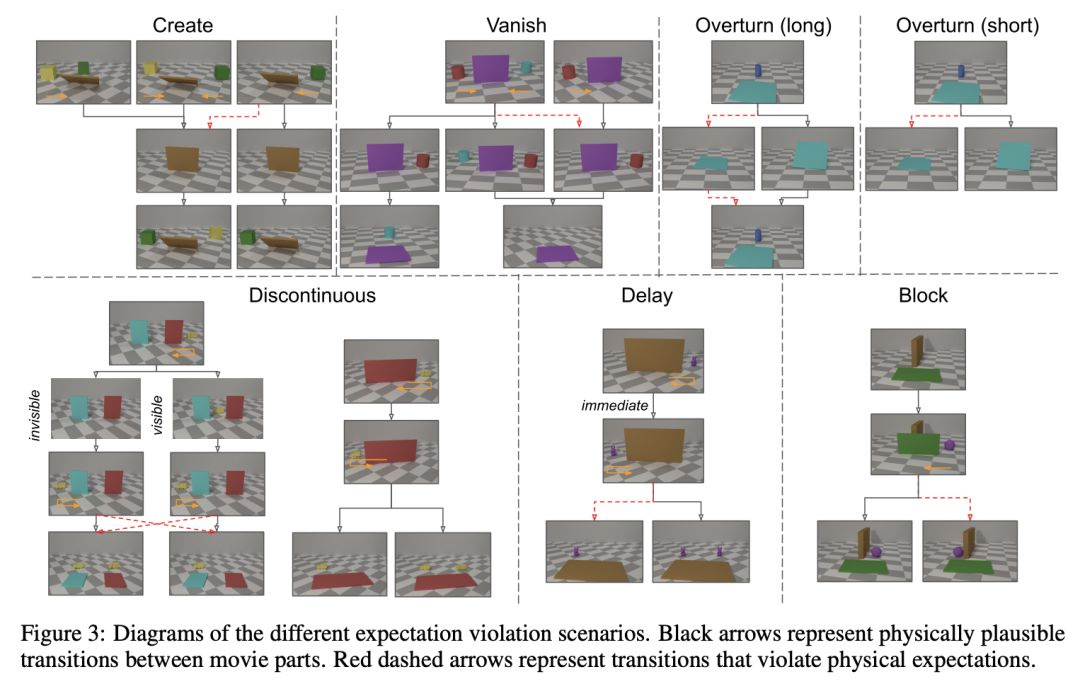

ADEPT依赖两大模块,像婴儿一样理解物理

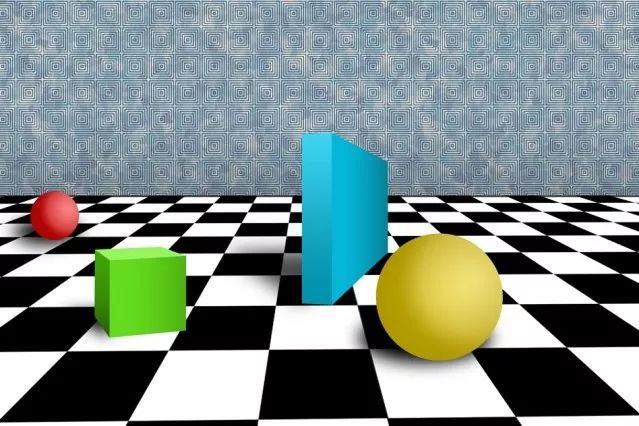

违反预期:AI对“凭空消失”的惊讶程度与人类特别匹配

-

与国内外一线大咖、行业翘楚面对面交流的机会 -

掌握深耕人工智能领域,成为行业专家 -

远高于同行业的底薪 -

五险一金+月度奖金+项目奖励+年底双薪 -

舒适的办公环境(北京融科资讯中心B座) -

一日三餐、水果零食

新智元邀你2020勇闯AI之巅,岗位信息详见海报:

登录查看更多

相关内容

专知会员服务

104+阅读 · 2019年10月22日