近期必读的五篇 NeurIPS 2020【元学习】相关论文

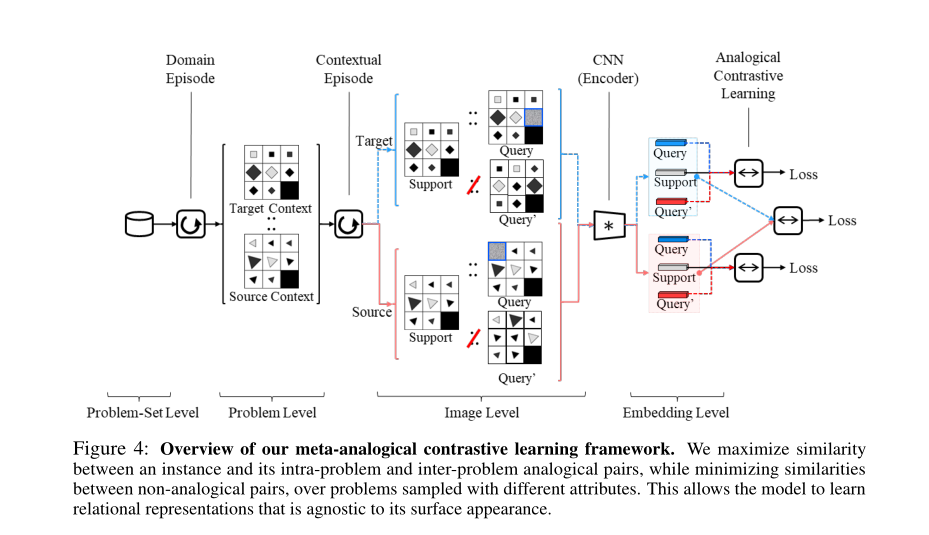

1. Few-shot Visual Reasoning with Meta-analogical Contrastive Learning

作者:Youngsung Kim, Jinwoo Shin, Eunho Yang, Sung Ju Hwang

摘要:尽管人类可以通过仅观察几个样本来解决需要逻辑推理的视觉难题,但它需要对大量样本进行训练,以使用最新的深度推理模型来在同一任务上获得相似的性能。在这项工作中,我们提出通过类比推理来解决这样的少样本抽象视觉推理问题,并且这是人类具有的识别两组数据之间结构或关系相似性的独特能力。具体来说,我们构造了两个不同问题实例的类比和非模拟训练对。后者是通过对原始问题(以前的问题)进行扰动或改组来创建的。然后,我们通过强制类比元素尽可能相似,同时最小化非类比元素之间的相似性,来提取成对的两个域中元素之间的结构关系。这种类比性的对比学习可以有效地学习给定抽象推理任务的关系表示。我们在RAVEN数据集上验证了我们的方法,该方法的性能优于最新方法,并且在缺乏训练数据时获得了更大的收益。我们进一步对具有不同属性的相同任务对我们的对比学习模型进行元学习,并表明它可以推广到具有未知属性的相同视觉推理问题。

网址:

https://www.zhuanzhi.ai/paper/92e64533747eb7dce1fbc96cbc68e03e

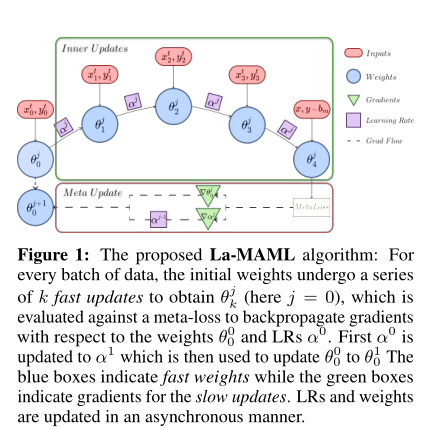

2. La-MAML: Look-ahead Meta Learning for Continual Learning

作者:Gunshi Gupta, Karmesh Yadav, Liam Paull

摘要:持续学习(continual learning)问题涉及训练模型,然而这些模型的能力有限,无法在一组顺序到达的未知数量的任务上表现良好。虽然元学习在减少新旧任务之间的干扰方面显示出巨大的潜力,但当前的训练过程往往很慢或离线,并且对许多超参数敏感。在这项工作中,我们提出了Look-ahead MAML(La-MAML),这是一种基于快速优化的元学习算法,用于在线持续学习,并有带少量的情节记忆。在元学习更新中对每个参数的学习率进行调制,使我们能够与以前有关超梯度和元下降的工作建立联系。与传统的基于先验的方法相比,该方法提供了一种更灵活,更有效的方法来减轻灾难性遗忘问题。La-MAML的性能优于其他基replay,基于先验和基于元学习的方法,并且可在现实世界中的视觉分类基准上持续学习。

网址:

https://www.zhuanzhi.ai/paper/9ead21408758c77704662fa717be42a1

3. Meta-learning from Tasks with Heterogeneous Attribute Spaces

作者:Tomoharu Iwata, Atsutoshi Kumagai

摘要:我们提出了一种异构元学习方法,该方法在具有各种属性空间的任务上训练模型,从而可以解决在给定标记实例的情况下属性空间与训练任务不同的未知任务(unseen tasks)。尽管已经提出了许多元学习方法,但是它们假定所有训练任务和目标任务共享相同的属性空间,并且当任务之间的属性大小不同时,它们将不适用。我们的模型使用推理网络从几个标记实例中推断每个属性和每个响应的潜在表示。然后,使用预测网络推断的表示来预测未标记实例的响应。即使属性和响应的大小在各个任务之间都不同,属性和响应表示也使我们能够基于属性和响应的特定于任务的属性进行预测。在我们使用合成数据集和OpenML中的59个数据集进行的实验中,我们证明了在使用具有异构属性空间的任务训练后,我们提出的方法可以预测新任务中给定标记实例的响应。

网址:

https://proceedings.neurips.cc/paper/2020/hash/438124b4c06f3a5caffab2c07863b617-Abstract.html

4. Model-based Adversarial Meta-Reinforcement Learning

作者:Zichuan Lin, Garrett Thomas, Guangwen Yang, Tengyu Ma

摘要:元强化学习(meta-RL)旨在从多个训练任务中有效地学习适应不可知测试任务的能力。尽管取得了成功,但已知现有的meta-RL算法对任务分配的变化很敏感。当测试任务分配与训练任务分配不同时,性能可能会大大降低。为了解决这个问题,本文提出了基于模型的对抗性元强化学习(AdMRL),旨在最大程度地降低最差情况的次优差距(最优回报与算法在自适应后获得的回报之间的差异),并使用基于模型的方法来处理一系列任务中的所有任务。我们提出了一个极小极大目标,并通过在学习固定任务的动力学模型与寻找当前模型的对抗任务(在该任务中,模型诱导的策略最大程度次优)之间交替进行优化。假设任务已参数化,我们通过隐函数定理推导了次最优性相对于任务参数的梯度公式,并展示了如何通过共轭梯度法和新颖的方法有效地实现梯度估计器--REINFORCE估算器。我们在几个连续的控制基准上评估了我们的方法,并证明了它在所有任务的最坏情况下的性能,对分发任务的概括能力以及在训练和测试时间样本效率方面相对于现有技术的有效性。

网址:

https://www.zhuanzhi.ai/paper/f52078d0293b04dd2e1a8607e7f8d38e

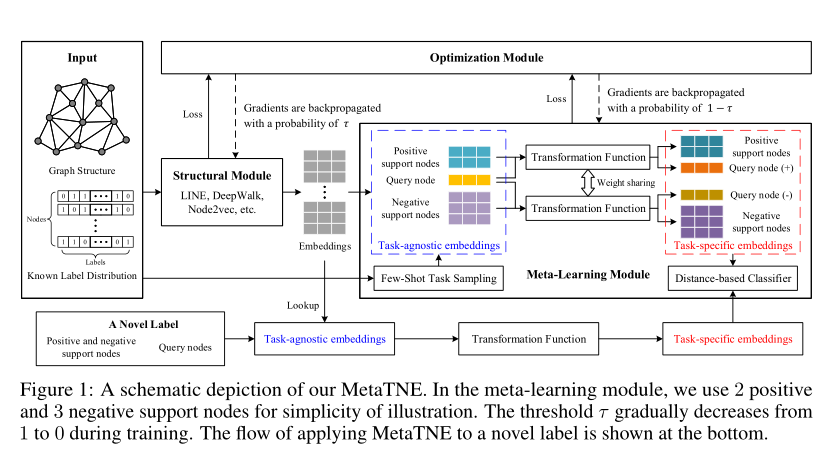

5. Node Classification on Graphs with Few-Shot Novel Labels via Meta Transformed Network Embedding

作者:Lin Lan, Pinghui Wang, Xuefeng Du, Kaikai Song, Jing Tao, Xiaohong Guan

摘要:我们研究了具有少量新颖标签的图节点分类问题,它具有两个独特的特性:(1)图中出现了新颖标签;(2)新颖标签仅具有几个用于训练分类器的代表性节点。对这个问题的研究具有指导意义,并且与许多应用相对应,例如对在线社交网络中只有几个用户的新组建的推荐。为了解决这个问题,我们提出了一种新颖的元变换网络嵌入框架(MetaTNE),该框架由三个模块组成:(1)一个结构模块根据图结构为每个节点提供潜在的表示。(2)元学习模块以元学习的方式捕获图结构和节点标签之间的关系作为先验知识。此外,我们引入了一种嵌入转换函数,以弥补元学习直接使用的不足。从本质上讲,可以将元学习的先验知识用于促进少样本新颖标签的学习。(3)优化模块采用简单而有效的调度策略来训练上述两个模块,并在图结构学习和元学习之间取得平衡。在四个真实数据集上进行的实验表明,MetaTNE相对于最新方法具有巨大的改进。

网址:

https://www.zhuanzhi.ai/paper/c88634d829437c465fb4ed28a4d5454d

请关注专知公众号(点击上方蓝色专知关注)

后台回复“NIPS2020ML” 就可以获取《5篇顶会NeurIPS 2020 元学习(Meta Learning)相关论文》的pdf下载链接~