复旦大学黄萱菁:自然语言处理中的可理解分析

“语言与智能高峰论坛”旨在向社会公众介绍语言与智能的前沿动态和创新成果,推动我国相关领域快速发展。论坛邀请国内外资深学者担任特邀讲者,设立青年科学家论坛、圆桌讨论和技术评测论坛,就语言与智能的前沿课题进行思想碰撞与深度交流。

复旦大学的黄萱菁教授针对深度学习推广中的可理解性和可解释性问题做了报告。以下为学术君根据演讲实录整理的文稿,略有删减——

自然语言处理中的可理解分析

为什么要做可理解分析呢?黄萱菁教授指出,深度学习把我们从特征挖掘时代带到了结构工程时代,但是也带来了新的问题——“如何选择适配特殊任务特殊数据集的结构?”可理解分析可以增加模型的可信赖性;可以判断模型是否过拟合;可以指出模型不足,便于继续优化。正是这些作用,所以我们需要继续优化运用它。

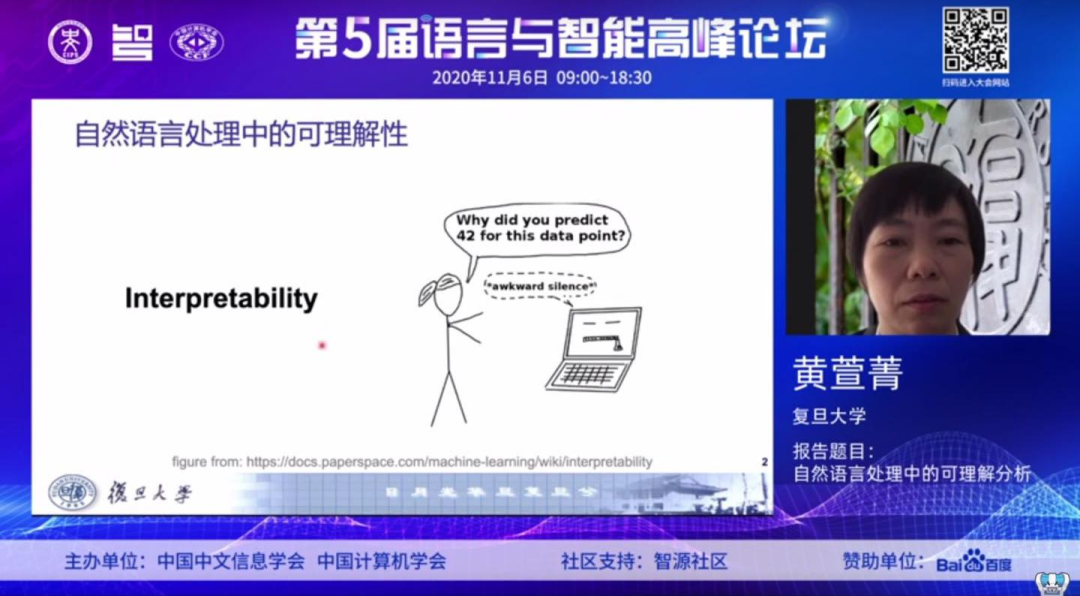

这两张图展示的是,涉及到 interpret ability,explanation这两个关键词,过去若干年被录用的会议论文的数目的发表趋势。x轴代表年份,y轴代表该年被录用的论文的数量。可以看到,最近两年的研究都呈现出了明显的一个增长趋势。可理解分析这个方向最近两年还是有较多人关注到的。

一、LSTM架构的认知解释。希望了解两个问题,一是“人阅读和机器阅读时的神经元活动是否可以相互预测?”,二是“LSTM架构在认知角度是否合理?”。

二、序列模型的认识。这里的研究动机主要是两个,一是“主流的几种基于神经网络模型的词表示,究竟编码了哪些语言学特征?”二是“神经元的行为模式是否可解释?”。

三、抽取式摘要中各个组件的作用分析,也就是不同配置的模型到底差异在哪里。

黄萱菁教授还在报告中介绍了今年自己团队已发表的鲁棒性分析的相关工作。

第二个是依存句法任务的攻击性能。基于依存句法对抗样本探究了句法任务模型的鲁棒性,通过利用对抗样本,提高了模型的鲁棒性。

第三个是基于情感分析(ABSA)的方面。黄萱菁教授的团队提出了一种简单有效的数据生成方法来测试模型的鲁棒性,构建了ARTS测试数据集来评测模型鲁棒性;继而提出了新的评测指标Aspect Robustness Score;并且通过探测9个现有的ABSA模型,提出了提升现有模型的鲁棒性的方法。

在报告的最后,黄萱菁教授对于可理解性分析的未来作出了研究展望;希望有一个统一的指标与数据集能够对可理解、可解释模型进行评价,并且有了这种统一评价之后,能够有一个通用的可交互的可解释工具,进行系统化平台化的分析。

另外,分析的目的是真正是改进现有系统的性能,帮助理解更好系统的输出,所以希望能够探索更多应用场景,通过可理解分析的结果去改变现有系统的性能。

黄萱菁个人介绍

黄萱菁,复旦大学计算机科学技术学院教授、博士生导师,主要从事自然语言处理、信息检索和社会媒体分析研究。兼任中国中文信息学会常务理事、社会媒体专委会副主任,中国计算机学会自然语言处理专委会副主任、学术工作委员会委员。在高水平国际学术期刊和会议上发表了百余篇论文,负责的多个科研项目受到国家自然科学基金、科技部、教育部、上海市科委的支持。入选由清华—中国工程院知识智能联合研究中心和清华大学人工智能研究院联合发布的“2020年度人工智能全球女性”,“2020年度AI 2000人工智能全球最具影响力提名学者”及“福布斯中国2020科技女性榜”。

参考资料:

http://conference.cipsc.org.cn/lis2020/reports/huangxuanjing.html

登录查看更多

相关内容

Arxiv

0+阅读 · 2021年1月26日

Arxiv

0+阅读 · 2021年1月22日

Arxiv

8+阅读 · 2018年8月22日

Arxiv

4+阅读 · 2017年8月17日