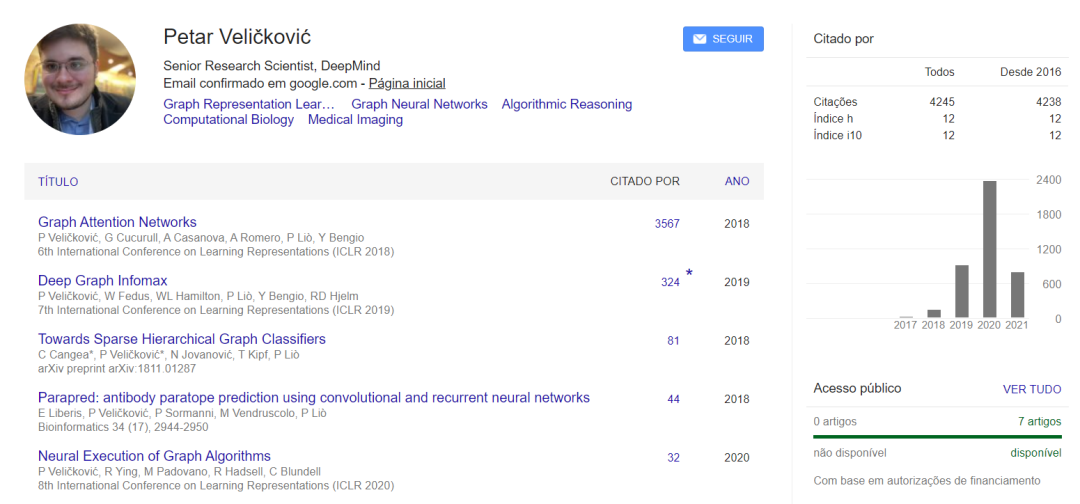

如何做出牛的研究?GAT作者DeepMind研究科学家Petar谈论自己读博科研经验,为您指点一二

【导读】如何入门科研,做出有影响力的研究?这是每个读博同学所关心的。最近GAT作者DeepMind研究科学家Petar Veličković在个人Twitter上分享了他早期读博的一些经历和建议,非常值得思考,包括要多找大牛组实习,对自己的想法“硬编码”验证,可以先投Workshop来通过圈内人Review反馈自己的工作等。希望对各位读博同学有用。

在继续之前,重要的免责声明: 这些只是我个人的观点,很可能是我的经验和性格的强烈偏见。希望还是有用的!

在攻读博士学位的早期阶段,我经常会碰到一个问题: 基于组里的硬件/软件/专业设置情况, 我所提出的想法显得的不适合,难于施行。

这将让我陷入好几个月的“困惑纠结”中(有时甚至迫使我将自己的薪水花在计算机上!)。对我来说,改变游戏规则的是那些对我想做工作有影响的研究人员: 首先从他们的角度学习,最后是去实习。

-

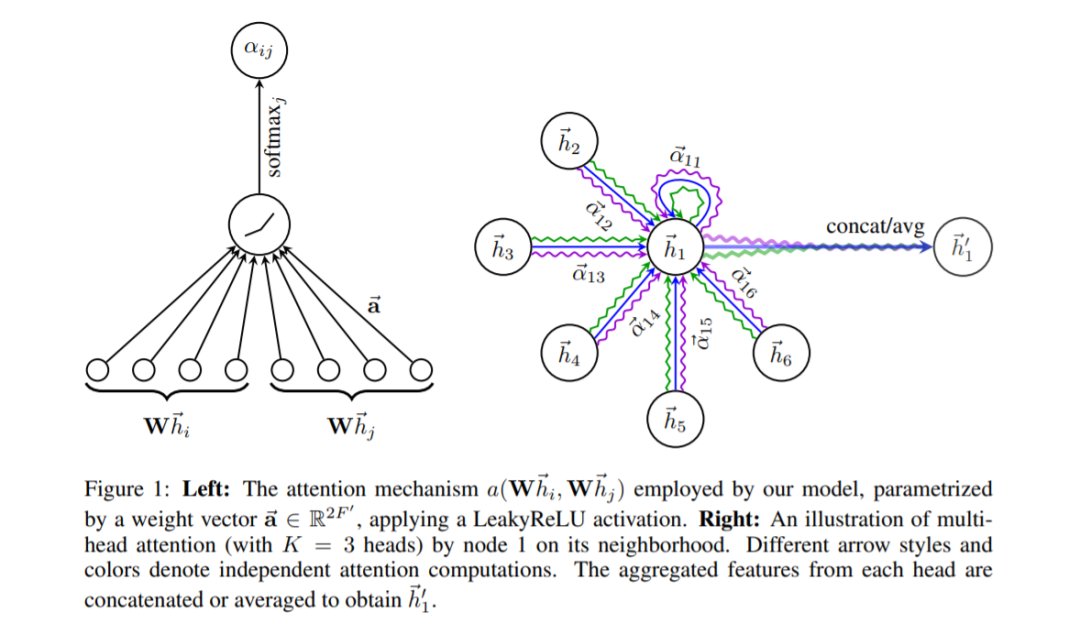

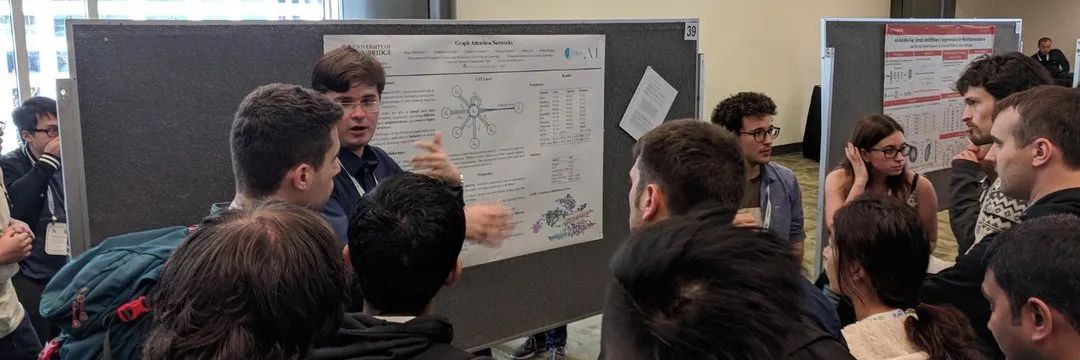

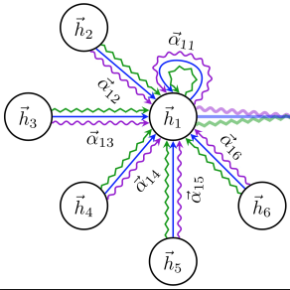

我在@Mila_Quebec的实习(在那里提出了GAT/DGI),这都是通过给Yoshua Bengio的邮件开始的,在这两种情况下,我们最初讨论的内容都与这两篇论文的最终内容完全无关。(第一次是多模态计算机视觉; 第二次,意识)。

-

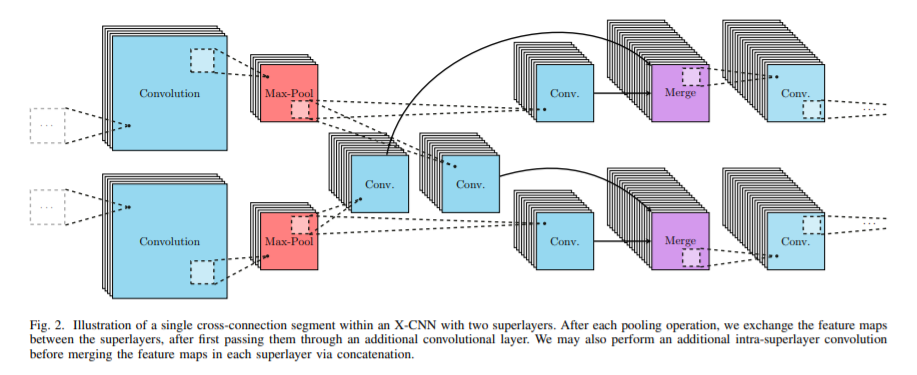

类似地,我在@BellLabs的实习(提出了X-CNN/X-LSTM)也从一个电子邮件帖子开始,目标是低资源的机器学习,与计算机视觉完全无关。

实习(或短期研究实习)是专注于解决某个特定问题(或一系列问题)的好方法: 这是一个预先确定的时间,通常与领域专家一起工作(这样他们就会知道什么是新奇的、令人兴奋的和可行的)。

…通常它会让你接触到更广泛的研究人员,他们可以提供宝贵的经验与建议,这在其他地方是不可能的。实际上,在实习中学到的经验教训也可以对你的工作流程产生积极的反馈。

最终,有了足够的经验,你就会熟悉这个领域,对什么是可行的有更好的感觉。在这方面,我逐渐学到的一个技能是,一旦你有了想要验证的想法假设,总是尽可能地“硬编码”问题。

例如,我的意思是,直接向模型提供它不应该有的数据,如果模型在这个设置中不起作用,你(通常)要么在某个地方有一个bug,要么这个假设很可能是错误的。

-

一旦你的模型正确地适应了硬编码的问题,你就可以逐渐放松输入的“受限”数据,确保它在每一步都能正常工作。这是一个很有影响力的工作流程,在我最近的许多算法推理论文中被证明是至关重要的。

-

我认为,学生们被迫“不发表就没门”,这是一个有点可悲的现实。如果你所处理的问题是你认为非常有意义的,并且你的解决方案有价值,我不认为一定要发表你的论文是绝对必要的。

-

研讨会通常有更高的接受率(约75% +%),是一个在你的论文发布前获得反馈的好平台,而具有讽刺意味的是,它们与大型会议联系在一起意味着你仍然能够获得更多曝光。

-

事实上,因为研讨会通常针对的是一个狭窄的“小众”研究人员,所以你很可能会从那些可能成为你未来的Reviewer甚至合作者的人那里得到集中的反馈。:)

-

希望你觉得它有用——欢迎任何反馈或个人经验。:)

专知便捷查看

便捷下载,请关注专知公众号(点击上方蓝色专知关注)

后台回复“Petar” 就可以获取《如何做出牛的研究?GAT作者DeepMind研究科学家Petar谈论自己读博科研经验,为您指点一二》专知下载链接