视频换脸新境界:CMU不仅给人类变脸,还能给花草、天气变脸 | ECCV 2018

圆栗子 发自 凹非寺

量子位 报道 | 公众号 QbitAI

把一段视频里的面部动作,移植到另一段视频的主角脸上。

大家可能已经习惯这样的操作了。

就算目标主角并不是人类,大概也算不上精彩。眼睛鼻子嘴,至少零件齐全。

那么,怎样的迁移才可走出这个框框,让这个星球上的万物,都有机会领取视频改造的恩泽?

△ 按着你想要的节奏开花:中老年表情包利器

来自卡耐基梅隆大学的团队,开发了自动变身技巧,不论是花花草草,还是万千气象,都能自如转换。

△ 云,也变得急切了

或许是怀着超越大前辈Cycle-GAN (来自朱俊彦团队) 的意味,团队给自家的GAN起了个非常环保的名字,叫Recycle-GAN。

这位选手,入选了ECCV 2018。

Recycle之道,时间知道

Recycle-GAN,是一只无监督学习的AI。

用不成对的二维图像数据,来训练视频重定向 (Video Retargeting) 并不容易:

一是,如果没有成对数据,那在视频变身的优化上,给的限制就不够,容易产生不良局部极小值 (Bad Local Minima) 而影响生成效果。

二是,只依靠二维图像的空间信息,要学习视频的风格就很困难。

△ 你开花,我就开花

针对这两个问题,CMU团队提出的方法,是利用时间信息 (Temporal Information) 来施加更多的限制,不良局部极小值的现象会减少。

另外,时间、空间信息的搭配食用,也能让AI更好地学到视频的风格特征。

△ 时间信息:进度条撑不住了 (误)

重要的是,视频里的时间信息唾手可得,无需寻觅。

然后,看一下Recycle-GAN,是怎样在两段视频的图像之间,建立映射的。

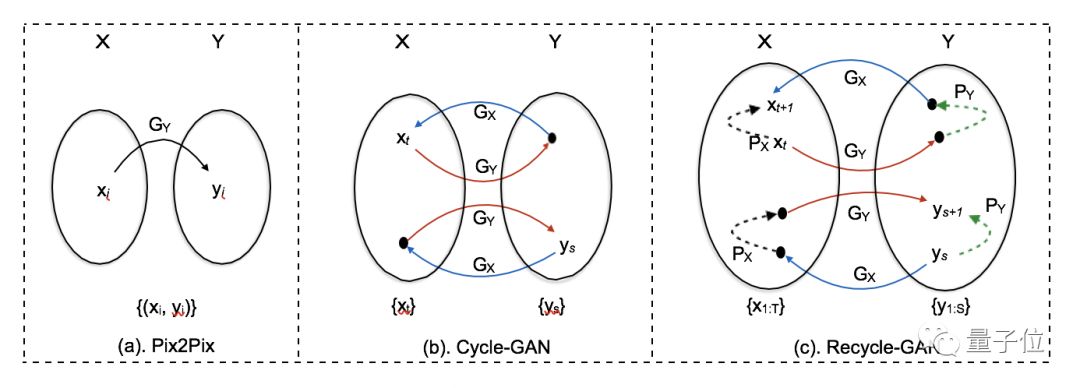

△ 三位选手对比一下

Pix2Pix是有成对数据的;CycleGAN靠的是循环一致性 (Cycle Consistency) ;RecycleGAN用的是视频流的时间信息。

翻来覆去的,比CycleGAN的历程还要艰辛。好像终于感受到,Recycle-GAN这个名字是有道理的。

把对抗损失 (Adversarial Loss) ,朱俊彦团队的循环损失 (Cycle Loss) ,反复损失 (Recurrent Loss) ,以及CMU团队自己造的“再”循环损失 (Recycle Loss) 都用上,才是强大的损失函数。

效果怎么样?

似乎只有和CycleGAN比一场,才知道时间信息好不好用。

第一局,先来看看换脸的效果:

RecycleGAN用奥巴马生成的川川,除了嘴皮子,脸的角度也在跟着变化。而中间的CycleGAN,只有嘴的动作比较明显。

第二局,你见过蒲公英开花的样子么:

当RecycleGAN的蒲公英,学着菊花的动作,变成茂密的团子,CycleGAN还在慢慢地绽放。

注意,团队是预先把两种花,从初开到完全凋谢的时间调成一致。

除此之外,再看云卷云舒 (片头也出现过) :

原本是悠然地移动。

和喷气一般的云,学习了之后,就获得了急躁的节奏。

这样一来,改变天气就不难了。团队说拍电影的成本,可以用这样的方法降下来。

代码也快来了

CMU的科学家们说,大家很快就可以看到代码了。

不过在那之前,我们还是有许多资源可以欣赏。

团队在项目主页里,提供了丰富的生成效果:

https://www.cs.cmu.edu/~aayushb/Recycle-GAN/

论文请至这里观察:

https://www.cs.cmu.edu/~aayushb/Recycle-GAN/recycle_gan.pdf

最后吐个槽

原本是日落:

看了黎明之前的视频,就跟着变了日出:

可是,日落变日出这样的操作,直接倒放不好么?

— 完 —

加入社群

量子位AI社群28群开始招募啦,欢迎对AI感兴趣的同学,在量子位公众号(QbitAI)对话界面回复关键字“交流群”,获取入群方式;

此外,量子位专业细分群(自动驾驶、CV、NLP、机器学习等)正在招募,面向正在从事相关领域的工程师及研究人员。

进专业群请在量子位公众号(QbitAI)对话界面回复关键字“专业群”,获取入群方式。(专业群审核较严,敬请谅解)

诚挚招聘

量子位正在招募编辑/记者,工作地点在北京中关村。期待有才气、有热情的同学加入我们!相关细节,请在量子位公众号(QbitAI)对话界面,回复“招聘”两个字。

量子位 QbitAI · 头条号签约作者

վ'ᴗ' ի 追踪AI技术和产品新动态