作者 | Bbuf

编辑 | 贾伟

最近何恺明团队在arXiv 上公布了他们发表在CVPR 2020 上的最新论文《Designing Network Design Spaces》[1]。和何恺明之前发表的大多数论文一样,一经公布,迅速得到众人的关注。知乎上迅速有人提出问题:“如何评价何恺明团队最新推出的RegNet? ”[2]

但需要强调的是,这篇文章的主角是 Ilija Radosavovic,一位伦敦大学的助教;其主要研究兴趣是搜索空间的优化,这篇文章是其系列工作的第二篇。第一篇为《On Network Design Spaces for Visual Recognition》[3]。

针对最新的这项工作,来自厦门大学知乎名为「 丶favor 」的硕士生在其知乎解读文章[4]中写道:

一句话概括就是,传统 NAS 方法这种基于个体估计(individual network instance)的方式(每次评估的时候采样一个网络)存在以下缺陷:1)非常不灵活(各种调参大法) ;2)泛化能力差;3)可解释性差。(搜出来的效果虽好,但是很多都是大力出奇迹,运气成分+1)。因此,作者顺理成章地提出了对网络设计空间进行整体估计(population estimation,意思就是所有的深度宽度之类的最佳设计空间关系给它估计出来)。非常直观地,如果我们能得到深度(depth),宽度(width)等等一系列网络设计要素关于网络设计目标的函数关系,那么我们就很轻松地知道大概多深的网络,多宽的网络是最佳选择。这也就直接解决了上述三个问题,并且这个方式实际上能反应出更优质的网络设计准则,从而达到Designing Network Design Spaces的目的。读到这里,牛逼就完事了!

论文链接:https://arxiv.org/pdf/2003.13678.pdf

我们认为,这篇论文有望成为今年最热的CV方面的工作。 读过EfficientNet的同学应该知道网络的分辨率、深度、宽度对网络的性能影响是相互作用的,并且探索了在一定计算代价下如何搜索最优模型。本文和传统的网络设计切入点不同,作者并不专注于设计单个网络实例,而是设计”网络设计空间“对整个网络进行参数化。 整个过程类似于经典的网络手工设计,但是却将其提升到了设计空间的层次。 基于此,本文提出了RegNet。在相同的训练设计和FLOPs的条件下,RegNet的精度超越了当前最SOTA的EfficientNet,并且在GPU上的速度比EfficientNet快5倍。

设计空间设计

我们先谈谈其总体思路。这篇文章事实上依赖于Radosavovic在第一篇文章中引入的网络设计空间概念[3]。即设计空间是一个巨大的,可能无限的模型结构的总体。[3]的核心观点是,我们可以从一个设计空间中对模型进行抽样,产生一个模型分布,然后利用经典的统计工具来分析设计空间。本文注意到,这和架构搜索(NAS)不同,架构搜索的目标是从空间中找到单个最佳模型。

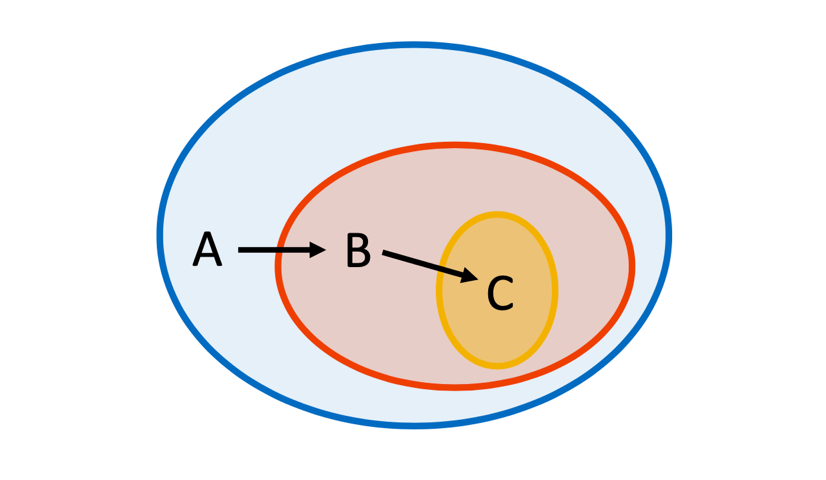

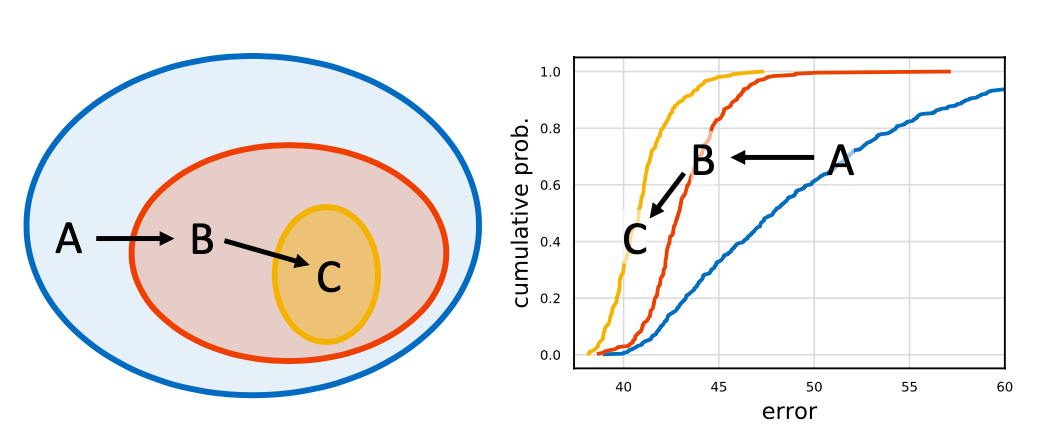

如Figure1所示,本文使用的整体策略是渐进式地设计原始的、相对不受约束的简化版设计空间,同时保持或者提升设计空间的质量。每个设计步骤的目的都是发现设计准则,从而产生更简单或性能更强的模型。

Figure 1. Design space design

1.1 设计空间设计工具 先来看一下设计空间设计的工具,为了评估和对比设计空间,这里使用Radosavovic等人介绍的工具。他提出通过从设计空间采样一组模型,并描述由此产生的模型误差分布,来量化设计空间的质量。这种方法背后的关键是,与使用搜索和比较两个设计空间中的最佳模型相比,比较分布更加可靠且信息更丰富。

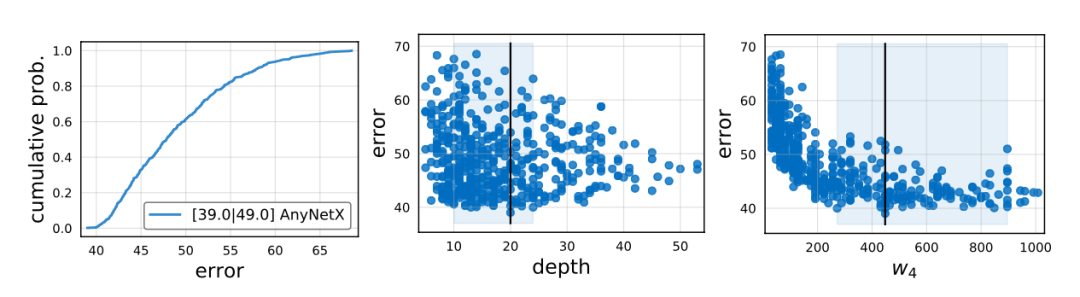

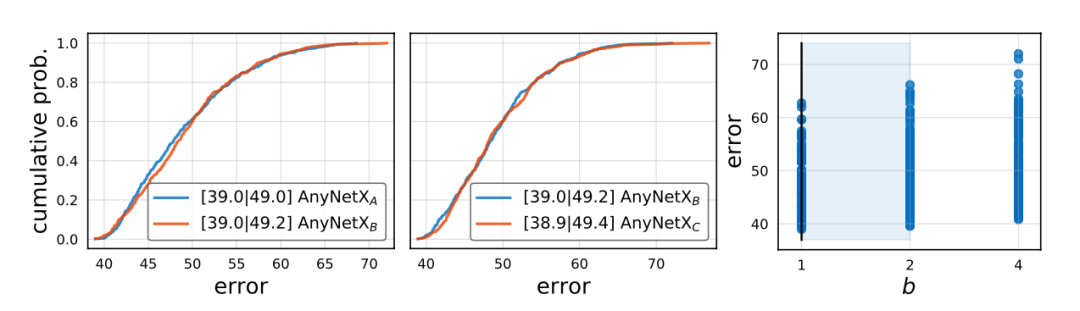

下面的Figure2展示了用

个抽样模型计算的AnyNetX 设计空间的统计结果。左:误差经验分布函数(EDF)是我们可视化设计空间质量的基本工具。在图例中,

分别是最小误差和平均误差(对应于曲线下的区域)。中间:网络深度

(块数)与误差的分布。右:第四阶段(

)的块宽度分布与误差。蓝色阴影区域包含

置信度的最佳模型(通过经验引导获得),黑色垂线是最可能的最优值。

Figure 2. AnyNetX 设计空间的统计

为了得到模型的分布,本文从设计空间中采样了

个模型进行训练。为了提高效率,这里主要在低计算量和低epoch的训练模式下进行。特别地,在本节中使用的是

Million FLOPs(400MF)模式,并对每个采样的模型在ImageNet数据集上训练

个Epoch。注意到,这里虽然训练了很多模型,但每次训练都很快:在

MF上给

个模型训练

个epoch和在

GF下把单个ResNet-50模型训练

个epoch的时间相当。注意,这里的FLOPs表示的是乘法和加法次数,MF和GF分别代表

和

个FLOPs。

和[3]一样,这里分析设计空间质量的主要工具是误差经验分布函数(EDF)。

个模型的误差EDF和误差

由下面的公式给出:

表示错误率小于

的模型百分比。上面的方法总结如下:

(1) 我们首先从设计空间中抽样和训练

个模型,获得模型的分布。

(2) 我们计算并绘制误差EDFs,以评估设计空间质量。

(3) 我们可视化设计空间的各种属性,并使用经验准则监督。

1.2 AnyNet 设计空间

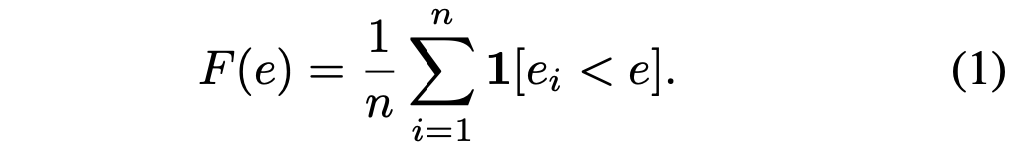

AnyNet设计空间的基本网络设计如Figure3所示。

Figure 3. AnyNet 设计空间的基本网络设计

给定输入图像,接下来是一个包含简单主干的网络,再接下来是执行大量计算的网络主体,最后是预测输出类别的网络头。本文保持主干和头部网络尽可能简单,主要关注网络网络主体的结构。可以看到这里网络主体由4个阶段(stage)组成,并且分辨率逐渐降低,然后每个stage里面又是由一系列相同的块(block)组成。在这个结构里面,可以改变的参数包括块的数量

,块的宽度

等。这里就完整展示了AnyNet的结构。

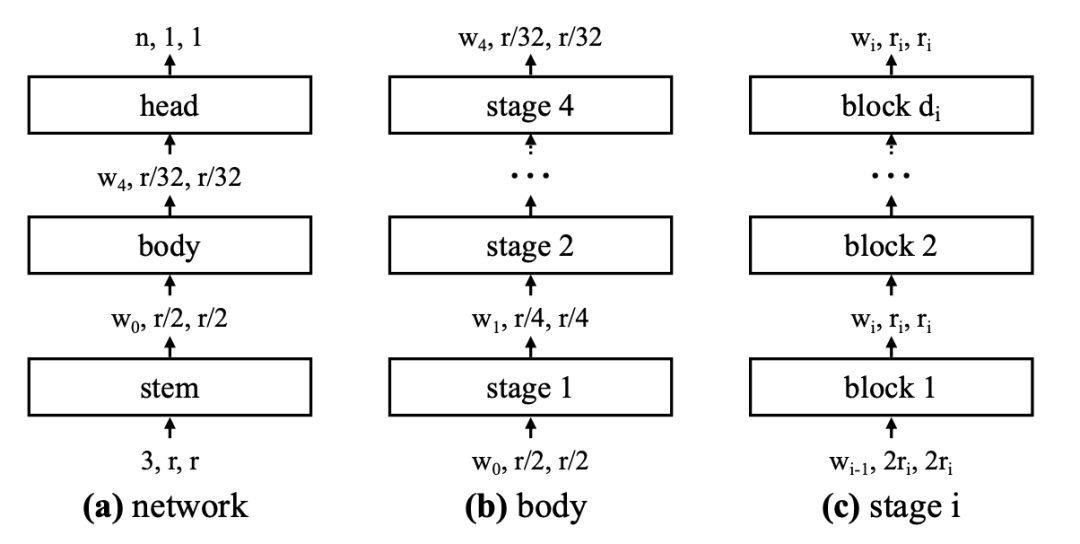

然而,我们看到论文的研究几乎都是在AnyNetX上的结果。那么AnyNetX和AnyNet又有什么区别呢?我们来看看Figure4,可以发现区别就是将原始的卷积换成分组卷积。

Figure 4. X block 基于标准残差 bottleneck 块。

在AnyNetX上,作者旨在:1)简化设计空间的结构;2)提供设计空间的可解释性;3)保持或提高设计空间的质量;4)保持设计空间中模型的多样性。

现在利用上一节介绍的工具来进行研究,这里将原始的不受约束的AnyNetX设计空间叫作

。

然后论文将

中所有阶段的BottleNeck比例

都设置为同一个值

,并将此设计空间称为

。

我们可以从Figure5左边那张图看到这两个网络设计空间的EDF基本上是一致的,这表示在耦合

时并没有带来精度损失。

然后在

的基础上将所有阶段使用一样的

来获得了

,从Figure5中间那张图可以看出,EDF也基本不变。

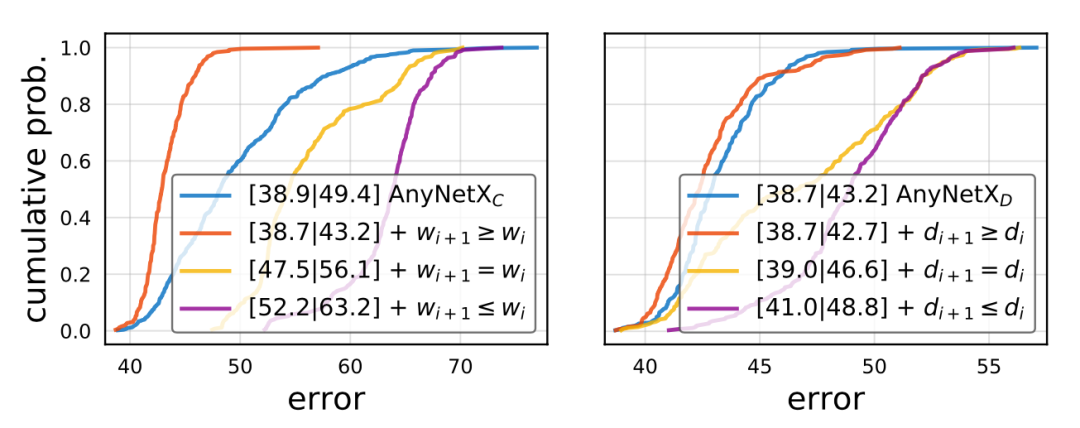

接着,论文研究了

中优秀和不好的典型网络结构,然后他们发现了一个规则: 表现良好的网络具有不断增长的宽度。

论文接着测试了

的设计原则,并将此约束下的设计空间称为

。在Figure 6(左)中可以看到这极大地改进了EDF。另外,再进一步测试多个模型后,作者发先除了阶段宽度

随着

增加,对于优秀的模型,阶段深度

也同样趋于增加,虽然不一定是在最后阶段。

在Figure6的右图中,我们发现当设置

时,EDF同样得到了较大改善。最后注意到对于

和

的约束使得设计空间减少了

,和

相比累计减少了

。

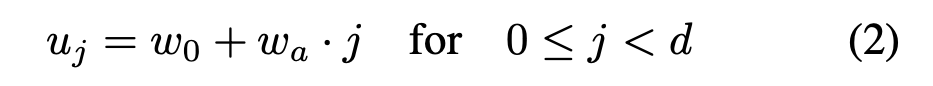

2.3 RegNet设计空间

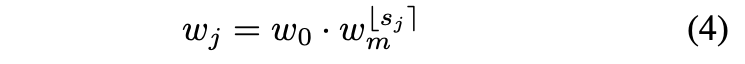

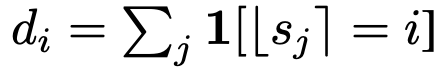

从AnyNetX的结果来看,是体现出了一些规律的,通过获得的几组变量和每个Blcok的下标之间的关系,可以拟合出一个函数关系。这样就可以建模好每个Stage的Block应该多深以及多宽的关系,这个建模的方法被论文叫作quantized linear 。这一方法可以用公式(2)来表示:

其中,

表示初始化宽度,

表示斜率,

表示网络深度。另外,为了量化

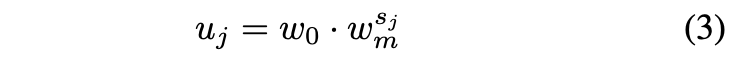

这里又引入了两组公式和新的超参数

用于计算

,这一过程可以用公式(3)和(4)来表示:

然后,我们就可以计算出每个Stage的宽度是:

以及Block的数量:

自此,网络设计空间就被

这三组参数表示出来,所以对这三组参数进行搜索就获得了论文中展示的超越EfficientNet的惊艳结果了。其它的细节就不展开介绍了,感兴趣可以看原论文。

实验

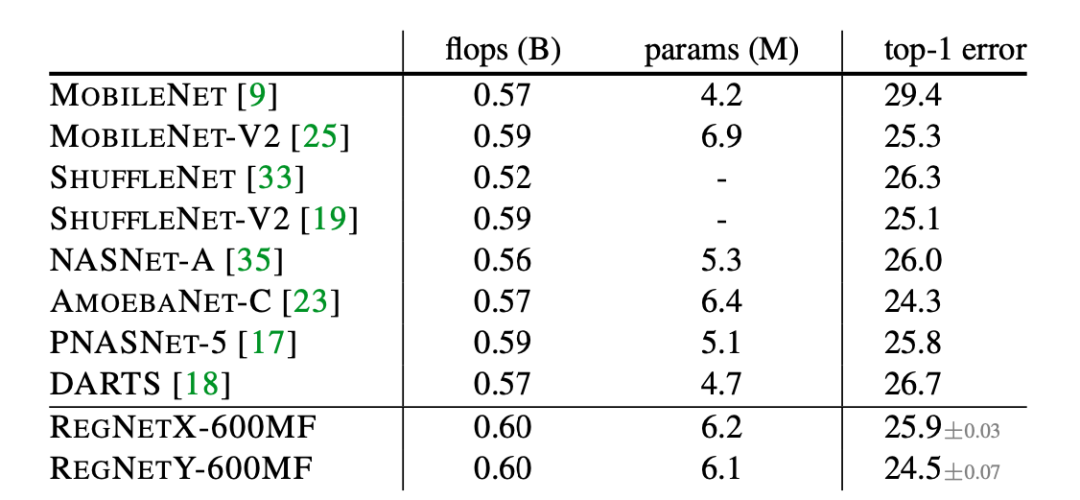

下面的Table2展示了RegNet和现有的SOTA移动端模型的性能对比,可以看到REGNET是非常有效的。

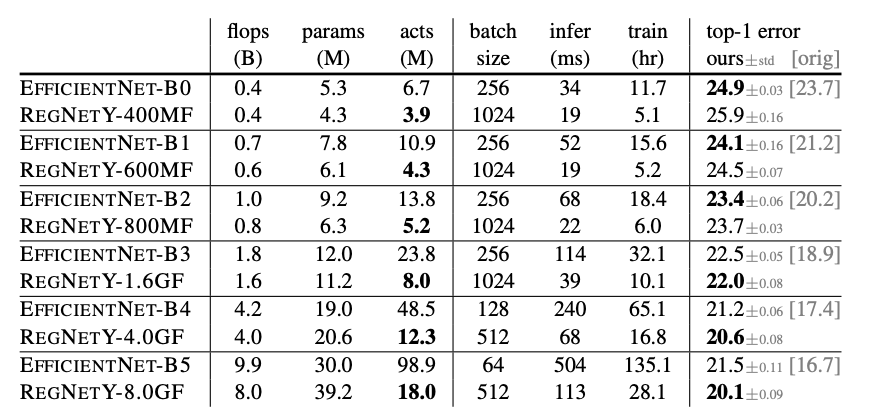

下面的Table4展示了论文将RegNet和SOTA EfficientNet 模型的对比结果,结果显示在相似的训练设置和FLOPs下,RegNet优于EfficientNet模型,并且 GPU 上的速度提升5倍。

结论

这篇论文提出了一种新的网络设计范式,和以往研究不同的是他们没有专注于设计单个网络实例,而是设计出了参数化网络群的网络设计空间。这种新的网络设计范式结合了神经框架搜索(NAS)和手工设计网络的优点,精度和速度全面超越了EfficientNet,将成为了目前最值得关注的一项CV方向的工作。

[1] I. Radosavovic, Raj Prateek Kosaraju, Ross Girshick, Kaiming He, Piotr Dolla ́r, Designing Network Design Spaces. CVPR 2020.

[2] 如何评价何恺明团队最新推出的 RegNet?https://www.zhihu.com/question/384255803

[3] I. Radosavovic, J. Johnson, S. Xie, W.-Y. Lo, and P. Doll ́ar.On network design spaces for visual recognition. InICCV,2019.

[4] 《Designing Network Design Spaces》的整体解读(一篇更比六篇强), https://zhuanlan.zhihu.com/p/122557226

相关报道:

CVPR 2020接收论文公布:录用1470篇,接收率“二连降”,仅22% !

论文集:

01. 17篇入选CVPR 2020,腾讯优图 9 篇精选论文详解

02. 22篇入选,百度 15 篇 CVPR 2020 精选论文详解

论文解读:

阅读 原文 ” 查看 CVPR 系列论文解读

点击“

阅读原文” 查看 CVPR 系列论文解读

点击“

阅读原文” 查看 CVPR 系列论文解读