在人工智能领域尤是如此,随着AI应用的不断落地,人们越来越意识到人工智能系统所带来的风险,并认识到现有法律与业界、学界规范仍不足以保证人工 智能的可靠研发。

如果能提供精准的声明和充足的证据,AI开发人员就能更好地向监管机构、公众和其他开发者证明其行为的责任性。

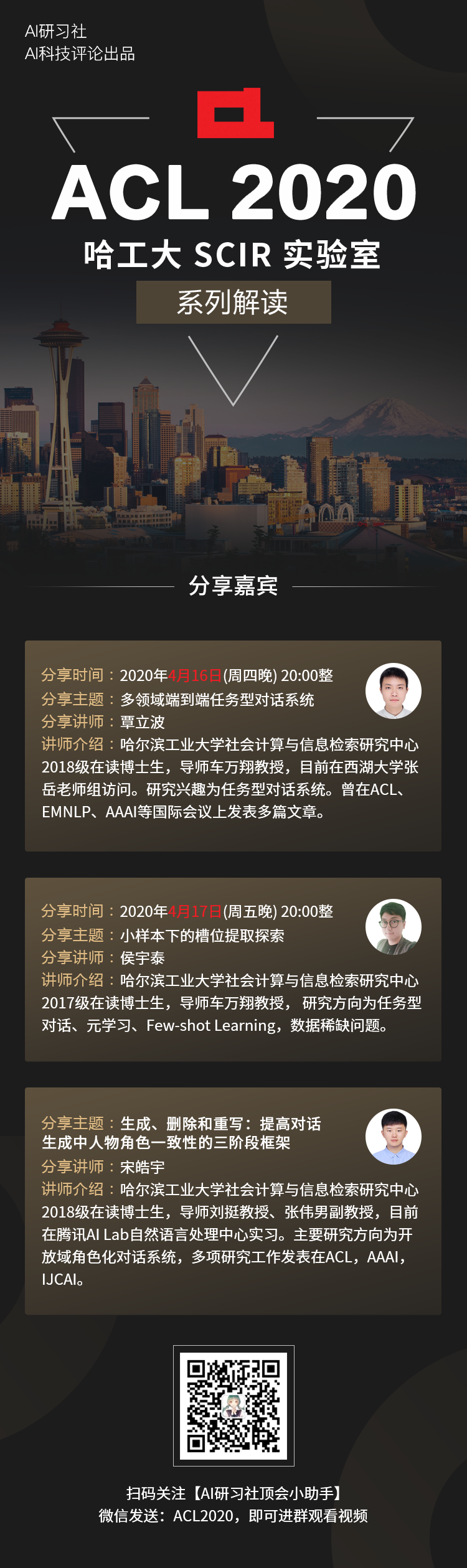

基于这个目的,近日59位世界级学者共同撰写一份构建可信赖人工智能的论文《迈向可信赖的人工智能:可验证声明的支持机制》,详细阐述了可信赖AI涵盖的机制。

![]() AI科技评论后台回复“可信赖AI”下载报告

整个报告由Open

AI牵头,涉及机构多达30多家,Google Brain,图灵研究所和很多主要欧美大学都有参与。

AI科技评论后台回复“可信赖AI”下载报告

整个报告由Open

AI牵头,涉及机构多达30多家,Google Brain,图灵研究所和很多主要欧美大学都有参与。

报告成文基于2019年4月举行了一次研讨会。该报告提出了作用于制度、软件和硬件三个层面的机制:

-

体制机制;这部分是作为有效验证人工智能研发声明的基础,提出了第三方审核 、红队测试练习、误差和安全隐患侦查激励制度、人工智能安全事故信息共享等四个建议。

-

软件机制:目的在于让人工智能系统的属性更易于理解和监督,具体措施包括:审计跟踪、可解释性、隐私保护的机器学习。

-

硬件机制:与计算硬件有关的机制可以在多方面发挥关键作用,包括证实有关隐私和安全性的声明、提高组织如何使用资源的透明度、以及影响谁具有验证不同声明所必需的资源。这部分包括:机器学习的硬件安全设施、高精度计算资源的测量、为学术界提供计算资源支持三个部分。

这部分,

首先提出观点:仅仅依靠道德准则或行为准则,远远不能够起到规范和约束作用。

因为准则通常是从特定的案例中抽象出来的,无法可靠地执行。

而体制机制可以帮助一个组织清晰其目标和价值观,反过来又可以为评价其主张提供基础。

在体制机制部分,报告建议是,可以利用第三方审核来替代自我评估声明;利用

红队测试练习(red teaming exercises)

以增强开发人员的防范意识, 减少系统被误用或袭击的可能性;利用

误差和安全隐患侦查激励制度 (bias and safety bounties)

以建立激励机制,促进对人工智能系统缺陷的及时发现、及时报告;以及加强

人工智能安全事故信息共享

,增进社会对人工智能系统的认识。

第三方审核针对的问题是:

人工智能的开发过程对特定组织之外的人来说往往是不透明的,各种障碍使得第三方难以核实开发者的说法。因此,关于系统属性的说法可能不容易核实。

给出的建议是:利益攸关方联盟应成立一个工作组,研究对人工智能系统进行第三方审计并为其提供资金的方案。重点在于设计出处理敏感知识产权的方法,并在标准化的需要和灵活性之间取得平衡。

红队测试练习针对的问题是

:

人工智能开发者很难解决与人工智能系统相关的 "未知数",包括恶意行为等风险。当前的红队方法不足以解决AI背景下的这些问题。

给出的建议是:人工智能研发机构应该参与红队测试 (red-teaming)的练习,从而发现系统潜在的风险,并分享相关的最佳实践和应对问题的工具。一个有凝聚力红队应该能回答这两个问题:一个团队的适当范围是什么?专有信息将如何处理?

误差和安全隐患侦查激励制度针对的问题是:

对于局外人来说,没有太多动力来寻找和报告AI偏见和安全问题。

给出的建议是:人工智能开发者应试行误差和安全隐患侦查激励制度 (bias and safety bounties),以建立广泛监 督人工智能系统的激励机制和标准流程。需要内容包括:确定征集和评估赏金申请的程序;制定程序,及时披露通过此类赏金发现的问题;避免创造不正当的激励机制.....

AI事故共享针对的问题是:

如果对人工智能系统的潜在风险有共同的认识,就可以更有效地审查有关这类系统的声明。然而,人工智能系统事故很少有分享,因为单方面这样做的成本很高。

给出的建议是:从长远来看,从实验和研究中获得的经验教训,可以为不同类型人工智能事故、报告流程集成成熟体系。

软件机制,就像软件本身一样,必须结合具体语境来理解, 软件机制的专业知识普及的并不广泛,这给建立机制带来了挑战。

提出的具体措施包括

审计跟踪

,通过收集有关开发和部署过程的关键信息来强化人工智能系统的问责制;保证

可解释性

以增进对人工智能系统特征的理解和审查;以及

隐私保护的机器学习

,使开发人员对隐私保护的承诺更有鲁棒性。

其中,审计跟踪针对的问题是:人工智能系统缺乏对问题定义、设计、开发和运行过程中所采取的步骤的可追踪记录,会出现缺乏问责问题。

给出的建议是:标准制定机构应该和学界、业界合作,要求对安全攸关的人工智能系统实行审计跟踪。虽然软件审计跟踪取决于应用,但软件审计跟踪通常需要一套基本的可追溯性跟踪来证明其合格性。跟踪流程需要考虑效率、完整性、防篡改和其他设计考虑因素之间的权衡。

解决方案:多给资金促进可解释性研究,重点是支持风险评估和审计。

隐私保护的机器学习

针对的问题是:目前缺乏评估新的隐私保护机器学习技术的标准,而实现这些技术的能力目前还不在典型的人工智能开发者的技能范围之内。

解决方案:AI开发者应开发、共享和使用保护隐私的机器学习工具套件。人工智能开发者应该对隐私机器学习技术的开源社区工作做出贡献,使用和以其他方式支持,如OpenMined、Microsoft SEAL、tf-encrypted、tf-federated和nGraph-HE等。

与计算硬件有关的机制可以在多方面发挥关键作用,包括证实有关隐私和安全性的声明、提高组织如何使用资源的透明度、以及影响谁具有验证不同声明所必需的资源。

这部分探讨的机制包括完善机器学习的

硬件安全设施

以提高隐私和安全性声明的可验证性;

高精度计算资源的测量,

以提高关于计算能力使用的声明的价值和可比性;以及为

学术界提供计算资源支持

,以提高业界以外人士评估有关大型人工智能系统的声明的能力。

硬件安全设施针对的问题是

:可信执行环境的开发面临着巨大的前期成本,可能不是最合适的基于硬件的解决方案。

建议是:业界和学界应共同努力为人工智能加速器开发硬件安全功能,或者确立在机器学习环境中使用安全区(包括商品硬件上的“安全飞地”)的最佳实践。

在硬件级别上,向机器学习加速器添加专用安全功能可能需要采取与安全飞地不同的形式。一方面由于不同的架构和芯片上空间的不同使用;另一方面是由于安全问题的不同权重;再者,由于相对于商用芯片的规模经济差异,许多机器学习加速器的开发商相对于英特尔或NVIDIA等老牌芯片设计公司来说规模更小、资源更少。

高精度计算资源针对的问题是:

缺乏衡量计算资源使用的标准,降低了自愿报告的价值,并使核实关于人工智能开发过程中使用的资源的声明变得困难。

解决建议是:一个或多个人工智能实验室应该对单个项目进行高精度计算资源的测量,并报告其实践能否被广泛采用。

为学术界提供计算资源针对的问题是:

工业界和学术界之间的计算资源差距限制了局外人审查人工智能开发人员提出的技术主张的能力,特别是那些与计算密集型系统相关的技术主张。

解决建议是:政府资助机构应大幅增加对学界研究人员的计算能力资源的资助,以增强学术研究人员验证商业人工智能声明的能力。

根据在于,如果各国政府利用其购买力就批量计算机采购进行谈判,可以使这种算力供应更容易负担得起,政府也可以为此建立自己的计算基础设施。

这个报告详细阐述了在AI领域赢得信任的一种方式,通过各种机制对相关人员的各种声明进行核实,能够确保人工智能以负责任的方式发展。

如果说广泛阐述道德原则可确保人工智能良好发展的第一步,那么采用可核查的机制是第二步。

报告中提出的机制可以帮助我们处理不同利益相关方可能面对的问题:

作为用户,我能否在使用新的人工智能系统机器翻译敏感文件时,检验其对隐私保护级别声明的真实性?

作为监管者,我能否追踪无人驾驶汽车导致事故的过程,并且知道用哪种标准来评判汽车公司的安全声明?

作为学者,我能否在缺乏业界计算资源的条件下,对大型人工智能系统所带来的影响进行客观的研究?

作为人工智能研发者,我能否确信我在某一领域的竞争对手遵循最佳实践,而不是偷工减料以获得竞争优势?

总的来说,针对妨碍人工智能声明有效评估的具体问题,报告提出了一一对应的一系列机制和建议。其中部分机制已经存在,但仍需完善,而另一部分则是前所未有的。报告为进一步增强人工智能研发声明的可验

证性作出了贡献。

![]() 点击“阅读原文” ,观看直播回放视频

点击“阅读原文” ,观看直播回放视频

AI科技评论后台回复“可信赖AI”下载报告

AI科技评论后台回复“可信赖AI”下载报告

![]()