这个夏天,跟陈天奇学「机器学习编译」中英文课程,6月17日开课!

机器之心报道

机器之心编辑部

陈天奇:「因为世界上还没有关于这个方向的系统性课程,所以这一次尝试应该会是和小伙伴们共同的探索」。

随着机器学习框架和硬件需求的发展,机器学习 / 深度学习编译正成为一个越来越受关注的话题。

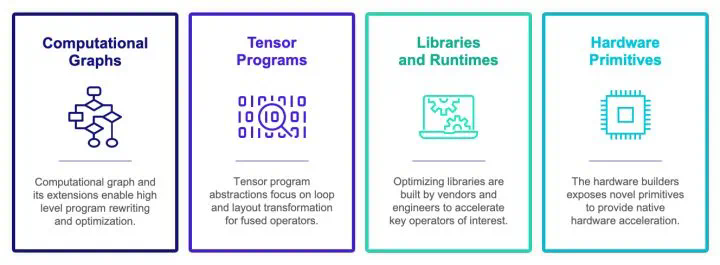

在去年 12 月的一篇文章中,TVM、MXNET、XGBoost 作者,CMU 助理教授,OctoML CTO 陈天奇探讨了「新一代深度学习编译技术的变革和展望」。他指出,现在深度学习编译生态正围绕四类抽象展开:计算图表示、张量程序表示、算子库和运行环境、硬件专用指令。

不过,由于篇幅受限,陈天奇并未就这一话题展开系统、详细的讨论,这让很多对机器学习 / 深度学习编译感兴趣的小伙伴感到意犹未尽。陈天奇本人也表示,「目前互联网上也有一些关于机器学习编译的介绍,不过大部分都还是介绍其中的各个模块,或者是针对一个系统的深入内部讲解。」因此,陈天奇萌生了开一门系统性课程的想法。

6 月 2 日,陈天奇通过知乎宣布,由他主讲的机器学习编译入门课程将于近期正式开课。

原贴链接:https://zhuanlan.zhihu.com/p/523372873

陈天奇介绍说,目前课程已经确定了几点大的方向,「首先,机器学习编译本身虽然有『编译』二字,其涉及到的技术其实超过了传统编译的范畴,包含了如机器学习搜索自动化,算子库整合,和机器学习生态交互等各个方面。而在相关抽象设计上面也有许多机器学习需求本身的考量。」因此,「这次课程会集中介绍计算图、张量程序、算子库和硬件指令四个层面的抽象。而更加重要的一点考量是整合。一般对于机器学习编译的介绍都会集中在一个点上,而各大抽象的整合本身反而恰好是真正需要大家关注的地方。」

目前,课程的中英文大纲都已经在官网上线,课程视频也是中英文均有。

英文课程主页 https://mlc.ai/summer22/

中文课程主页 https://mlc.ai/summer22-zh/

以下是关于该课程的详细信息(来自课程官网):

课程简介

随着人工智能应用在我们的日常生活中变得越来越普遍,目前存在的挑战是如何在不同的生产环境中部署最新的人工智能模型。模型和部署环境的组合爆炸给训练和推理部署带来了巨大的挑战。此外,目前落地的模型也提出了更多的要求,例如减少软件依赖、全面的模型覆盖、利用新硬件进行加速、减少内存占用,以及更强的可扩展性。

这些模型训练和推理问题,涉及机器学习编程范式、基于学习的搜索算法、编译优化以及计算运行时。这些话题的组合生成了一个全新主题——机器学习编译,并且该方向正在不断持续发展。这门课程将按照其中的关键元素,系统地研究这一新兴领域的关键要素。参与者将学习一些核心的概念,用以表示机器学习程序、自动优化技术,以及在端到端机器学习部署中优化环境依赖、内存和性能的方法。

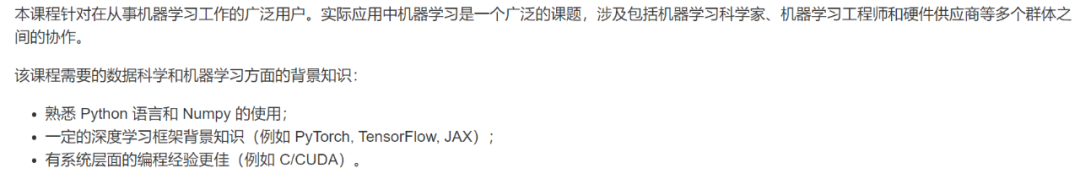

课程受众和知识储备要求

关于这门课程的受众和要求,陈天奇表示,「这次课程本身并不需要编译和机器学习系统的背景知识。只需要对于深度学习框架有一些使用经验即可」。具体信息如下:

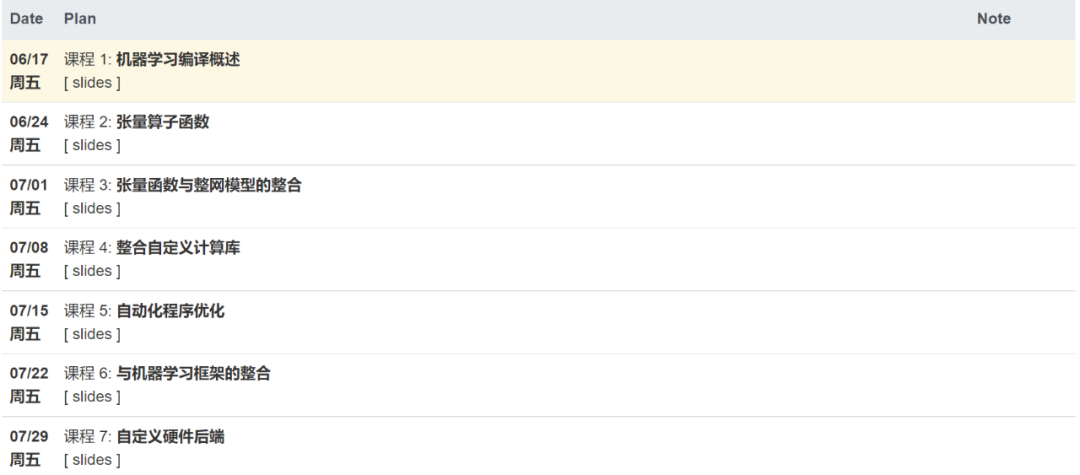

课程安排

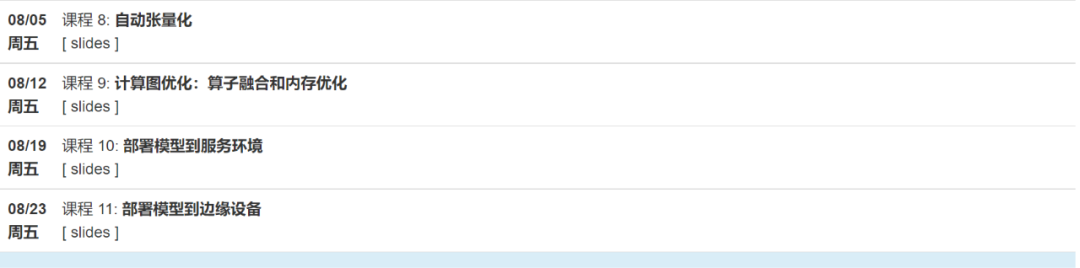

从目前公布的课程安排来看,这门课程总共有 11 次课,从 6 月 17 日一直持续到 8 月 23 日,可以陪伴大家度过一个充实的夏天。

此外,这门课程还设置了专门的中英文论坛。

中文论坛:https://github.com/mlc-ai/mlc-zh/discussions

英文论坛:https://github.com/mlc-ai/mlc-en/discussions

小板凳搬好了吗?

© THE END

转载请联系本公众号获得授权

投稿或寻求报道:content@jiqizhixin.com