双十二小编联合SIGAI人工智能平台推出AI界三大重磅福利,请接住!

双十二福利

100+高质量原创AI技术文章免费下载

《AI领域的Python核心编程》免费上课

《算法工程师进阶路径详解》免费获取

【福利一】

免费下载100+原创技术文章

www.sigai.cn首次注册用户

免费下载100+原创技术文章,

得50元平台代金券

点击进入:SIGAI历史文章汇总

【福利二】

免费上优质课程

《AI领域的Python核心编程-带你从0到1实现一个深度学习项目》

对高校学生免费开放

在职者399元买课返100元

截止目前已经有2300+同学参与了这个项目,通过用户反馈,我们发现这门课真正适合的群体是有一定编程基础,希望Python能力进阶,在深度学习领域进一步发展的同学。我们设立的目标是希望通过这门课提升你的代码能力,助力你成为合格的算法工程师。

登陆www.sigai.cn 或者SIGAI小程序即可试听

课程详细介绍

《AI领域的Python核心编程-带你从0到1实现一个深度学习项目》

课程OKR:掌握AI领域里的Python开发

会用:独立用Python实现机器学习算法

会读:读懂开源社区代码,并可以进行修改和扩展

会写:Python代码更加Pythonic,促进协作和交流

会学:有了对的认知,在编程世界自然一往无前

导师简介

丁老师:AI软件系统架构师,GitHub百星作者,HackerRank Python板块满分,累积面试100+AI算法研发及Python开发人员

课程内容

本课程分为两部分:

第一部分:21课时的AI中的Python编程基础讲解

第 1 集 课程简介,设计原则及学习方法

1.1 课程OKR

1.2 为什么要用Markdown式讲稿而非keynote

1.3 为什么学习Python

1.4 为什么做AI要学习Python

1.5 为什么学习Python3而不是Python2

1.6 课程设计原则

1.6.1 学习Python的正确姿势

1.6.2 AI领域Python的最小知识范围

1.7 课程学习方法

第 2 集 Python学习的预备内容

2.1 本节课主要内容

2.2 Linux系统简介

2.2.1 Linux

2.2.2 跨硬件平台

2.2.3 一切皆是文件

2.3 Linux命令行简介

2.3.1 shell

2.3.2 终端仿真器程序-terminal

2.4 使用SIGAI在线编程模块的terminal

2.5 Linux文件系统及读写权限简介

2.6 Linux目录结构

2.7 账户读写权限

2.7.1 看第一列字符串

2.7.2 文件类型

2.7.3 权限类型

2.8 Python解释器

2.8.1 Python的程序是怎么执行的

2.8.2 增强版解释器-IPython

2.8.3 更强的工具-Jupyter Notebook

2.8.4 REPL-DD(交互式命令行驱动开发)

2.9 SIGAI在线编程功能

2.9.1 四个模块

2.9.2 使用SIGAI在线编程模块与本地环境的区别

第 3 集 Python快速面面观(上)

3.1 课程介绍

3.2 第一个Python程序

3.3 输入与输出

3.4 Python中应知道的细节

3.5 数据类型

3.6 常量与基本运算

3.7 浅谈变量

3.8 List

3.8.1 可变有序集合

3.8.2 List之可变

3.8.3 List之有序

3.8.4 List之集合

3.9 Tuple

3.9.1 Tuple之不可变

3.9.2 Tuple之括号歧义

3.9.3 Tuple之可变

3.10 Dict

3.11 Set

3.12 Python入门小坑之除法与字符串

3.12.1 单引号,双引号,三单引号,三双引号

3.12.2 引号作为字符

3.12.3 转义字符

3.12.4 raw string

3.12.5 三引号?

3.13 Python入门小坑之字符编码

3.13.1 字符编码常见工作模式

3.13.2 Python中的字符串

3.13.3 字符串的编解码(decode&encode)

3.14 Python入门小坑之再谈变量

3.14.1 可变类型与不可变类型

3.14.2 可变对象与不可变对象

3.14.3 Python中的引用与拷贝

第 4 集 Python快速面面观(下)

4.1 本集内容简介

4.2 布尔变量的基本判断规则与方法

4.3 数字的基本判断规则与方法

4.4 Python入门小坑之逻辑判断

4.5 深入理解Python中的 and和or

4.6 if语句

4.7 循环之for循环

4.8 循环之while循环、break、continue

4.8.1 while循环:只要满足条件则持续操作

4.8.2 break语句:满足条件则跳出循环

4.8.3 continue语句:满足条件则直接进入下个循环

4.9 函数

4.9.1 调用内置函数

4.9.2 自定义函数

4.9.3 函数的默认参数

4.10 Python入门小坑之默认参数的记忆性

4.11 传入任意个数的参数

4.12 Python中的面向对象

4.13 Python代码的组织-模块

4.14 包管理工具pip

4.15 Python入门小坑之解释器默认搜索路径

第 5 集 玩转Python中的List

5.1 本集内容简介

5.2 切片

5.2.1切片功能的三个参数

5.3 多重List的浅拷贝与深拷贝

5.4 序列的加法,乘法,初始化

5.4.1 序列的加法

5.4.2 序列的乘法

5.4.3 常用的序列初始化方案

5.5 序列的常见内置方法

5.5.1 序列的包含关系:in

5.5.2 序列的长度,最大值,最小值:len,max,min

5.5.3 List与str的相互转换

5.5.4 List的元素与切片的赋值与删除

5.5.5 计数函数:count

5.5.6 列表的排序

5.5.7 Llst的内置方法及其时间空间复杂度

5.6 初见 List comprehension

第 6 集 Python中的函数与函数式编程(上)

6.1 本集内容简介

6.2 认识函数

6.2.1 代码块

6.2.2 函数定义

6.3 函数参数

6.3.1 形参与实参

6.3.2 参数的传递

6.3.3 位置参数与关键字参数

6.4 名称空间与作用域解析

6.4.1 作用域的产生

6.4.2 作用域的查看(globals()与locals())

6.4.3 作用域间变量的遮盖

6.4.4 修改不同作用域里的变量

6.4.5 作用域的生命周期

第 7 集 Python中的函数与函数式编程(下)

7.1 函数式编程概述

7.1.1 程序的状态与命令式编程

7.1.2 函数式编程

7.2 一等函数

7.2.1 一等对象

7.3 一阶函数

7.3.1 map高阶函数

7.3.2 filter高阶函数

7.3.3 reduce高阶函数

7.3.4 sorted高阶函数

7.3.5 partial高阶函数

7.4 匿名函数

7.4.1 用lambda 与用def 的区别在哪

7.4.2 lambda 速写

7.4.3 List + lambda

7.4.4 入门小坑系列之---惰性计算

第 8 集 闭包

8.1 再谈变量作用域

8.1.1 从内层函数的角度看,变量使用的两个维度

8.1.2 变量作用域识别三要素

8.1.3 三种变量作用域

8.1.4 实践和金句

8.1.5 Python解释器如何识别变量的作用域?

8.1.6 为什么会有 nonlocal 关键字?

8.2 什么是闭包?

8.2.1 闭包的各种实现方式

8.3 闭包的作用

第 9 集 装饰器

9.1 概述

9.2 Why?为什么会出现装饰器这个东西?

9.2.1 不引入多余变量名

9.2.2 显示调用,就近原则

9.2.3 分层封装,充分服用

9.3 What? 什么是装饰器

9.3.1 装饰器的堆叠

9.3.2 装饰器在导入时立即执行

9.3.3 带参数的装饰器

9.4 How?装饰器怎么用

9.4.1 装饰器的常见使用场景

9.4.2 注册机制或授权机制(与应用开发相关)

9.4.3 参数的数据验证或清洗

9.4.4 复用核心计算模块,仅改变输出方式

9.5 总结

第 10 集 理解面向对象编程(OPP)

10.1 本节课的OKR

10.1.1 三节课之间的关系:层层递进

10.1.2 本节课的object

10.1.3 本节课的key Result

10.2 什么是面向对象,什么是面向过程

10.2.1 面向过程式编程

10.2.2 面向对象式编程

10.2.3 举例说明

10.3 面向对象和面向过程的区别

10.4 比设计模式更重要的是设计原则

10.4.1 面向对象设计的目标

10.4.2 面向对象设计的SOLID原则

10.4.3 AI场景+Python(语言)+OOP(编程模式)

第 11 集 OOP in Python

11.1 本节课的OKR

11.1.1 本节课与上节课的关系

11.1.2 本节课与下节课的关系

11.1.3 本节课的Key Result

11.2 面向对象的Python实现

11.2.1 类的创建

11.2.2 类的数据绑定

11.2.3 类的自定义实现化

11.2.4 对象方法

11.2.5 类方法

11.2.6 属性封装

11.2.7 继承(隐式实例化)

11.2.8 继承(显示实例化)

11.2.9 多态

11.3 面向对象的重要特性总结

第 12 集 Pythonic OOP(上)

12.1 本节课的OKR

12.1.1 本节课的KR

12.1.2 说明

12.2 关于双下划线

12.2.1 怎么读

12.2.2 双下划线开头和结尾的变量或方法叫什么

12.2.3 如何认识Python的special method

12.3 从语言设计层面理解Python的数据模型

12.3.1 一切都是对象

12.3.2Objects 的组成⼀:identity

12.3.3Objects 的组成二:type

12.3.4Objects 的组成二:value

12.3.5 存放其他 Object 的reference的Object:Container

12.4 Pythonic OOP with SpecialMethod and Attribute

12.4.1 Theimplicit superclass – object & type object

12.4.2Integrating Seamlessly with Python

12.5 Attribute Access andProperties(Level I:Basic Access)

第 13 集 Pythonic OOP(下)

13. 1Attribute Access andProperties(Level II:Property)

13.1.1 Cross-Cutting and DuckTyping

13.1.2 单继承 vs 多态

13.2.2 传统OOP vs 鸭子类型

13.2.3 传统OOP的多态 vs 鸭子类型的多态

13.2.4MixIn:基于鸭子类型的视角看Multi-Inheritance

13.2.5Cross-Cutting:基于鸭子类型的视角看Decorator与Special Method

13.2.6Python语言设计的三个关键词(其实是一件事的三个不同视角)

13.3 总结

第 14 集 迭代器协议

14.1 本节课的OKR

14.1.1 Objective

14.1.2 Key Result

14.2 Iterator Protocol

14.3 Generator

14.3.1 yield Expression

14.3.2 Generator Expression

14.3.3 在Python中不要小瞧任何看似微小的区别

14.4 为什么需要生成器

14.4.1 用生成器表示全部的斐波那契数列

14.4.2 通过生成器管道模块化处理数据

14.5 总结:关于Python中的迭代思维

第 15 集 异常处理

15.1 什么是异常

15.2 为什么程序会出现异常

15.3 通常如何处理

15.4 Python中的异常及相关语法

15.4.1 案例:主动抛出异常

15.4.2 案例:被动遇到异常

15.4.3 案例:异常处理语句—未遇到异常

15.4.4 案例:异常处理语句—捕获全部异常

15.4.5 案例:异常处理语句—捕获指定异常

15.4.6 案例:异常处理语句—捕获异常后仍抛出

15.4.7 案例:异常处理语句—捕获异常后显示异常信息但不抛出异常 15.4.8 案例:异常语句与循环的连用

15.5 异常的传播

15.6 关于异常的后续学习

第 16 集 上下文管理器

16.1 概述

16.1.1 为什么要讲Context Manager?

16.1.2 Context Manager与Decorator之间的关系?

16.1.3 本节课的主要内容

16.2 Why?为什么我们需要Context Manager?

16.2.1 有始必有终

16.2.2 有始必有终的try/finally实现及相应的Context Manager抽象 16.2.3 When to use Context Manager?

16.3 What?什么是Context Manager?与with语句是何关系?

16.3.1 Context Manager is a protocol for Python with statement

16.3.2 案例:Context Manager通用结构

16.4 How?Context Manager都怎么使用?

16.4.1 成对出现的模式:Context Manager使用的信号

16.4.2 确保一个打开的流在程序中关闭

16.4.3 确保为测试而准备的代码执行环境在执行完毕后销毁

16.4.5 确保不同线程之间访问共享资源时的线程锁一定会释放 16.4.6 在部分代码处使用高精度模式

16.4.7 管理数据库的连接资源

16.4.8 对某一块代码进行运行时间测量

16.4.9 临时创建文件进行缓存,并在使用完毕后删除

16.4.10 一个功能的代码实现与其工程化的区别

第 17 集 导入时与运行时(上)

17.1 概述

17.2 安装Python的时候到底安装的是什么?

17.3 Python解释器是什么?

17.4 解释器由什么组成?

17.5 程序运行完整流程

17.6 模块是一个对象

17.7 模块有自己的作用域

17.8 模块只需要导入一次

第 18 集 导入时与运行时(中)

第 18 集 导入时与运行时(中)

18.1 模块通常怎么用(一):工具包

18.2 模块通常怎么用(二):测试包

18.3 模块通常怎么用(三):配置包

18.4 模块怎么变成包

18.5 模块有自己的预设字段

18.6 如果使用 from pkg import ,你需知道模块的访问限制变

第 19 集 导入时与运行时(下)

19.1 案例:模块,类,函数,在导入时与运行时的行为

19.2 案例:加上装饰器,类中类,看导入时与运行时

19.3 如果没有 if name == main,会发生什么

19.4 总结

第 20 集 结束语,后面的路靠你自己了

20.1 回顾一下整个课程内容

20.2 从课程的特点谈谈对Python教学的理解

20.3 课程的KR藏于课程设计中,而O的实现要靠你后续的努力

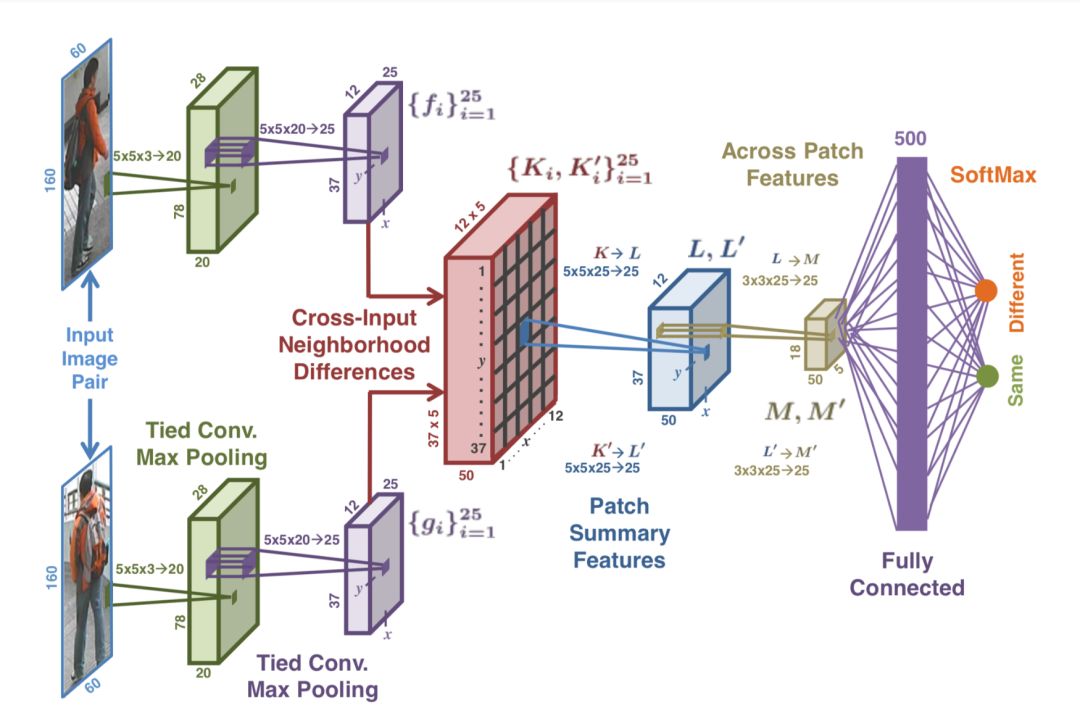

第二部分:实践项目:从读论文到代码复现(学习完基础课程并通过测评的同学才能进阶)

具体步骤:

选定一篇经典论文;

怎么搜索,怎么下载论文;

怎么阅读论文:链式反向阅读法+综述阅读法;

怎么找到训练数据集;

怎么分析数据集;

怎么实现论文的模型结构;

怎么处理数据集;

复现论文模型需要找到哪些参数;

评估结果,调试模型;

配置GPU服务器环境的流程;

训练好的模型如何使用;

毕业证书:

报名流程

Step 1: 扫码关注微信公众号SIGAICN

Step 2:回复“ Python程序员推荐 ”

Step 3: www.sigai.cn注册账号,找小编开通课程

P.S. 小编不会强行要求你转载,但是如果你觉得这门课不错,请推荐给需要的小伙伴

学习流程

www.sigai.cn注册账号

将注册用手机号发给小编,开通课程权限

登录网站,下载课件

学习基础知识部分,建议一个月内搞定(目前最快学习者7天左右搞定)

修完基础课程,找小编申请评测

评测通过,获得实践项目权限

辅助工具

在线答疑群聊(能力强的同学欢迎竞选班委,班委任职期间免费享受SIGAI深度学习专题课程)

SIGAI在线编程(本课程基于SIGAI在线编程功能进行讲解,将代码放在浏览器,轻松省力)

福利三:

助力成为一个优秀的算法工程师

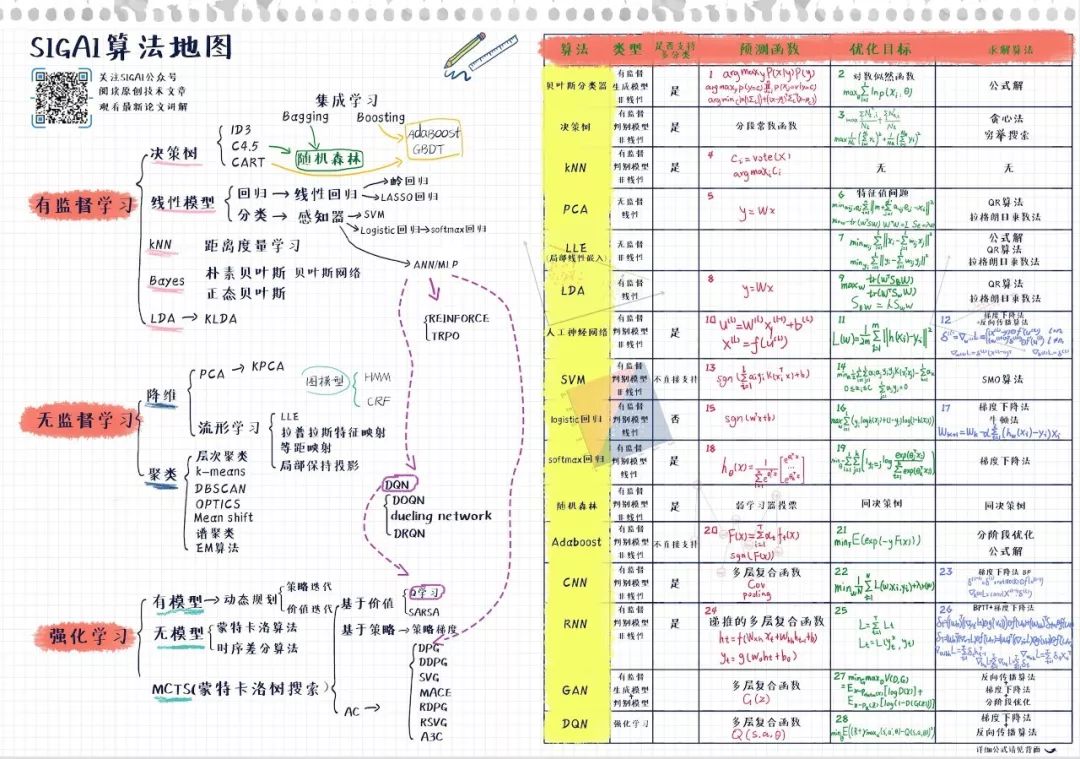

要成为优秀的算法工程师,数学基础、代码能力、算法功底三种能力缺一不可!

扫描底部SIGAI微信公众号,回复“算法地图”,即可获得算法地图高清版

关于数学基础,详见《机器学习中的数学知识》,里边详细介绍了机器学习涉及的数学知识,如果还有不清楚,也可以在网易云课堂来听下SIGAI公开课免费版《机器学习中的数学基础》或SIGAI人工智能平台的《人工智能的数学基础》。

关于算法功底,小编诚恳地说修炼之路没有捷径,只能一步一个脚印。这里推荐下我们的两门课程:

《机器学习》、《深度学习》

课程相较于CS229和CS231内容更加全面,设计更为合理

-

▲向上滑动查看机器学习课程目录(部分)

第 1 集机器学习简介

1.1 课程介绍

1.2 本集介绍

1.3 推荐的参考书

1.4 人工智能简介

1.5 机器学习简介

1.6 为什么需要机器学习1.7 机器学习的发展历史

1.8 机器学习的典型应用

1.9 业内主要公司介绍

1.10 本课程讲授的算法

1.11 本集总结

第 2 集数学知识-1

2.1 本集内容简介

2.2 学好机器学习需要哪些数学知识

2.3 推荐的参考书

2.4 本集所讲的知识点

2.5 机器学习算法所用的数学知识2.6 导数

2.7 高阶导数

2.8 导数与函数的性质

2.9 一元函数的泰勒展开

2.10 向量

2.11 矩阵

2.12 行列式

2.13 偏导数

2.14 高阶偏导数

2.15 梯度

2.16 雅可比矩阵

2.17 Hessian 矩阵

2.18 极值判别法则

2.19 二次型

2.20 特征值与特征向量2.21 特征值分解

2.22 多元函数的泰勒展开2.23 矩阵和向量求导公式

2.24 奇异值分解

2.25 为什么需要概率论2.26 随机事件与概率

2.27 条件概率与贝叶斯公式

2.28 随机事件的独立性

2.29 随机变量

2.30 数学期望与方差2.31 常用的概率分布

2.32 随机向量

2.33 随机变量的独立性2.34 协方差

2.35 常用的多维概率分布

2.36 最大似然估计

2.37 本集总结第 3 集数学知识-2

3.1 本集内容简介

3.2 最优化中的基本概念

3.3 为什么要用迭代法

3.4 梯度下降法

3.5 牛顿法3.6 坐标下降法

3.7 优化算法面临的问题

3.8 拉格朗日乘数法

3.9 凸优化简介

3.10 凸集

3.11 凸函数

3.12 凸优化的性质

3.13 凸优化的一般表述3.14 拉格朗日对偶

3.15 KKT 条件

3.16 本集总结第 4 集基本概念

4.1 本集介绍

4.2 监督信号

4.3 有监督学习

4.4 无监督学习

4.5 强化学习

4.6 分类问题

4.7 回归问题

4.8 线性回归

4.9 判别模型与生成模型4.10 准确率

4.11 回归误差

4.12 精度与召回率

4.13 ROC 曲线

4.14 混淆矩阵

4.15 交叉验证

4.16 欠拟合

4.17 过拟合

4.18 欠拟合与过拟合总结4.19 偏差与方差分解

4.20 正则化

4.21 岭回归

4.22 本集总结

第 5 集贝叶斯分类器

5.1 本集简介

5.2 贝叶斯公式

5.3 朴素贝叶斯分类器

5.4 正态贝叶斯分类器

5.5 实验环节

5.6 实际应用

5.7 本集总结第 6 集决策树

6.1 本集内容介绍6.2 树与二叉树简介

6.3 决策树简介

6.4 决策树的表示能力

6.5 训练算法要解决的核心问题6.6 递归分裂过程

6.7 寻找最佳分裂

6.8 叶子节点值的设定

6.9 属性缺失与替代分裂

6.10 过拟合与剪枝

6.11 实验环节

6.12 实际应用

6.13 本集总结第 7 集k近邻算法

7.1 本集简介

7.2 k 近邻算法

7.3 预测算法

7.4 距离函数

7.5 距离度量学习7.6 实验环节

7.7 实际应用

7.8 本集总结

第 8 集数据降维1

8.1 本集内容简介

8.2 为什么需要数据降维

8.3 PCA 简介

8.4 计算投影矩阵

8.5 完整的算法流程8.6 实验环节

8.7 实际应用

8.8 本集总结

第 9 集数据降维2

9.1 本集内容简介9.2 非线性降维技术简介

9.3 流形简介

9.4 流形学习简介

9.5 局部线性嵌入9.6 拉普拉斯特征映射

9.7 局部保持投影

9.8 等距映射

9.9 实验环节9.10 本集总结

第 10 集线性判别分析

10.1 本集内容简介

10.2 LDA 的基本思想

10.3 寻找最佳投影方向

10.4 推广到高维和多类的情况10.5 PCA 与 LDA 的比较

10.6 实验环节

10.7 实际应用

10.8 本集总结

第 11 集人工神经网络 1

11.1 本集内容简介

11.2 动物神经系统的基本原理11.3 人工神经网络的基本思想

11.4 神经元的原理

11.5 sigmiod 函数

11.6 神经网络的结构

11.7 神经网络每一层完成的变换11.8 正向传播算法

11.9 神经网络的本质

11.10 怎样用于实际问题第 12 集人工神经网络 2

12.1 本集内容简介

12.2 反向传播算法概述12.3 反向传播算法的历史

12.4 正向传播算法回顾

12.5 优化目标函数

12.6 欧氏距离的求导公式

12.7 链式法则

12.8 基础求导公式

12.9 求导的整体思路

12.10 权重和偏置的求导公式12.11 输出层的求导

12.12 误差项的计算

12.13 完整的算法

12.14 算法总结

12.15 工程实现细节

12.16 本集总结

第 13 集人工神经网络 3

13.1 本集内容简介

13.2 实验环节

13.3 理论分析13.4 理论分析-拟合能力

13.5 理论分析-与神经系统的关系

13.6 实现细节问题

13.7 输入与输出值的设定

13.8 网络的规模

13.9 激活函数

13.10 损失函数

13.11 参数初始化

13.12 正则化

13.13 学习率的设定

13.14 动量项

13.15 挑战与改进措施

13.16 梯度消失问题

13.17 退化

13.18 局部极小值

13.19 鞍点问题

13.20 损失函数曲面分析

13.21 实际应用

13.22 实践项目

13.23 本集总结第 14 集支持向量机 1

14.1 本集内容简介

14.2 支持向量机简介

14.3 线性分类器

14.4 分类间隔

14.5 线性可分的原问题14.6 线性可分的对偶问题

14.7 线性可分的实验

14.8 线性不可分的原问题14.9 线性不可分的对偶问题

14.10 KKT 条件的使用

14.11 线性不可分的实验14.12 核函数实验

14.13 核映射与核函数14.14 本集总结

第 15 集支持向量机 2

15.1 本集内容简介

15.2 对偶问题求解面临的问题15.3 SMO 算法简介

15.4 求解子问题

15.5 子问题是凸优化问题的证明15.6 SMO 算法的收敛性

15.7 优化变量的选择

15.8 完整的算法

15.9 实现细节问题

15.10 本集总结第 16 集支持向量机 3

16.1 本集内容简介

16.2 多分类问题

16.3 libsvm 简介

16.4 实验环节

16.5 实际应用

16.6 应用时的细节问题

16.7 SVM 整体推导思路的总结第 17 集线性模型 1

17.1 本集内容简介

17.2 线性模型

17.3 logistic 回归的基本思想17.4 预测函数

17.5 试验

17.6 优化目标函数

17.7 凸优化证明

17.8 梯度下降法求解

17.9 另一种形式的对数似然函数

17.10 L2 正则化 logistic 回归

17.11 L1 正则化 logistic 回归

17.12 liblinear 简介

17.13 实验

17.14 softmax 回归

17.15 实际应用

17.16 本集总结第 18 集线性模型 2

18.1 本集内容简介

18.2 线性支持向量机简介18.3 L2 正则化 L1-loss 原问题

18.4 L2 正则化 L2-loss 原问题

18.5 L2 正则化对偶问题

18.6 L1 正则化 L2-loss 原问题18.7 多类线性支持向量机

18.8 实验

18.9 libsvm 和 liblinear 的比较18.10 实际应用

18.11 本集总结第 19 集随机森林

19.1 本集内容简介

19.2 集成学习简介

19.3 Bootstrap 抽样

19.4 Bagging 算法

19.5 随机森林的基本原理19.6 训练算法

19.7 包外误差

19.8 计算变量的重要性19.9 实验

19.10 实际应用

19.11 本集总结第 20 集AdaBoost算法1

20.1 本集内容简介

20.2 再论集成学习算法20.3 Boosting 算法简介

20.4 AdaBoost 的预测算法

20.5 训练算法

20.6 训练算法的解释

20.7 算法的总结

20.8 与随机森林的比较

20.9 训练误差分析

第 21 集AdaBoost算法2

21.1 本集内容简介

21.2 广义加法模型

21.3 指数损失函数

21.4 AdaBoost 训练算法的推导21.5 实现细节问题

21.6 弱分类器的选择

21.7 弱分类器数量的确定

21.8 样本权重削减

第 22 集AdaBoost算法3

22.1 本集内容简介

22.2 实验环节

22.3 应用简介22.4 VJ 框架简介

22.5 滑动窗口技术

22.6 分类器级联

22.7 Haar 特征

22.8 积分图

22.9 训练算法的原理22.10 训练自己的模型

22.11 VJ 框架的改进

22.12 AdaBoost 算法总结

第 23 集高斯混合模型与 EM 算法

23.1 本集内容简介

23.2 高斯混合模型简介

23.3 实际例子23.4 训练算法面临的问题

23.5 EM 算法

23.6 实现细节与面临的问题23.7 应用-视频背景建模

23.8 本集总结

第 24 集聚类算法 1

24.1 本集内容简介24.2 聚类问题简介

24.3 聚类算法的分类

24.4 层次聚类流程

24.5 层次聚类的实例

24.6 簇距离的定义

24.7k 均值算法的基本思想

24.8k 均值算法的流程

24.9 实现细节问题与改进方案24.10 实验

24.11EM 算法简介

24.12Jensen 不等式

24.13EM 算法的推导

24.14EM 算法的流程

24.15EM 算法收敛性的证明

第 25 集聚类算法 2

25.1 本集内容简介

25.2 基于密度的算法简介25.3DBSCAN 算法简介

25.4 基本概念

25.5DBSCAN 算法的核心思想25.6DBSCAN 算法的流程

25.7 实现细节问题

25.8 实验

25.9DBSCAN 算法的优缺点25.10OPTICS 算法简介

25.11 基本概念

25.12 算法的流程

25.13 根据排序结果得到聚类结果25.14 实验

25.15Mean Shift 算法

25.16Mean Shift 算法的流程25.17 谱聚类算法简介

25.18 图切割问题

25.19 优化目标函数

25.20 算法的流程

25.21 聚类算法的评价指标

25.22 实际应用

25.23 聚类算法总结第 26 集隐马尔可夫模型

26.1 本集内容简介

26.2 概率图模型简介26.3 马尔可夫模型简介

26.4 状态与状态转移矩阵

26.5 马尔可夫性

26.6 马尔可夫模型

26.7 模型的训练

26.8 隐马尔可夫模型简介26.9 隐马尔可夫模型的核心问题

26.10 估值问题

26.11 解码问题

26.12 训练问题26.13 实际应用

26.14 本集总结

第 27 集强化学习 1

27.1 本集内容简介27.2 强化学习简介

27.3 马尔可夫决策过程

27.4 状态价值函数

27.5 策略价值函数

27.6 贝尔曼最优性方程

27.7 动态规划算法简介

27.8 策略迭代算法

27.9 价值迭代算法

第 28 集强化学习 2

28.1 本集内容简介

28.2 无模型算法简介

28.3 蒙特卡洛算法简介

28.4 状态价值函数估计

28.5 动作价值函数估计

28.6 蒙特卡洛控制

28.7 蒙特卡洛算法存在的问题28.8 时序差分算法简介

28.9Sarsa 算法

28.10Q 学习算法

28.11 强化学习总结第 29 集工程实践问题

29.1 本集内容简介

29.2 样本与标注

29.3 特征构造

29.4 特征预处理

29.5 模型选择问题

29.6 过拟合问题

29.7 参数调优

29.8 本集总结

第 30 集实践项目

30.1 实践项目说明

30.2 用 HOG+线性支持向量机进行目标检测30.3 用 logistic 回归进行数据预测

30.4 用全连接神经网络进行图像分类

30.5 用 AdaBoost 算法进行目标检测

30.6 用支持向量机进行文本分类

30.7 用随机森林进行数据预测

30.8 用 PCA+LDA 进行人脸识别

30.9 用聚类算法进行数据分析第 31 集各种算法总结

更多内容详见SIGAI.cn网站

此外,SIGAI邀请了各个方向的资深专家就其研究领域遇到的高质量论文进行精彩解读,部分还包含源码解读并附带源码,对于正在埋头苦读论文的同学,这波助攻确实给力。见SIGAI人工智能平台->知识库

《机器学习》课程大纲

课程导师是《机器学习和应用》(12月即将在清华出版社出版)一书的作者雷老师亲自录制,这里稍稍分享几篇雷老师出的好文,希望能够让你有所收益。

《行人检测算法》

《图像分割技术介绍》

所有资源科通过扫描文末二维码,进入SIGAI小程序或者登陆www.sigai.cn公众号获取。

最后,算法工程师之路需要耐心和毅力,现在开始不骄不躁的积累,才能为自己成就一个美好未来。

再次强调免费Python核心编程课程的报名方式:扫码关注微信公众号SIGAICN,回复“Python程序员推荐”

如果你觉得文章不错,欢迎点赞分享到朋友圈