面向深度学习模型的对抗攻击与防御方法综述

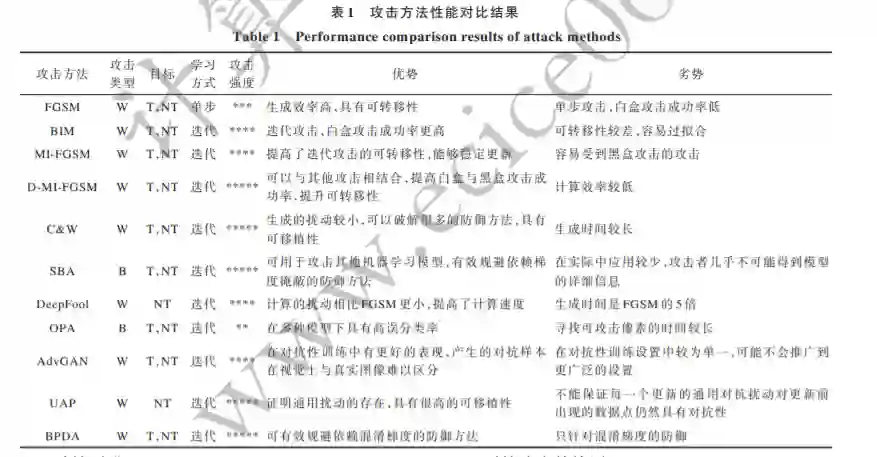

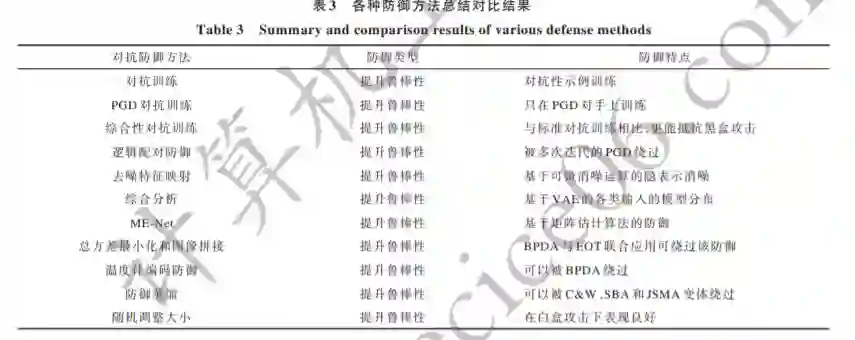

摘要: 深度学习作为人工智能技术的重要组成部分,被广泛应用于计算机视觉和自然语言处理等领域。尽管深度学习在图像分类和目标检测等任务中取得了较好性能,但是对抗攻击的存在对深度学习模型的安全应用构成了潜在威胁,进而影响了模型的安全性。在简述对抗样本的概念及其产生原因的基础上,分析对抗攻击的主要攻击方式及目标,研究具有代表性的经典对抗样本生成方法。描述对抗样本的检测与防御方法,并阐述对抗样本在不同领域的应用实例。通过对对抗样本攻击与防御方法的分析与总结,展望对抗攻击与防御领域未来的研究方向。

http://www.ecice06.com/CN/10.19678/j.issn.1000-3428.0059156

随着人工智能技术的快速发展,深度学习已广 泛应用于图像分类[1-3] 、目标检测[4-6] 和语音识别[7-9] 等 领域,但由于其自身存在若干技术性不足,导致深度 学习在给人们生活带来极大便利的同时也面临着较 多挑战,模型算法的安全隐患更是加剧了深度学习 技术被对抗样本欺骗以及隐私泄露等安全风险,因 此深度学习的安全问题[10] 引起了研究人员的广泛关 注。在早期研究中,针对深度学习算法潜在攻击以 及相应防御方法的研究,主要关注模型的攻击成功率以及是否能够成功规避某种攻击方法。以传统的 分类模型为例,其存在判断准确度越高则模型鲁棒 性越低这一问题,因此,学者们开始关注模型鲁棒性 和准确度的平衡问题。

现有综述性文献多数倾向于阐述传统的对抗攻 击与防御方法。近年来,对抗样本的研究变得多样 化,早期研究通常将对抗样本视为神经网络的一种 威胁,近期学者们聚焦于如何在不同领域利用对抗 样本的特性来更好地完成分类和识别等任务。2013 年,SZEGEDY 等人[11] 利用难以察觉的扰 动 来 揭 示 深 度 神 经 网 络 的 脆 弱 特 性 。2014 年 ,GOODFELLOW 等 人[12]提 出 对 抗 样 本 的 概 念 。此 后,越来越多的研究人员专注于该领域的研究。早 期的研究工作致力于分析不同深度学习模型(如循 环神经网络、卷积神经网络等)中的漏洞以及提高模 型对对抗样本的鲁棒性。BARRENO 等人[13] 对深度 学习的安全性进行了调研,并针对机器学习系统的 攻击进行分类。PAPERNOT 等人[14] 总结了已有关 于机器学习系统攻击和相应防御的研究成果,并系 统分析机器学习的安全性和隐私性,提出机器学习 的威胁模型。近年来,针对对抗样本的研究更加多 样化。2019 年,XIE 等人[15] 提出利用对抗样本改进 图像识别模型精度的方法。2020 年,DUAN 等人[16] 利用风格迁移技术[17] 使对抗样本在物理世界变得人 眼不可察觉,以达到欺骗算法的目的。由于深度学 习模型存在脆弱性,类似的对抗攻击同样会威胁深 度学习在医疗安全、自动驾驶等方面的应用。

自从对抗攻击的概念被提出之后,研究人员不 断提出新的攻击方法和防御手段。现有的对抗攻击 方法研究主要针对对抗样本的生成方法以及如何提 高对模型的攻击成功率,对抗防御研究主要关注基 于对抗样本的检测与提高模型鲁棒性 2 个方面。本文介绍对抗样本的概念、产生的原因及对抗样本的 可迁移性,分析现阶段经典的对抗样本生成方法以 及检测手段,并归纳针对上述检测手段的防御策略, 通过梳理分析较为先进的对抗样本应用方法以展望 该领域未来的研究方向。

专知便捷查看

便捷下载,请关注专知公众号(点击上方蓝色专知关注)

后台回复“对抗防御” 可以获取《面向深度学习模型的对抗攻击与防御方法综述》专知下载链接索引