联邦学习中的隐私和鲁棒性:攻击和防御, 杨强等学者最新综述论文,16页pdf

首篇关于联邦学习隐私鲁棒性攻击防御的综述论文

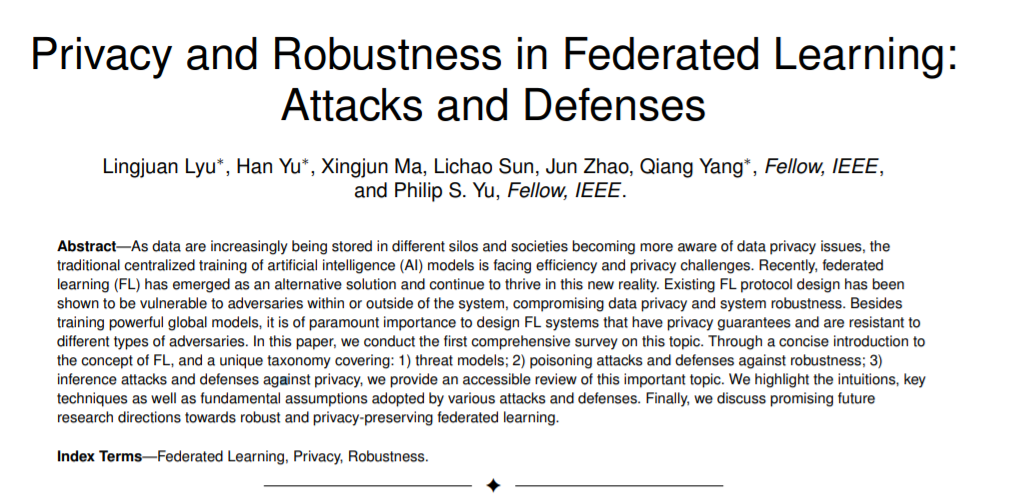

随着数据越来越多地存储在不同的筒仓中,社会越来越关注数据隐私问题,传统的人工智能(AI)模型集中训练正面临效率和隐私方面的挑战。最近,联邦学习(FL)作为一种替代解决方案出现,并在这种新的现实中继续蓬勃发展。现有的FL协议设计已经被证明对系统内外的对抗是脆弱的,危及数据隐私和系统的鲁棒性。除了训练强大的全局模型外,最重要的是设计具有隐私保障和抵抗不同类型对手的FL系统。在本文中,我们对这一问题进行了第一次全面的综述。通过对FL概念的简明介绍,和一个独特的分类涵盖:1) 威胁模型; 2) 中毒攻击与鲁棒性防御; 3) 对隐私的推理攻击和防御,我们提供了这一重要主题的可访问的回顾。我们强调了各种攻击和防御所采用的直觉、关键技术和基本假设。最后,我们对鲁棒性和隐私保护联合学习的未来研究方向进行了讨论。

https://www.zhuanzhi.ai/paper/678e6e386bbefa8076e699ebd9fd8c2a

引言

随着计算设备变得越来越普遍,人们在日常使用中产生了大量的数据。将这样的数据收集到集中的存储设施中既昂贵又耗时。传统的集中式机器学习(ML)方法不能支持这种普遍存在的部署和应用,这是由于基础设施的缺点,如有限的通信带宽、间歇性的网络连接和严格的延迟约束[1]。另一个关键问题是数据隐私和用户机密性,因为使用数据通常包含敏感信息[2]。面部图像、基于位置的服务或健康信息等敏感数据可用于有针对性的社交广告和推荐,造成即时或潜在的隐私风险。因此,私人数据不应该在没有任何隐私考虑的情况下直接共享。随着社会对隐私保护意识的增强,《通用数据保护条例》(GDPR)等法律限制正在出现,这使得数据聚合实践变得不那么可行。

在这种情况下,联邦学习(FL)(也被称为协作学习)将模型训练分发到数据来源的设备上,作为一种有前景的ML范式[4]出现了。FL使多个参与者能够构建一个联合ML模型,而不暴露他们的私人训练数据[4],[5]。它还可以处理不平衡、非独立和同分布(非i.i.d)数据,这些数据自然出现在真实的[6]世界中。近年来,FL获得了广泛的应用,如下一个单词预测[6]、[7]、安全视觉目标检测[8]、实体解析[9]等。

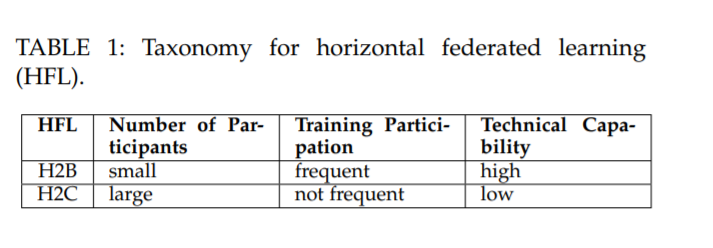

根据参与者之间数据特征和数据样本的分布,联邦学习一般可以分为水平联邦学习(HFL)、垂直联邦学习(VFL)和联邦迁移学习(FTL)[10]。

具有同构体系结构的FL: 共享模型更新通常仅限于同构的FL体系结构,也就是说,相同的模型被所有参与者共享。参与者的目标是共同学习一个更准确的模型。具有异构架构的FL: 最近的努力扩展了FL,以协同训练具有异构架构的模型[15],[16]。

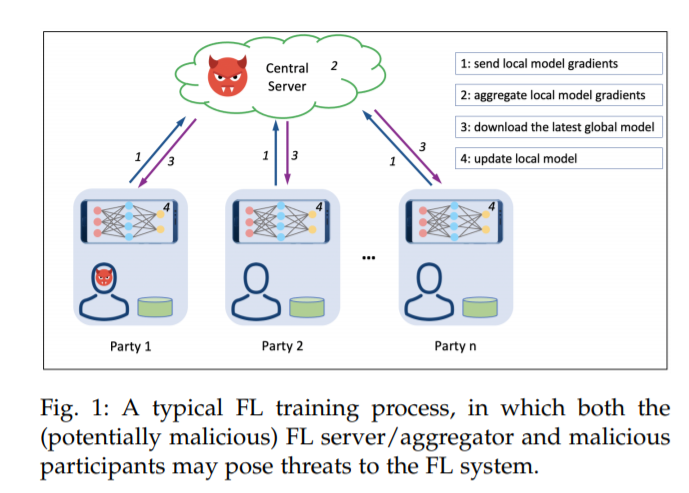

FL提供了一个关注隐私的模型训练的范式,它不需要数据共享,并且允许参与者自由地加入和离开联盟。然而,最近的研究表明,FL可能并不总是提供足够的隐私和健壮性保证。现有的FL协议设计容易受到以下攻击: (1)恶意服务器试图从个人更新中推断敏感信息,篡改训练过程或控制参与者对全局参数的看法;或者(2)一个敌对的参与者推断其他参与者的敏感信息,篡改全局参数聚合或破坏全局模型。

在隐私泄露方面,在整个训练过程中,通信模型的更新会泄露敏感信息[18]、[19],并导致深度泄露[20],无论是对第三方服务器还是中央服务器[7]、[21]。例如,如[22]所示,即使是很小一部分的梯度也可以揭示相当数量的有关本地数据的敏感信息。最近的研究表明,通过简单地观察梯度,恶意攻击者可以在[20],[23]几次迭代内窃取训练数据。

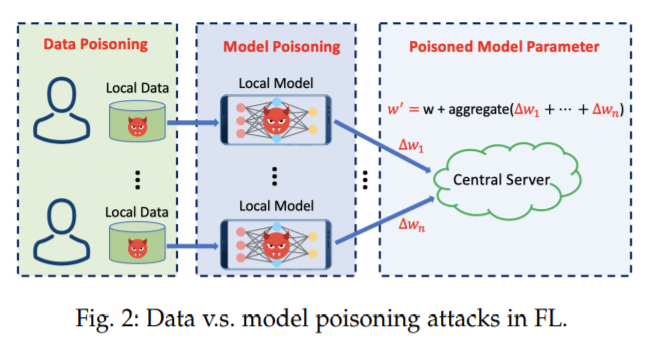

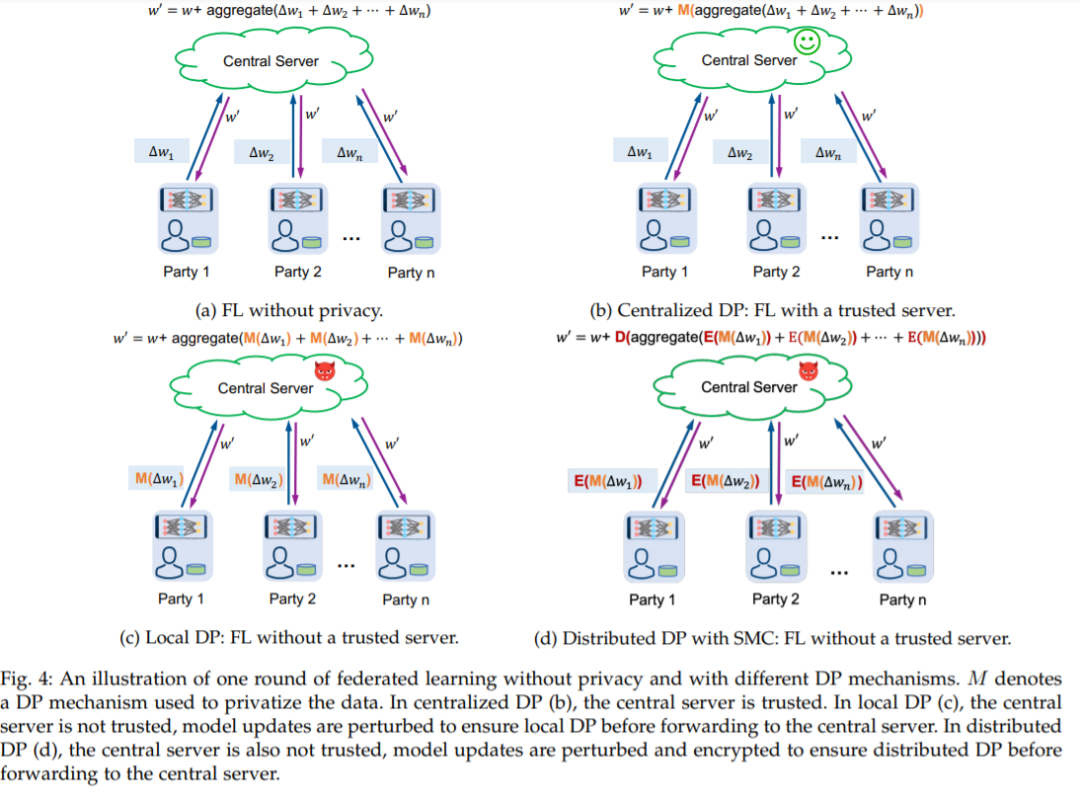

在鲁棒性方面,FL系统容易受到[24]、[25]和[26]、[27]、[28]、[29]的模型中毒攻击。恶意参与者可以攻击全局模型的收敛性,或者通过故意改变其本地数据(数据中毒)或梯度上传(模型中毒)将后门触发器植入全局模型。模型投毒攻击可以进一步分为:(1)Byzantine 攻击,攻击者的目标是破坏全局模型[13]、[30]的收敛性和性能;(2)后门攻击,对手的目标是在全局模型中植入一个后门触发器,以欺骗模型不断预测子任务上的敌对类,同时在主要任务[26],[27]上保持良好的性能。需要注意的是,后门模型投毒攻击通常利用数据投毒来获取有毒的参数更新[24]、[26]、[27]。

这些隐私和鲁棒性攻击对FL构成了重大威胁。在集中学习中,服务器控制参与者的隐私和模型鲁棒性。然而,在FL中,任何参与者都可以攻击服务器并监视其他参与者,有时甚至不涉及服务器。因此,理解这些隐私性和健壮性攻击背后的原理是很重要的。

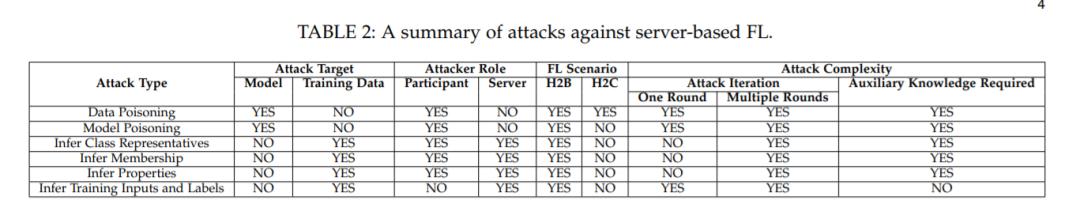

目前对FL的研究主要集中在系统/协议设计[10]、[31]、[32]。联邦学习的隐私和稳健性威胁还没有得到很好的探讨。在本文中,我们调研了FL的隐私和鲁棒性威胁及其防御方面的最新进展。特别地,我们关注由FL系统内部者发起的两种特定威胁:1) 试图阻止学习全局模型的中毒攻击,或控制全局模型行为的植入触发器;2) 试图泄露其他参与者隐私信息的推理攻击。表2总结了这些攻击的特性。

专知便捷查看

便捷下载,请关注专知公众号(点击上方蓝色专知关注)

后台回复“PRFL” 可以获取《联邦学习中的隐私和鲁棒性:攻击和防御, 杨强等学者最新综述论文,16页pdf》专知下载链接索引