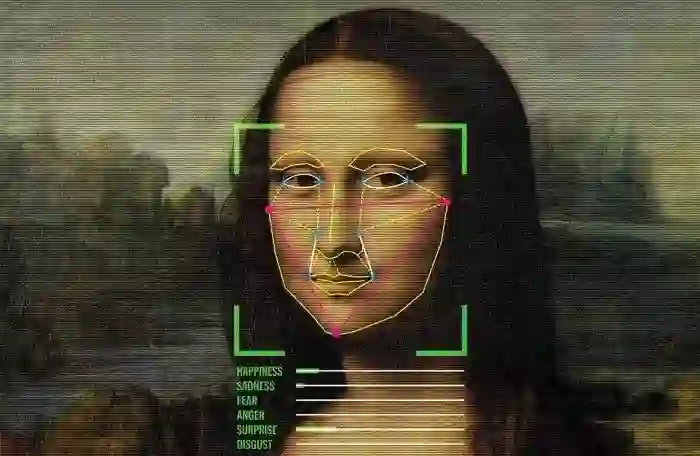

从看脸到读心:深度理解人的视觉技术走到哪了?

作者 | 蒋宝尚

登录查看更多

相关内容

山世光,中科院计算所 中科院计算所研究员、博导,现任中科院智能信息处理重点实验室常务副主任。他的研究领域为计算机视觉和机器学习。已在国内外刊物和学术会议上发表论文300余篇,其中CCFA类论文80余篇,论文被谷歌学术引用16000余次。研究成果获2005年度国家科技进步二等奖(第3完成人),2015年度国家自然科学二等奖(第2完成人),CVPR2008BestStudentPosterAwardRunner-up奖。他带领团队研发的人脸识别技术已应用于公安部门、华为等众多产品或系统中。曾担任过CVPR19/20,ICCV11,FG13/18/20,BTAS18,ACCV12/16/18,ICPR12/14/20,ICASSP14等十余次领域主流国际会议的领域主席,现/曾任IEEETIP,CVIU,PRL,Neurocomputing,FCS等国际学术刊物的编委(AE)。他是基金委优青,第三批国家万人计划入选者,科技部创新人才推进计划中青年科技创新领军人才,人社部国家百千万人才工程有突出贡献中青年专家,国务院特殊津贴专家,CCF青年科学家奖获得者。个人主页:http://vipl.ict.ac.cn/people/~sgshan

Arxiv

3+阅读 · 2017年12月28日