腾讯AI Lab NLP 团队首次曝光,张潼、俞栋带队解读ACL三大前沿

1新智元推荐

来源:腾讯 AI Lab

【新智元导读】 本文将深度解析2017ACL热门研究。文章第一部分是三大前沿领域重点文章解析,包括信息抽取、问答系统和机器翻译等。第二部分是ACL简介及腾讯自然语言处理(NLP)团队首次曝光。

腾讯 AI Lab去年四月成立,今年是首次参展ACL,共计三篇文章被录取,位居国内企业前列。此次团队由实验室主任张潼博士与副主任俞栋博士共同带领到现场交流学习。

下左图:参与ACL的团队;下右图:现场论文展示

从研究领域和前沿思考出发,我们重点关注了三大领域的前沿研究,以下为重点论文评述。

以下论文均可在官网下载:http://t.cn/R9ynux4

随着人工智能的发展,图灵测试受到越来越多的挑战,问答系统(QA)就是其中一个尝试:试图让机器用准确、简洁的语言回答用户提出的自然语言问题。近年来,基于神经网络的问答系统已成主流。在本届ACL,知识问答系统(KBQA)及检索式问答系统(IRQA)也继续在神经网络模型基础之上有新突破:一方面在知识问答系统中,在解决问题表示以及答案生成任务时,基于端到端神经网络模型被进一步优化;另一方面,检索式问答系统中,针对小规模文档精确检索以及针对大规模文档快速检索,有了新尝试和突破。

一、知识问答系统

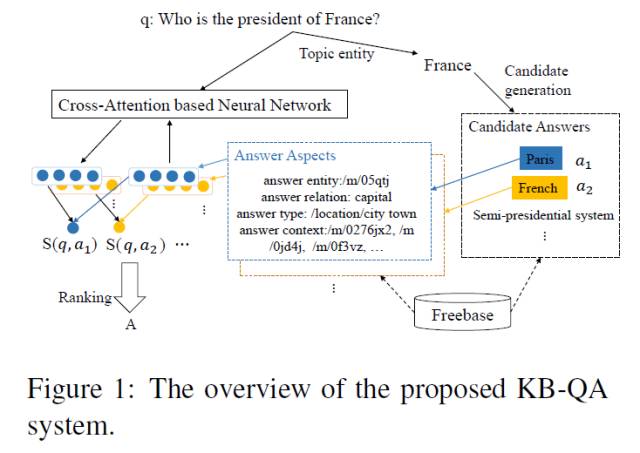

1、An End-to-End Model for Question Answering over Knowledge Base with Cross-Attention Combining Global Knowledge

基于神经网络的知识问答系统已取得瞩目成绩,然而传统神经网络方法在进行问句表示的同时,并没有考虑答案对其影响。这篇中科院和百度合作完成的文章中,作者提出了一种基于端到端的神经网络模型,特别地利用交叉注意力机制对问句和答案进行互相关注。一方面利用答案信息动态地进行问句表示,使得问句表示更加灵活充分;另外一方面也根据问题对答案不同方面的不同关注,对问句答案得分进行不同权重表示。此外,知识库全局知识被进一步引入用来训练Embedding并扩展词表,从而充分捕捉到知识库的全局结构信息,并缓解了传统模型中的词表溢出问题。在公开的数据集WebQuestions上,实验证明该方法能有效提升端到端模型实验性能。

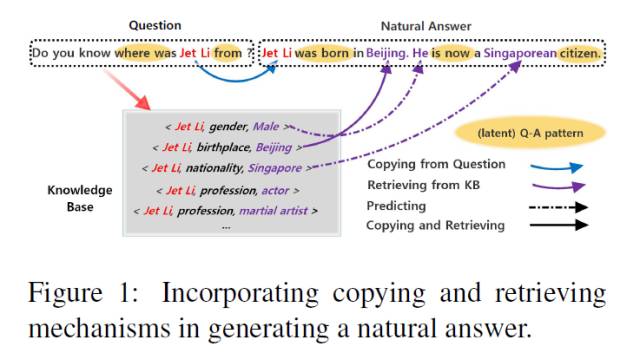

2、Generating Natural Answers by Incorporating Copying and Retrieving Mechanisms in Sequence-to-Sequence Learning

如何让知识问答系统生成自然语言形式的答案目前仍是一大挑战,中科院发表的这篇文章给出了一种可融入外部知识库的端到端神经网络模型。为给出一个自然的答案,此模型使用了端到端的语言模型。同时为引入外部知识库,而引入了检索机制。针对需要结合多个事实回答的复杂问句,模型用三种不同模式获取词汇并进行选取:用拷贝方式取得问句中的实体、用预测方式产生让答案更自然的连接词、用检索方式获取相关事实并结合多个相关事实产生复杂问句的自然形式的答案。论文分别在模拟数据集和真实数据集上进行了模型检验,在自动评估和人工评估上都证实了其模型超出其他传统端到端模型。

二、检索式问答系统

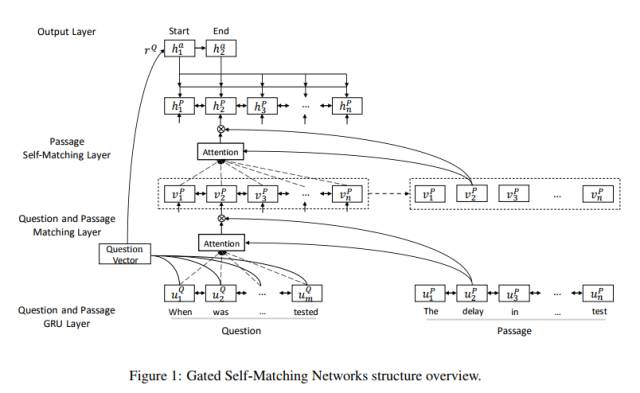

1、Gated Self-Matching Networks for Reading Comprehension and Question Answering

检索式问答系统试图从文档中获取问题的答案。一般步骤是先从一众文档中检索相关文档,然后再进一步检索出相关篇章。由北大和微软合作发表的这篇文章重点解决后面一步,即阅读理解式的问答系统。文章基于端到端的多层神经网络模型从篇章中获取答案。

模型分为四部分:一是使用多层双向神经网络编码问题和篇章的语义向量表示;二是使用门注意力机制得到问题感知的篇章的语义向量表示;三是通过Self-Matching注意力机制提炼篇章的语义向量表示,从全部篇章中编码最终语义向量表示;四是利用Pointer-network来预测答案边界,从而得到最终答案。在Stanford发布的机器阅读理解比赛数据集SQuAD上,本文提出的模型的单模型和集成模型结果都分别排名第一。

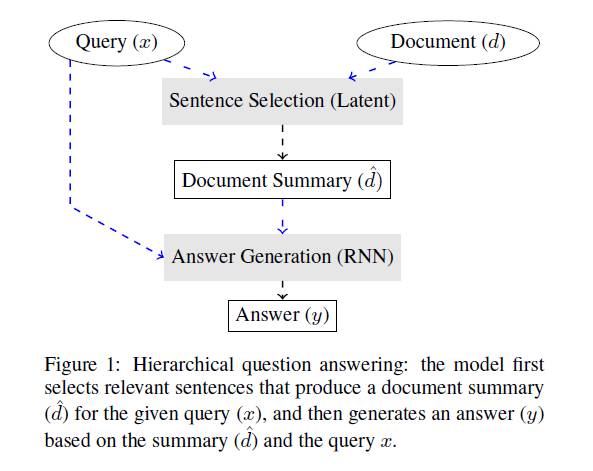

2、Coarse-to-Fine Question Answering for Long Documents

大规模文档中检索答案在时间有效性上目前仍是一大挑战,由华盛顿大学和谷歌等多家机构联合发表的这篇文章中,针对大规模文档检索提出了一种高效检索并保持甚至提高目前最先进模型性能的架构 - 模型分层对文档检索。首先使用快速模型从大规模文档中选择问题相关的少量句子:使用三种不同句子简单表示方式处理大规模文档,然后利用Hard或Soft注意力机制得到文档的一个摘要表示,并使用三种不同方式选择少量候选句子,然后才用相对慢速的端到端神经网络模型从候选句子中产生最终结果。在WIKIREADING部分数据集上,实验结果显示此框架可以比基础模型检索速度高出3.5到6.7倍。

粗略统计,本届ACL有27篇机器翻译相关的论文(15篇长文+12篇短文)。我们总结了三大未来趋势,重点关注其中三个较有代表性方向的相关研究工作。

趋势一:神经网络机器翻译的进一步可视化,建立起神经网络内部向量数字和自然语言结构的关联,为神经网络翻译模型提供更有效的理解和调试工具。

趋势二:神经网络机器翻译模型框架的优化。最近的工作表明递归神经网络并不是神经网络机器翻译模型的惟一选择,Facebook最近的工作使用CNN全面替代RNN,Google更进一步只用前向神经网络+注意力机制,均取得了速度和翻译效果上的进步。如果找到一种在效果和可解释性上更优的模型框架,是未来的一个重要研究方向。

趋势三:解决更通用的翻译问题。虽然当前神经网络机器翻译方法和过去的统计机器翻译方法差异很大,但很多翻译问题是相通的,所以解决通用的翻译问题也是未来的一个研究趋势。比如如何在资源匮乏领域构建好的翻译模型,如何进行篇章级翻译,以及如何在当前词级别的神经网络翻译模型中进行短语的翻译?腾讯AI Lab最近接收的两篇EMNLP 2017论文对后两个问题进行了初步探索。

一、基于句法的翻译模型

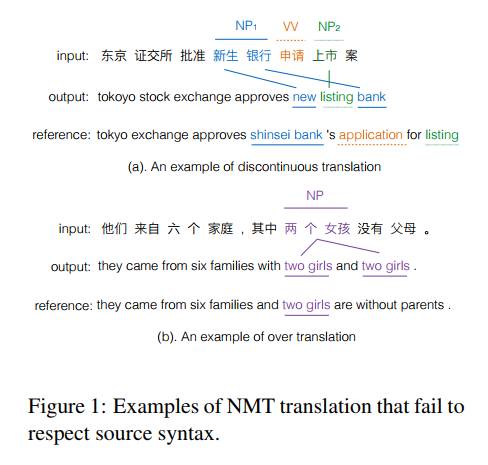

本次会议中,有关如何在神经网络翻译模型中引入句法信息的工作共有8篇,是本届会议中机器翻译领域的一个重要方向。受过去统计机器翻译发展脉落(从基于字符串的翻译模型到基于句法树的翻译模型)的启发,来自不同单位的研究者探讨了各种引入句法信息的方式,包括引入源端句法树或目标端句法树,使用成分句法树或依存句法树及至浅层组块结构。

腾讯AI Lab研究员参与的两个研究[1-2]分别探索了从源端和目标端引入句法信息的可能性。第一个工作通过使用一种简单有效的方式将句法树转化为句法标签序列,在不更改序列到序列模型框架的条件下将源端句法信息引入神经网络翻译系统中。第二个工作则是在解码器端引入一个额外的组块层,通过限定每个组块短语中的所有词共用一个组块层状态及源端上下文向量,不仅引入了目标端的句法信息,同时以一种比较巧妙的方式引入“短语”翻译。

* [1] Modeling Source Syntax for Neural Machine Translation; [2]Chunk-Based Bi-Scale Decoder for Neural Machine Translation

二、神经网络的理解和可视化

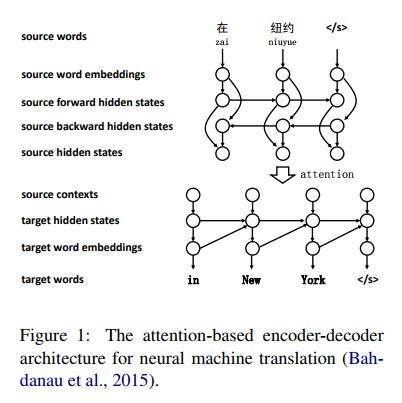

神经网络机器翻译模型自2014年被提出以来,一个主要问题是神经网络结构及运行过程的不可解释性,让研究者无法根据翻译出现的问题对网络结构进行针对性改进设计,从而引发一个重要问题 - 当前神经网络模型无法保证将源端语义内容无损传递至目标端,让生成的译文流畅度较好但忠实度不足,比如遗漏翻译或过度翻译错误。

本次会议有两篇论文尝试理解及可视化神经网络模型,其中一篇ACL Outstanding Paper来自清华大学NLP组[1],他们提出了一种新的可视化方法,通过计算神经网络中任意两个神经元之间的相关性,为分析、理解和调试神经网络机器翻译提供了可能性。

[1] Visualizing and Understanding Neural Machine Translation

另一篇论文[2]则通过外在词性和形态标注任务来评判通过不同粒度方法训练得到的词语表示,分析神经网络翻译模型对词语的理解能力。

[2]What do Neural Machine Translation Models Learn about Morphology?

三、神经网络结构的改进

本次会议同样有多篇工作尝试对当前神经网络结构进行改进,其中三篇工作比较有代表性:

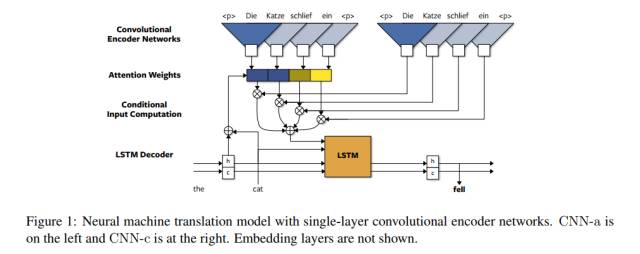

1、A Convolutional Encoder Model for Neural Machine Translation

在编码器端使用卷积神经网络(CNN)代替主流的递归神经网络(RNN),在效果相当的前提下速度提升近2倍。

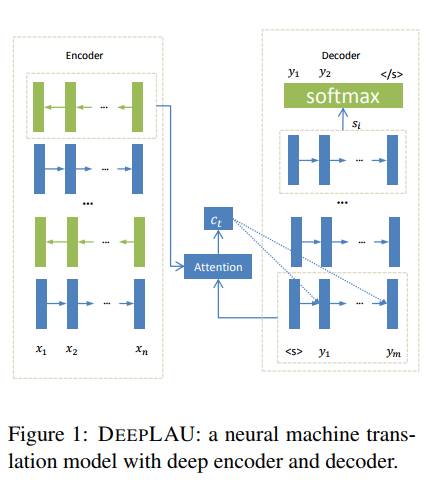

2、Deep Neural Machine Translation with Linear Associative Unit

为当前主流的非线性Gating RNN(比如LSTM或GRU)提供了一种线性的可能替代(Linear Associative Unit),在深层神经网络中取得了较好效果。

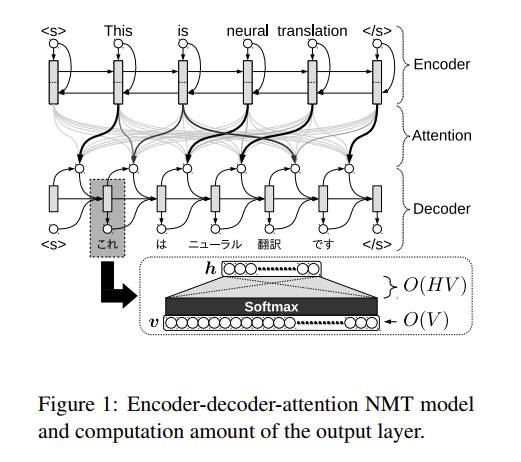

3、Neural Machine Translation via Binary Code Prediction

通过将时间消耗最大的词汇表归一化过程(Softmax)替换为高效的二进制预测(Binary Code Prediction)问题,可极大提高翻译模型的训练和解码速度以及内存消耗。

信息抽取主要是指从文本中自动抽取特定目标信息的技术。本次ACL大会有关信息抽取论文共计20多篇,涵盖实体识别、事件抽取、关系抽取、三元组抽取等多个具体任务,其中模型大部分还是以神经网络为主,但方法各有特点。我们从几个领域里分别选取了一篇代表性文章进行解读:

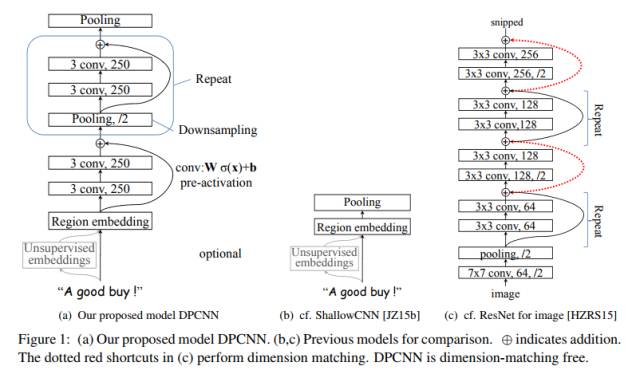

1、Deep Pyramid Convolutional Neural Networks for Text Categorization

该篇论文由腾讯AI Lab和RJ Research Consulting合作完成,主要介绍了一种轻量级的词级别深度卷积网络。该模型能有效捕捉文本的全局语义信息,并能在神经网络层数增加的前提下保证计算量不变。该模型在六个分本分类(主题分类和情感分类)的公开数据集中取得目前最优的结果。

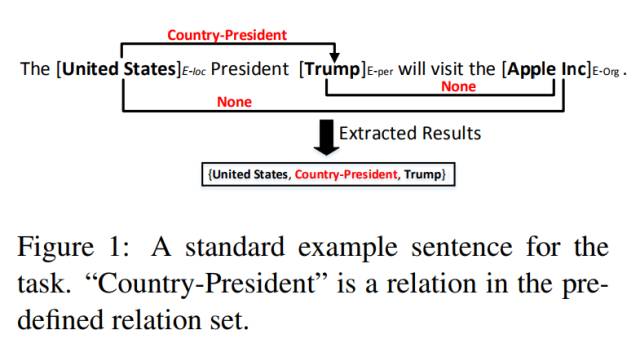

2、Joint Extraction of Entities and Relations Based on a Novel Tagging Scheme

该论文是腾讯AI Lab研究员在中科院自动化所读博期间发表的三元组抽取工作,入选ACL了2017 Outstanding Papers。该论文提出了一种新型的标记策略,通过设计特殊标签可有效关联词语与三元组之间的关系。因此,基于此标记策略,成功地把三元组抽取问题转换为序列标注问题,提出了一种端对端的序列标注模型用于三元组抽取。

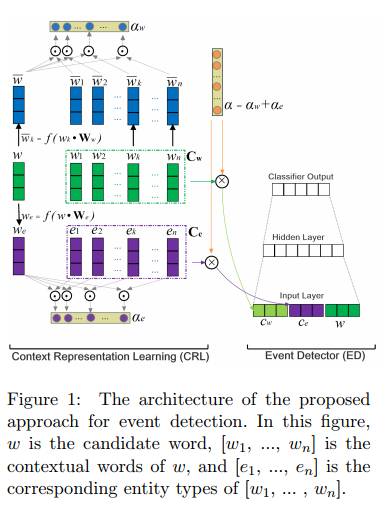

3、Exploiting Argument Information to Improve Event Detection via Supervised Attention Mechanisms

该论文是腾讯AI Lab研究员在中科院自动化所读博期间研究的事件抽取工作,提出了一种直接应用角色信息做事件识别的方法,基本思想是在事件识别过程中重点关注事件的角色词。作者为此提出了一个基于神经网络的事件识别模型,并通过有监督的关注机制实现上述目标。

4、A Local Detection Approach for Named Entity Recognition and Mention Detection

该论文针对命名实体识别任务提出了一种新颖的解决方式,并入选ACL 2017 Outstanding Papers。传统的命名实体识别方法是将该任务转换为一个序列标注的问题,本文不再从序列标注的角度出发,而是采用一种对输入文本中的文本片段分类的方式识别实体。该论文通过固定窗口的方式获得输入文本中的各片段,然后利用片段的上下文背景信息及片段本身信息对片段进行实体分类。该方法在几个公开的实体识别数据中获得了最优结果。此外,相比于序列标注的方式,该方法可以有效解决重叠实体的问题。

自然语言理解(Natural Language Processing,简称NLP)赋予计算机通过自然语言文本与外界交互的能力。NLP中心使命是追踪和研究最前沿的自然语言文本理解和生成技术,并孵化下一代自然语言处理技术与商业应用场景。目前团队有10位基础研究科学家,其中大多拥有国内外知名院校的博士学位,在学界或工业界科研经历丰富。同时在应用探索上,NLP中心与腾讯多个应用工程师团队及国内外高校及实验室紧密合作。

在前沿研究上,NLP中心正致力于打造一个文本理解引擎,实现基于语义分析、知识推理和统计机器学习相结合的深度文本理解。开放域人机对话是NLP领域目前最艰巨的任务之一,NLP中心正在打造一个开放域人机对话引擎(Open-Domain Conversation Engine),通过深度理解自然语言提升回复质量,并允许用户定制不同性别和语言风格的聊天机器人。研究人员结合深度学习技术和NLP研究热点,取得了诸多创造性的成果,研究成果被近期多个相关顶级会议和刊物录用,包括ACL会议论文3篇,EMNLP会议论文7篇,及TASLP期刊论文1篇。

在应用探索上,NLP中心特别注重研究与具体产品间的交互。其文本理解、文本生成、对话和翻译等技术应用到了公司诸多产品中,提升产品智能化以更好服务用户。研究人员还积极从产品实际需求中发现新的NLP问题,为学术界提供更丰富的研究课题和场景。

本届ACL腾讯AI Lab被收录的三篇论文包括:

论文一:Modeling Source Syntax for Neural Machine Translation

论文二:Chunk-Based Bi-Scale Decoder for Neural Machine Translation

论文三:Deep Pyramid Convolutional Neural Networks for Text Categorization

一分钟了解ACL 2017

ACL(国际计算机语言协会年会,Meeting of the Association for Computational Linguistics)是计算语言学里最重要的国际会议,今年是第55届,于7月30日到8月4日在加拿大温哥华举办。会议涵盖生物医学、认知建模与心理语言学、交互式对话系统、机器翻译等各个领域。

在评估会议的学术影响力指标上,本次会议均创新高 —— 论文有效提交数1318 篇,包括751 篇长文和 567 篇短文。录取数为 195 篇长文(18%)、104 篇短文(25%)与22 篇杰出论文( 1.6%)。而在新发布的2017谷歌学术指标中,ACL是计算机语言学和自然语言处理领域排名最高的国际学术年会。

整个会议期共 367 个报告,长文将展示 14 分钟,短文 12 分钟,密度为历届最高。并首次举办了关注女性研究群体的「WiNLP Workshop」,及可代为照顾儿童的「KiddleCorp」,方便已为人父母的研究者参会。

录取论文涉及领域占比最高的五类是:信息提取检索与问答、文档分析和自然语言处理应用(23.4%)、语义(12.1%)、机器翻译(8.2%)、机器学习(7%)、生成与总结(6.5%)。而投稿热度增长最快的领域为对话和交互系统(59.7%)、机器人视觉基础(41.9% )与机器学习( 34.4%)。

腾讯AI Lab主任张潼介绍到,「ACL早期利用语法和规则分析自然语言,90年代后,随着以LDC(Linguistic Data Consortium)为代表的自然语言数据集建立扩充,统计自然语言方法在计算语言学里作用越来越大并成为主流。2000年后随着互联网高速发展及以自然语言为核心的人机交互方式兴起,自然语言研究被赋予极高应用价值。」

腾讯AI Lab副主任俞栋认为,「自然语言的理解、表达、生成和转换一直是自然语言处理的核心问题。近年来有很多新的解决思路和方法。今年的ACL涉及自然语言处理的各方面,尤其在语义解析、语义角色标注、基于语义和语法的自然语言生成、机器翻译和问答系统方向上都有一些有趣的工作。」

点击阅读原文,查看腾讯 AI 实验室原文报道。

【号外】新智元正在进行新一轮招聘,飞往智能宇宙的最美飞船,还有N个座位

点击阅读原文可查看职位详情,期待你的加入~