AI超大事件丨从研究到应用,这是一份2017年AI领域的最全面总结

2017年已经结束了,还有什么比回顾这一整年中AI的发展历程更激动人心的吗?

AI大事件的作者Denny Britz梳理了2017整年的AI大事,人工智能从研究到应用领域的回顾,都在这篇AI超大事件里了。

强化学习在很多游戏上达到了超人表现

今年AI领域最成功的故事可能就是AlphaGo了(Nature论文),AlphaGo是一个强化学习代理,击败了世界上最好的国际象棋棋手。

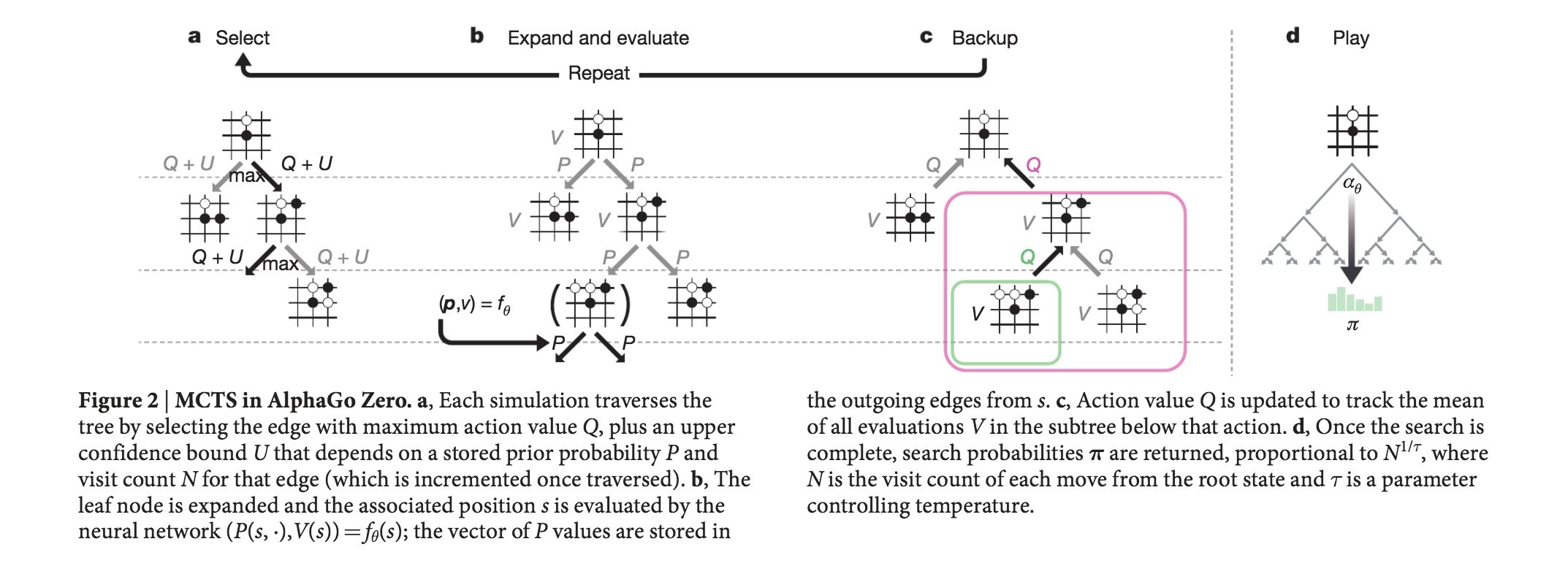

AlphaGo的第一个版本使用来自人类专家的训练数据进行引导,并通过自我对弈和蒙特卡洛树搜索进一步提升。不久之后,AlphaGo Zero(Nature论文)更进了一步,学习如何从头开始玩国际象棋,不需要任何人工训练数据,使用先前发表在 Thinking Fast and Slow with Deep Learning and Tree Search中的技术。它轻松击败了AlphaGo的第一个版本。

而在今年年底,我们又看到了AlphaGo Zero算法的另一个升级,称为AlphaZero,它不仅掌握了国际象棋,而且在将棋上也使用了相同的技术。有意思的是,人工智能代理的游戏策略使得很多经验丰富的人类玩家都大受启发,从而激励玩家从AlphaGo中学习并相应地调整自己的游戏风格。为了使这个学习过程更容易,DeepMind还发布了AlphaGo Teach工具。

但是AlphaGo并不是人工智能取得重大进展的唯一游戏。来自CMU的研究人员开发的Libratus(Science论文)在一场为期20天的无限德州扑克锦标赛中成功击败了顶级人类玩家。 稍早些时候,由查尔斯大学,捷克技术大学和艾伯塔大学的研究人员开发的DeepStack系统成为第一个击败专业扑克玩家的系统。 请注意,这两个系统针对的是双人扑克,比在多个玩家中游戏容易。后者很可能会在2018年取得进一步的进展。

强化学习的下一个领域是包括多人扑克在内的多人游戏。DeepMind正在积极研究“星际争霸2”,并在2017年发布了研究环境,而OpenAI已经在1v1 Dota 2上击败了顶级人类玩家,目标是在不久的将来于5v5游戏中全面击败人类玩家。

遗传算法东山再起

对于监督式学习,使用反向传播算法的基于梯度的方法对于研究者来说已经非常熟练了。但同时,在强化学习中,进化策略(ES)似乎正在东山再起。由于数据通常不是iid(独立且分布相同)的,因此错误信号更加稀疏,而且由于需要进行探索,所以不依赖于梯度的算法可以更好地工作。此外,遗传算法可以线性扩展到数千台机器,从而实现极快的并行训练,不需要昂贵的GPU。

今年早些时候,来自OpenAI的研究人员证明,遗传算法可以实现与标准的强化学习算法(如Deep Q-Learning)相媲美的性能。今年年底,Uber的一个团队发布了一篇博文和一组五篇研究论文,进一步展示了遗传算法的潜力。下面这个视频展示了使用各种算法玩Atari游戏的得分情况,GA策略得分为10500,而DQN,AC3和ES在这个游戏中得分低于1,000。

WaveNets,CNN和注意机制

谷歌的Tacotron 2文本转语音系统产生了极其精准的音频样本,这项技术基于WaveNet。这是一种自动回归模型,也被部署在谷歌助理中,并在过去一年中实现了大幅的速度提升。 WaveNet之前也被应用于机器翻译,从而减少了经常性架构的训练时间。

从机器学习子领域看,花费很长时间进行训练的经常性架构逐渐成为一种趋势。研究人员完全摆脱了复发和卷积,并使用更复杂的注意力机制,达到了在训练成本很低的情况下的最高水平。

深度学习框架的一年

如果我不得不用一句话总结2017年,那我会说是“框架的一年”。Facebook使用PyTorch做了一个大跃进。 由于其动态图形结构与Chainer提供的类似,PyTorch从自然语言处理的研究人员那里得到了更多的青睐,他们经常需要处理在Tensorflow等静态图形框架中很难声明的动态和循环结构。

Tensorflow在2017年已经相当成功.Tensorflow 1.0在2月份发布了一个稳定且向后兼容的API。 目前,Tensorflow的版本是1.4.1。 除主框架之外,还发布了多个Tensorflow伴随库,包括用于动态计算图的Tensorflow Fold,用于数据输入管道的Tensorflow Transform以及DeepMind的更高级别的Sonnet库。 Tensorflow团队还宣布了一个新的热切执行模式,其工作方式类似于PyTorch的动态计算图。

除Google和Facebook之外,还有许多其他公司也加入了机器学习框架的行列:

苹果公司发布了CoreML移动机器学习库。

Uber的一个团队发布了Pyro,一种深度概率编程语言(Deep Probabilistic Programming Language)。

亚马逊(Amazon)宣布在MXNet上提供更高级别的API,即Gluon。

Uber发布了其内部米开朗基罗机器学习基础设施平台的详细信息。

而且由于框架的数量逐渐泛滥,Facebook和微软发布了ONNX开放格式,以便跨框架共享深度学习模式。 例如,您可以在一个框架中训练您的模型,然后在另一个框架中投入生产。

除了通用的深度学习框架外,我们还看到大量的强化学习框架正在发布中,其中包括:

OpenAI Roboschool是一款用于机器人仿真的开源软件。

OpenAI Baselines是一套强化学习算法的高质量实现库。

Tensorflow代理包含优化的基础设施,使用Tensorflow来训练RL代理。

Unity ML Agents允许研究人员和开发人员使用Unity Editor创建游戏和模拟,并使用强化学习进行训练。

Nervana Coach允许使用最先进的强化学习算法进行实验。

Facebook的游戏研究ELF平台。

DeepMind Pycolab是一个可定制的网格世界游戏引擎。

Geek.ai MAgent是一个多代理强化学习的研究平台。

为了让深度学习更容易部署,我们也看到了一些Web的框架,比如谷歌的deeplearn.js和MIL webdnn执行框架。但至少有一个非常流行的框架在2017年结束了它的生命,那就是Theano,开发商决定Theano 1.0将成为Theano的最后一个版本。

学习资源

随着深度学习和强化学习越来越受欢迎,越来越多的讲座,训练营和活动已经在2017年在线录制和发布。以下是我最喜欢的一些:

由OpenAI和加州大学伯克利分校联合主办的Deep RL Bootcamp讲授了关于强化学习的基础知识以及最新研究成果。

斯坦福大学2017年春季版视觉识别卷积神经网络课程。可以查看课程网站。

斯坦福大学自然语言处理与深度学习课程2017年冬季版。 可以查看课程网站。

斯坦福的深度学习理论课程。

新的Coursera深度学习专业。

蒙特利尔的深度学习和暑期加强学校。

加州大学伯克利分校2017年秋季深度强化学习课程。

几个学术会议延续了在网上发布会议的新传统。 如果您想赶上尖端的研究,您可以观看NIPS 2017,ICLR 2017或EMNLP 2017的一些录像。

研究人员也开始在arXiv上发布教程和调查论文。 这是2017年中我的最爱:

Deep Reinforcement Learning: An Overview

A Brief Introduction to Machine Learning for Engineers

Neural Machine Translation

Neural Machine Translation and Sequence-to-sequence Models: A Tutorial

AI应用之“艺术”

2017年开始获得更多关注的应用是图像,音乐,草图和视频的生成性建模。 NIPS 2017年会议首次推出了机器学习创意与设计研讨会。

最流行的应用程序之一是谷歌的QuickDraw,它使用神经网络来识别你的涂鸦。 使用开源的数据集,您甚至可以教机器为您完成您的绘图。

GANs今年取得了重大进展。 例如,CycleGAN,DiscoGAN和StarGAN等新模型在生成人脸方面取得了令人印象深刻的成果。 GANs在过去难以生成逼真的高分辨率图像,但pix2pixHD的结果表明,研究者们正在解决这些问题。 GANs会成为人类的新画笔吗?让我们在2018年拭目以待。

AI应用之“自动驾驶”

自驾车领域的大玩家是Uber和Lyft,Alphabet的Waymo和Tesla。 由于软件错误,Uber在旧金山错过了几盏红灯。之后,Uber分享了内部使用的汽车可视化平台的细节。Uber的自驾车计划在12月份达到了200万英里。

与此同时,Waymo的自驾车在四月份成为了第一批真正的AI车手,后来在亚利桑那州的凤凰城完全取消了操作人员。 Waymo还公布了他们的测试和模拟技术的细节。

那些酷酷的研究项目

2017年发布了许多有趣的项目,在这里不可能一一列举。 只能对那些脱颖而出的稍作介绍:

Creating Anime characters with Deep Learning

Colorizing B&W Photos with Neural Networks

Mario Kart (SNES) played by a neural network

A Real-time Mario Kart 64 AI

Spotting Forgeries using Deep Learning

Edges to Cats

更偏向研究的项目:

The Unsupervised Sentiment Neuron – 一个学习情绪的优秀系统,尽管只是被用来预测亚马逊评论文本中的下一个字符。

Learning to Communicate – 开发自己语言的人工智能代理。

The Case for Learning Index Structures – 使用神经网络优化高速缓存的B-树,速度高达70%,同时通过多个实际数据集在内存中节省数量级。

Attention is All You Need

Mask R-CNN – 对象实例分割的一般框架

Deep Image Prior for denoising, superresolution, and inpainting

数据集

用于监督学习的神经网络以数据饥饿而闻名。 所以开源数据集对研究界来说是一个非常重要的贡献。 以下是今年出现的几个数据集:

Youtube Bounding Boxes

Google QuickDraw Data

DeepMind Open Source Datasets

Google Speech Commands Dataset

Atomic Visual Actions

Several updates to the Open Images data set

Nsynth dataset of annotated musical notes

Quora Question Pairs

深度学习的挑战:可重复性和炼金术

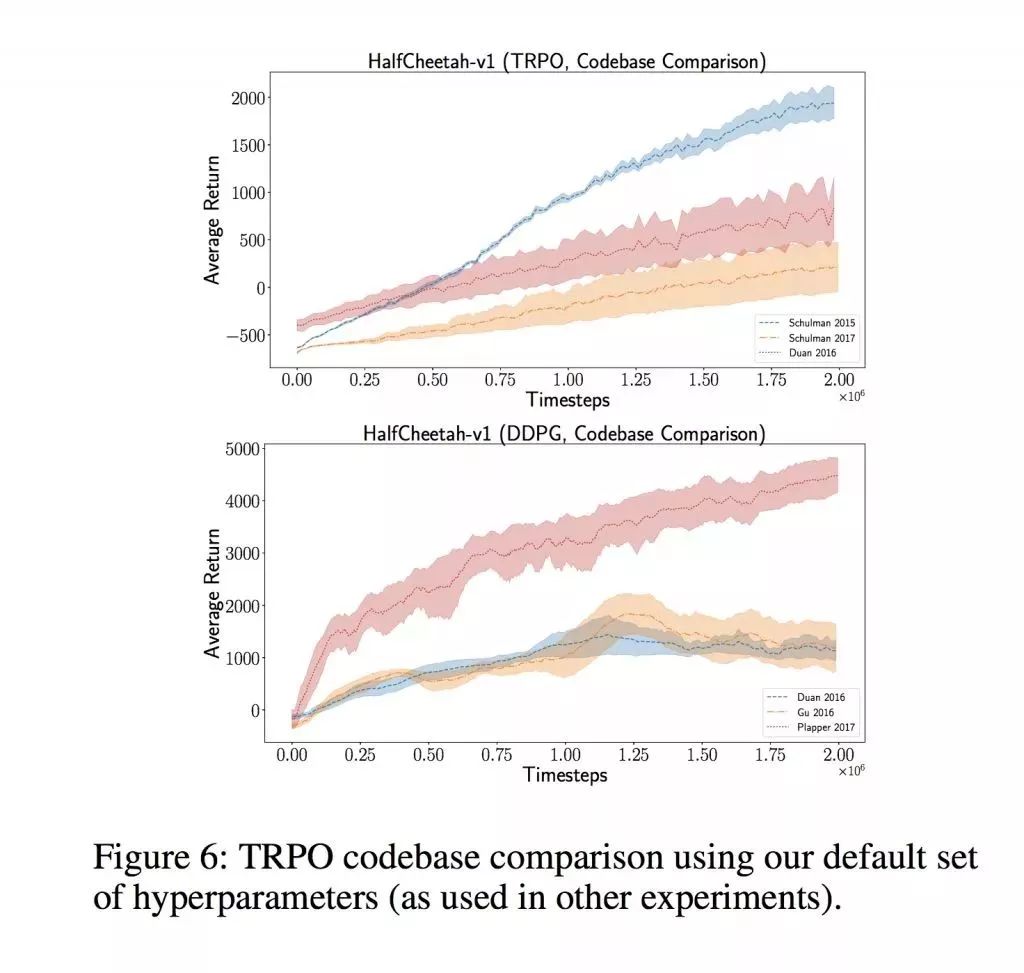

在2017年,一些研究人员对学术论文结果的可重复性提出了担忧。深度学习模型通常需要大量的超参数,必须对其进行优化才能获得足够好的结果。这种优化通常非常昂贵,昂贵到只有像Google和Facebook这样的公司才能负担得起。研究人员并不总是发布他们的代码,并且出于各种原因忘记把重要的细节放到完成的论文中,这使得可重复性成为一个很大的问题。在Reinforcement Learning That Matters这篇文章中,研究人员表明,使用相同的算法和不同的基础代码使得结果出现了很大的不同和很高的方差:

在Are GANs Created Equal? A Large-Scale Study这篇文章中,研究者表明,使用昂贵的超参数搜索进行调整的GAN可以击败更为复杂的方法。同样,在 On the State of the Art of Evaluation in Neural Language Models中,研究人员表明,简单的LSTM架构,如果适当规范化和调整,可以胜过更多的近期模型。

在许多研究人员的共同努力下,阿里·拉希米(Ali Rahimi)将最近的深度学习方法与炼金术进行了比较,并呼吁进行更严格的实验设计。然而Yann LeCun将他的讲话视作对深度学习的侮辱,并在第二天进行了反驳。

中国和加拿大的人工智能发展

随着美国移民政策收紧,越来越多的公司开始在海外开设办事处,加拿大成为主要目的地。 Google在多伦多开设了一个新的办公室,DeepMind在加拿大埃德蒙顿开设了一个新办公室,Facebook AI Research也扩展到了蒙特利尔。

中国是另一个倍受关注的目的地。 由于拥有大量的资金,大量的人才库和政府数据,在人工智能的发展和生产部署方面,它正在与美国竞争。Google日前宣布即将在北京开设一个新实验室。

硬件大战:Nvidia, Intel, Google, Tesla

现代深度学习技术要求昂贵的GPU来训练最先进的模型。 到目前为止,NVIDIA一直是最大的赢家。今年,它发布了Titan V旗舰GPU。但是竞争无处不在, Google的TPU现在可以在其云平台上使用,英特尔的Nervana推出了一套新的芯片,甚至特斯拉也公开表示它正在开发自己的AI硬件。竞争也可能来自中国,专门从事比特币挖掘的硬件制造商希望进入以人工智能为核心的GPU领域。

炒作和失败

对于人工智能的炒作在2017年达到了新的巅峰,主流媒体的报道与研究实验室或生产系统实际发生的事情几乎从不相符。IBM Watson成为了过度营销的传奇,但它却从未提供相应的、令人满意的成果。今年,每个人都开始讨厌Watson,这在它于医疗方面一再失败之后也并不奇怪。

今年获得最多炒作的故事可能是Facebook的“研究人员关闭发明自己语言的AI”,其实这件事情的本质仅仅是研究人员停止了一个结果不太好的标准实验而已。

然而更值得注意的是,不仅仅媒体应当因为炒作被钉在历史的耻辱柱上。研究人员也在论文的标题和摘要中大吹特吹,这些标题和摘要不能反映实际的实验结果,比如 natural language generation paper和 Machine Learning for markets.

高调招聘和离职

Coursera的联合创始人Andrew Ng(他的机器学习MOOC可能是最著名的),在今年多次被报道。 Andrew在三月份离开百度领导的AI集团,筹集了1.5亿美元的基金,并成立了一个专注于制造业的新公司landing.ai。 在其他消息中,Gary Marcus辞去了Uber人工智能实验室主任的职务,Facebook聘请了Siri的自然语言理解部门负责人,几位著名的研究人员离开了OpenAI,开创了一家新的机器人公司。

学术界的科学家不断流失到业界的趋势也在继续,大学实验室抱怨说,他们无法与行业巨头提供的薪水竞争。

初创企业投资和收购

就像去年一样,AI创业的生态系统正在蓬勃发展,并进行了几次高调的收购:

Microsoft收购了深度学习创业公司MAluuba

谷歌宣布收购全球最大数据科学社区KaggleGoogle Cloud收购Kaggle

Softbank收购机器人制造商Boston Dynamics(以不太使用机器学习而闻名)

Facebook收购AI助理公司Ozlo

Samsung收购Fluently来建设Bixby

很多创业公司也拿到了巨额风投:

Mythic筹集了880万美元,意图将AI集成到芯片上

Element AI,为公司建立人工智能解决方案的平台,筹集了1.02亿美元

Drive.ai筹集了5000万美元,并将Andrew Ng加入董事会

Graphcore筹集了3000万美元

Appier发布了3300万美元的C系列

Prowler.io筹集了1300万美元

Sophia Genetics筹集了3000万美元帮助医生使用AI和基因组数据进行诊断

最后,祝大家新年快乐!感谢大家对AI大事件系列的关注和支持!

志愿者介绍

回复“志愿者”加入我们

往期精彩文章

点击图片阅读