自然语言处理顶会ACL2020放榜了,你的论文中了吗?因新冠将在线举办

【导读】自然语言处理领域顶级会议ACL2020,昨天ACL组委会发布了接受论文通知,你的论文中了吗?众多作者也纷纷发布自己中的论文。国内哈工大SCIR实验室中了8篇。在这里小编整理16篇ACL2020论文抢先看!值得注意的是,由于全球新冠肺炎疫情暴发,将改为在线举办。

今年ACL投稿论文达到3000+篇,ACL 2020的审稿周期从19年的12月9日一直到20年的4月3日接近4个月时间,评审细致,竞争激烈!

The 58th Annual Meeting of the Association for Computational Linguistics (ACL 2020) 将于2020年7月5日至10日在美国华盛顿州西雅图举行。ACL年会是计算语言学和自然语言处理领域最重要的顶级国际会议,CCF A类会议,由计算语言学协会主办,每年举办一次。其接收的论文覆盖了对话交互系统、语义分析、摘要生成、信息抽取、问答系统、文本挖掘、机器翻译、语篇语用学、情感分析和意见挖掘、社会计算等自然语言处理领域众多研究方向。该会议的论文基本代表自然语言处理领域最新研究进展和最高研究水平,受到学术界和产业界的高度关注。

值得一提的是,为了应对新冠肺炎的影响,大会主席Dan Jurafsky发信确认,ACL2020将在线举办。

ACL 2020 论文抢鲜看!

哈工大SCIR八篇长文被ACL 2020录用(授权转载来自哈工大社会计算与信息检索研究中心公众号,哈工大SCIR)

https://mp.weixin.qq.com/s/sFUO02l-RfF7OsAMAoi_lQ

题目:Conversational Graph Grounded Policy Learning for Open-Domain Conversation Generation

作者:徐俊,王海峰,牛正雨,吴华,车万翔,刘挺

摘要:我们提出用图的形式捕捉对话转移规律作为先验信息,用于辅助开放域多轮对话策略学习。基于图,我们设计策略学习模型指导更加连贯和可控的多轮对话生成。

题目:Document Modeling with Graph Attention Networks for Multi-grained Machine Reading Comprehension

作者:郑博,文灏洋,梁耀波,段楠,车万翔,Daxin Jiang,周明,刘挺

摘要:我们提出了一种新的多粒度机器阅读理解框架,按照文档的层次结构以四个粒度进行建模,分别是文档级、段落级、句子级以及词级别。我们利用图注意力网络(Graph Attention Networks)获取不同级别的表示并使得它们可以被同时学习。长短答案可以分别从段落级以及词级别表示中提取,通过这种方式,我们可以建模两种粒度答案之间的关系,使它们互相提供信息。

题目:Dynamic Fusion Network for Multi-Domain End-to-end Task-Oriented Dialog

作者:覃立波,徐啸,车万翔,张岳,刘挺

摘要:我们首次在端到端任务型对话系统中提出一个shared-private 框架去显式学习领域特有的和领域共享的知识。此外,我们提出了一种新颖的动态融合网络(DF-Net)来动态探索目标领域与每个领域之间的相关性。

题目:Few-shot Slot Tagging with Collapsed Dependency Transfer and Label-enhanced Task-adaptive Projection Network

作者:侯宇泰,车万翔,赖勇魁,周之涵,刘一佳,刘晗,刘挺

摘要:在本文中,我们研究了少样本槽位提取问题(Few-shot Slot-Tagging)。与其他广泛研究的少样本问题相比,少样本槽位提取面临着“建模标签间依赖关系”的独特挑战。

题目:Generate, Delete and Rewrite: A Three-Stage Framework for Improving Persona Consistency of Dialogue Generation

作者:宋皓宇,王琰,张伟男,刘晓江,刘挺

摘要:在这项工作中,我们提出了一个三阶段的对话生成框架。该框架使用生成-删除-重写机制从生成的原型回复中删除不一致的词语,然后进一步将其改写为属性信息一致的回复。我们通过人工评价和自动指标进行了评估。在PersonaChat数据集上的实验表明,我们的方法获得了非常好的性能。

题目:Towards Conversational Recommendation over Multi-Type Dialogs

作者:柳泽明,王海峰,牛正雨,吴华,车万翔,刘挺

摘要:我们提出一个新的任务——多类型对话中的对话式推荐,期望Bot能够主动且自然地将对话从非推荐对话(比如『问答』)引导到推荐对话,然后基于收集到的用户兴趣及用户实时反馈通过多次交互完成最终的推荐目标。

更多ACL论文列表:

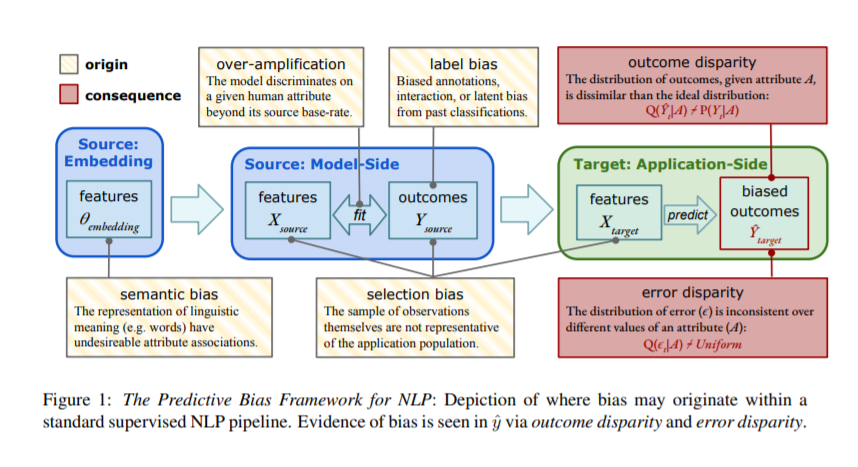

1.自然语言处理模型里的偏见 Predictive Biases in Natural Language Processing Models: A Conceptual Framework and Overview

https://arxiv.org/abs/1912.11078

2. 无监督域聚类Unsupervised Domain Clusters in Pretrained Language Models

3. 逻辑自然语言生成,LogicNLG: Logical Natural Language Generation from Open-Domain Tables

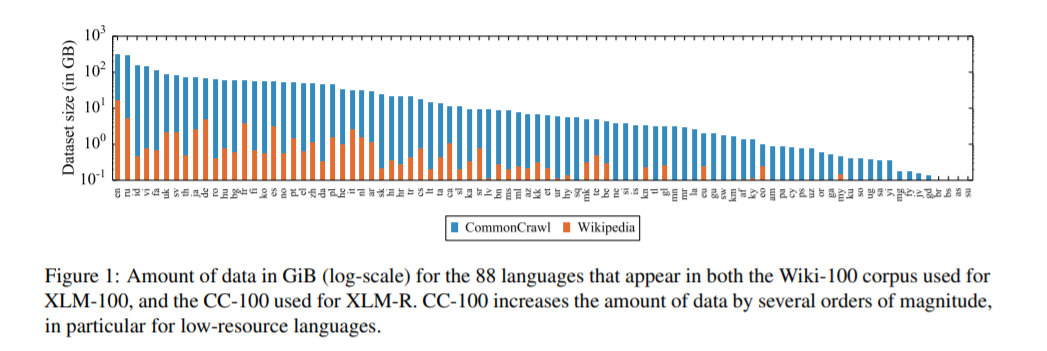

4. 无监督跨语言表示学习,Unsupervised Cross-lingual Representation Learning at Scale

https://arxiv.org/pdf/1911.02116.pdf

5. 语言和视觉推理的跨模态关联 Cross-Modality Relevance for Reasoning on Language and Vision

https://hlr.github.io/

6. 利用合成数据进行零样本迁移学习,实现多域对话状态跟踪,Zero-Shot Transfer Learning with Synthesized Data for Multi-Domain Dialogue State Tracking

https://almond-static.stanford.edu/papers/multiwoz-acl2020.pdf

7. 多阶段蒸馏框架用于大规模多语言NER,Multi-Stage Distillation Framework for Massive Multi-lingual NER

https://www.microsoft.com/en-us/research/uploads/prod/2020/04/TinyMBERT_Multi_lingual_NER_Distillation.pdf

8. 注意力可解释性 Learning to Deceive with Attention-Based Explanations

https://arxiv.org/pdf/1909.07913.pdf

更多ACL2020论文传送门:

1. 如何看待ACL 2020录用结果?- 知乎

https://www.zhihu.com/question/384287944

2. https://twitter.com/hashtag/acl2020nlp?src=hashtag_click

https://twitter.com/hashtag/ACL2020?src=hashtag_click

专知便捷查看

便捷下载,请关注专知公众号(点击上方蓝色专知关注)

后台回复“ACL20” 就可以获取《18篇以及更多ACL2020论文》论文专知下载链接