学界 | 向频域方向演进的卷积网络:OctConv用更低计算力做到更高准确率

AI 科技评论按:近几天,一篇改进卷积网络的论文引发了不小的关注和讨论。简单来说,这篇论文对传统的卷积操作做了简单的通用改进,就同时获得了更低的计算能力消耗和更高的准确率。知名机器学习研究员、「GANs 之父」Ian Goodfellow 就在推特上公开称赞了这篇论文。

这篇论文的一作是陈云鹏,目前在新加坡国立大学(NUS)读最后一年博士生,他的导师是冯佳时助理教授和颜水成副教授。此前,陈云鹏在华中科技大学获得学士学位,并曾在香港大学做助理研究员、在 Facebook 机器学习应用部门(Facebook AML) 做实习研究员。从新加坡国立大学毕业之后,陈云鹏将于今年正式加入 Facebook,成为一名研究科学家。

下面雷锋网 AI 科技评论简单介绍一下论文的主要内容。

(降低一个八度:通过 Octave Convoluation 减少卷积神经网络中的空间冗余度)

卷积神经网络(CNN)在许多计算机视觉任务中都取得了前所未有的成功,并且随着近期研究中对于密集的模型参数以及 feature map 通道维度的固有冗余性的改进,CNN 的效率也在不断提高。不过,CNN 生成的 feature map 中仍然存在着显著的空间冗余度,具体来说,feature map 中的每个位置都只独立存储自己的特征描述器,但相邻的位置其实也会存储一些相同信息;这些信息可以共同存储并处理。

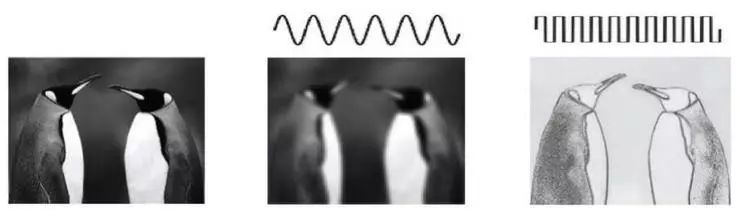

图 1 - (a) 研究出发点:通过视觉的空间频域模型可以把自然图像分解为低频部分和高频部分

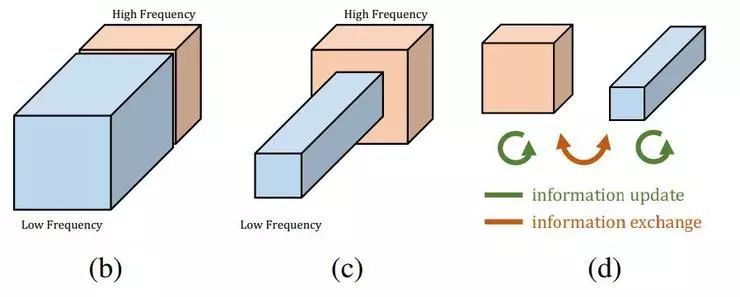

图 1 - (b) 卷积层输出的特征图也可以被分解并根据不同的空间频率重新分组。(c) 论文中提出的多频率特征表征会在低分辨率张量中存储平滑变化的低频特征图,这样就降低了空间冗余度。(d) 论文中提出的 Octave Convoluation 直接在这种表征上进行运算,它会更新每一组中的信息,并更进一步地允许不同组之间交换信息。

如上方图 1 - (a) 所示,一张自然图像可以被分解为低空间频率部分和高空间频率部分,前者描述了平滑变化的结构,后者描述了快速变化的图像细节。与之类似,论文作者们提出卷积层的特征图输出也可以被分解为具有不同空间频率的部分,并提出了一个新的多频率特征表征,它在不同的组中分别存储高频和低频的特征图,如图 1 - (b) 所示。这样,低频组的空间分辨率就可以安全地降低,通过在相邻的位置之间共享信息的方式降低空间冗余度,如图 1 - (c) 所示。为了与这种新的特征表示方法相容,作者们从原始的卷积操作进行了泛化,提出了 Octave Convolution (OctConv),它的输入是含有高低不同频率张量的特征图,然后直接从低频的特征图中提取信息,不需要把它解码回高频,如图 1 - (d) 所示。

作为原始的卷积操作的替代方案,OctConv 消耗的存储和计算资源明显更小。同时,OctConv 处理低频信息时使用的是对应的低频卷积,这种做法显著增大了原像素空间中的感知域大小,所以还能提升识别性能。

作者们把 OctConv 设计为了一种通用的方法,它可以作为现有卷积网络中卷积操作的直接替换。由于 OctConv 的重点在于在不同空间频率上处理特征图并降低空间冗余度,它就形成了对现有的各种改进 CNN 网络方案的另一个方向的补充;现有的方法包含更好的拓扑结构、降低卷积特征图中的通道冗余度、降低密集模型参数冗余度等等。

作者们还进一步讨论了如何把 OctConv 集成在分组、深度优先、以及三维卷积用例中。此外,与尝试利用多尺度信息的方法不同,OctConv 可以轻松地替换原本的卷积操作,不需要更改网络结构或者超参数调节。

论文中的实验表明,只需要简单地把原本的卷积替换为 OctConv ,就可以稳定提高各种热门二维 CNN 主干网络的表现,包括 ResNet、ResNeXt、DenseNet、MobileNet、Se-Net 在 ImageNet 上的二维图像识别,以及 C2D、I3D 在 Kinetics 数据集上的三维视频动作识别。换装了 OctConv 后的 ResNet-152 可以达到目前最先进的手工设计网络的表现,同时消耗的存储和计算却要小很多。

论文原文:https://arxiv.org/abs/1904.05049,相关代码近期会在 GitHub 上开源。雷锋网 AI 科技评论编译