滑铁卢大学2020新书《预训练Transformer模型文本排序》,155页pdf

摘要

文本排序的目标是生成一个有序的文本列表,这些文本从语料库中检索,以响应针对特定任务的查询。最常见的文本排序是搜索,搜索引擎(也称为检索系统)根据用户查询的估计相关性生成一个文本排序列表(网页、科学论文、新闻文章、tweet等)。在这种情况下,相关文本是那些“关于”用户请求的主题并满足用户信息需求的文本。信息检索(IR)的研究人员称之为临时检索问题。

使用关键字搜索,也称为关键字查询(例如,在web上),用户通常在搜索框(例如,在浏览器中)中键入一些查询词,然后返回包含排序文本表示的结果。这些结果被称为排名列表,点击列表,点击量,排序文本的表示通常包括标题、相关元数据、文本本身的摘要(例如,突出显示用户查询词的keyword -context摘要),以及到原始数据源的链接。虽然有很多关于文本排序问题的例子(参见1.1节),但是这种特殊的场景是普遍存在的,而且无疑是所有读者都熟悉的。

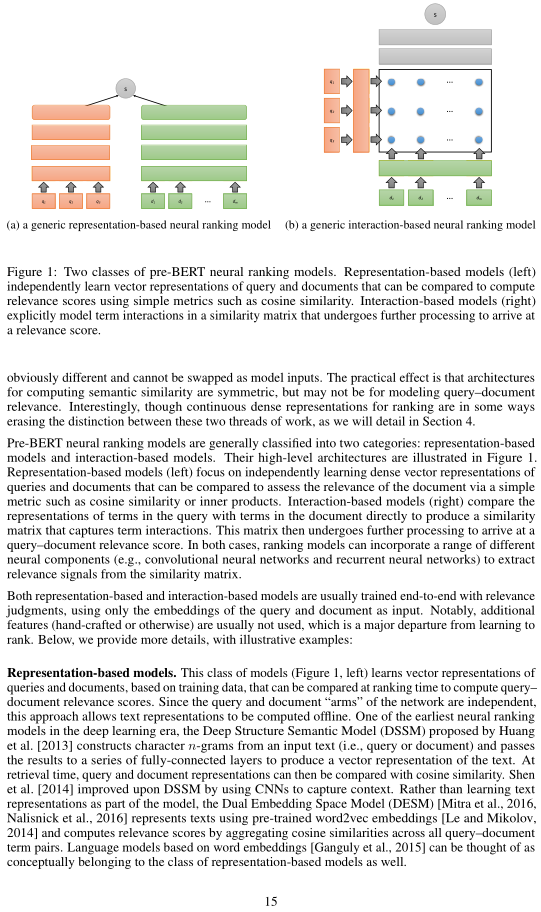

该综述提供了一种称为Transformer的神经网络结构的文本排序的概述,其中最著名的例子是谷歌的发明,即BERT(来自Transformers的双向编码器表示)[Devlin et al., 2019]。毫无夸张地说,BERT已经彻底改变了自然语言处理(NLP)和信息检索(IR)以及更广泛的人类语言技术(HLT)等领域,这是一个包罗万象的术语,包括处理、分析和使用(人类)语言数据的技术。在文本排序方面,BERT提供的结果在质量上无疑比之前的结果更好。

https://www.zhuanzhi.ai/paper/fe2037d3186f4dd1fe3c3ea1fb69f79e

目录

部分内容概览

专知便捷查看

便捷下载,请关注专知公众号(点击上方蓝色专知关注)

后台回复“PTTR2020” 可以获取《【2020新书】预训练Transformer模型的文本排序》专知下载链接索引