编辑:好困

【新智元导读】强化学习在围棋及游戏领域的成功,使其成为机器学习和人工智能最受关注的领域之一,吸引Google、Deepmind、OpenAI等众多科技界头部公司争相角逐,更是被Deepmind认定为通向「通用人工智能」的关键技术。

虽然强化学习已经在游戏世界中展现出超越顶尖人类的自主行动和自主决策的能力,但要让强化学习走出游戏世界,落实到真实业务场景中,仍然任重而道远。

凭借在强化学习领域的深厚积累,南栖仙策不仅取得突破性的研究成果,发展了独特的环境模型学习技术,更是打通算法、工程、实施、服务的落地实践闭环,在强化学习落地的荆棘丛中率先开辟出一条道路。

南栖仙策将强化学习落地技术与经验凝聚在核心工具「仙启」中,并于近日发布了这一「智能决策工业软件」的正式版本。

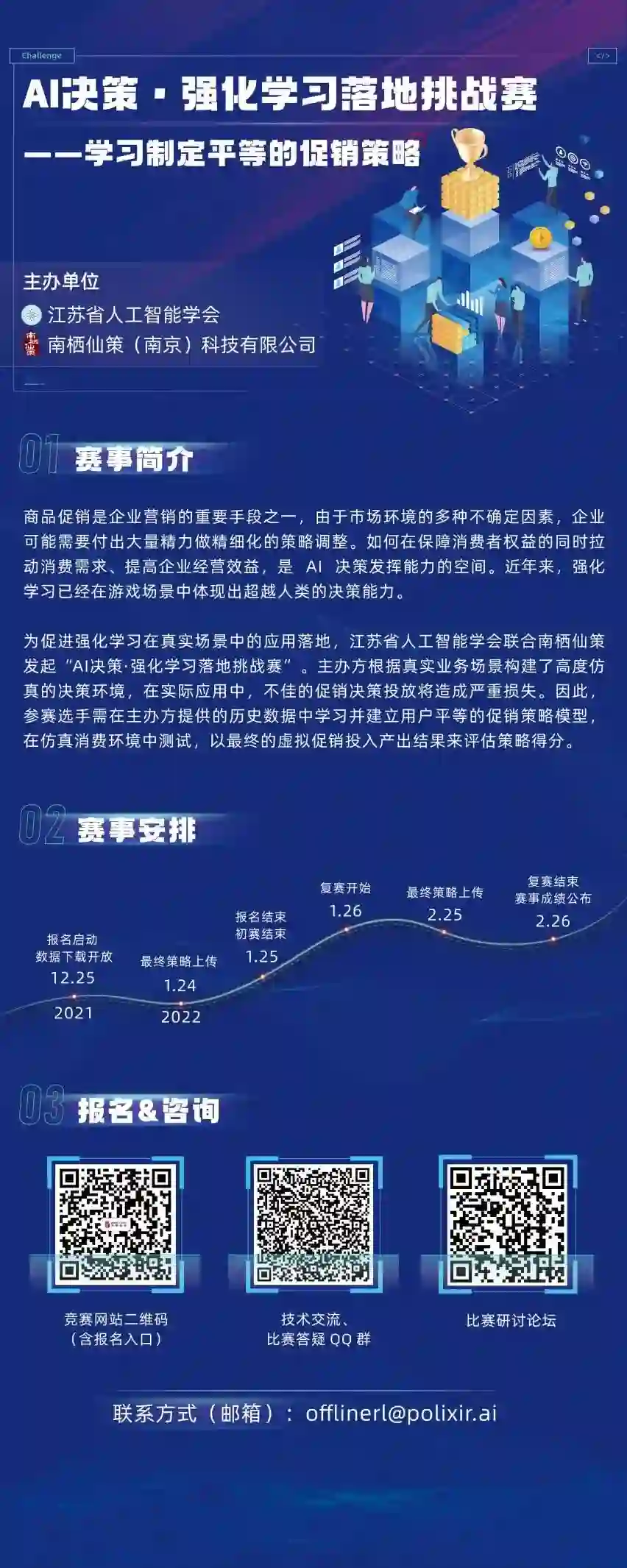

与此同时,为了更好的推动全球强化学习技术的发展以及相关领域技术人才的培养,南栖仙策联合江苏省人工智能学会共同发起「AI决策•强化学习落地挑战赛」。

挑战赛将于12月25日开启报名通道,欢迎业界精英在比赛中大显身手,充分展现AI决策技术的先进实力!

2016年3月9日,Deepmind开发的围棋AI系统AlphaGo在与围棋世界冠军李世乭的对弈中拿下第一局。五日后,AlphaGo以4:1战胜李世乭,这也是AI首次在围棋上战胜人类顶尖职业棋手。

这场胜利是人工智能发展道路上的一个重要里程碑。

全球人工智能发展随之进入新一轮的上升期,同时,一个陌生的技术名词「强化学习」也开始受到广泛关注。

其实,强化学习并不是一个新生事物,其代表性技术「时序差分」方法诞生在1984年,距今已有37个年头。

在AlphaGo创造历史前的30多年里,强化学习相比人工智能其他领域的技术应用更不为大众所知。强化学习的低调并非故意为之,其实是有着内在的原因。

「强化学习」与「监督学习」并列,是机器学习的主要子领域。监督学习的目标是解决预测问题,从打上标记的数据中学习,例如,语音文字识别、人脸识别等就是这一类技术;而强化学习解决的是决策问题,就像自然界中的生物,需要在环境中摸索、试错,根据环境的反馈,改变自己的生活习性,从而更好地「生存」下去。

强化学习自主试错学习的方式,减少了对人力的依赖,也因此被Deepmind认为是通向「通用人工智能」的关键技术。

在游戏规则完全清晰的虚拟环境中,借助强大的算力,可以取得现实世界一天、游戏世界数十年的加速效果,于是强化学习在短时间内通过海量试错学习,可获得超越人类的决策能力。

以AlphaGo为例,它在围棋环境中通过强化学习在短短数月内自我对弈了超过三千万局,倘若以业余棋手平均一小时一局计算,人类习得这样的决策能力至少需要4000年!

可以想象,对于实际业务问题,如果人们也能刻画出清晰完整的游戏规则,那么强化学习就可以轻松找出最优业务决策,成为人们有力的帮手,解放人类在细碎决策上的繁琐劳动,转而在顶层设计上充分发挥人类的优势——想象力与创造力。

但事实上,我们面对的大多数实际问题都缺乏清晰完整的规则,并非理想的「游戏环境」。更残酷的是,如果让强化学习在现实世界中训练试错,会给人们带来巨大的代价,乃至发生生命危险!

因此,离开了虚拟的游戏世界,强化学习显得不再智能,不仅学习速度极慢,而且还会因为在学习过程中会尝试大量的错误行为造成不可挽回的损失。

在AlphaGo的光环下,今天的强化学习已成为人工智能领域的高光方向。然而学术界的进展与业界的期望尚不匹配。

如

果说今天有一项算法创新可以将强化学习所需的数亿次探索交互降低两个数量级,这在学术界一定是重磅新闻。

然而,数百万次的探索在产业界仍然距离广泛应用遥遥无期。

回到2016年5月,在AlphaGo战胜李世乭后的两个月,南京大学LAMDA组的俞扬教授收到了来自阿里巴巴负责「淘宝搜索」团队的业务咨询:将强化学习应用到搜索排序任务上时,是否可以只从离线数据中学习?

显然,在尝试应用强化学习技术时,该技术团队遇到了缺乏「游戏环境」的挑战,在淘宝搜索排序任务上,没有明确的规则可以描述用户的行为,因此难以构造强化学习训练的「游戏环境」。

如果可以从离线数据中还原出「游戏环境」,强化学习便可发挥优势,那就能解决问题了。

2017年4月,俞扬教授提交了「虚拟淘宝」合作项目申请,试图从历史数据中学习出一个有虚拟用户的环境,有了这个环境,便可以实现「零成本」训练强化学习。

项目申请提交后,很快

收到了评审专家的质疑,「simulating the environment of e-commerce is unbelievably challenging」,这封电子邮件至今仍保留在俞扬教授的收件箱中。

「质疑十分合理,实际上当时并没有任何技术能够把环境学好。」俞扬教授说。即使在今天国际强化学习学术领域的主流认知中,环境模型仍然被认为是极其困难的,基于这样的认知,主流技术的发展方向是不使用或少使用环境模型。

「但是环境的学习极其关键。」虽然受到质疑,俞扬教授没有放弃这一方向的技术研究。

实际上,在南京大学LAMDA实验室里,周志华教授早已指出适应开放动态环境是机器学习未来的重要方向,并于2014年受到国家自然科学基金重点项目的支持,相关成果在2016年国际人工智能会议AAAI主席报告中被作为通向未来稳健人工智能的代表性工作之一。

因此,学习环境模型在俞扬教授看来是必经之路,但是如何才能把环境学习好,这个问题一直萦绕在他脑海中。

2018年1月,经过各种尝试和努力后,一种初步的技术方案在淘宝场景的测试中第一次看到了有效的结果。这一结果,终于让俞扬教授有了一些信心。

但更多的疑问也

随之出现,「这样的技术是否有通用性?

是否能得到数学理论的支撑?

是否在其它问题上也有效,有效的范围是什么?

」带着这些问题,俞扬教授和他的学生一起,通过与更多的企业合作,在多种不同场景

中验证了技术方案的有效性,同时技术

方案也在不断升级完善。

在

2020

年人工智能国际顶级会议NeurIPS上,俞扬教授团队发表了该技术在环境学习上的最新理论成果,从理论上严格证明了该技术的可行性,也为环境学习技术打了一剂强心针。

「现在回过头来看,很庆幸当时坚持要做环境的学习。」环境模型不仅可以实现「零成本」训练强化学习,更有不少其他技术途径难以替代的优势,例如可预估决策的效果、灵活调整决策目标、施加整体约束,等等。

在实际场景验证的过程中发现,环境模型学习技术的应用门槛很高,从业务理解到技术应用都与以往有较大的差异。「技术如果不能转变为生产力、不能造福社会,仅仅停留在论文纸面上,那就太可惜了。」

2019年6月,在南京大学人工智能创新研究院与投资人的共同支持下,俞扬教授和秦熔均师徒二人开始组建南栖仙策团队,推动技术的深度应用和普及。南栖仙策一边将环境学习技术应用在更多的场景中,一边带回场景落地的经验和挑战,不断完善技术。

经过不断的迭代,南栖仙策将核心技术与应用经验沉淀,打造基于环境学习的通用智能决策工具「仙启」。2021年12月24日,南栖仙策「仙启」正式版面世了。

在发布「仙启」正式版之前,南栖仙策其实已经发布了多个开源算法库。秦熔均介绍道,这包括:离线强化学习算法库(https://agit.ai/Polixir/OfflineRL)、离线强化学习数据集(https://agit.ai/Polixir/OfflineData)、离线策略评估算法库(https://agit.ai/Polixir/d3pe)、以及无梯度优化算法库(https://agit.ai/Polixir/ZOOpt)等,「仙启」则是以这些开源库为基石。

「仙启」(https://revive.cn)是一个SaaS化平台系统,同时也提供SDK软件。对于熟悉强化学习的开发者,「仙启」SDK提供了最为灵活的使用方式。「仙启」SaaS系统则提供了数据接入、决策流图设计、环境学习、策略训练、模型部署一条链路的服务,还特别关注团队协作,方便开发人员信息共享。

通过与数十家各类行业领域的公司合作打磨,「仙启」已经实现了在能源、制造、物流、营销跨行业多业务场景的应用,获得产业和企业侧的高度认可。

尽管这些行业的业务流程纷繁复杂,行业与行业之间又有着巨大的差异,仙启每一次都可以做到切中要害稳健落地,甚至时常打破企业的认知,带来出乎意料的好效果,「企业常常会说『真没想到原来每个场景上都还可以继续做决策优化,仙启让我们又看到了新的机会』」秦熔均介绍道。

更难得的是,「仙启」为工业业务场景提供辅助决策工具,与业务实际决策环进行解耦,可由企业根据自身情况灵活部署。同时,「仙启」直接基于业务场景的历史数据进行学习,不借助其他商业软件,部署周期短,也为企业带来了极低的使用门槛。

对于有兴趣了解「仙启」的开发者,南栖仙策与江苏省人工智能学会联合举办的强化学习落地挑战赛放出了一道营销运营类业务的赛题,其中的基线方法就是通过对「仙启」的简单调用得到,同时赛方也提供了基线方法的源代码,为参赛选手提供一个起点。

「AI决策•强化学习落地挑战赛」与「仙启」同步发布。

挑战赛由南栖仙策联合江苏省人工智能学会共同发起,旨在促进强化学习在真实场景的应用。欢迎有兴趣的小伙伴都来参与!

可以扫描海报二维码报名和咨询,或点击

「阅读原文」

查看详细赛事信息哦。