两项第一!微信Embedding联合团队征战OGB斩获佳绩

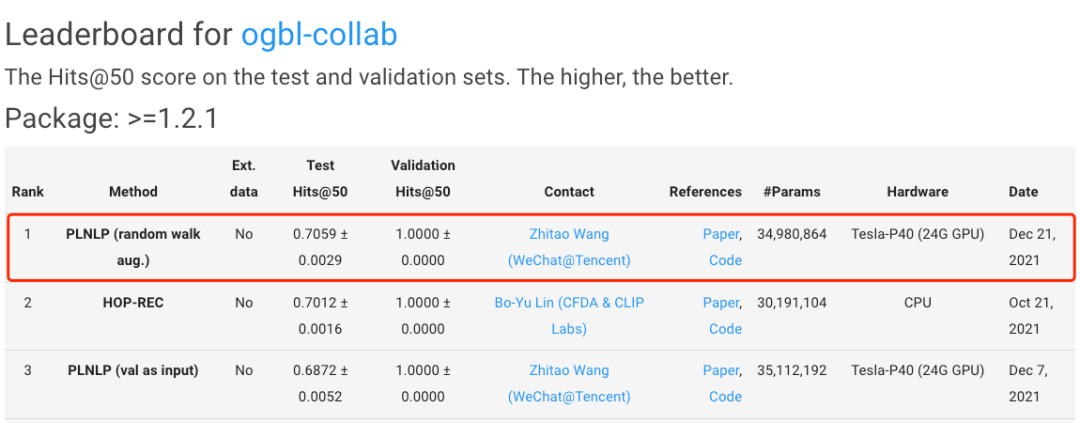

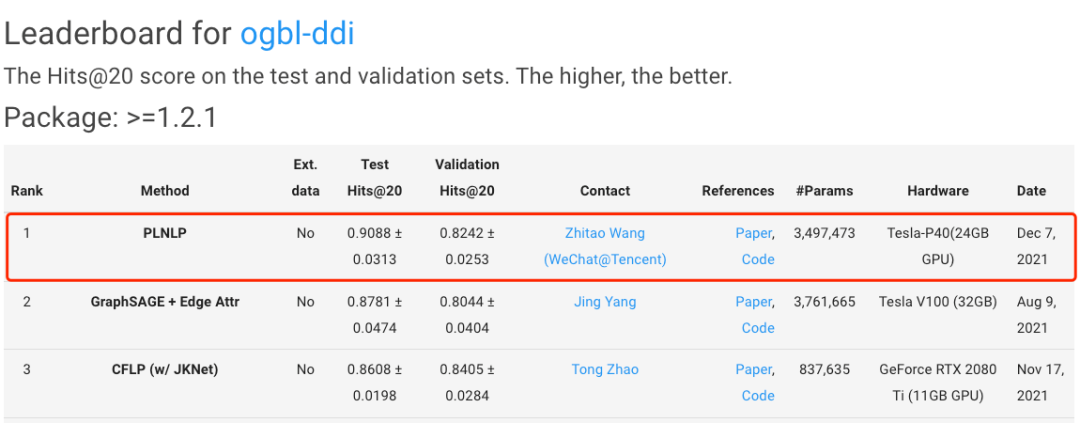

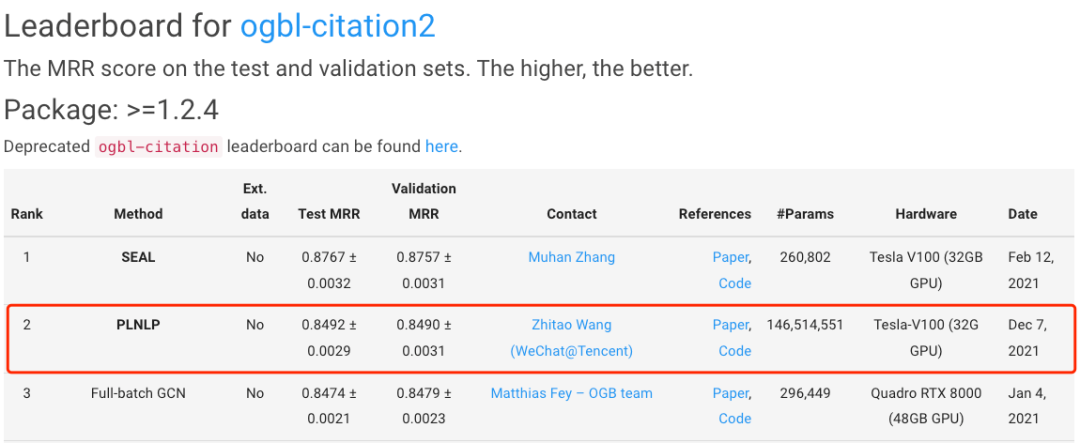

近期,在国际顶级图学习基准评测榜单OGB(Open Graph Benchmark)中,微信支付与微信看一看embedding联合团队(zhitao、joyce、brian、yuanhang、justin),凭借在边性质预测任务方面的出色表现,在学者合作网络、药物反应网络以及学术引用网络三个数据集的边预测竞赛中分列第一名、第一名和第二名。

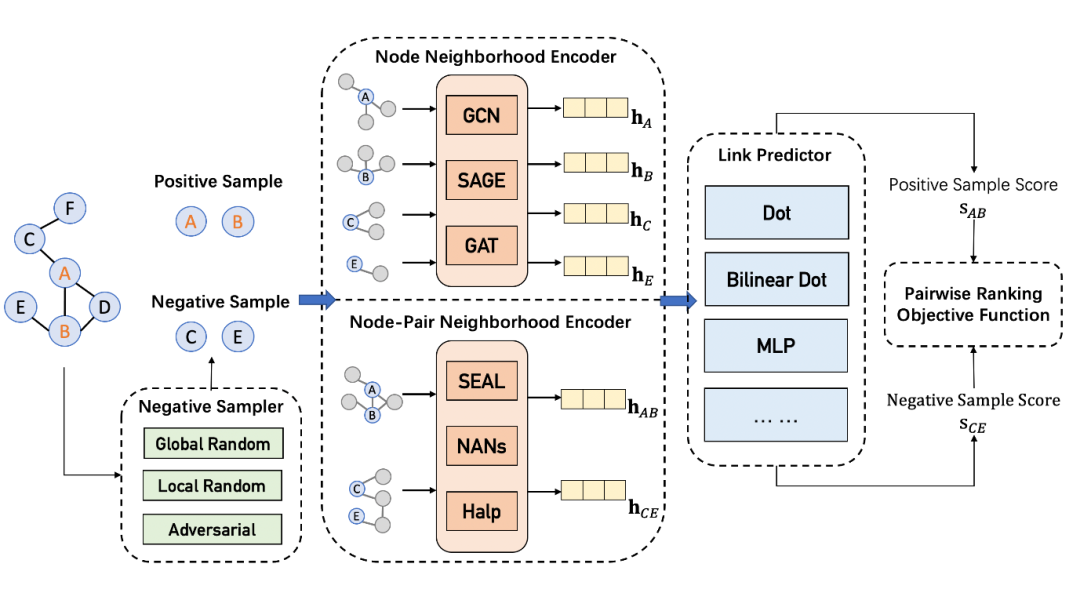

该任务主要是基于观测到的图结构,预测未来会出现或未观测到的边关系。边预测算法可以广泛应用在如蛋白质交互检测、欺诈检测,朋友推荐以及商品推荐等多个工业界场景中。

参赛方案已整理成论文:Pairwise Learning for Neural Link Prediction (https://arxiv.org/pdf/2112.02936.pdf)

比赛介绍

技术介绍

团队介绍

微信AI

不描摹技术的酷炫,不依赖拟人的形态,微信AI是什么?是悄无声息却无处不在,是用技术创造更高效率,是更懂你。

微信AI关注语音识别与合成、自然语言处理、计算机视觉、工业级推荐系统等领域,成果对内应用于微信翻译、微信视频号、微信看一看等业务,对外服务王者荣耀、QQ音乐等产品。

登录查看更多

相关内容

Arxiv

0+阅读 · 2022年4月20日

Arxiv

44+阅读 · 2020年2月5日