中文数据集有奖公开征集

各位自然语言处理界的同仁:

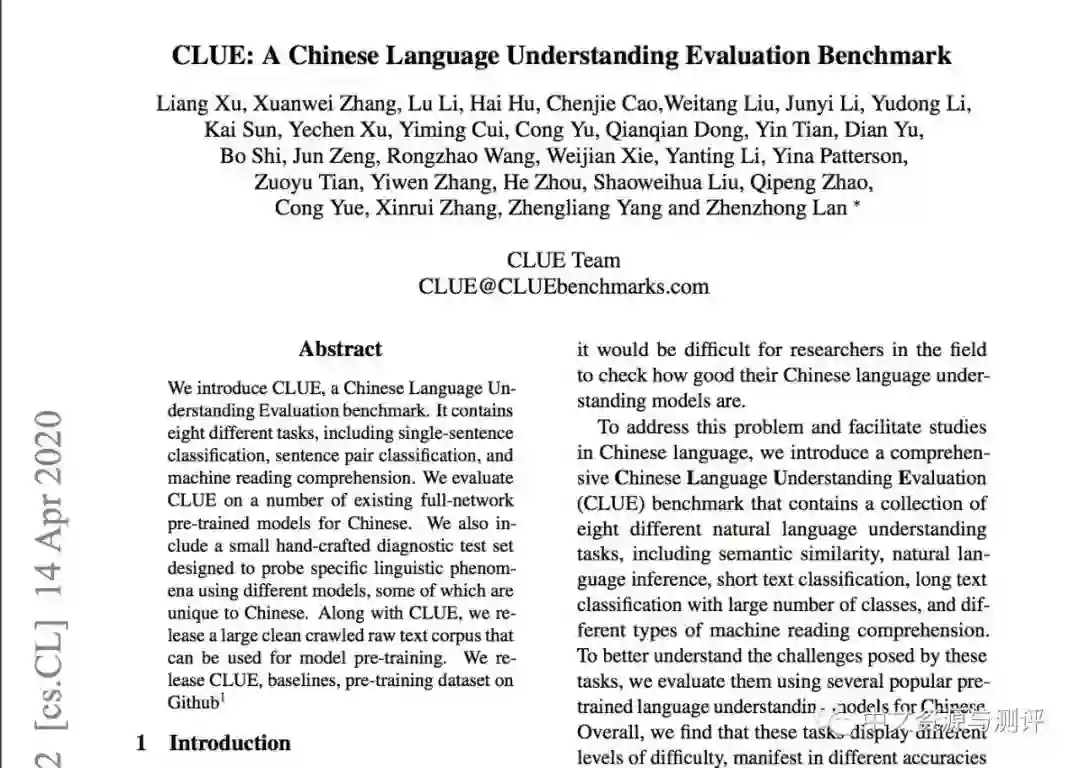

我们是中文任务基准测评小组,即Chinese Language Understanding Evaluation(CLUE)的成员。我们收集、制作了一套中文自然语言理解评测平台:CLUE Benchmark。

CLUE Benchmark旨在综合形式不同、难度各异的中文自然语言理解数据集,制作一个统一的测试平台,以准确评价模型的自然语言理解能力。目前我们已经收集了至少9大数据集,并制作了排行榜。包括华为、阿里、腾讯等公司,以及中科院相关院所等高校参与了测评。我们的GitHub repository已获得超过1000个星。

我们的网站:

https://www.CLUEbenchmarks.com

论文的arxiv地址:

https://arxiv.org/abs/2004.05986

Github地址:

https://github.com/CLUEbenchmark

🔍

现在,在「知乎」也能找到我们了

进入知乎首页搜索「PaperWeekly」

点击「关注」订阅我们的专栏吧

关于PaperWeekly

PaperWeekly 是一个推荐、解读、讨论、报道人工智能前沿论文成果的学术平台。如果你研究或从事 AI 领域,欢迎在公众号后台点击「交流群」,小助手将把你带入 PaperWeekly 的交流群里。

登录查看更多

相关内容

专知会员服务

30+阅读 · 2020年1月2日