【ICML2020-Google】AutoML-Zero进化算法加持,仅用数学运算自动找出ML算法

转载自机器之心

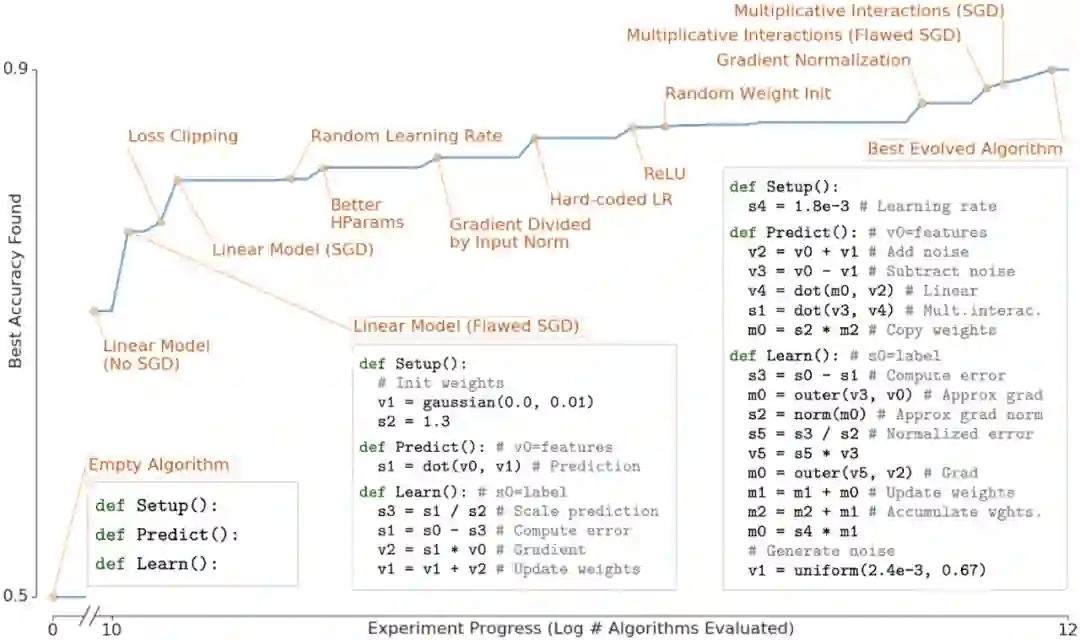

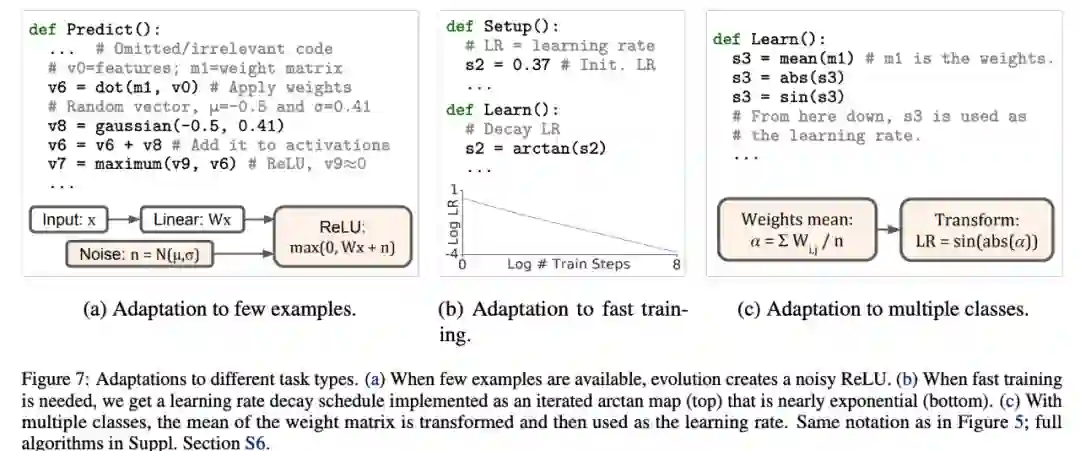

仅使用基础数学运算就能自动搜索机器学习算法?谷歌 Quoc V. Le 等人提出了 AutoML-Zero 方法。

论文链接:https://arxiv.org/pdf/2003.03384.pdf

GitHub 项目地址:https://github.com/google-research/google-research/tree/master/automl_zero#automl-zero

专知便捷查看

便捷下载,请关注专知公众号(点击上方蓝色专知关注)

后台回复“AMZO” 可以获取《ICML2020AutoML-Zero进化算法加持,仅用数学运算自动找出ML算法》专知下载链接索引

登录查看更多